简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

硬件配置:6530*2/512G/960 NVME SSD*2+8T*3/L40*4/2700W*2软件配置:Winserver2022+ollama0.7+deepseek-r1:70b+docker4.41+dify1.4+CUDA12.8;企业自建deepseek-r1:70b大模型实现企业知识问答。

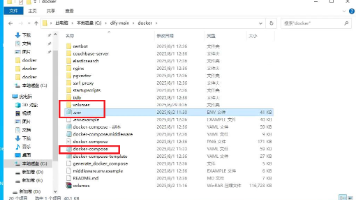

dify现在更新版本的速度很快,基本上每周都有一个小版本升级,偶尔还会有大版本升级,比如1.6版本加入MCP,1.7版本升级加入OAuth。大家都知道在开源的世界,Windows爹不亲娘不爱的,dify的官方升级办法里也没有Windows适用的方法,一旦升级失败,有时候应用都要推倒重来,笔者就升级一次失败耗去两天时间才恢复。经过试验,按以下步骤可以较好的实现在Windows下升级dify版本,并保

dify现在更新版本的速度很快,基本上每周都有一个小版本升级,偶尔还会有大版本升级,比如1.6版本加入MCP,1.7版本升级加入OAuth。大家都知道在开源的世界,Windows爹不亲娘不爱的,dify的官方升级办法里也没有Windows适用的方法,一旦升级失败,有时候应用都要推倒重来,笔者就升级一次失败耗去两天时间才恢复。经过试验,按以下步骤可以较好的实现在Windows下升级dify版本,并保

硬件配置:6530*2/512G/960 NVME SSD*2+8T*3/L40*4/2700W*2GPU分析:由于是企业应用,需要考虑多用户并发,网络上那些硬件分析对于企业来说都过于激进了。L40每块GPU有48G显存,4块加起来有192G,非常适合运行大模型。理论上最大可运行70b的FP16精度模型,模型精度对显存要求如下表:注意:ollama pull deepseek-r1:70b-lla