简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

在手机上浏览到一篇很棒的技术长文或 PDF,但现在没时间细看。

通用图形用户界面(GUI)智能体是 AI 领域最具前景的挑战之一。随着视觉语言模型(VLM)的飞速发展,构建能够自主操作移动应用(如 Android/iOS)的 Agent 已成为可能。然而,将强化学习 (RL)多步任务中,只有最终成功才给 1 分奖励。任务难度分布不均,导致大量计算资源浪费在极难任务上。移动端模拟器(Emulator)运行缓慢,每一次交互采样的成本极高。**智谱(Zhipu AI

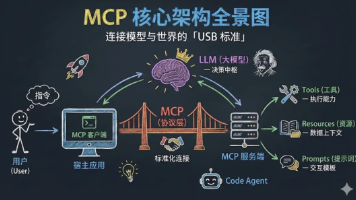

AI Agent直接使用高德地图,如何在Claude code上准确配置MCP

加载模型权重和处理当前对话的KV缓存。模型权重:参数量 x 每个参数占用字节数。80亿参数,BF16精度(2字节),则约需16GBKV缓存:与处理的序列长度、批次大小直接相关。

通用图形用户界面(GUI)智能体是 AI 领域最具前景的挑战之一。随着视觉语言模型(VLM)的飞速发展,构建能够自主操作移动应用(如 Android/iOS)的 Agent 已成为可能。然而,将强化学习 (RL)多步任务中,只有最终成功才给 1 分奖励。任务难度分布不均,导致大量计算资源浪费在极难任务上。移动端模拟器(Emulator)运行缓慢,每一次交互采样的成本极高。**智谱(Zhipu AI

将 ToT 框架的主要概念概括成了一段简短的提示词,指导 LLM 在一次提示中对中间思维做出评估。我的看法:如果模型足够强大,CoT和ToT的作用将大大减少。一句话总结:CoT和ToT都是Prompt技巧中的一种。,引导语言模型探索 把思维作为中间步骤 来解决通用问题。Chain-of-Thought思维链。:Tree of Thoughts 思维树。ToT 基于思维链提示进行了。

在做完capacity + random routing后,我们最终确认了每个token要发去的top2expert和其对应的权重,通过加权计算的方式,确认Moe-Layer最终的输出结果。: 为每个expert设置capacity(expert buffer),限制它能处理的最大token数量,多出来的token算为溢出,在top2Expert都溢出的情况下,该token会被直接发去下一层att

如果什么时候,可以不断流式的接受外界的输入token,KV Cache一直在GPU内存或者临时换出到CPU内存,这样KV Cache就是AI Agent的工作记忆,或者说AI Agent的状态,这是的Agent或许就是不断进行的“半神”存在。大模型的输入:包括角色设定(system prompt)、最近对话、全局记忆概要(即角色对用户的核心记忆 b.2)、经过RAG的聊天记录分段总结(a.)和分类

如果什么时候,可以不断流式的接受外界的输入token,KV Cache一直在GPU内存或者临时换出到CPU内存,这样KV Cache就是AI Agent的工作记忆,或者说AI Agent的状态,这是的Agent或许就是不断进行的“半神”存在。大模型的输入:包括角色设定(system prompt)、最近对话、全局记忆概要(即角色对用户的核心记忆 b.2)、经过RAG的聊天记录分段总结(a.)和分类

在做完capacity + random routing后,我们最终确认了每个token要发去的top2expert和其对应的权重,通过加权计算的方式,确认Moe-Layer最终的输出结果。: 为每个expert设置capacity(expert buffer),限制它能处理的最大token数量,多出来的token算为溢出,在top2Expert都溢出的情况下,该token会被直接发去下一层att