简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

当上下文接近容量:中间过程丢弃或摘要,保留开头(目标/约束)与结尾(最新状态/错误)。这是一种非常实用的经验主义:开头决定方向,结尾决定下一步。3.3 子代理:用隔离换清醒✅。

MemoryBank 的代表性做法是:把交互历史压缩成 summary,再作为长期记忆注入后续会话。它解决了上下文窗口有限的硬约束:不可能把所有历史原文都塞回 prompt,只能。

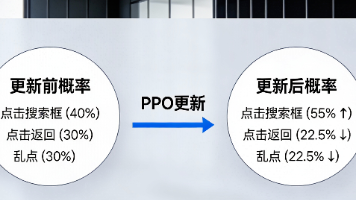

本文通过手机网购实战案例,深度拆解GUI Agent大模型利用PPO强化学习更新参数的核心逻辑。

深入解构开源的AI编程智能体Cline的核心提示词,揭示其通过结构化协议,思维链机制及双模态交互实现精准代码工程的核心逻辑。

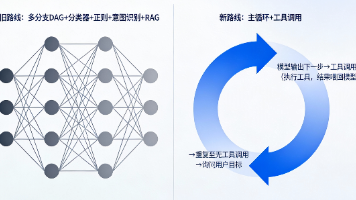

基于 AutoGLM(或其他视觉语言模型,VLM)构建,旨在通过自然语言指令自动化 Android 设备的操作。与传统的基于规则或脚本(如 Appium、UiAutomator)的自动化不同,并不依赖预先编写的控件 ID 或坐标路径。看:通过 ADB 获取屏幕截图和当前应用信息。想:利用多模态大模型分析当前界面,结合任务上下文进行规划。做:将模型输出的决策转化为具体的 ADB 指令执行。反馈:观察

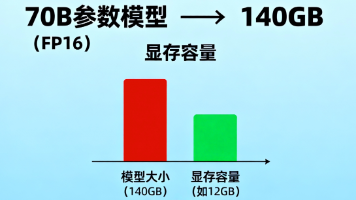

大模型量化技术全解析,先理解线性量化的基础,再看对象/粒度/流程怎么选,最后是各种进阶招式。

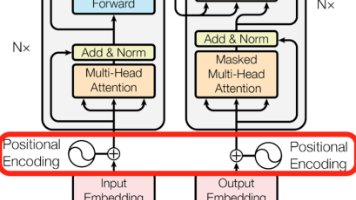

任意位置都能直接算出旋转角度,不需要额外参数,现在主流大模型(LLaMA、Qwen 等)几乎都使用 RoPE,随着距离 |m − n| 变大,RoPE 下点积的有效贡献会逐渐衰减:对长上下文的处理更平滑,更像人类注意力。:直接改变注意力点积:点积 = 内容相关性 + 与相对距离 |m − n| 相关的项,注意力天然偏向基于相对距离的建模:更接近人类处理语言的习惯,我们通常记得的是这个词在那个词前后

揭秘碳基大脑与硅基智能的本质差异,从记忆容量到元认知的深度剖析,带你认清 AI 进化的终极方向。

深入解构开源的AI编程智能体Cline的核心提示词,揭示其通过结构化协议,思维链机制及双模态交互实现精准代码工程的核心逻辑。

深入解构开源的AI编程智能体Cline的核心提示词,揭示其通过结构化协议,思维链机制及双模态交互实现精准代码工程的核心逻辑。