简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

2026年将成为企业AI Agent从试点转向生产系统的关键转折点。Anthropic报告指出,AI正从"对话助手"转变为"任务委派型执行单元",77%的企业应用已呈现完整任务委派特征。这一转变由三方面成熟推动:模型能力达到工程可用阈值、企业完成低价值试错、管理层意识到组织重构的重要性。真正的瓶颈不在于模型或算力,而是上下文获取与组织能力。成功场景需具备模型

本文深入解析了DPO(Direct Preference Optimization)技术如何用监督学习重构RLHF(强化学习人类反馈)的核心问题。文章指出RLHF在语言模型应用中存在三大痛点:奖励模型噪声大、PPO训练链复杂不稳定、RL与LLM的马尔可夫性错配。DPO通过直接利用偏好数据,用log-prob差距替代奖励模型,以隐式KL正则和logistic loss实现稳定优化,将对齐问题转化为监

Ilya Sutskever提出,未来AGI的关键在于快速学习能力而非模型规模或推理能力。他认为当前大模型存在泛化不稳定、缺乏任务内学习能力等问题,真正的智能体需要具备内部更新机制、强泛化能力和价值系统。未来AGI将是LLM、强化学习、元学习和价值系统的组合体,其核心竞争力在于学习速度而非静态推理能力。Sutskever预测5-20年内将出现这种能持续学习、适应和更新的智能体系统,而非简单的更大规

在2025年云栖大会上,阿里巴巴CEO吴泳铭提出,通用人工智能(AGI)的实现已成为确定性趋势,并将迈向能自我迭代的超级人工智能(ASI)。他将AI演进划分为“智能涌现”“自主行动”和“自我迭代”三阶段,强调大模型将成为下一代操作系统,超级AI云则是下一代计算机。吴泳铭描绘了ASI赋能人类、指数级提升生产力的未来图景,并宣布阿里云将持续投入基础设施与开源生态。然而,这一愿景也需审慎看待:AGI的“

企业AI应用2025趋势解读 OpenAI最新报告显示,企业AI应用正加速渗透核心业务:ChatGPT企业消息量年增8倍,API调用暴增320倍,超9000家企业处理超100亿tokens。75%员工反馈AI显著提效,日均节省40-60分钟,技术岗最高达80分钟,且能完成编码等新任务。 行业差异明显:科技(11倍)、医疗(8倍)增速领先,美、德、日使用最活跃。企业内部呈现两极分化——头部员工AI使

蔚来智能驾驶负责人任少卿提出"蔚来是AI公司而非汽车公司"的论断,揭示了其颠覆性的技术路径。蔚来正从传统"功能叠加"转向"认知构建",通过世界模型和强化学习训练具身智能体,将量产车变为AI训练平台。其研发体系类似AI实验室,以长期认知能力而非短期功能为目标。虽然面临商业现实压力,但蔚来选择用量产车型养AI研究,用AI定义产品差异。这种&q

AI硬件创业的窄门法则:未来智能的生存启示 AI硬件创业看似繁荣却暗藏危机,多数项目因忽视硬件基础或沉迷大模型幻想而失败。未来智能(Future Intelligence)却通过聚焦办公会议场景,验证了“5+X”;成功法则:先确保音质、续航等五项基础体验达标,再叠加AI能力。其发展历程揭示AI硬件的核心矛盾:垂直场景带来生存空间,却也限制发展边界;软硬一体需要深度耦合,却面临生态孤岛困境。未来智能

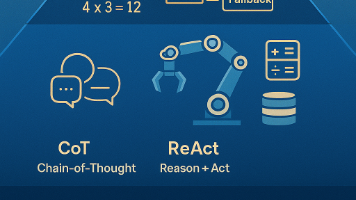

本文深入剖析大模型推理能力的本质,指出Chain-of-Thought(CoT)与规划(Planning)并非简单提示词技巧,而是依赖模型规模的涌现能力。小模型因容量、数据与推理机制限制,难以支撑多步推理与复杂任务规划。ReAct框架仅在具备可靠外部工具时有效,无工具场景下强行使用反而导致幻觉;纯对话应用应采用结构化ChatFlow引导反思,而非套用Agent范式。文章强调:技术选型需尊重模型能力

2025年10月中国AI投融资呈现总量平稳、结构集中特点,大模型与智能体(Agent)成为核心赛道。大模型领域进入第二阶段,从参数扩张转向生态建设,月之暗面等企业获数亿美元融资;智能体赛道处于早期探索阶段,乾知智能等获500-3000万美元投资。资本更关注技术壁垒与场景结合,国际机构活跃度提升。趋势显示Model-as-Agent融合将催生新产品形态,垂直领域落地加速,但需警惕同质化与估值过高风险

本文探讨了大模型生成速度对用户体验的影响,重点分析了首字延迟(TTFT)和生成速度(Token/s)两大关键指标。文章指出: 用户对响应速度极其敏感,TTFT>3秒会导致70%+的流失率; 不同应用场景需要差异化的速度标准,如实时对话要求TTFT<1s且≥40Token/s; 提供可交互的HTML模拟工具,可直观体验不同速度效果,帮助团队理解优化方向。 核心观点:模型性能不等于用户体验