简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

该算法的核心逻辑是基于特征的相似性生成,本质是用已知推未知:1、先通过AnalyzeSignal提取原始音频的特征值(周期、频谱、能量等参数);2、对浊音:复制周期片段并混合,利用周期性保证相似性;3、对清音:用LPC滤波噪声,利用频谱特征保证相似性;最后通过混合、衰减、加噪声等优化,确保生成的填补音频自然流畅,让听众无法察觉丢包的存在。

本文介绍了WebRTC中用于优化实时音频传输的加速算法(Accelerate)。该算法在音频数据堆积时,通过基音周期检测和重叠相加技术缩短播放时长,同时保持音调不变。算法实现包括三个关键步骤:1)检测满足加速条件的音频段(30ms以上,强相关或非活动语音);2)使用抛物线拟合算法精确定位音频峰值;3)通过三段式音频处理(基础段拷贝、周期段复制、交叉淡入淡出)实现平滑加速。其中交叉淡入淡出技术有效消

一、dos窗口输入nvidia-smi查询二、调用英伟达控制面板查询,桌面点击右键点击界面系统信息

本文介绍了WebRTC中NetEQ网络延时计算的两种算法:针对单纯网络抖动的UnderrunOptimizer算法和针对丢包场景的ReorderOptimizer算法。前者通过IAT直方图以95%概率计算最大延时值,后者则通过计算延时成本与丢包成本的平衡点确定最优延时。DelayManager最终综合两种算法的最大值作为当前网络延时,为变速算法提供关键决策依据。文章详细解析了两种算法的实现原理和核

一、概述音频的QOS可以分:音频前处理3A算法、NetEQ两大类。二、音频前处理3A算法1)AECAEC (Acoustic Echo Cancellation) 回声消除算法IOS和ANDROID系统都使用内置的AEC算法。只有windows使用webrtc的AEC算法。配置过程请参见WebRtcVoiceEngine::Init->WebRtcVoiceEn...

一、问题描述1)预置条件1、配置webrtc抗丢包方法为FEC Only。启动配置的时候,可以选NACK Only 或FEC Only 或HARQ混合模式。为了测试webrtc的X264 FEC抗丢包性能,在启动配置的时候,选择FEC Only模式。配置方法请参考:VCMLossProtectionLogic::SetMethod2、使用Net...

一、概念SVC(可适性视频编码或可分级视频编码)是传统H.264/MPEG-4 AVC编码的延伸,可提升更大的编码弹性,并具有时间可适性(Temporal Scalability)、空间可适性(Spatial Scalability)及质量可适性(SNR/Quality/Fidelity scalability)三大特性,使视频传输更能适应在异质的网络带宽。二、概述SVC以AVC视频编...

一、视频显示流程图1)显卡工作流程图像或者视频数据一旦离开CPU,必须通过4个步骤,才会到达显示器:1、从总线进入GPU(Graphics Processing Unit,图形处理器):将CPU送来的数据总线,再从总线送到GPU里面进行处理。2、从GPU进入帧缓冲存储器(或称显存):将GPU芯片处理完的数据送到显存。3、从显存进入视频控制器:视频控制器有可能是DAC(Dig...

一、背景介绍音视频同步效果直接影响用户体验,音视频同步机制也是webrtc的核心模块之一。音视频同步的基本思想是,在接收端渲染前,对齐当前要渲染的音视频采集时间,要处理好三大块事情:音视频采集绝对时间、音视频传输时间、音视频同步时间。二、实现原理1)采集时间2)传输时间戳3)音视频同步三、参考https://www.jianshu.com/p/3a4d24a71091https://my.osch

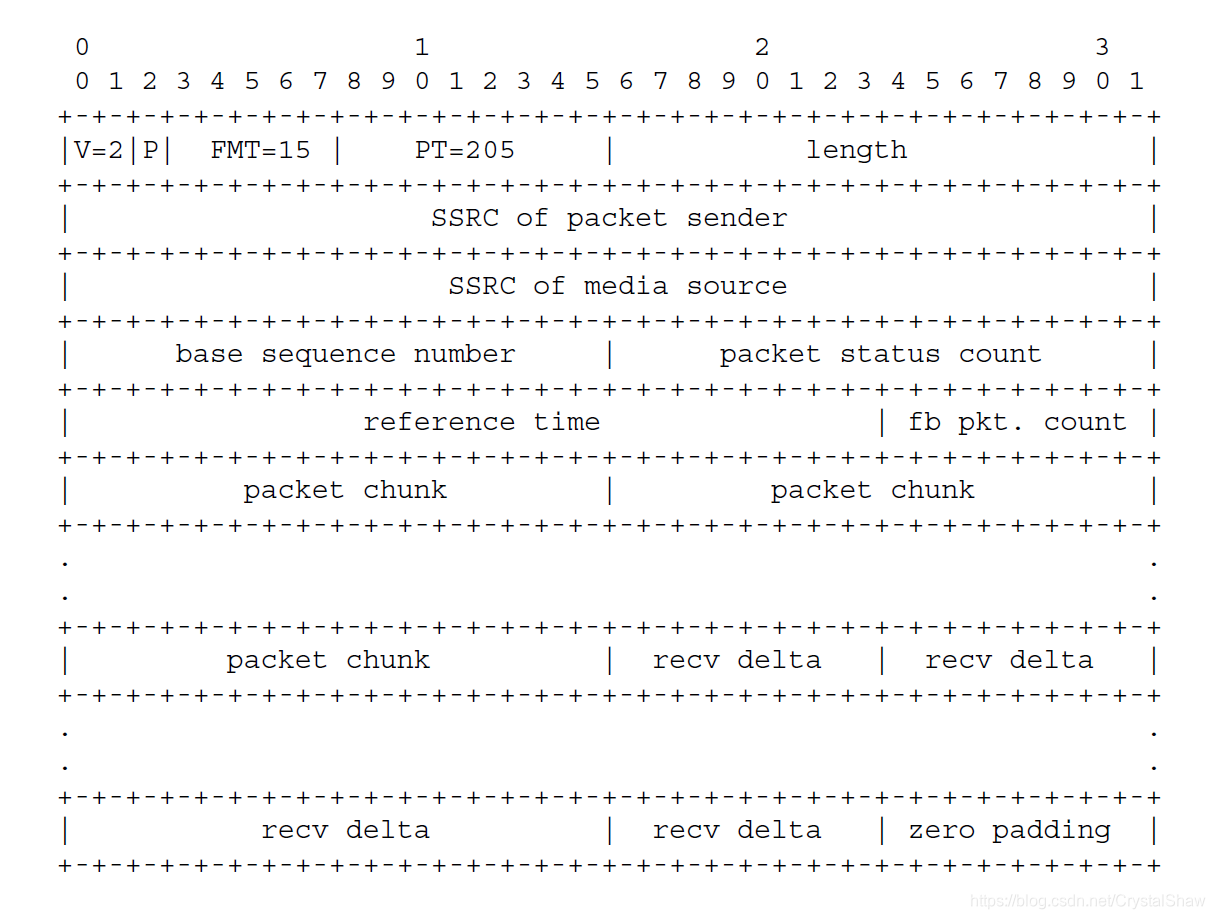

一、协议链接https://tools.ietf.org/pdf/draft-holmer-rmcat-transport-wide-cc-extensions-01.pdf二、协议定义三、抓包示例四、参数说明version (V): 2 bits。固定是2。padding (P): 1 bit。feedback message type (FMT): 5 bits。TransportCC固定是1