简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

随着人工智能(AI)和机器学习(ML)技术的迅猛发展,AI模型的规模和复杂度也在不断增加。这些大规模模型,如大型语言模型(LLMs)、计算机视觉模型和复杂的推荐系统,通常需要大量的计算资源来训练和推理。云计算平台提供了便捷的解决方案,但本地部署AI大模型有其独特的优势和必要性。大模型本地部署,顾名思义就是把大模型部署到我们本地的笔记本或者台式机上。

Qwen 2.5-Coder 是基于 AI 的语言模型,也是先进的编程辅助工具,能帮助开发者自动化编码任务,还能在复杂编程挑战中提供智能辅助,提升开发效率和代码质量。本文教会大家如何在本地部署Qwen 2.5-Coder大模型。

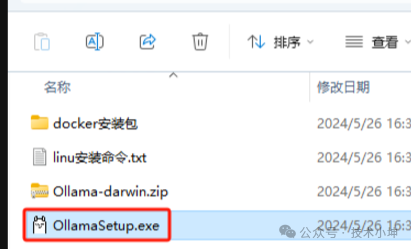

Deepseek本地部署详细指南!从 Ollama 到个人知识库应用

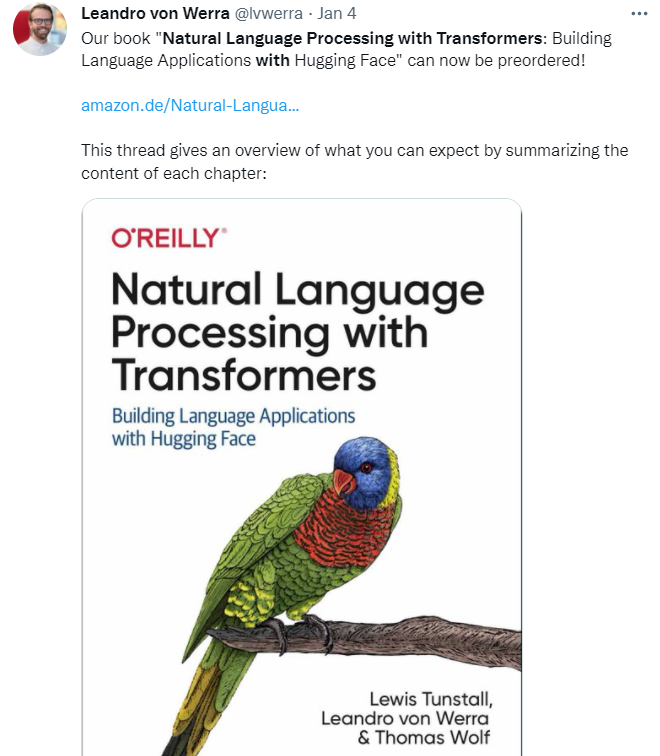

Hugging Face 是一家总部位于纽约的聊天机器人初创服务商,专注于NLP技术,拥有大型的开源社区。尤其是在github上开源的自然语言处理,预训练模型库 Transformers,已被下载超过一百万次,github上超过24000个star。Transformers 提供了NLP领域大量state-of-art的预训练语言模型结构的模型和调用框架。自2017年推出以来,Transforme

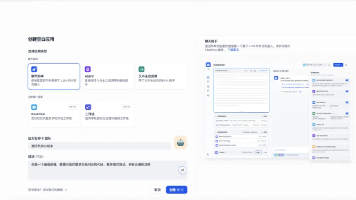

还在手动调参部署AI模型?本地跑模型卡成PPT?知识库管理乱成毛线团?

【AI大模型部署】私有知识库与外网大模型的完美结合:AnythingLLM全攻略由于算力的限制,使用起来很慢,但是我又不想把私人文件传给公网的大模型,那么有没有一种方法可以在访问私人的知识库的前提下,又可以访问外网的大模型呢?答案是必须的。

本篇文章主要对训练 LLM 以及部署应用时的精度问题进行了一些探讨和实践,读过后应该会对常用的浮点数 FP16,FP32,BF16 有一个更好的理解~

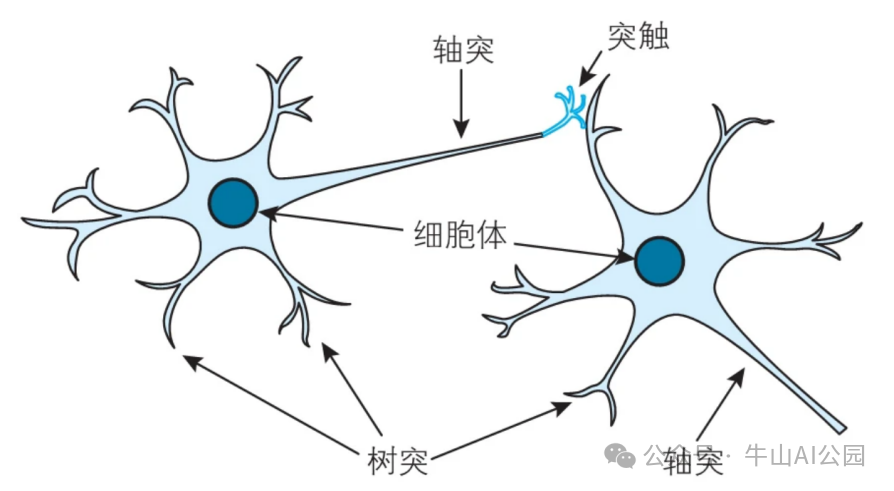

AI 模型训练是指通过数据驱动的方式,让人工智能(AI)系统从经验中学习,以便在给定的任务上进行预测、分类或生成等操作。这个过程通过优化模型的参数(如神经网络的权重和偏置)来最小化预测误差或损失,从而使模型能够在新数据上做出准确的判断,本文将介绍AI模型中神经网络和神经元的构造,以及AI训练的原理。

当前AI革命中,大模型发挥关键角色,其理论基础在于Scaling Law。简单来说就是,随着数据、参数和计算能力的提升,模型能力增强,展现出小规模模型所不具备的“涌现能力”。众多AI企业推出开源大模型,规模按扩展定律实现指数增长。

在AI领域,常见的深度学习框架TensorFlow、PyTorch和Keras无疑是开发者们的得力工具,但随着模型规模的急剧膨胀,这些传统框架在应对大模型时往往会显得力不从心。比如Pytorch的分布式并行计算框架DDP(Distributed Data Parallel),尽管实现了数据并行,但是当模型大小超过单个GPU显存限制时显得捉襟见肘。此时,开发者往往只能手动进行复杂模型的参数拆分到各个