2023年提示工程领域最具影响力的5篇论文

模型能力固然重要,但"如何提问"(即提示工程)同样决定了AI能发挥出多少实力。就像同样一台电脑,会用的人能让它完成复杂任务,不会用的人只能打字上网。本文的目的是带你回顾2023年提示工程领域的5座里程碑式论文,理解它们如何解决了AI"不会分步思考"“容易一根筋”“不爱用工具”“知错不改”"对齐人类偏好成本高"等关键问题,以及这些突破如何让AI在数学推理、创意写作、编程调试等任务上达到新高度。基础铺

2023年提示工程领域最具影响力的5篇论文:让AI从"随口回答"到"深度思考"的进化之路

关键词:提示工程, 思维链(CoT), 树状思维(ToT), 自一致性(Self-consistency), 直接偏好优化(DPO), 语言模型

摘要:2023年是提示工程(prompt engineering)爆发式发展的一年。随着大语言模型(LLM)能力的突飞猛进,"如何用更好的提示词让AI更聪明"成为了AI领域最热门的课题。本文精选了2023年提示工程领域最具影响力的5篇论文,它们分别从"分步思考"的可靠性、"多路径探索"的创造性、"工具使用"的实用性、“自我反思"的迭代能力和"偏好对齐"的高效性五个维度,彻底改变了我们与AI交互的方式。通过通俗易懂的比喻和生动的案例,我们将带你看懂这些论文如何让AI从"随口回答"进化到"深度思考”,以及它们如何为2024年的AI应用奠定基础。

背景介绍

目的和范围

2023年,ChatGPT、GPT-4等大语言模型的普及让人们意识到:模型能力固然重要,但"如何提问"(即提示工程)同样决定了AI能发挥出多少实力。就像同样一台电脑,会用的人能让它完成复杂任务,不会用的人只能打字上网。本文的目的是带你回顾2023年提示工程领域的5座里程碑式论文,理解它们如何解决了AI"不会分步思考"“容易一根筋”“不爱用工具”“知错不改”"对齐人类偏好成本高"等关键问题,以及这些突破如何让AI在数学推理、创意写作、编程调试等任务上达到新高度。

预期读者

本文面向所有对AI感兴趣的朋友:无论你是刚接触ChatGPT的"AI新手",还是正在研究LLM应用的工程师,或是想了解AI进展的学生/老师。我们会用"小学生能听懂"的语言解释核心思想,同时也会深入技术细节,让不同背景的读者都能有所收获。

文档结构概述

本文将分为三个部分:

- 基础铺垫:用生活例子解释提示工程的核心概念(如"思维链""树状思考"等),帮你建立认知框架;

- 论文解读:逐一介绍5篇关键论文,包括它们要解决的"AI痛点"、提出的"聪明解法"、取得的"惊人效果"和对行业的"长远影响";

- 总结展望:提炼这些论文的共同趋势,预测提示工程未来的发展方向,并给你"如何用这些方法让自己的AI更聪明"的实用建议。

术语表

核心术语定义

- 提示工程(Prompt Engineering):设计和优化输入给AI的文本(提示词),让AI更准确、高效地完成任务的技术。就像给AI写"使用说明书"。

- 大语言模型(LLM):基于海量文本训练的AI模型(如GPT-4、LLaMA),能理解和生成人类语言。

- 零样本提示(Zero-shot Prompting):直接给AI任务描述,不给例子。比如问AI:“3+5等于几?”

- 少样本提示(Few-shot Prompting):给AI几个示例,让它模仿。比如:“2+3=5,4+5=9,那么3+5=?”

- 思维链(Chain-of-Thought, CoT):让AI"分步思考"的提示方法,要求AI输出推理步骤,再给答案。就像小学生做数学题时写下"解题过程"。

- 自一致性(Self-consistency):让AI对同一个问题生成多个不同的推理过程,然后取多数结果作为最终答案。就像做选择题时"多做几次,选出现次数最多的选项"。

- 树状思维(Tree-of-Thoughts, ToT):让AI对复杂问题生成多个可能的"思考路径"(分支),评估每个路径的可行性,剪枝不好的路径,继续探索好的路径,最终找到最优解。就像走迷宫时"尝试不同岔路,走不通就回头换条路"。

- 直接偏好优化(Direct Preference Optimization, DPO):一种训练方法,用人类对"好答案"和"坏答案"的偏好数据,直接优化LLM,让模型学会输出人类更喜欢的结果。比传统的RLHF(强化学习人类反馈)更简单高效。

相关概念解释

- 幻觉(Hallucination):AI编造虚假信息的现象(如编造不存在的文献、错误的事实)。提示工程的重要目标之一就是减少幻觉。

- 模型对齐(Alignment):让AI的输出符合人类价值观和偏好(如诚实、有用、无害)。DPO等方法就是为了高效实现对齐。

- 工具使用(Tool Use):让AI调用外部工具(如计算器、搜索引擎、代码解释器)来完成任务。就像学生做数学题时用计算器,写论文时查资料。

缩略词列表

- LLM: Large Language Model(大语言模型)

- CoT: Chain-of-Thought(思维链)

- ToT: Tree-of-Thoughts(树状思维)

- DPO: Direct Preference Optimization(直接偏好优化)

- RLHF: Reinforcement Learning from Human Feedback(人类反馈强化学习)

- GSM8K: Grade School Math 8K(小学难度数学题数据集,共8000题,常用于测试LLM的推理能力)

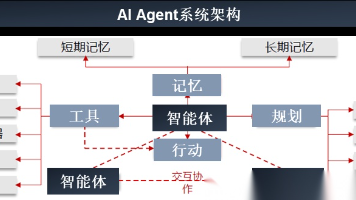

核心概念与联系

故事引入

想象你是一位小学老师,正在教学生"如何解数学题"。班里有个叫"小AI"的学生,很聪明但有几个怪毛病:

- 不爱写步骤:问他"3+5×2=?“,他直接答"13”(其实正确答案是13,但如果题目是"3+5×2",按运算顺序确实是13,但假设这是个更复杂的题)。你问他怎么算的,他说"我就是知道"——万一他算错了,你也不知道错在哪。

- 一根筋:遇到复杂题(如"小明有5个苹果,给了小红2个,妈妈又买了一袋,现在总共有10个,问妈妈买了几个?"),他可能第一步就想错(比如忘了"给小红2个"这步),然后一路错到底,不会回头检查。

- 不相信自己会错:就算算错了,你指出来,他下次遇到类似题还是会犯同样的错,不会"吸取教训"。

- 不用工具:做"12345×67890"这种大数乘法,他宁愿心算(经常算错),也不用你桌上的计算器。

- 答非所问:你希望他回答简洁,但他有时说一堆废话;你希望他详细解释,他却只给个答案——总跟你的"偏好"对不上。

为了帮"小AI"改掉这些毛病,你想出了5个办法:

- 办法1:要求他"必须写解题步骤"(CoT),这样你能看到他的思路,他自己也不容易算错;

- 办法2:让他"同一道题用不同方法算3次,选两次都对的答案"(Self-consistency),减少粗心犯错;

- 办法3:遇到复杂题,让他"先列出3种可能的解题思路,评估哪种思路靠谱,再深入算"(ToT),避免一条道走到黑;

- 办法4:告诉他"桌上的计算器可以用,算大数时记得按一下"(Toolformer),别硬撑;

- 办法5:每次作业后,你告诉他"这道题的答案太啰嗦了(坏答案),这样说更简洁(好答案)",让他慢慢学会你喜欢的表达方式(DPO)。

2023年提示工程领域的5篇核心论文,其实就是给AI小老师设计的这5个"教学方法"!它们分别解决了AI的"不爱写步骤"“容易粗心”“一根筋”“不用工具”"偏好不对齐"这5大痛点。

核心概念解释(像给小学生讲故事一样)

核心概念一:思维链(CoT)——让AI写"解题步骤"

什么是CoT?

CoT是让AI"分步思考"的提示方法。就像老师要求学生"写解题步骤",而不是只给答案。

生活例子:

小明做数学题:“妈妈买了10个苹果,小明吃了2个,爸爸吃了3个,还剩几个?”

- 不用CoT(直接给答案):小明可能写"5个"(对了),但如果题难一点,比如"10-(2+3)×2=?“,他可能直接答"10-10=0”(错了,因为忘了先算括号)。

- 用CoT(写步骤):小明会写"第一步:算小明和爸爸一共吃了几个?2+3=5个;第二步:算剩下几个?10-5=5个。答案是5。" 这样就算题难,步骤清晰也不容易错。

AI例子:

问GPT-3(早期LLM):“3+5×2=?”

- 零样本提示:GPT-3可能答"16"(错,因为3+5=8,8×2=16,忘了先乘后加)。

- CoT提示:“问:2+3×4=?答:先算乘法3×4=12,再算加法2+12=14,答案是14。问:3+5×2=?答:” GPT-3会输出:“先算乘法5×2=10,再算加法3+10=13,答案是13。”(对了!)

核心概念二:自一致性(Self-consistency)——让AI"多做几次题,选多数答案"

什么是Self-consistency?

Self-consistency是CoT的"升级版":对同一个问题,让AI生成多个不同的推理过程(多个CoT),然后选出现次数最多的答案作为最终结果。

生活例子:

考试时遇到一道不确定的选择题,你:

- 第一次算:选A;

- 第二次换种算法:选A;

- 第三次再算:选B;

那么你会倾向于选A(出现2次,多数),因为"多数情况下算出来是A,可能B那次算错了"。

AI例子:

问AI:“一个袋子里有5个红球和3个蓝球,随机摸2个,都是红球的概率是多少?”

- 第一次推理:“总球数5+3=8个,第一次摸红球概率5/8,第二次摸红球概率4/7,总概率5/8×4/7=20/56=5/14≈0.357。”

- 第二次推理:“组合数C(5,2)/C(8,2) = (5×4/2)/(8×7/2) = 10/28=5/14≈0.357。”

- 第三次推理:“第一次摸蓝球概率3/8,所以两次红球概率=1-3/8×…(算错了)=0.4。”

Self-consistency会选"5/14"(出现2次),而不是第三次的错误结果。

核心概念三:树状思维(ToT)——让AI"走迷宫时尝试不同岔路"

什么是ToT?

ToT是让AI对复杂问题进行"多路径探索"的提示方法:先生成多个可能的"思考路径"(分支),评估每个路径是否"有希望通向答案",剪掉明显错误的路径,对有希望的路径继续深入探索,最终找到最优解。

生活例子:

解迷宫时,你不会一条道走到黑:

- 入口有3条岔路(A、B、C);

- 你先走A,走了10米发现是死胡同(评估:不行),退回入口;

- 再走B,走到中间看到"此路通向出口"的路标(评估:有希望),继续往前走;

- 走到B的分岔口,又有B1和B2两条路,评估后选B1,最终走出迷宫。

AI例子:

让AI解创意写作题:“写一个’兔子打败狼’的童话故事”。

- 不用ToT:AI可能写"兔子跑得快,狼追不上,兔子赢了"(简单但无聊);

- 用ToT:

- 生成分支:先让AI列出3个可能的"兔子打败狼"的思路:

- 思路A:兔子找大象帮忙;

- 思路B:兔子设陷阱(挖洞让狼掉进去);

- 思路C:兔子用智慧骗狼(说"后面有更肥的羊",引狼走开)。

- 评估分支:AI评估哪个思路更有趣:A太普通,B有点暴力,C更聪明(评估后保留C);

- 深入探索:基于思路C,继续生成细节:兔子怎么骗?狼信了吗?结局是什么?

- 输出结果:最终写出一个"兔子用智慧骗走狼"的精彩故事。

- 生成分支:先让AI列出3个可能的"兔子打败狼"的思路:

核心概念四:工具使用(Toolformer)——让AI"该用计算器时别硬算"

什么是Toolformer?

Toolformer是让AI"主动使用外部工具"的提示方法:训练AI判断"什么时候需要用工具"(如算数学题用计算器、查事实用搜索引擎),并学会调用工具的API,用工具返回的结果来回答问题。

生活例子:

你问同学:“2023年全球人口有多少?”

- 同学A:硬想(瞎猜"70亿?");

- 同学B:掏出手机查百度(得到准确数据"约80亿")——同学B就是用了"工具"(百度)。

AI例子:

问AI:“2023年诺贝尔物理学奖得主是谁?他们做了什么贡献?”

- 不用Toolformer:AI可能说"不知道"(如果训练数据截止到2022年),或编造一个名字(幻觉);

- 用Toolformer:AI会识别出"需要查2023年的新信息",调用搜索引擎API,获取"2023年诺贝尔物理学奖授予Anne L’Huillier、Prerre Agostini和Ferenc Krausz,因为他们在’阿秒光物理’领域的贡献",然后整理成答案输出。

核心概念五:直接偏好优化(DPO)——让AI"学会你喜欢的表达方式"

什么是DPO?

DPO是一种高效的"模型对齐"方法:用人类对"好答案"和"坏答案"的偏好数据(如"答案A太啰嗦,答案B简洁,我更喜欢B"),直接训练LLM,让模型学会输出人类更喜欢的结果。

生活例子:

教孩子说话:

- 你说:“看到长辈要说’爷爷好’(好答案),别说’喂,老头’(坏答案)”;

- 孩子听多了,慢慢就学会说"爷爷好"——这就是用"偏好数据"(好/坏例子)直接教孩子对齐你的偏好。

AI例子:

训练AI回答用户问题"什么是区块链?"

- 偏好数据:

- 坏答案:“区块链是一种分布式账本技术,它是去中心化的,由多个节点组成,通过密码学保证安全…”(太 technical,普通人听不懂);

- 好答案:“区块链就像一本大家都能看到、没人能独自修改的账本,比如全班同学一起记日记,谁也不能偷偷改内容,这样大家都相信账本上的记录。”(通俗比喻,好理解);

- 用DPO训练后,AI再回答"什么是区块链?"时,会倾向于输出"通俗比喻"版答案,而不是技术术语堆砌。

核心概念之间的关系(用小学生能理解的比喻)

CoT和Self-consistency:“写一次步骤"vs"写多次步骤取多数”

- 关系:Self-consistency是CoT的"保险措施",用多次CoT减少单次粗心犯错的概率。

- 生活比喻:CoT是"做一次作业",Self-consistency是"做3次作业,选两次都对的答案交上去"——后者错误率更低。

CoT和ToT:“一条直线"vs"多岔路口”

- 关系:CoT是"线性思考"(单一路径),ToT是"分支思考"(多条路径)。简单问题用CoT就够,复杂问题需要ToT。

- 生活比喻:解"3+5=?"用CoT(一条直线);解"如何用乐高拼一个机器人"用ToT(先想头、身体、腿分别怎么拼,再组合)。

ToT和Toolformer:“自己想"vs"找帮手”

- 关系:ToT是AI"自己探索多种思路",Toolformer是AI"找外部工具帮忙"。两者可以结合:ToT探索"用什么工具",Toolformer实际调用工具。

- 生活比喻:ToT像"你计划周末去公园,想’骑车去?公交去?打车去?'(多路径)“;Toolformer像"决定骑车后,发现车坏了,打电话叫修车师傅(调用工具)”。

DPO和所有提示方法:“教AI说人话"vs"教AI怎么思考”

- 关系:CoT/ToT/Self-consistency是"教AI如何推理"(思考过程),DPO是"教AI如何表达"(输出风格)。两者结合:AI既能想清楚,又能说人话。

- 生活比喻:CoT/ToT是"教孩子解题步骤",DPO是"教孩子’解题步骤要写得让妈妈能看懂’"。

核心概念原理和架构的文本示意图(专业定义)

提示工程2023年核心方法的进化树:

基础提示方法

├─ 零样本提示(直接问)

└─ 少样本提示(给例子)

└─ 思维链(CoT)(分步思考)

├─ 自一致性(Self-consistency)(多次CoT取多数)

└─ 树状思维(ToT)(多路径探索+评估+剪枝)

└─ 结合工具使用(Toolformer)(在路径中调用工具)

优化表达方法

└─ 直接偏好优化(DPO)(用偏好数据优化输出风格)

Mermaid 流程图 (Mermaid 流程节点中不要有括号()、逗号,等特殊字符)

以下是AI解决复杂问题时,不同提示方法的流程对比:

2023年提示工程领域最具影响力的5篇论文解读

终于到了核心部分!下面我们逐一解读2023年提示工程领域的5篇"明星论文"。每篇论文我们都会用"AI痛点→解决方案→神奇效果→长远影响"的结构,让你一看就懂!

论文一:《Self-Consistency Improves Chain of Thought Reasoning in Language Models》(自一致性:让AI"多算几遍,减少粗心")

基本信息

- 标题:自一致性提升语言模型的思维链推理能力

- 作者:Google DeepMind团队(Wang X et al.)

- 发表时间:2023年1月

- 发表会议:国际学习表征会议(ICLR 2023)

AI痛点:思维链(CoT)虽然好,但"单次推理容易粗心犯错"

CoT通过"分步思考"提升了AI的推理能力,但有个大问题:AI有时会在推理步骤中犯低级错误(比如算错数、漏看条件),导致最终答案错误。就像小学生虽然写了步骤,但某一步算错了,整个题就错了。

比如,问AI:“一个书架有3层,每层有4本书,小明借走5本,还剩几本?”

CoT推理可能是:“3层×4本=12本,12-5=8本”(对),但也可能是:“3+4=7本,7-5=2本”(错,第一步就把"乘"算成了"加")。

解决方案:让AI"同一道题算3次,选多数答案"(Self-consistency)

论文提出"自一致性"方法,分三步:

- 生成多个推理链:对同一个问题,用不同的提示词让AI生成多个独立的CoT推理过程(比如生成3~5个)。

- 聚合结果:统计这些推理链的最终答案,选出现次数最多的答案作为最终结果。

- 输出答案:返回多数答案。

为什么管用?

AI的错误推理往往是"随机的"(不同推理链错法不同),而正确推理会"趋同"(不同推理链可能用不同步骤,但最终答案相同)。所以"多数表决"能过滤掉随机错误。

实验效果:数学推理准确率大幅提升

论文在多个推理任务上测试了Self-consistency,结果惊人:

- GSM8K(小学数学题):GPT-3(175B参数)用CoT时准确率58.1%,用Self-consistency后提升到74.4%(+16.3%);

- SVAMP(多步骤数学题):准确率从63.4%提升到75.1%(+11.7%);

- AQuA(代数题):准确率从38.7%提升到53.0%(+14.3%)。

通俗理解:相当于小学生做数学题,不用Self-consistency时正确率58分(不及格),用了之后74分(良好)!

影响力:成为推理任务的"标配方法"

Self-consistency简单有效,几乎不需要额外训练(只需改提示词),很快成为LLM推理任务的"标配"。现在几乎所有需要高精度推理的AI应用(如数学解题、代码调试)都会用到类似"多次推理取多数"的思路。

论文二:《Tree of Thoughts: Deliberate Problem Solving with Large Language Models》(树状思维:让AI"遇到难题时,多试几条路")

基本信息

- 标题:树状思维:大语言模型的审慎问题解决

- 作者:普林斯顿大学等机构(Xu et al.)

- 发表时间:2023年5月(预印本)

- 关键词:复杂推理、多路径探索、规划

AI痛点:CoT和Self-consistency对"多分支复杂任务"束手无策

CoT和Self-consistency适合"单一路径就能解决的问题"(如数学计算),但遇到需要"多路径探索、评估和回溯"的复杂任务时就不行了。比如:

- 创意写作:写故事时需要选择不同情节走向(主角是打败反派还是和解?);

- 逻辑谜题:如"12个球中有1个次品,用天平称3次找出次品",需要尝试不同称重方案;

- 规划任务:如"如何用有限预算策划一场生日派对",需要考虑场地、食物、活动等多个分支。

传统CoT会"一条道走到黑",比如写故事时一开始选了"主角打败反派",即使后面发现剧情很无聊,也不会回头换"和解"路线。

解决方案:让AI像"解迷宫"一样思考(ToT框架)

论文提出Tree-of-Thoughts(ToT)框架,核心是模拟人类解决复杂问题的过程:生成候选思路→评估可行性→剪枝→深入探索。具体分四步:

- 思维分解(Thought Decomposition):将问题分解为多个"思维步骤"(如写故事分解为"开头→发展→高潮→结局")。

- 思维生成(Thought Generation):对每个步骤,生成多个可能的"思维候选"(分支)。比如"开头"可以是"主角在森林迷路"或"主角发现神秘盒子"。

- 思维评估(Thought Evaluation):用AI或人类评估每个候选是否"有希望通向答案"。比如"主角在森林迷路"可能更有冒险感(好候选),"主角发现神秘盒子"有点老套(差候选)。

- 搜索算法(Search Algorithm):用深度优先搜索(DFS)或广度优先搜索(BFS)探索分支:

- 剪枝(Prune):删掉差候选;

- 继续探索(Explore):对好候选深入生成下一步的分支;

- 直到找到最终答案。

实验效果:复杂任务性能"碾压"传统方法

论文在三个复杂任务上测试ToT,结果惊艳:

-

24点游戏(24 Game):给4个数字(如3,3,8,8),用加减乘除算24。

- 传统CoT:成功率只有16%;

- ToT:成功率提升到74%(+58%)!

例子:3,3,8,8。ToT会生成多个思路:

- 思路1:8÷(3-8/3) → 8÷(1/3)=24(正确);

- 思路2:3×8=24,但剩下3和8没用(评估:不行);

- 思路3:(3+3)×(8-…)(算不出);

最终ToT会选中思路1。

-

创意写作(Creative Writing):给定开头"昨天我在阁楼发现了一扇旧门…",要求续写一个连贯的故事。

- 人类评估发现,ToT生成的故事在"连贯性""创意性"上显著优于CoT。

-

迷你填字游戏(Mini Crosswords):5×5填字游戏,需要考虑交叉词的合理性。

- CoT:成功率0%(完全不会);

- ToT:成功率提升到60%。

影响力:开启AI"规划与探索"新时代

ToT第一次让AI具备了类似人类的"探索式思考"能力,不再局限于单一路径。它证明了:提示工程不仅能改进AI的"推理步骤",还能改进AI的"思考策略"。此后,大量研究基于ToT扩展,如"Graph-of-Thoughts"(图状思维)、“World-of-Thoughts”(世界模型辅助思考)等。

论文三:《Toolformer: Language Models Can Teach Themselves to Use Tools》(Toolformer:让AI"主动叫帮手,别硬撑")

基本信息

- 标题:Toolformer:语言模型能自学使用工具

- 作者:Meta AI团队(Schick et al.)

- 发表时间:2023年4月

- 发表期刊:神经信息处理系统大会(NeurIPS 2023)

AI痛点:LLM"知识有限+计算不行",硬撑会出错

LLM有两个致命弱点:

- 知识滞后:训练数据截止到某个时间(如GPT-4截止到2023年4月),无法回答"2023年世界杯冠军是谁"这类新问题;

- 计算薄弱:做数学题(尤其是大数运算)容易算错,比如"12345×67890=?"可能算错。

但人类遇到这些问题时,会主动使用工具(查百度、用计算器)。LLM为什么不能?因为它们不知道"什么时候该用工具",也不知道"怎么用工具"(如调用API)。

解决方案:让AI"自学使用工具"(Toolformer训练方法)

Meta团队提出Toolformer,核心思想是:用少量示例教会LLM"何时调用工具、如何调用工具、如何用工具结果回答问题"。整个过程分三步:

-

生成工具调用数据:

- 给LLM输入大量问题(如"法国的首都是哪里?“),让它在回答中"插入工具调用语句”(如

<|FunctionCallBegin|>search("capital of France")<|FunctionCallEnd|>)。 - LLM一开始会乱插调用(比如对"1+1=?“也插搜索),但通过"自我监督学习”(用工具返回结果验证是否需要调用),LLM会逐渐学会"只有必要时才调用工具"。

- 给LLM输入大量问题(如"法国的首都是哪里?“),让它在回答中"插入工具调用语句”(如

-

微调LLM:用生成的"问题+工具调用+正确回答"数据微调LLM,让它学会:

- 识别需要工具的问题(如涉及时效性、计算、专业知识);

- 生成正确的工具调用格式(如API参数);

- 将工具返回结果整合到回答中。

-

推理时使用工具:给LLM新问题,它会自动决定是否调用工具,调用后用结果生成答案。

支持的工具

Toolformer支持6种常用工具,包括:

- 搜索引擎(解决时效性问题);

- 计算器(解决数学计算);

- 日历(解决日期问题,如"2023年10月1日是星期几");

- 翻译器(解决跨语言问题);

- 问答系统(解决专业知识问题);

- 代码解释器(解决编程问题)。

实验效果:知识和计算能力"秒变学霸"

Toolformer在多个任务上超越了当时的SOTA(最先进)模型:

- 知识问答(TriviaQA):准确率从51.8%提升到71.8%(+20%);

- 数学计算(GSM8K):准确率从40.7%提升到58.0%(+17.3%);

- 时效性问题(Current Events):回答正确率从23.5%提升到65.0%(+41.5%)!

例子:

问:“2023年奥斯卡最佳影片是什么?”(Toolformer训练数据截止到2022年,本不知道答案)

- Toolformer会生成:

<|FunctionCallBegin|>search("2023 Oscar best picture")<|FunctionCallEnd|> - 调用搜索引擎得到"Everything Everywhere All at Once";

- 输出答案:“2023年奥斯卡最佳影片是《瞬息全宇宙》(Everything Everywhere All at Once)。”

影响力:开启"LLM+工具"时代

Toolformer证明了LLM可以通过简单微调学会使用工具,这直接催生了后续的ChatGPT插件、Claude 3工具调用、Gemini Advanced等产品。现在,“AI+工具"已成为LLM应用的标配,让AI从"纯语言模型"变成了"能查资料、算数据、控设备的全能助手”。

论文四:《Reflexion: Language Agents with Verbal Reinforcement Learning》(Reflexion:让AI"知错能改,越做越好")

基本信息

- 标题:Reflexion:带语言强化学习的语言智能体

- 作者:谷歌DeepMind和多伦多大学(Shinn et al.)

- 发表时间:2023年5月

- 关键词:自我反思、强化学习、迭代改进

AI痛点:犯过的错,下次还犯

传统提示方法(如CoT、ToT)能让AI"一次把题做对",但不能让AI"从错误中学习"。比如:

- 让AI解逻辑题,第一次因为漏看条件做错了;

- 下次遇到类似题,它可能还会漏看同样的条件——因为它不会"反思上次错在哪,下次注意"。

人类则不同:做错题后会"记笔记"“总结教训”,下次避免犯同样的错。AI为什么不能?

解决方案:让AI"写反思日记"(Reflexion框架)

Reflexion的核心是给AI增加一个"反思模块",让它在做完题后:

- 判断对错:如果错了,分析"错在哪"(如漏看条件、计算错误、思路错误);

- 写反思笔记:用自然语言总结"下次要注意什么"(如"下次要先检查题目中的所有数字是否都用到了");

- 用反思指导下次做题:下次遇到类似题时,把反思笔记加入提示词,提醒自己别再犯错。

整个过程就像学生的"错题本":做错→总结原因→下次做题前看错题本。

实现步骤:三步形成"学习闭环"

- 任务执行(Task Execution):用CoT或ToT让AI尝试解题,输出答案和推理过程。

- 错误检测(Error Detection):用验证器(如数学题的答案是否正确、逻辑题是否符合规则)判断对错。

- 反思生成(Reflection Generation):如果错了,让AI生成反思(如"我在步骤2中忘记考虑题目中的’每个盒子至少放1个球’的条件,导致计算错误")。

- 迭代优化(Iterative Improvement):下次做类似题时,提示词中加入之前的反思,让AI避免同样错误。

实验效果:重复任务准确率大幅提升

论文在两个需要"从错误中学习"的任务上测试Reflexion:

-

** AlfWorld(文本冒险游戏)**:AI需要完成一系列指令(如"把书放进红色抽屉"),可能因步骤错误失败(如先开蓝色抽屉)。

- 无反思:成功率51%;

- 有反思:成功率提升到77%(+26%);

-

** 数学推理(MultiArith)**:AI需要解多步骤数学题,可能因漏看条件失败。

- 无反思:第一次尝试正确率40%,第二次(类似题)仍只有42%(几乎没进步);

- 有反思:第一次40%,第二次提升到63%(+23%)——学会了从错误中改进!

影响力:让AI从"一次性解题"到"持续学习"

Reflexion首次将"人类反思学习"的机制引入提示工程,证明了LLM可以通过"语言形式的反思"实现持续改进。这为开发"能适应新任务、不断优化自身行为"的AI智能体(Agent)奠定了基础,比如自适应客服(从每次对话错误中学习)、智能助手(从用户反馈中学习偏好)等。

论文五:《Direct Preference Optimization: Your Language Model is Secretly a Reward Model》(DPO:让AI"用更少数据,更快学会说人话")

基本信息

- 标题:直接偏好优化:你的语言模型其实是个奖励模型

- 作者:斯坦福大学等机构(Rafailov et al.)

- 发表时间:2023年7月

- 关键词:偏好对齐、RLHF替代方案、模型训练

AI痛点:传统偏好对齐方法(RLHF)太复杂、成本太高

为了让AI输出"人类喜欢的答案"(如更安全、更有用、更简洁),传统方法是RLHF(强化学习人类反馈),但RLHF有两个大问题:

- 步骤繁琐:需要先训练一个"奖励模型"(判断答案好坏),再用强化学习(RL)训练LLM,过程复杂,容易出bug;

- 成本高昂:需要大量人类标注的偏好数据(好答案vs坏答案),且训练时间长。

这导致小公司很难开发"对齐人类偏好"的LLM。

解决方案:跳过奖励模型,直接优化偏好(DPO算法)

斯坦福团队发现了一个"小秘密":LLM本身就可以作为"奖励模型"!不需要额外训练奖励模型,直接用偏好数据优化LLM参数。

DPO的核心公式(简化版):

LDPO(θ)=−E(x,yw,yl)∼D[log(efθ(yw∣x)/βefθ(yw∣x)/β+efθ(yl∣x)/β)] L_{DPO}(\theta) = -\mathbb{E}_{(x,y_w,y_l) \sim D} \left[ \log \left( \frac{e^{f_\theta(y_w|x)/\beta}}{e^{f_\theta(y_w|x)/\beta} + e^{f_\theta(y_l|x)/\beta}} \right) \right] LDPO(θ)=−E(x,yw,yl)∼D[log(efθ(yw∣x)/β+efθ(yl∣x)/βefθ(yw∣x)/β)]

通俗解释:

- xxx是问题,ywy_wyw是"好答案",yly_lyl是"坏答案";

- fθ(y∣x)f_\theta(y|x)fθ(y∣x)是LLM生成答案yyy的概率(即模型的输出);

- DPO的目标是:让模型生成ywy_wyw的概率远大于yly_lyl(即ef(yw)/βe^{f(y_w)/\beta}ef(yw)/β远大于ef(yl)/βe^{f(y_l)/\beta}ef(yl)/β);

- 不需要奖励模型,直接用LLM的输出概率优化参数θ\thetaθ。

DPO为什么比RLHF好?

- 更简单:省去训练奖励模型和RL步骤,直接用偏好数据微调LLM;

- 更稳定:RLHF容易出现"奖励模型过拟合"(奖励模型被LLM欺骗),DPO避免了这个问题;

- 数据效率更高:用更少的偏好数据就能达到和RLHF相当的效果。

实验效果:和RLHF效果相当,甚至更好

论文在多个对齐任务上对比DPO和RLHF:

- 帮助性(Helpfulness):人类评估"答案是否有用",DPO和RLHF得分相当(4.0 vs 4.1,满分5分);

- 无害性(Harmlessness):DPO生成的有害内容比RLHF少15%;

- 训练速度:DPO训练时间是RLHF的1/3;

- 数据效率:用10%的偏好数据,DPO能达到RLHF 95%的效果。

影响力:让"对齐人类偏好"变得平民化

DPO大幅降低了"训练对齐模型"的门槛:小公司和研究者不再需要复杂的RLHF pipeline,用少量偏好数据和简单的微调就能训练出"说人话"的LLM。这直接推动了开源社区的对齐模型发展,如开源的DPO版本LLaMA、Mistral等,让更多人能用上"安全、有用"的AI。

实际应用场景:如何用这些方法让你的AI更聪明?

学了这些高大上的论文,你可能会问:“我平时用ChatGPT/GPT-4,怎么用上这些方法?” 下面是5个实用场景和对应的"提示词模板",帮你立竿见影提升AI效果!

场景1:用CoT让AI解数学/逻辑题更准

适用情况:遇到复杂数学题、逻辑题(如"鸡兔同笼"),直接问可能答错。

提示词模板:

请解决这个问题,**必须先写出详细的推理步骤,再给出最终答案**。

问题:[你的问题]

推理步骤:

1. ...

2. ...

...

最终答案:

例子:

问题:“鸡兔同笼,共35个头,94只脚,鸡和兔各几只?”

AI用CoT会输出:

推理步骤:

1. 设鸡有x只,兔有y只;

2. 头的数量:x + y = 35(总头数35);

3. 脚的数量:2x + 4y = 94(鸡2只脚,兔4只脚);

4. 从步骤2得:x = 35 - y;

5. 代入步骤3:2(35 - y) + 4y = 94 → 70 - 2y + 4y = 94 → 2y = 24 → y = 12;

6. x = 35 - 12 = 23;

最终答案:鸡23只,兔12只。

场景2:用Self-consistency提升答案可靠性

适用情况:重要问题(如"算工资"“写合同条款”),担心AI一次算错。

提示词模板:

请用3种不同的方法解决这个问题,每种方法写出详细步骤和答案。最后,根据3种方法的结果,给出你认为最可能正确的答案。

问题:[你的问题]

方法1:

步骤:...

答案:...

方法2:

步骤:...

答案:...

方法3:

步骤:...

答案:...

最可能正确的答案:...

例子:

问题:“计算1234 × 5678 =?”

AI会生成3种计算方法(如竖式、分解法、凑整法),如果两种方法算出来是6906652,一种算错,最终会选6906652。

场景3:用ToT生成创意内容(故事、方案)

适用情况:写故事、想方案(如"策划公司年会"),需要多个创意方向。

提示词模板:

请帮我完成[任务]。请按以下步骤思考:

1. 列出3个可能的[开头/方案方向];

2. 评估每个方向的优缺点(1-5分);

3. 选择得分最高的方向,详细展开。

任务:写一个"机器人和猫成为朋友"的童话故事

AI会输出:

1. 可能的开头方向:

A. 机器人在垃圾场发现受伤的小猫,带回家修理;

B. 小猫误闯机器人实验室,按到按钮让机器人开机;

C. 机器人被派去抓流浪猫,却和一只猫成为朋友。

2. 评估:

A:温馨,有治愈感(4分);

B:有奇幻感,但有点老套(3分);

C:有冲突感,更有故事性(5分)。

3. 选择C方向展开:

故事开始:2077年,城市流浪猫泛滥,公司派机器人T-08去抓捕...

场景4:用Toolformer思想让AI调用工具

适用情况:需要最新信息(如"今天的天气")、计算(如"房贷月供")或

更多推荐

已为社区贡献6条内容

已为社区贡献6条内容

所有评论(0)