使用KTransformers安装Deepseek-r1满血版本实操

跟着步骤一步一步操作,每个人的机器上环境不一样,遇到问题解决对应的问题就好,祝你好运我是在linux上进行的操作,我的设备是一张3080和一张3090,内存是16张64gDDR4总1024g内存。

·

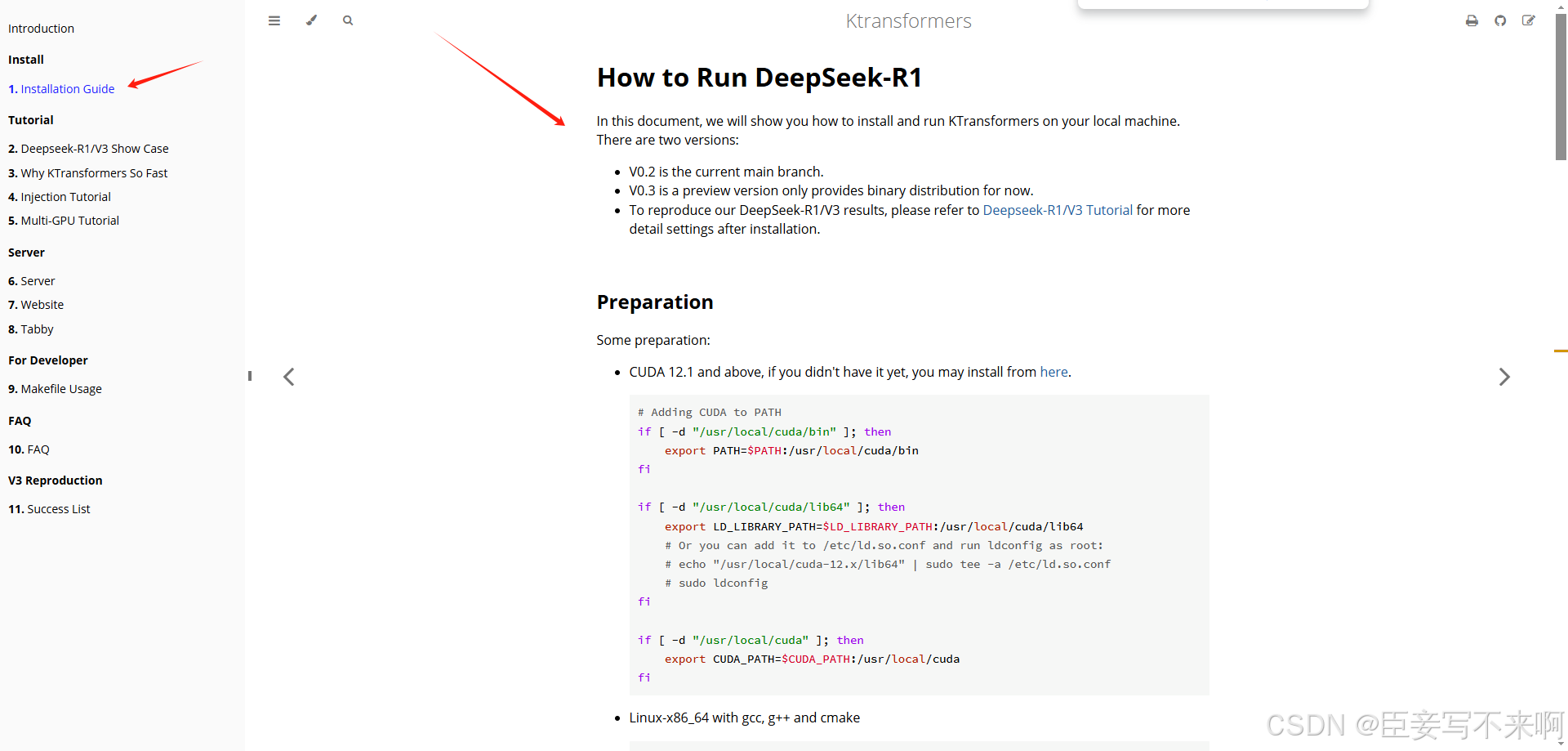

KTransformers官方文档:Installation Guide - Ktransformers

跟着步骤一步一步操作,每个人的机器上环境不一样,遇到问题解决对应的问题就好,祝你好运

我是在linux上进行的操作,我的设备是一张3080和一张3090,内存是16张64gDDR4总1024g内存

参考文章1:超详细的Linux-Conda环境安装教程_centos安装conda-CSDN博客

参考文章2:KTransformers:告别天价显卡!国产框架让单卡24G显存跑DeepSeek-R1 671B大模型:推理速度飙升28倍_24g显存跑671b大模型-CSDN博客

参考文章3:记录ktransformers的搭建过程-CSDN博客

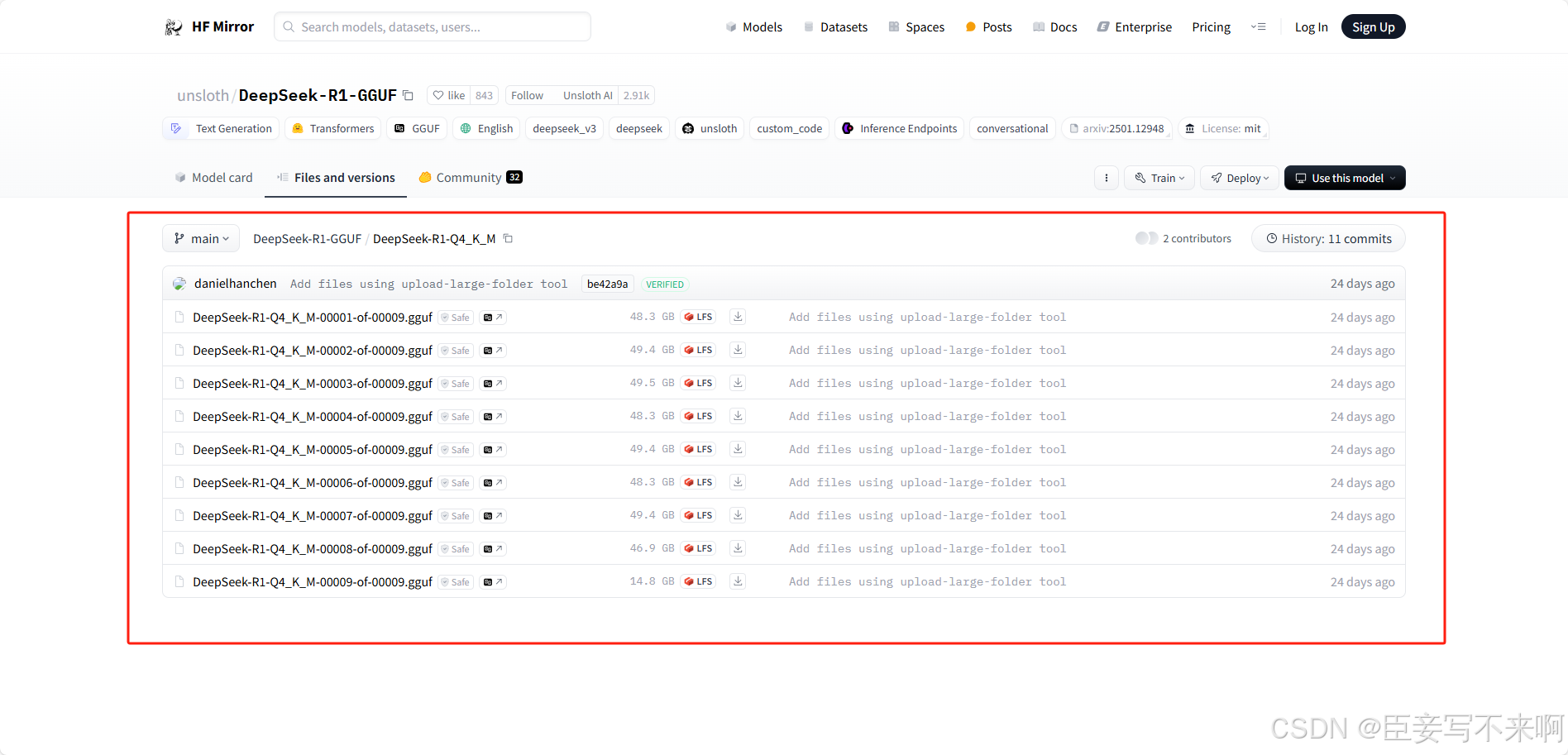

由于我在使用KTransformers的时候支持的R1模型只支持DeepSeek-R1-Q4_K_M这个版本,所以我在这里下载的,有墙,我是下到本地电脑后上传到服务器

下载地址:unsloth/DeepSeek-R1-GGUF at main

国内镜像:unsloth/DeepSeek-R1-GGUF at main

国内另一个下载源魔塔:魔搭社区

下载之后需要用工具聚合为一个包,因为这是进行了分片的包

注释 1:

你可能需要使用 Homebrew 安装 llama.cpp,命令如下:

/bin/bash -c "$(curl -fsSL https://raw.githubusercontent.com/Homebrew/install/HEAD/install.sh)"

brew install llama.cpp并使用 llama-gguf-split 合并分片文件,命令如下:

llama-gguf-split --merge DeepSeek-R1-UD-IQ1_M-00001-of-00004.gguf DeepSeek-R1-UD-IQ1_S.gguf

llama-gguf-split --merge DeepSeek-R1-Q4_K_M-00001-of-00009.gguf DeepSeek-R1-Q4_K_M.gguf参考文章4:如何将671B满血版DeepSeek R1部署到本地?保姆级教程来了!有手就会-CSDN博客

这篇文章里面,注释 1:这里会提到合并。

多卡启用策略

参考文章5:ktransformers/ktransformers/optimize at main · kvcache-ai/ktransformers · GitHub

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)