windows使用Ollama本地部署Deepseek-R1满血版,更改Ollama默认安装路径和模型存储位置,详细步骤教学,超简单!!!

本篇文章仔细讲解了如何通过ollama在windows系统上本地部署Deepseek大语言模型,并教会大家更改Ollama默认安装路径和模型存储位置,从而避免占用C盘空间,通过图文步骤教学,让大家拥有属于自己的AI模型,新手小白也能快速入门。有时候我们在输入ollama命令后出现报错,这时可以先退出ollama,通过任务栏ollama图标或任务管理器都可以退出ollama,然后重新运行命令即可。总

文章目录

前言

本篇文章仔细讲解了如何通过 ollama 在windows系统上本地部署Deepseek 大语言模型,并教会大家更改Ollama默认安装路径和模型存储位置,从而避免占用C盘空间,通过图文步骤教学,让大家拥有属于自己的AI模型,新手小白也能快速入门。

1、Deepseek本地部署

1.1 步驟1:Ollama的下载与安装

Ollama是一个开源的本地大语言模型(LLM)运行平台,专注于让用户能够轻松在个人电脑(Windows/macOS/Linux)上部署和运行各种开源AI模型(如DeepSeek、Llama、Mistral等)。

1. 下载Ollama

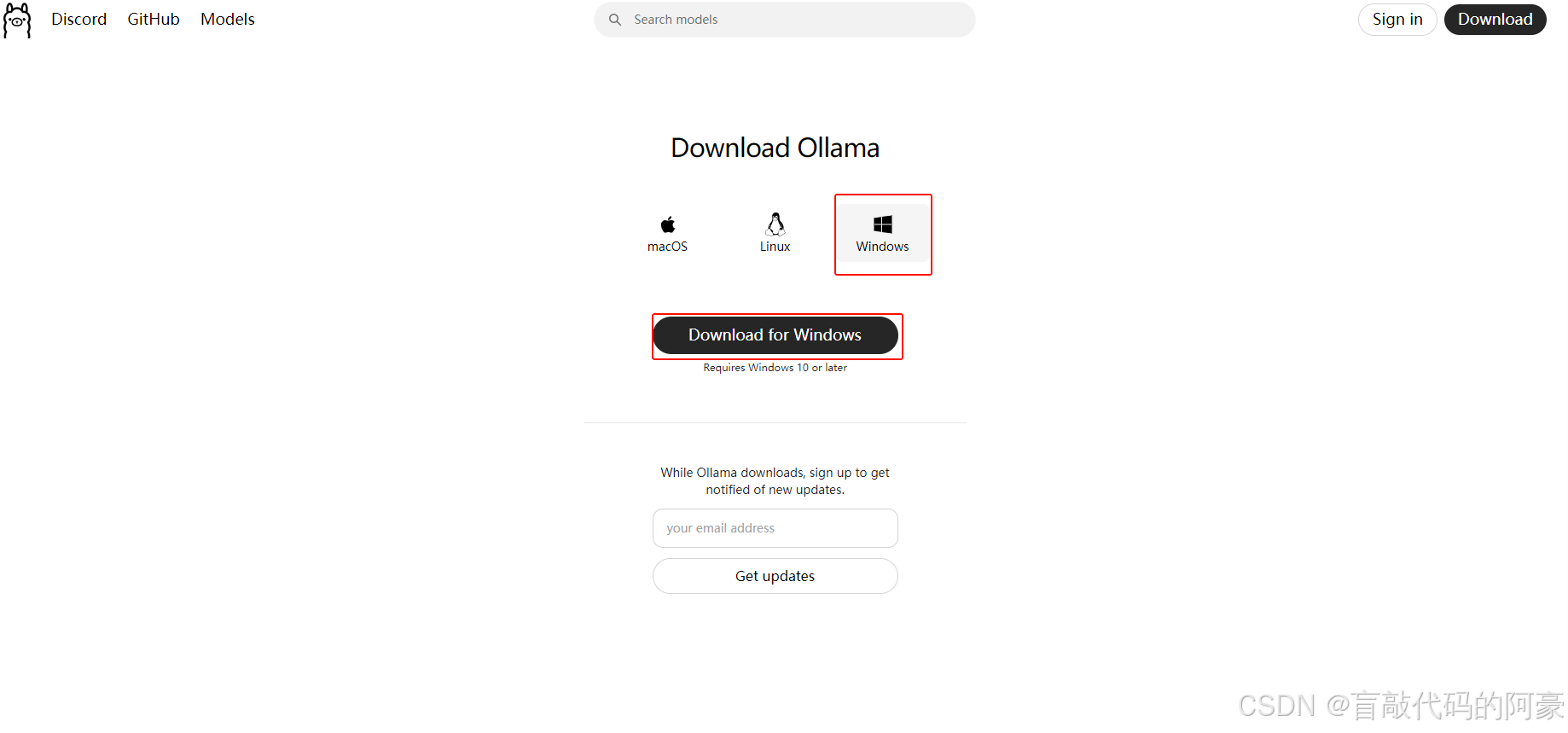

- 方法1:官网下载

这里我们下载Windows版本的即可,由于在浏览器下载速度缓慢,可以复制其下载链接,进入迅雷等工具内进行下载

- 方法2:网盘下载

- 123云盘:https://www.123865.com/s/Tzrfjv-xXGw3

提取码:ah66 - 迅雷:https://pan.xunlei.com/s/VOM_iCWWouybTDgdVy-nksCMA1

提取码:wy9m

考虑到大家下载速度过慢,我已经提前下载好放入上面两个网盘中了,大家可自行提取

- 123云盘:https://www.123865.com/s/Tzrfjv-xXGw3

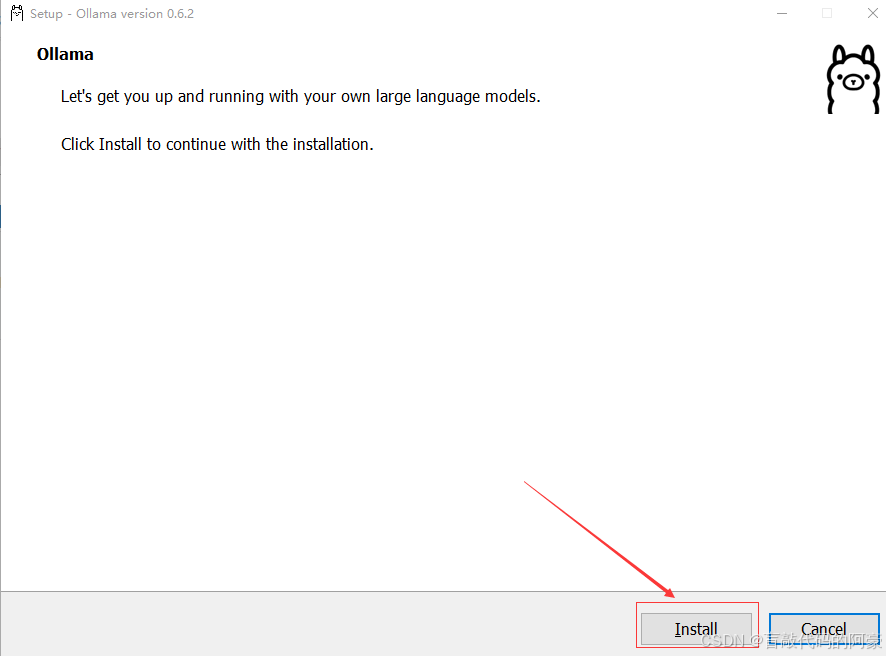

2. 安装Ollama

下载好安装包后,双击运行,点击

Install,默认安装在C盘,这里没有提供更改安装位置的选项,至少需要5G的内存空间

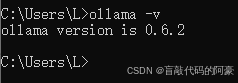

3. 校验Ollama是否安装成功

-

打开终端(管理员权限的PowerShell或CMD),输入命令:

ollama -v

1.2 步骤2:下载DeepSeek模型

-

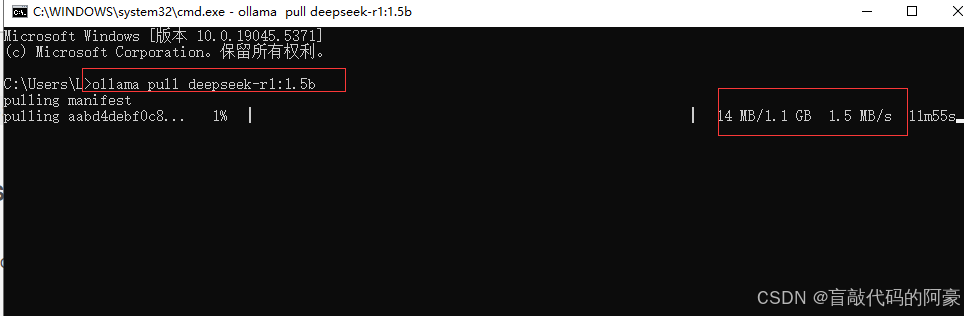

打开终端(管理员权限的PowerShell或CMD),输入以下命令下载模型:

ollama pull deepseek-r1:1.5b # deepseek最小可用模型,显存需求低案例演示:(下载会显示进度条,若不小心中断下载,重新输入命令,会接着刚刚的位置继续下载)

-

DeepSeek模型版本:

-

deepseek-r1:1.5b:(1.1GB)轻量级问答/代码生成 -

deepseek-r1:7b:(4.7GB)复杂推理/多轮对话 -

deepseek-r1:14b:(9GB)专业领域分析 -

deepseek-r1:671b:(需404GB,仅限专业硬件)

-

Tips:ollama支持同时下载多个模型版本,通过启动不同版本,可以享受不同的AI模型。

1.3 步骤3:启动模型对话

-

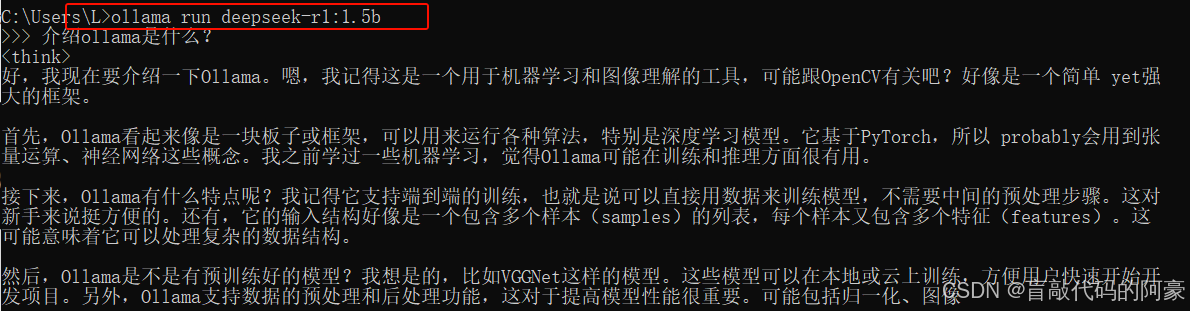

在终端输入命令进入交互模式:

ollama run deepseek-r1:1.5b注意:若运行的模型未下载,执行该命令后,会直接下载该模型

-

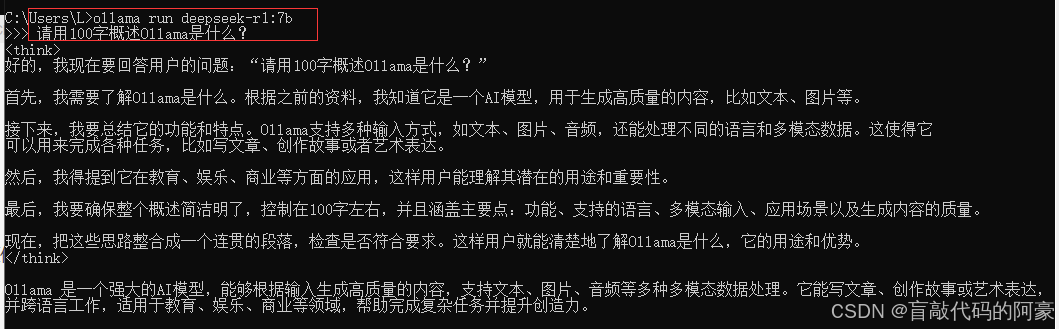

输入问题即可与模型对话(支持中英文),如下:(注:这里使用的是 7b 版本)

-

基础交互命令:

ctrl+c:中断模型回答ctrl+d 或 /bye:退出交互模式,也就是退出对话

1.4 常见问题及总结

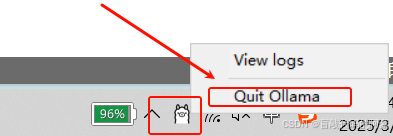

有时候我们在输入ollama命令后出现报错,这时可以先退出ollama,通过

任务栏ollama图标或任务管理器都可以退出ollama,然后重新运行命令即可。

总结:

-

推荐新手:优先使用Ollama方案,简单快捷且社区支持完善。

-

硬件限制:显存不足时避免尝试14B及以上模型,1.5B或7B已能满足基础需求。

-

数据安全:本地部署适合对隐私要求高的场景(如医疗、金融),但需承担硬件成本。

如需进一步优化或部署大规模模型(如671B),需专业服务器及多卡配置。

2、Ollama基础命令及使用

2.1 模型管理命令

1、下载模型

# 指定模型版本(需确认版本存在)

ollama pull deepseek-r1:7b

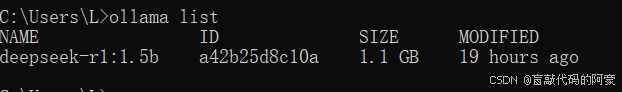

2、查看已下载的模型

ollama list

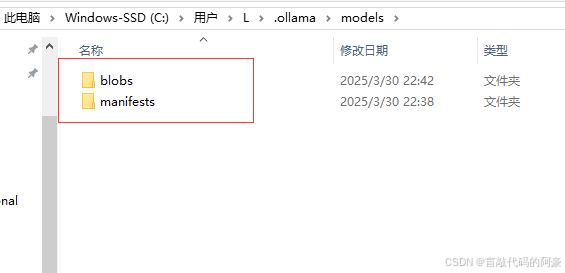

示例:

3、删除模型

# 指定对应的模型版本即可删除

ollama rm deepseek-r1:1.5b

2.2 运行与交互命令

1、启动模型对话

# 指定启动的模型版本即可

ollama run deepseek-r1:1.5b

输入问题后按回车,模型会生成回答(支持多轮对话,按Ctrl+C中断模型回答)

2、单次提问模式

ollama run deepseek-r1:1.5b "如何学习Python?"

2.3 ollama默认安装路径及模型下载位置

1、ollama安装路径

ollama默认安装在C盘下,在安装时会选择为单独用户安装和为所有用户安转,导致路径有所不同:

- 单独用户:

C:\Users\你的用户名\AppData\Local\Programs\Ollama- 所有用户:

C:\Program Files\Ollama\ollama.exe

如果是 64 位系统,也可能是:C:\Program Files (x86)\Ollama\ollama.exe

也可以直接在cmd命令窗口输入:where ollama,查看ollama安装路径

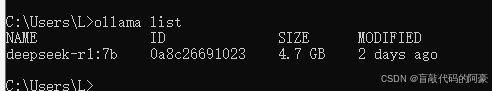

如果都找不到,可以打开任务管理器,右键点击ollama进程,打开文件所在位置:

Tips:

ollama在安装后,会默认加入电脑开机自启的选项,不用手动启动即可在cmd命令窗口运行服务

2、模型存储位置

模型下载后存储的位置:

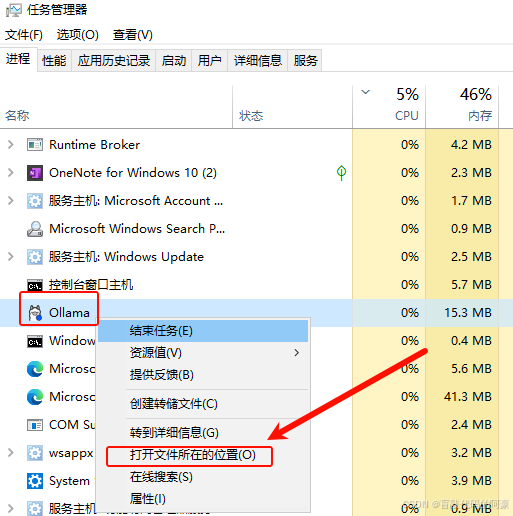

C:\Users\<你的用户名>\.ollama\models或C:\用户\<你的用户名>\.ollama\models

在下载模型后,会自动生成blobs和manifests两个文件夹,用于存放模型和缓存,删除这两个文件夹即可删除下载的所有模型

3、扩展:技能提升

3.1 更改ollama默认安装位置和模型存储位置

ollama官网下载的安装包,默认会将其安装在电脑的C盘,包括后续下载的所有AI模型,默认存储路径也在C盘,随着后续任务量不断增加,C盘的空间会不断被压缩,导致系统卡顿。因此,接下来我将针对这个问题,教大家如何更改ollama的安装路径,以及模型的存储位置

首先,我们需要从官网下载并安装好ollama,接下来进行下面的步骤:

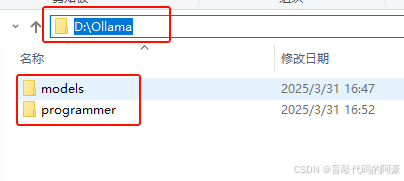

步骤1:创建新的文件夹

- 在D盘创建一个文件夹,命名为

Ollama,并在该文件夹下创建models和paogrammer两个文件夹

这里我选择在D盘创建文件夹,大家可根据需求,选择合适的盘符

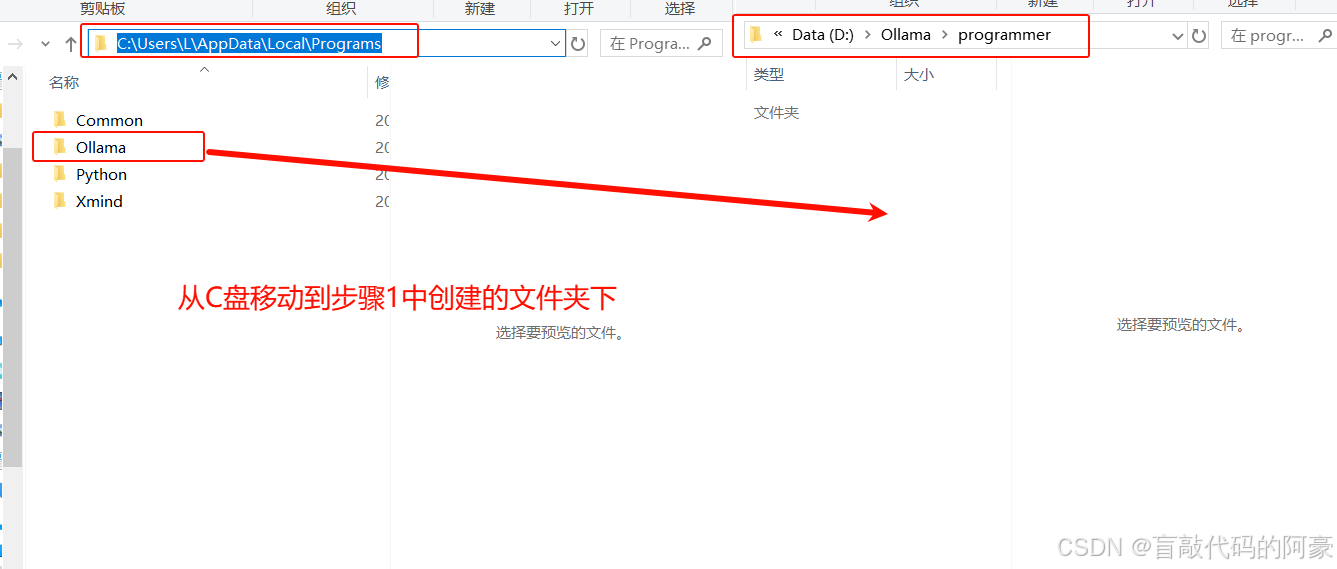

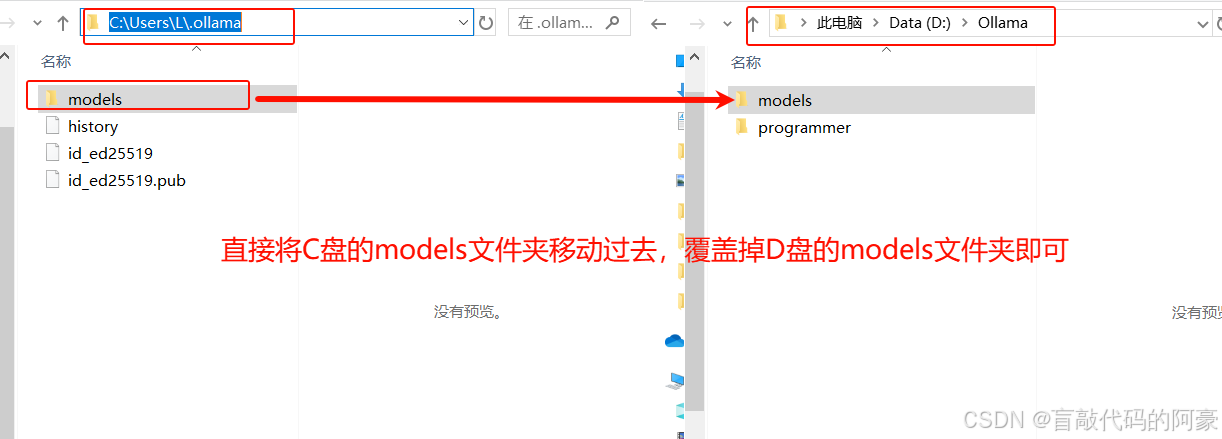

步骤2:将默认路径下的文件夹移动到新创建的文件夹下

- 移动

ollama默认安装文件夹:

- 移动模型默认存储文件夹:

如果models内已经下载了模型,不用删除,同样按照上述方法移动即可,后续配置好后依旧可以使用,不用重新下载

注意:

将上述两个C盘类的文件夹移动后,记得删除,不然会占用C盘空间,若找不到这两个文件夹的存储路径,可以参考本篇文章 2.3 小节

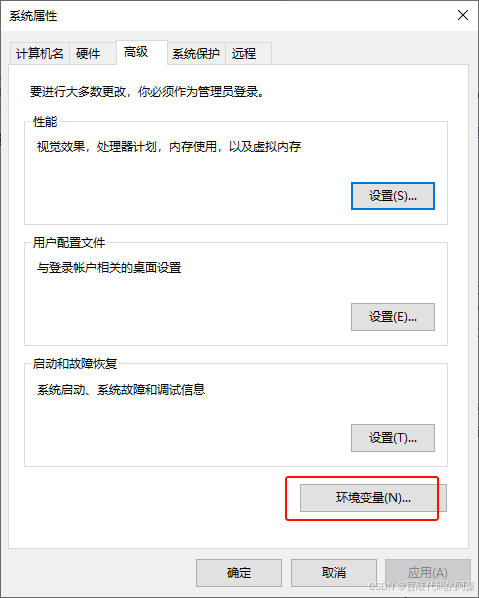

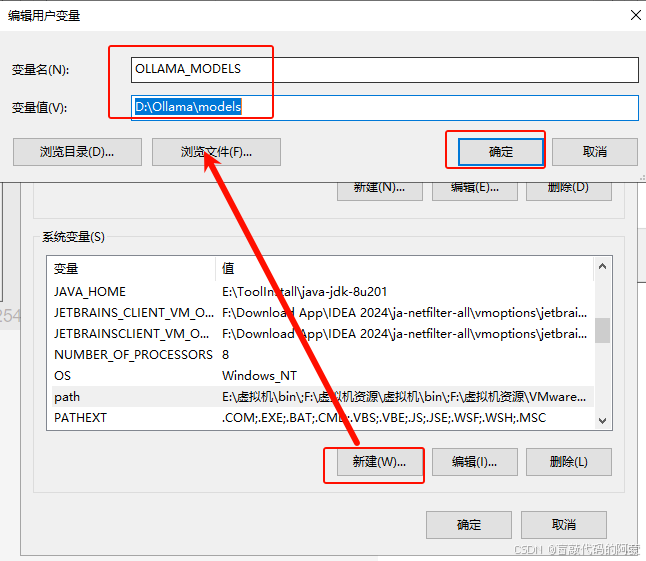

步骤3:修改 环境变量

- 在桌面右键

计算机,点击属性,找到高级系统设置,点击环境变量

- 在

系统变量下 新建变量,变量名为OLLAMA_MODELS,变量值为D:\Ollama\models

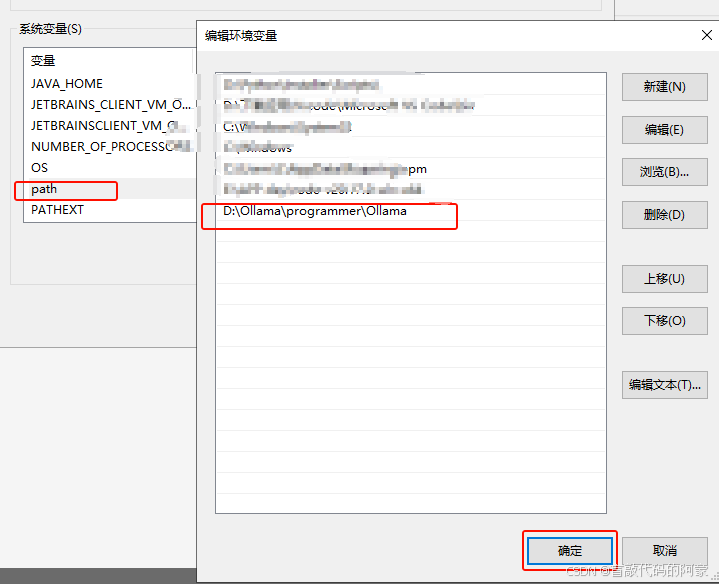

- 修改

path环境变量,添加移动后ollama的安装路径:D:\Ollama\programmer\Ollama

添加完所有变量后,不断点击确定,然后退出

步骤4:测试ollama能否正常使用

-

首先确保

Ollama处于关闭状态,可以查看任务栏图标或任务管理器,若是启动状态,需要将其关闭

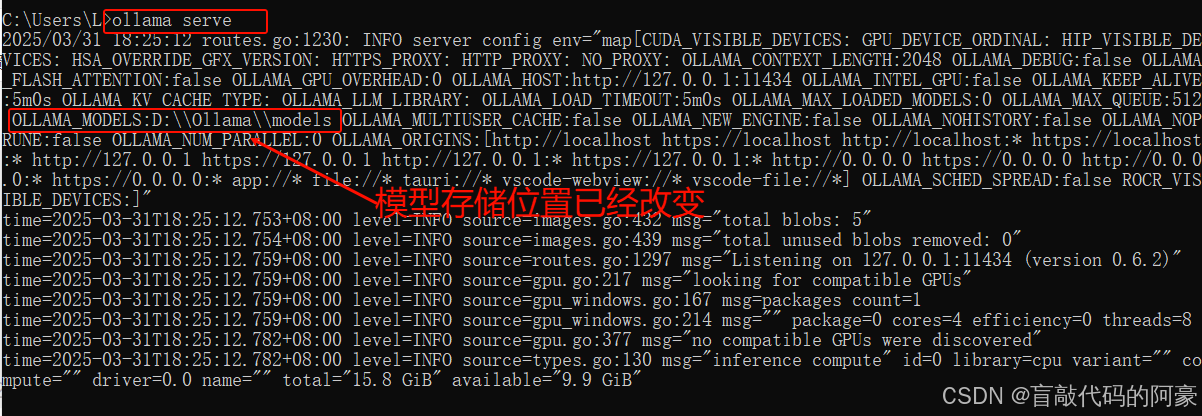

-

打开 CMD命令窗口,输入:

ollama serve,查看服务日志,可以看到命令成功执行,且模型默认存储位置已成功修改,按ctrl+c可以退出当前状态

ollama serve命令只能在ollama退出后,首次输入才能运行,若ollama已经启动,输入该命令可能会报错 -

输入命令:

ollama list查看原来下载的模型是否存在,若原来没有下载模型,输入命令下载即可

-

运行模型:

ollama run deepseek-r1:1.5b,看能否使用

问题解决:

若无法运行ollama命令或无法下载和查看模型,可能是环境变量还未生效,可以尝试重启电脑,再次运行命令。

3.2 通过python调用本地部署Deepseek模型的API接口

参考下面这篇文章:

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)