美团放大招:5600亿参数AI模型LongCat开源,本地生活服务迎来智能新革命

你以为美团只会送外卖?这个每天穿梭在城市大街小巷的本地生活巨头,正以"跨界运动员"的姿态在AI赛道上演华丽转身——它悄悄造出的大语言模型LongCat,不仅比DeepSeek更快,更在2025年9月以开源姿态正式加入全球AI竞赛。这场跨界并非偶然,而是美团基于千万级商户数据、亿级用户行为轨迹积累的必然结果,当这些覆盖餐饮、零售、酒店、配送的复杂场景数据与AI碰撞,催生的不仅是技术突破,更是本地生活

从外卖到AI:美团的"跨界突袭"

你以为美团只会送外卖?这个每天穿梭在城市大街小巷的本地生活巨头,正以"跨界运动员"的姿态在AI赛道上演华丽转身——它悄悄造出的大语言模型LongCat,不仅比DeepSeek更快,更在2025年9月以开源姿态正式加入全球AI竞赛。这场跨界并非偶然,而是美团基于千万级商户数据、亿级用户行为轨迹积累的必然结果,当这些覆盖餐饮、零售、酒店、配送的复杂场景数据与AI碰撞,催生的不仅是技术突破,更是本地生活服务的智能化革命。

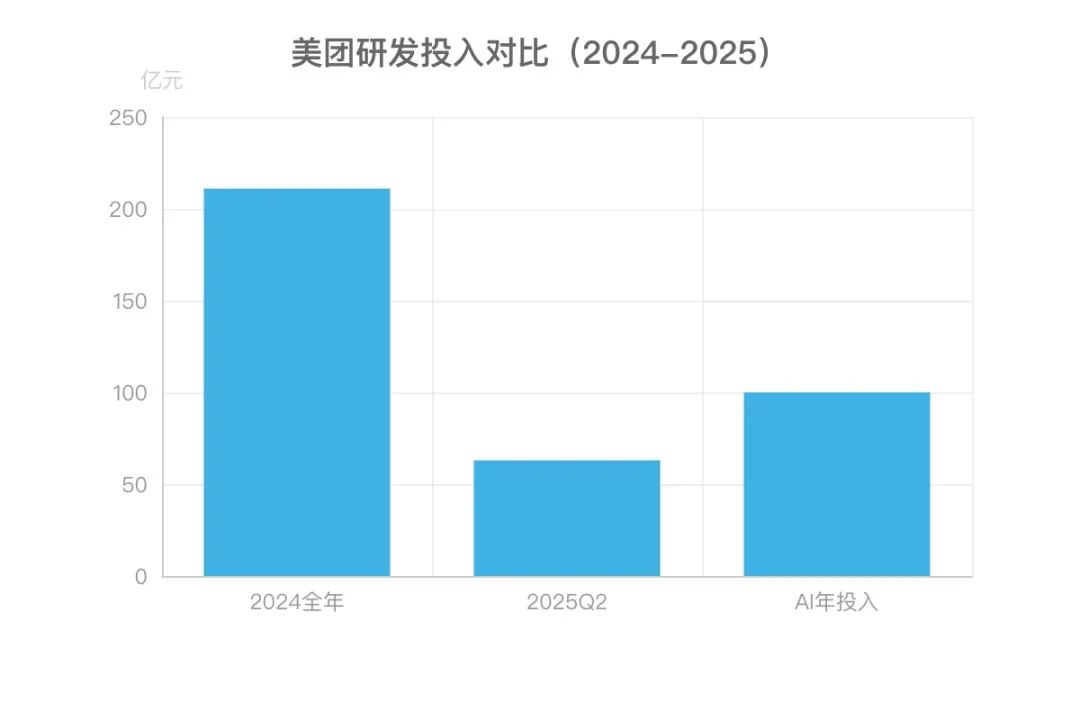

美团CEO王兴的判断一针见血:"AI不是选择题而是生存题"。这位互联网老兵将AI提升至公司治理核心,提出"主动出击"而非"被动防御"的战略框架,明确三大方向:通过AI提升40万员工效率的"AI at work"、优化B/C端产品的"AI in products",以及构建自研大语言模型的"Building LLM"。这种战略决心转化为真金白银的投入:2025年第二季度研发开支达63亿元,同比增长17.2%,占收入比例6.8%,2024年全年研发投入更是高达211亿元,核心本地生活业务每年在AI上的投入超百亿元。

美团AI战略的"三级跳"

-

效率革命:AI编程助手、智能会议安排等工具已渗透日常运营,27%的新代码由AI生成,客服效率提升20%,客户满意度提高7.5个百分点。

-

产品升级:推出AI经营决策助手"袋鼠参谋"、酒店垂类AI Agent"美团既白",用AI重构商户服务链路。

-

技术突围:从2025年3月LongCat作为内部助手上线,到9月开源LongCat-Flash-Chat模型,完成从应用到基础模型的跨越。

LongCat的诞生恰是这场战略的集大成者。这个5600亿参数的MoE模型,天生带着美团本地生活的"场景基因"——用户一次外卖下单涉及商户库存、配送路径、支付规则等10余个系统协同,而LongCat作为智能体,能像"超级调度员"般完成工具调用与流程编排,将AI从对话助手升级为业务引擎。更值得注意的是,其训练未依赖英伟达GPU,而是采用"数万个加速卡"的自主硬件方案,这种"接地气"的技术路径,或许正是美团跨界AI最独特的底气。

从收购AI初创公司Light Year(2.81亿美元)组建独立AI军团,到API调用量从2024年10%飙升至2025年68%,美团用两年时间证明:当外卖员的电动车轮与AI的数据流同频转动,这家公司正在重新定义"本地生活"的边界。如今LongCat-Flash-Chat的开源,不仅是技术自信的宣言,更可能成为撬动整个本地生活服务智能化的支点——毕竟,没有谁比美团更懂这个赛道的"烟火气",也没有谁比它更擅长用技术点燃这场烟火。

当AI学会"分工干活":LongCat的三大黑科技

AI界的“效率冠军”是怎么炼成的?美团最新开源的LongCat模型用5600亿参数实现了比手机还快的响应速度,背后藏着三项颠覆传统的“干活哲学”。

512个“专家”的分工哲学:拒绝全员加班

传统大模型像工厂流水线,每个任务都要调动所有机器全力运转,而LongCat采用的混合专家(MoE)架构更像高效的公司团队——512个“AI专家”各有所长,每个输入仅需激活其中少数专家(平均约270亿参数,仅占总参数的4.8%)。就像餐厅后厨不会让所有厨师都炒同一道菜,LongCat让擅长语义理解的专家处理对话、擅长逻辑推理的专家应对复杂问题,通过“专人专岗”避免5600亿参数“全员加班”,既保证了模型能力又降低了计算负担。

零计算专家的“懒人智慧”:简单问题不浪费算力

如果说MoE架构是“分工哲学”,那“零计算专家机制”就是LongCat的“懒人智慧”。模型在专家池中加入了特殊的“零计算专家”,它们接到简单任务时直接“抄近路”——比如处理常见词汇或标点符号时,不做任何复杂运算,直接返回输入结果,像超市自助结账机处理小额支付一样高效。这种设计让40%的简单请求免于占用高端算力,实现“算力按需分配”:复杂问题交给全职专家(标准FFN专家),简单任务交给“兼职助手”(零计算专家),既保证精度又节省资源。

关键数据:LongCat总参数达5600亿,但每个输入平均仅激活270亿参数,通过PID控制器动态调节专家负载,确保计算资源分配始终处于最优状态。

外卖骑手式并行通信:5600亿参数为何比手机还快

最令人惊叹的是LongCat的“闪电响应速度”,这要归功于快捷连接MoE(ScMoE)架构的“并行通信技术”。传统大模型的计算和通信像快递员“送完一单再取下一单”,串行操作浪费时间;而ScMoE通过跨层通道让上一层的计算与下一层的通信“同时进行”,就像外卖骑手在等餐时提前联系下一单商家,取餐送餐无缝衔接。这种“计算-通信重叠”设计让模型在H800芯片上实现100+ tokens/s的推理速度,理论上把每个词元的生成时间(TPOT)缩短近50%,最终实现5600亿参数模型的响应速度堪比手机操作。

从“分工协作”到“按需出力”再到“并行提速”,LongCat用这三大黑科技重新定义了大模型的效率标准,也为本地生活服务场景的智能化铺平了道路。

比快更快:LongCat的"性能成绩单"

如果把AI大模型比作外卖骑手,LongCat-Flash无疑是那个总能提前送达的"五星骑手"——别人需要30分钟配送的服务,它10分钟就能热气腾腾地送到用户手上。这种"比快更快"的性能优势,不仅体现在直观的响应速度上,更通过成本控制与任务执行能力的多维突破,重新定义了本地生活服务场景下的AI效率标准。

闪电级推理:从"等餐焦虑"到"秒级响应"

LongCat-Flash将推理速度推至新高度,实现单卡每秒处理100+ token的吞吐量,这意味着用户输入问题后,答案几乎能以"打字速度"同步生成。实测数据更具说服力:面对初中数学题"求分式方程1/2x=2/(x-3)的解",LongCat仅用5秒就输出完整解题步骤,而同类模型DeepSeek需要18秒;在文学创作场景中,LongCat实现"秒级响应",DeepSeek则需等待11秒才能生成第一段文字。这种速度差距在高频交互的本地生活场景中至关重要——当用户询问"附近奶茶店排队情况"或"外卖订单实时位置"时,每一秒的延迟都可能降低服务体验。

从技术指标看,LongCat-Flash的推理性能实现"双超越":不仅推理吞吐量比Llama 3.3-70B提升5倍,在H800 GPU上的单用户生成速度(100+ tokens/s)更是显著超越同期Llama 3(80 tokens/s)和Gemini 2.5 Pro(约40 tokens/s)。正如行业观察所言:**"速度不是全部,但没有速度的AI就像外卖超时的骑手——再强的能力也会被差评淹没"**。

成本"地板价":每百万token仅需5元人民币

在速度之外,LongCat-Flash通过架构优化实现了"极速又极省"的成本控制。其推理成本低至每百万输出token 0.7美元(约合5元人民币),仅为行业平均水平的1/3。这一成本优势背后,是560B参数模型仅激活27B动态参数(平均激活率4.8%)的高效设计,以及多步重叠调度器等技术创新,让算力资源像"外卖箱空间"一样被极致利用。

对本地生活服务平台而言,这种低成本意味着可以为用户提供"无限续杯"的AI交互服务——无论是餐饮推荐、优惠券计算还是售后咨询,都无需担心因调用成本过高而限制使用频次。有测算显示,若某外卖平台日均处理1亿次AI交互,采用LongCat-Flash可使年成本降低超2000万元。

Agent能力"超纲":工具调用得分碾压竞品

LongCat-Flash的"骑手技能"不止于快,更在于复杂任务的"一次性做对"能力。在智能体(Agent)工具调用评测中,其表现尤为突出:在电信场景τ²-Bench基准测试中,LongCat-Flash以73.68分的成绩远超竞品,得分是Claude4 Sonnet(46.20分)的1.6倍,DeepSeek V3.1(38.50分)的1.9倍。这意味着在需要调用地图、支付、客服等多工具的本地生活场景中,LongCat能像"熟悉全城路况的老骑手"一样,精准规划工具调用路径,避免无效操作。

权威基准测试进一步验证了其综合实力:在指令遵循领域,IFEval得分89.65分超越Claude4 Sonnet(88.35分);数学推理领域,MATH500准确率96.40分领先DeepSeek V3.1(96.08分); ArenaHard-V2通用能力评测中,86.50分的成绩位列全球模型第二。以下为核心测试结果对比:

|

测试领域 |

具体基准 |

DeepSeek V3.1 |

Claude4 Sonnet |

LongCat-Flash |

|---|---|---|---|---|

|

通用能力 |

ArenaHard-V2 |

84.10 |

62.10 |

86.50 |

|

指令遵循 |

IFEval |

86.69 |

88.35 |

89.65 |

|

COLLIE |

43.80 |

51.22 |

57.10 | |

|

数学推理 |

MATH500 |

96.08 |

93.80 |

96.40 |

|

Agent工具调用 |

τ²-Bench(telecom) |

38.50 |

46.20 |

73.68 |

性能启示:当AI速度、成本与能力形成"铁三角"优势,意味着本地生活服务中的"AI客服响应慢""智能推荐不准""多步骤操作繁琐"等痛点,将迎来系统性解决方案。LongCat-Flash的出现,不仅是技术参数的突破,更是对"AI服务体验"的重新定义——就像外卖骑手的"准时率"与"配送质量"同等重要,AI的"速度"与"能力"缺一不可。

从5秒解出数学题到0.7美元/百万token的成本控制,从电信场景工具调用的碾压性得分到秒级响应的交互体验,LongCat-Flash用"性能成绩单"证明:在本地生活服务的AI革命中,"快"是基础,"又快又好又省"才是核心竞争力。这或许正是美团将其开源的底气——当技术优势转化为服务优势,每个用户都能成为"五星好评"的受益者。

不止快,更要"有用":LongCat的生活服务实战

"今晚想吃火锅,但不想排队,还得避开辣锅,记得给孩子留宝宝椅——"当你对着手机说出这句话时,LongCat已经默默调出你的历史订单偏好,自动完成餐厅筛选、订座备注,甚至提醒你常去的那家火锅店今天有宝宝椅活动。这不是科幻电影里的场景,而是美团5600亿参数AI模型LongCat在本地生活服务中的真实落地。对LongCat来说,技术的终极目标从来不是实验室里的跑分,而是成为那个能帮你解决"今晚吃什么"的贴心朋友。

从"听懂"到"解决",AI客服的人性化进化

生活服务里的问题往往藏在口语化的抱怨中。当你对着客服说"外卖洒了一半,汤都快没了",LongCat能瞬间捕捉到"洒了一半"这个核心诉求,自动触发理赔流程——无需你重复描述细节,也不用等待人工转接。这种"听得懂人话"的能力,背后是模型在IFEval(指令遵循评估基准)89.65分的顶尖表现,以及针对美团10亿级用户真实对话数据的深度训练。数据显示,接入LongCat后,美团智能客服的客户满意度提升了超过7.5个百分点,运营效率直接提升20%。

商户的"智能管家":让数据为经营决策买单

对商家而言,LongCat更像一位懂行的"经营参谋"。成都一家连锁火锅店老板发现,自从用上LongCat驱动的"袋鼠参谋"系统,备货损耗率下降了15%——因为模型会结合实时天气(比如周末暴雨)、商圈人流热力图,甚至周边写字楼的加班情况,动态预测第二天的食材需求量。北京三里屯的奶茶店则通过LongCat的库存预警功能,在去年国庆假期前提前3天备足了爆款饮品原料,避免了因断货导致的日均3万元损失。这些改变的核心,在于LongCat将复杂的AI能力转化为商家"看得懂、用得上"的工具:不是冰冷的数据流,而是"明天多备20%珍珠"这样直接的行动建议。

技术哲学:不炫技,只解决真问题

LongCat-Flash被定义为"非思考型基础模型",它不追求学术论文里的多步推理跑分,而是专注于"工具调用、环境交互、多轮信息处理"这些生活服务场景的刚需能力。就像美团工程师所说:"我们不需要AI帮用户解微积分,而是要让它在用户说'外卖洒了'时,10秒内启动理赔;在商家问'明天备多少菜'时,给出结合天气和人流的精准答案。"

从"工具"到"朋友",AI如何走进日常生活?

LongCat的"有用",更体现在它对生活细节的理解。当你纠结"今晚吃什么"时,它会结合你的饮食偏好、附近商圈排队情况、甚至当天天气推荐——雨天推热汤面,晴天推荐户外露台餐厅;母亲节时,它不仅会提醒你"美团买菜今天有50元妈妈专享券",还会自动生成"给妈妈做顿饭"的食材清单。这种"比你更懂你"的体验,源于模型对美团10年积累的生活服务数据的深度消化:它认识"宝宝椅""微辣免蒜"这些行业黑话,也理解"外卖洒了"背后的情绪价值。

如今,LongCat已渗透进美团生态的毛细血管:从消费者的"专属生活小秘书",到商家的"智能经营助手",再到内部员工的AI编程工具(27%的新代码由AI生成)。这些落地场景共同指向一个结论:真正有价值的AI,不是站在实验室聚光灯下的技术展品,而是能蹲下来帮你系鞋带的伙伴。当技术开始认真解决"订火锅""修水管""今晚吃什么"这些琐碎却重要的问题时,本地生活服务的智能革命,才算真正到来。

开源背后:美团的"AI生态野心"

当美团将5600亿参数的LongCat-Flash模型以最宽松的MIT许可证全盘开源时,业界突然意识到:这场看似"技术普惠"的举动,实则是美团在AI时代下的生态棋局。不同于巨头们封闭模型的"围墙策略",美团选择了一条更开放的路径——用代码和权重的开放,编织一张覆盖开发者、商户与用户的AI生态网络。

用"低门槛"敲开生态大门

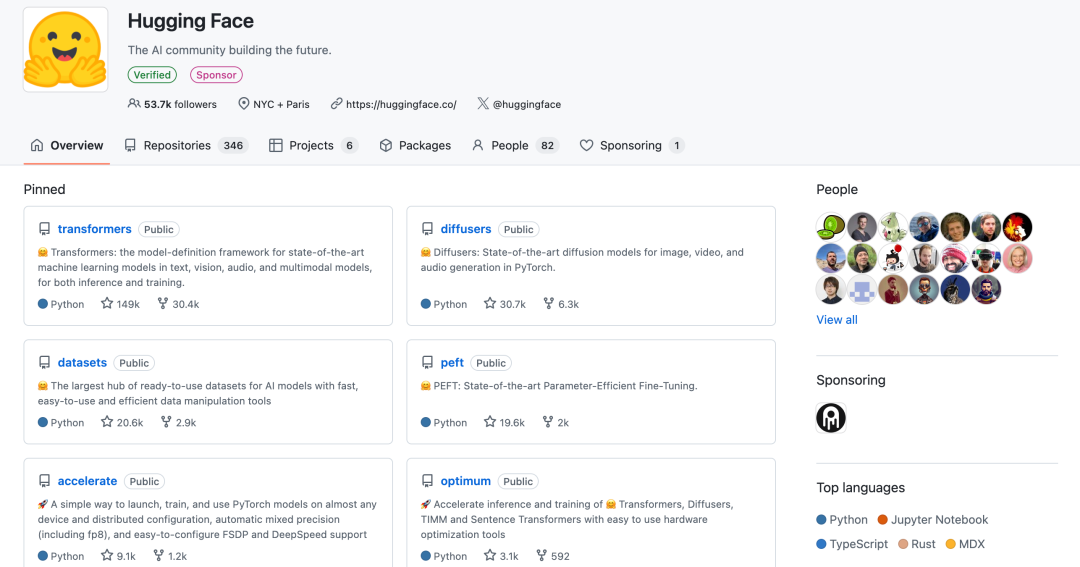

LongCat的开源策略从一开始就带着强烈的"普惠基因"。美团不仅在GitHub与Hugging Face同步开放全部代码与模型权重,更采用了允许自由修改、商用的MIT许可证,开发者甚至无需支付任何费用就能将其用于企业级应用,唯一的约束仅是"不滥用美团商标"。为了让技术真正"能用起来",官方还配套了SGLang/vLLM推理框架适配方案、详细的《Deployment Guide》环境配置手册,甚至标准化的Chat模板,连中小团队都能按图索骥完成部署。

这种"零门槛"策略迅速见效:模型开源首日GitHub Star破万,单周Hugging Face下载量超5万,开发者社区里涌现出物流调度优化、智能客服插件等基于LongCat的创新应用。正如美团AI团队在技术博客中所言:"我们希望LongCat成为开发者的‘脚手架’,而不是仅供仰望的‘黑箱子’。"

生态吸引力的核心密码

• 成本革命:推理成本低至5元/百万token,较同类模型下降超50%,中小企业也能负担。

• 即插即用:提供在线体验入口(https://longcat.chat/)和单机部署命令,10分钟即可启动模型。

• 场景适配:预置生活服务专用模板,覆盖单轮/多轮对话、工具调用等高频需求。

短期防御与长期重构的"双轨战略"

经济学者盘和林曾犀利指出,美团开源LongCat的底层逻辑是"防止对手用AI颠覆行业"。在本地生活赛道,当竞争对手试图用AI优化配送路径、预测消费需求时,美团通过开放模型底座,相当于将"技术护城河"变成了"生态护城河"——全球开发者的每一次优化、每一个基于LongCat的创新应用,都在间接强化美团的技术壁垒。

但这盘棋的落点远不止于防御。美团AI战略明确分为"AI at work(企业效率)、AI in products(产品智能)、Building LLM(大模型研发)"三层,LongCat正是"Building LLM"的关键落子。通过开源汇聚的开发者智慧,将反哺美团数百万商户的实际需求:餐厅老板能用低成本接入智能菜单推荐,便利店可借助AI预测库存,甚至骑手调度系统能更精准规划路线。这种"商户数据养模型,模型优化反哺商户"的正向飞轮,正是美团"用AI重构本地生活基础设施"的核心野心。

从"模型"到"生活助手"的终极进化

当技术回归生活本身,LongCat的价值开始显现出温度。不同于专注知识问答的通用模型,它更像一个扎根生活场景的"超级助手"——依托美团数亿用户的交易评价、实时配送数据和商户动态信息,能完成从"帮你选餐厅"到"规划配送时间"的全链路服务。王兴曾说:"只有将人工智能深度融入到业务中,才能真正实现效率与服务的双重提升",这句话或许揭示了AI的终极形态:不是打败人类的"超级大脑",而是成为每个普通人的"生活搭档"。

想象这样一个场景:未来你加班到深夜打开外卖App,LongCat已根据你的口味偏好和健康数据筛选出三家餐厅,自动避开配送超时的区域,甚至在下单时就帮你备注"麻烦放门口,谢谢"。这种"润物细无声"的智能,或许正是美团通过开源LongCat想要抵达的终点——未来的AI不是颠覆生活,而是像外卖小哥一样,默默成为你生活中不可或缺的帮手。

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)