冲上热搜!美团首个开源大模型来了!5600亿参数,推理速度比DeepSeek-V3快50%

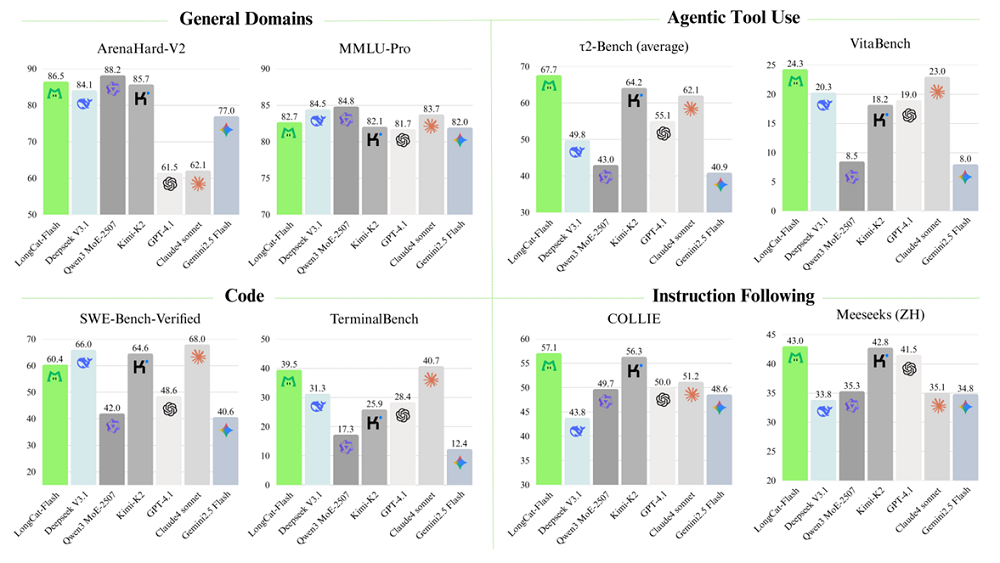

与DeepSeek-V3.1、Kimi-K2、Qwen3 MoE-2507等头部开源模型相比,LongCat-Flash在通用领域、编程等场景的能力还有一定差距,技术报告链接:github.com/meituan-longcat/LongCat-Flash-Chat/blob/main/tech_report.pdf。GitHub地址:github.com/meituan-longcat/Long

9月1日,美团发布了其首款开源大模型LongCat-Flash,这是一款拥有5600亿个总参数的MoE(混合专家)模型。

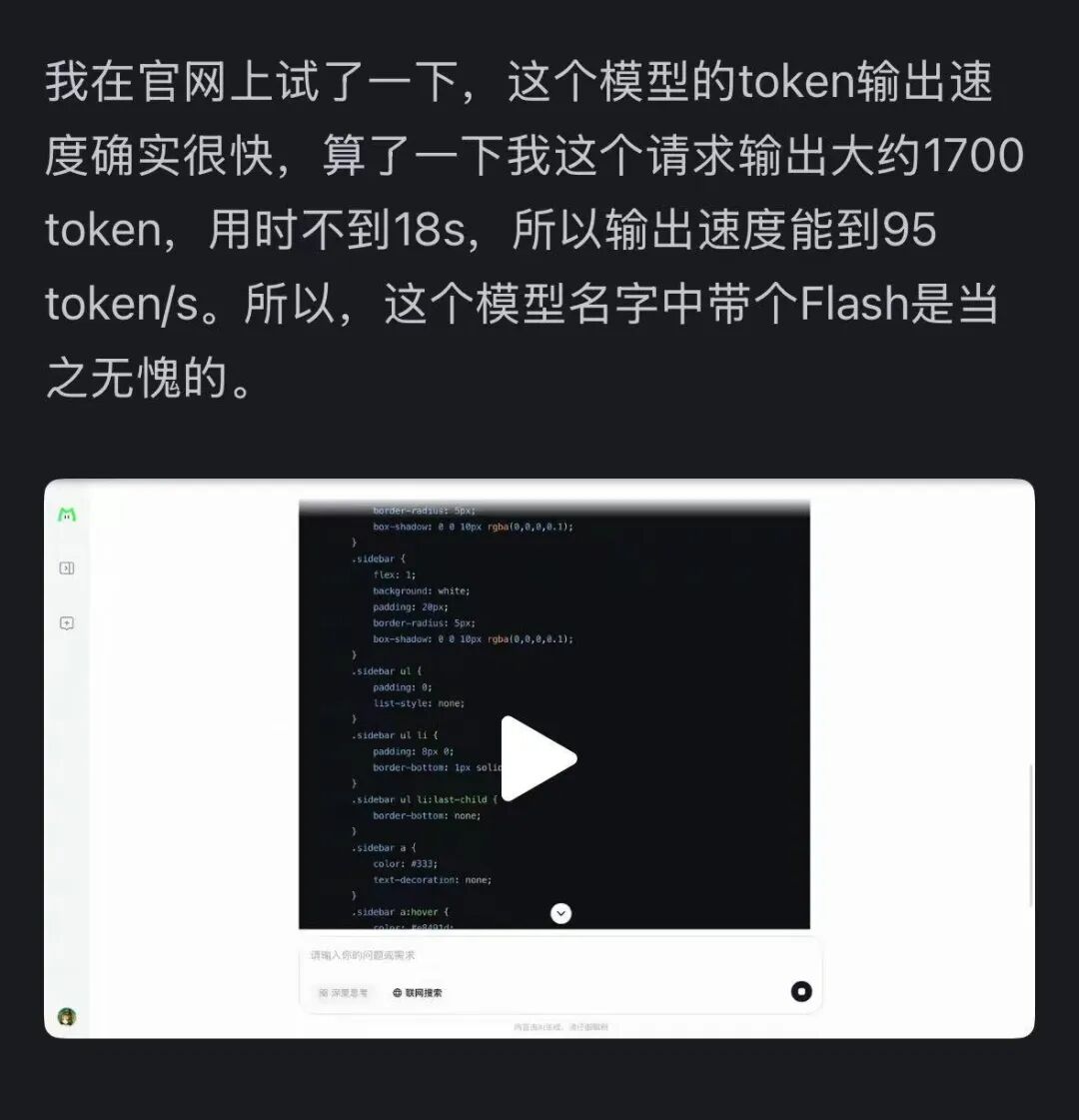

实现了每秒超过100个token的推理速度,理论每token输出时间相比DeepSeek-V3降低近50%。

这个模型来自美团的 LongCat-Flash 系列,官网可以直接使用(https://longcat.ai)。

它天然知道「not all tokens are equal」,因此会根据重要性为重要 token 分配动态计算预算。这让它在仅激活少量参数的前提下,性能就能并肩当下领先的开源模型。

图源:知乎网友 @小小将。

LongCat-Flash目前暂时不支持文件、图像等多模态内容的上传。网页端内,提供了联网搜索功能,但深度思考功能显示为“敬请期待”的状态。

根据美团龙猫团队分享的技术报告,LongCat-Flash采用了创新的MoE架构,引入零计算专家,减少了在低难度token上浪费的计算资源,从而提升推理效率。

与DeepSeek-V3.1、Kimi-K2、Qwen3 MoE-2507等头部开源模型相比,LongCat-Flash在通用领域、编程等场景的能力还有一定差距,但在Agentic工具调用、指令遵循等场景中,LongCat-Flash达到了开源模型SOTA的水准。

-

Hugging Face地址:huggingface.co/meituan-longcat

-

GitHub地址:github.com/meituan-longcat/LongCat-Flash-Chat

-

技术报告链接:github.com/meituan-longcat/LongCat-Flash-Chat/blob/main/tech_report.pdf

-

网页版:longcat.ai/

推荐阅读

欢迎大家加入DLer-大模型技术交流群!

👆 长按识别,邀请您进群!

更多推荐

已为社区贡献2条内容

已为社区贡献2条内容

所有评论(0)