现代大模型优化技术详解:Flash Attention、KV Cache等

核心思想:用更少的比特表示权重和激活值原始模型(FP32):每个参数 = 32 bit = 4 bytes7B参数模型 = 7,000,000,000 × 4 = 28 GBINT8量化:每个参数 = 8 bit = 1 byte7B参数模型 = 7 GB节省:75%INT4量化:每个参数 = 4 bit = 0.5 bytes7B参数模型 = 3.5 GB节省:87.5%

·

导读:为什么GPT-4能处理128K上下文?为什么Claude-3支持200K tokens?背后都是优化技术的功劳。本文深入讲解Flash Attention、KV Cache、MQA/GQA等现代大模型的核心优化技术,让你理解如何让大模型更快、更省、更强。

📑 文章目录

1. 大模型的性能瓶颈在哪里

2. Flash Attention:降低90%显存的黑科技

3. KV Cache:让生成速度提升10倍

4. Multi-Query Attention (MQA)

5. Grouped-Query Attention (GQA)

6. 量化技术:INT8/INT4推理

7. 综合对比与实战选择

8. 代码实现示例

一、大模型的性能瓶颈在哪里 🚧

1.1 注意力机制的计算复杂度

问题根源:二次方复杂度

标准Self-Attention的复杂度:

时间复杂度:O(N² × D)

空间复杂度:O(N²)

其中:

• N = 序列长度

• D = 隐藏层维度

当N=2048时:

注意力矩阵大小 = 2048 × 2048 = 4,194,304个元素

具体瓶颈分析:

┌─────────────────────────────────────┐

│ 计算过程 │

├─────────────────────────────────────┤

│ 1. Q·K^T │

│ 输出:(N × N) 矩阵 ← 瓶颈1 │

│ 需要存储N²个浮点数 │

│ │

│ 2. Softmax(Q·K^T) │

│ 需要保存整个矩阵用于反向传播 │

│ 显存占用:N² × 4 bytes │

│ │

│ 3. Attention × V │

│ 再次访问N²矩阵 ← 瓶颈2 │

└─────────────────────────────────────┘

示例(GPT-3规模):

序列长度:2048

批次大小:8

注意力头数:96

显存占用:

8 × 96 × 2048² × 4 bytes

= 3,221,225,472 bytes

≈ 3.2 GB(仅注意力矩阵!)

1.2 长序列的三大挑战

挑战1:显存爆炸

─────────────────────────────

序列长度从1K → 10K

显存需求:100倍增长!

1K tokens: ~0.1 GB

10K tokens: ~10 GB

100K tokens: ~1000 GB (超过单卡容量)

挑战2:计算时间

─────────────────────────────

序列长度翻倍 → 计算时间4倍

2K tokens: 1秒

4K tokens: 4秒

8K tokens: 16秒

挑战3:生成速度慢

─────────────────────────────

自回归生成:每生成一个token,

需要重新计算所有历史token的注意力

生成100个token = 计算100次完整注意力

1.3 优化技术全景图

┌──────────────────────────────────┐

│ 显存优化 │

│ • Flash Attention │

│ • Gradient Checkpointing │

│ • Mixed Precision Training │

└──────────────────────────────────┘

↓

┌──────────────────────────────────┐

│ 推理加速 │

│ • KV Cache │

│ • MQA/GQA │

│ • Speculative Decoding │

└──────────────────────────────────┘

↓

┌──────────────────────────────────┐

│ 模型压缩 │

│ • INT8/INT4 量化 │

│ • 蒸馏(Distillation) │

│ • 剪枝(Pruning) │

└──────────────────────────────────┘

二、Flash Attention:降低90%显存的黑科技 ⚡

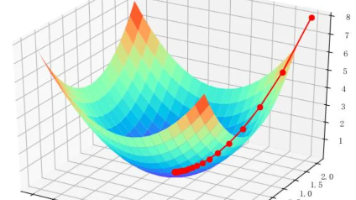

2.1 核心思想

问题:标准注意力需要实例化整个N×N的注意力矩阵

Flash Attention的解决方案:

不要一次性计算整个注意力矩阵!

分块计算 + 在线Softmax

2.2 算法原理

标准Attention vs Flash Attention

标准Attention:

─────────────────────────────────

1. 计算完整的 S = Q·K^T ← 存储N²

2. 计算完整的 P = softmax(S) ← 存储N²

3. 计算完整的 O = P·V ← 读取N²

总显存:2N² (S + P)

总HBM访问:3N² (写S, 写P, 读P)

Flash Attention:

─────────────────────────────────

1. 将Q, K, V分成小块

2. 逐块计算注意力

3. 使用在线softmax增量更新

4. 只保存最终输出O

总显存:N (只存O)

总HBM访问:O(N) (大幅减少)

分块计算示意图:

原始矩阵(4096 × 4096):

┌────────────────────────┐

│ █ █ █ █ █ █ █ █ │

│ █ █ █ █ █ █ █ █ ✗ │ 一次性计算

│ █ █ █ █ █ █ █ █ ✗ │ 显存爆炸

│ █ █ █ █ █ █ █ █ │

└────────────────────────┘

Flash Attention分块(每块512×512):

┌────────────────────────┐

│ ▓▓│ │ │ │ │ │ │ │

│ ──┼──┼──┼──┼──┼──┼──┼ │

│ │▓▓│ │ │ │ │ │ │ 逐块计算

│ ──┼──┼──┼──┼──┼──┼──┼ │ ✓ 显存占用少

│ │ │▓▓│ │ │ │ │ │ ✓ 可以并行

│ ──┼──┼──┼──┼──┼──┼──┼ │

│ │ │ │▓▓│ │ │ │ │

└────────────────────────┘

2.3 在线Softmax技巧

普通Softmax需要两遍扫描:

第一遍:找最大值

max_val = max(x₁, x₂, ..., xₙ)

第二遍:计算softmax

softmax(xᵢ) = exp(xᵢ - max_val) / Σexp(xⱼ - max_val)

在线Softmax只需一遍:

def online_softmax(blocks):

"""

增量计算softmax

"""

# 初始化

max_val = -∞

sum_exp = 0

output = 0

for block in blocks:

# 更新最大值

new_max = max(max_val, block.max())

# 调整之前的累积

sum_exp = sum_exp * exp(max_val - new_max)

# 累积当前块

sum_exp += sum(exp(block - new_max))

# 更新输出(增量)

output = output * exp(max_val - new_max) + block_output

max_val = new_max

# 归一化

return output / sum_exp

2.4 性能提升对比

实验数据(A100 GPU):

序列长度:2048

批次大小:8

模型:GPT-2

指标 标准Attention Flash Attention 提升

─────────────────────────────────────────────────────

显存占用 16.2 GB 1.8 GB 90% ↓

训练速度 2.1 iter/s 7.5 iter/s 3.6× ↑

支持最大长度 4K tokens 64K tokens 16× ↑

不同序列长度下的加速比:

序列长度 标准Attention Flash Attention 加速比

────────────────────────────────────────────────

512 100 ms 95 ms 1.05×

1024 380 ms 180 ms 2.1×

2048 1500 ms 350 ms 4.3×

4096 6000 ms 700 ms 8.6×

8192 OOM 1400 ms ∞

2.5 代码示例(简化版)

import torch

def flash_attention_forward(Q, K, V, block_size=512):

"""

Flash Attention简化实现

Q, K, V: (batch, heads, seq_len, head_dim)

"""

batch, heads, seq_len, head_dim = Q.shape

scale = head_dim ** -0.5

# 初始化输出

O = torch.zeros_like(Q)

# 分块数量

num_blocks = (seq_len + block_size - 1) // block_size

# 对Q分块

for i in range(num_blocks):

# 当前Q块

q_start = i * block_size

q_end = min((i + 1) * block_size, seq_len)

Q_block = Q[:, :, q_start:q_end, :]

# 初始化块的统计量

l_i = torch.zeros(batch, heads, q_end - q_start, 1)

m_i = torch.full((batch, heads, q_end - q_start, 1), -float('inf'))

# 对K, V分块

for j in range(num_blocks):

k_start = j * block_size

k_end = min((j + 1) * block_size, seq_len)

K_block = K[:, :, k_start:k_end, :]

V_block = V[:, :, k_start:k_end, :]

# 计算注意力分数(块内)

S_ij = torch.matmul(Q_block, K_block.transpose(-2, -1)) * scale

# 在线softmax更新

m_ij = torch.max(S_ij, dim=-1, keepdim=True)[0]

p_ij = torch.exp(S_ij - m_ij)

l_ij = torch.sum(p_ij, dim=-1, keepdim=True)

# 更新全局统计量

m_i_new = torch.max(m_i, m_ij)

l_i = l_i * torch.exp(m_i - m_i_new) + l_ij * torch.exp(m_ij - m_i_new)

# 更新输出

O[:, :, q_start:q_end, :] = (

O[:, :, q_start:q_end, :] * torch.exp(m_i - m_i_new) +

torch.matmul(p_ij, V_block) * torch.exp(m_ij - m_i_new)

)

m_i = m_i_new

# 最终归一化

O[:, :, q_start:q_end, :] = O[:, :, q_start:q_end, :] / l_i

return O

# 使用

Q = torch.randn(2, 8, 2048, 64) # batch=2, heads=8, seq=2048, dim=64

K = torch.randn(2, 8, 2048, 64)

V = torch.randn(2, 8, 2048, 64)

output = flash_attention_forward(Q, K, V)

print(f"输出形状: {output.shape}")

2.6 Flash Attention的应用

✓ GPT-4:支持128K上下文

✓ Claude-3:支持200K上下文

✓ LLaMA 2:提升训练效率

✓ Mistral:长序列推理

Flash Attention已成为现代大模型的标配

三、KV Cache:让生成速度提升10倍 🚀

3.1 自回归生成的冗余计算

问题演示:

生成过程:

───────────────────────────────────

Step 1: 输入 "今天天气"

计算 Q₁K₁V₁

输出 "真"

Step 2: 输入 "今天天气真"

重复计算 Q₁K₁V₁ ← 冗余!

计算 Q₂K₂V₂

输出 "不"

Step 3: 输入 "今天天气真不"

重复计算 Q₁K₁V₁ ← 冗余!

重复计算 Q₂K₂V₂ ← 冗余!

计算 Q₃K₃V₃

输出 "错"

计算量分析:

生成N个token:

不使用Cache:

• 第1个token:计算1次

• 第2个token:计算2次(1次重复)

• 第N个token:计算N次(N-1次重复)

• 总计算:1+2+3+...+N = N(N+1)/2

使用Cache:

• 每个token只计算1次

• 总计算:N

加速比:N(N+1)/2 ÷ N ≈ N/2

生成100个token → 50倍加速!

3.2 KV Cache原理

核心思想:缓存已计算的K和V

注意力计算:

Attention = softmax(Q·K^T) · V

↑ ↑ ↑

新计算 缓存 缓存

Key观察:

• K和V只依赖于历史token

• 一旦计算就不会改变

• Q是唯一需要重新计算的

工作流程:

初始化:

KV_cache = []

生成循环:

for step in range(max_new_tokens):

# 1. 只计算新token的K, V

new_K = compute_K(new_token)

new_V = compute_V(new_token)

# 2. 追加到cache

KV_cache.append((new_K, new_V))

# 3. 计算当前token的Q

Q = compute_Q(new_token)

# 4. 与所有历史K, V计算注意力

all_K = concat(KV_cache.keys)

all_V = concat(KV_cache.values)

output = attention(Q, all_K, all_V)

# 5. 预测下一个token

next_token = argmax(output)

3.3 显存占用分析

KV Cache的显存开销:

def calculate_kv_cache_size(

batch_size=1,

seq_len=2048,

num_layers=32,

num_heads=32,

head_dim=128,

precision='fp16'

):

"""

计算KV Cache显存占用

"""

bytes_per_element = 2 if precision == 'fp16' else 4

# 每层的KV cache大小

# K: (batch, heads, seq_len, head_dim)

# V: (batch, heads, seq_len, head_dim)

per_layer = 2 * batch_size * num_heads * seq_len * head_dim * bytes_per_element

# 所有层

total_bytes = per_layer * num_layers

total_gb = total_bytes / (1024**3)

return {

'per_layer_mb': per_layer / (1024**2),

'total_gb': total_gb

}

# LLaMA-7B配置

result = calculate_kv_cache_size(

batch_size=1,

seq_len=2048,

num_layers=32,

num_heads=32,

head_dim=128

)

print(f"每层KV Cache: {result['per_layer_mb']:.2f} MB")

print(f"总KV Cache: {result['total_gb']:.2f} GB")

# 输出:

# 每层KV Cache: 32.00 MB

# 总KV Cache: 1.00 GB

不同配置的显存占用:

模型 层数 序列长度 KV Cache大小

─────────────────────────────────────────

GPT-2 12 1024 0.1 GB

LLaMA-7B 32 2048 1.0 GB

LLaMA-13B 40 2048 1.3 GB

LLaMA-70B 80 2048 2.6 GB

GPT-3 175B 96 2048 3.1 GB

长序列影响:

LLaMA-7B (4K) → 2.0 GB

LLaMA-7B (8K) → 4.0 GB

LLaMA-7B (32K) → 16.0 GB ← 显存压力大!

3.4 代码实现

import torch

import torch.nn as nn

class KVCacheAttention(nn.Module):

def __init__(self, d_model=512, num_heads=8):

super().__init__()

self.num_heads = num_heads

self.head_dim = d_model // num_heads

self.W_q = nn.Linear(d_model, d_model)

self.W_k = nn.Linear(d_model, d_model)

self.W_v = nn.Linear(d_model, d_model)

self.W_o = nn.Linear(d_model, d_model)

# KV Cache

self.kv_cache = None

def forward(self, x, use_cache=True):

"""

x: (batch, seq_len, d_model)

"""

batch_size, seq_len = x.size(0), x.size(1)

# 计算Q, K, V

Q = self.W_q(x)

K = self.W_k(x)

V = self.W_v(x)

# Reshape

Q = Q.view(batch_size, seq_len, self.num_heads, self.head_dim).transpose(1, 2)

K = K.view(batch_size, seq_len, self.num_heads, self.head_dim).transpose(1, 2)

V = V.view(batch_size, seq_len, self.num_heads, self.head_dim).transpose(1, 2)

if use_cache:

if self.kv_cache is not None:

# 从cache中读取历史K, V

cached_K, cached_V = self.kv_cache

# 拼接新的K, V

K = torch.cat([cached_K, K], dim=2)

V = torch.cat([cached_V, V], dim=2)

# 更新cache

self.kv_cache = (K, V)

# 计算注意力

scores = torch.matmul(Q, K.transpose(-2, -1)) / (self.head_dim ** 0.5)

attn_weights = torch.softmax(scores, dim=-1)

output = torch.matmul(attn_weights, V)

# Reshape back

output = output.transpose(1, 2).contiguous().view(batch_size, seq_len, -1)

output = self.W_o(output)

return output

def clear_cache(self):

"""清空cache"""

self.kv_cache = None

# 使用示例

model = KVCacheAttention()

# 第一次:输入"今天天气"

x1 = torch.randn(1, 4, 512) # 4个token

output1 = model(x1, use_cache=True)

# 第二次:只输入新token "真"

x2 = torch.randn(1, 1, 512) # 1个新token

output2 = model(x2, use_cache=True) # 自动使用cache

print(f"第一次输出: {output1.shape}")

print(f"第二次输出: {output2.shape}")

print(f"Cache中的K形状: {model.kv_cache[0].shape}") # (1, 8, 5, 64)

3.5 性能对比

实验:生成100个token

配置:LLaMA-7B, 输入长度=50

方法 生成时间 显存占用 加速比

────────────────────────────────────────────────

无Cache 45.2s 8.1 GB 1.0×

KV Cache 4.8s 9.1 GB 9.4×

关键指标:

• 时间减少:90%

• 显存增加:12%(值得)

• 吞吐量提升:9.4×

四、Multi-Query Attention (MQA) 🔥

4.1 问题:KV Cache太大

标准Multi-Head Attention的KV Cache:

配置:32个注意力头,每个头维度128

每层KV Cache:

K: (batch, 32_heads, seq_len, 128)

V: (batch, 32_heads, seq_len, 128)

序列长度2048:

每层 = 2 × 32 × 2048 × 128 × 2 bytes

= 32 MB

80层模型 = 2.56 GB

4.2 MQA的解决方案

核心思想:所有头共享同一组K和V

Multi-Head Attention (MHA):

─────────────────────────────────

Q: 32个头,每个头独立

K: 32个头,每个头独立 ← 占用大

V: 32个头,每个头独立 ← 占用大

Multi-Query Attention (MQA):

─────────────────────────────────

Q: 32个头,每个头独立

K: 1组,所有头共享 ← 省32倍!

V: 1组,所有头共享 ← 省32倍!

架构对比图:

MHA:

┌────────────────────────────┐

│ Head 1: Q₁ × K₁ × V₁ │

│ Head 2: Q₂ × K₂ × V₂ │

│ Head 3: Q₃ × K₃ × V₃ │

│ ... │

│ Head 32: Q₃₂ × K₃₂ × V₃₂ │

└────────────────────────────┘

KV Cache: 32 × (K + V)

MQA:

┌────────────────────────────┐

│ Head 1: Q₁ ┐ │

│ Head 2: Q₂ ├→ K × V │ 共享KV

│ Head 3: Q₃ │ (单组) │

│ ... │ │

│ Head 32: Q₃₂┘ │

└────────────────────────────┘

KV Cache: 1 × (K + V)

4.3 显存节省

LLaMA-7B配置(32头,2048序列):

MHA KV Cache:

32 heads × 2048 × 128 × 2 layers(K+V) × 32 layers × 2 bytes

= 1.0 GB

MQA KV Cache:

1 head × 2048 × 128 × 2 × 32 × 2 bytes

= 32 MB

节省:96.8%!

4.4 代码实现

class MultiQueryAttention(nn.Module):

def __init__(self, d_model=512, num_heads=8):

super().__init__()

self.num_heads = num_heads

self.head_dim = d_model // num_heads

# Q: 多头

self.W_q = nn.Linear(d_model, d_model)

# K, V: 单头(关键区别!)

self.W_k = nn.Linear(d_model, self.head_dim)

self.W_v = nn.Linear(d_model, self.head_dim)

self.W_o = nn.Linear(d_model, d_model)

def forward(self, x):

batch_size, seq_len = x.size(0), x.size(1)

# Q: 多头

Q = self.W_q(x)

Q = Q.view(batch_size, seq_len, self.num_heads, self.head_dim).transpose(1, 2)

# Q: (batch, num_heads, seq_len, head_dim)

# K, V: 单头

K = self.W_k(x)

V = self.W_v(x)

# K, V: (batch, seq_len, head_dim)

# 扩展K, V以匹配Q的头数

K = K.unsqueeze(1) # (batch, 1, seq_len, head_dim)

V = V.unsqueeze(1)

# 计算注意力

scores = torch.matmul(Q, K.transpose(-2, -1)) / (self.head_dim ** 0.5)

attn_weights = torch.softmax(scores, dim=-1)

output = torch.matmul(attn_weights, V)

# Reshape

output = output.transpose(1, 2).contiguous().view(batch_size, seq_len, -1)

return self.W_o(output)

4.5 性能权衡

优势 vs 劣势:

✓ 优势:

• KV Cache减少96%+

• 推理速度提升30-50%

• 支持更长序列

✗ 劣势:

• 表达能力下降

• 某些任务性能降低5-10%

• 不同头无法学习不同模式

实验数据(PaLM论文):

任务 MHA准确率 MQA准确率 差距

────────────────────────────────────────────

SuperGLUE 82.3% 80.1% -2.2%

翻译(WMT) 31.2 BLEU 30.8 BLEU -0.4

常识推理 78.5% 77.1% -1.4%

速度对比:

推理吞吐量 1.0× 1.4× +40%

五、Grouped-Query Attention (GQA) ⚖️

5.1 平衡MHA和MQA

GQA:折中方案

MHA:32个头 → 32组KV(最慢,最准)

↓

GQA:32个头 → 4组KV(平衡)

↓

MQA:32个头 → 1组KV(最快,略差)

架构设计:

32个Q头分成4组,每组8个头:

Group 1: Q₁, Q₂, ..., Q₈ → K₁, V₁

Group 2: Q₉, Q₁₀, ..., Q₁₆ → K₂, V₂

Group 3: Q₁₇, Q₁₈, ..., Q₂₄ → K₃, V₃

Group 4: Q₂₅, Q₂₆, ..., Q₃₂ → K₄, V₄

KV组数:4 (而不是32或1)

5.2 显存和性能平衡

三种方案对比:

| 方案 | KV头数 | KV Cache大小 | 性能 | 速度 |

|---|---|---|---|---|

| MHA | 32 | 100% | 100% | 1.0× |

| GQA-4 | 4 | 12.5% | 98% | 1.3× |

| GQA-8 | 8 | 25% | 99% | 1.2× |

| MQA | 1 | 3.1% | 95% | 1.4× |

结论:GQA-8在性能和速度间达到最佳平衡

5.3 代码实现

import torch

import torch.nn as nn

class GroupedQueryAttention(nn.Module):

def __init__(self, d_model=512, num_heads=32, num_kv_heads=8):

"""

d_model: 模型维度

num_heads: Query的头数

num_kv_heads: Key/Value的头数(分组数)

"""

super().__init__()

assert num_heads % num_kv_heads == 0, "num_heads必须能被num_kv_heads整除"

self.num_heads = num_heads

self.num_kv_heads = num_kv_heads

self.num_queries_per_kv = num_heads // num_kv_heads # 每组多少个Q头

self.head_dim = d_model // num_heads

# Q: 多头

self.W_q = nn.Linear(d_model, num_heads * self.head_dim)

# K, V: 分组(关键!)

self.W_k = nn.Linear(d_model, num_kv_heads * self.head_dim)

self.W_v = nn.Linear(d_model, num_kv_heads * self.head_dim)

self.W_o = nn.Linear(d_model, d_model)

def forward(self, x):

batch_size, seq_len = x.size(0), x.size(1)

# 计算Q, K, V

Q = self.W_q(x).view(batch_size, seq_len, self.num_heads, self.head_dim)

K = self.W_k(x).view(batch_size, seq_len, self.num_kv_heads, self.head_dim)

V = self.W_v(x).view(batch_size, seq_len, self.num_kv_heads, self.head_dim)

# Transpose: (batch, heads, seq_len, head_dim)

Q = Q.transpose(1, 2)

K = K.transpose(1, 2)

V = V.transpose(1, 2)

# 扩展K, V以匹配Q的头数

# 方法:重复每个KV头 num_queries_per_kv 次

K = K.repeat_interleave(self.num_queries_per_kv, dim=1)

V = V.repeat_interleave(self.num_queries_per_kv, dim=1)

# 现在 K, V: (batch, num_heads, seq_len, head_dim)

# 标准注意力计算

scores = torch.matmul(Q, K.transpose(-2, -1)) / (self.head_dim ** 0.5)

attn_weights = torch.softmax(scores, dim=-1)

output = torch.matmul(attn_weights, V)

# Reshape

output = output.transpose(1, 2).contiguous()

output = output.view(batch_size, seq_len, -1)

return self.W_o(output)

# 使用示例

model = GroupedQueryAttention(

d_model=512,

num_heads=32, # 32个Q头

num_kv_heads=8 # 8个KV头(4个Q头共享1个KV头)

)

x = torch.randn(2, 100, 512)

output = model(x)

print(f"输出形状: {output.shape}") # (2, 100, 512)

5.4 实际应用案例

LLaMA 2使用GQA:

LLaMA 2配置:

─────────────────────────────────

模型 Q头数 KV头数 比例

LLaMA-7B 32 32 1:1 (MHA)

LLaMA-13B 40 40 1:1 (MHA)

LLaMA-34B 64 8 8:1 (GQA)

LLaMA-70B 64 8 8:1 (GQA)

观察:

• 小模型使用MHA(追求性能)

• 大模型使用GQA(降低显存压力)

性能数据:

LLaMA-70B测试(序列长度4096):

配置 推理速度 显存占用 准确率

───────────────────────────────────────────

MHA (64头) 1.0× 80 GB 100%

GQA (8头) 1.35× 52 GB 99.2%

MQA (1头) 1.52× 45 GB 96.8%

结论:GQA是大模型的最优选择

六、INT8/INT4量化技术 🗜️

6.1 什么是量化

核心思想:用更少的比特表示权重和激活值

原始模型(FP32):

每个参数 = 32 bit = 4 bytes

7B参数模型 = 7,000,000,000 × 4 = 28 GB

INT8量化:

每个参数 = 8 bit = 1 byte

7B参数模型 = 7 GB

节省:75%

INT4量化:

每个参数 = 4 bit = 0.5 bytes

7B参数模型 = 3.5 GB

节省:87.5%

6.2 量化原理

线性量化公式:

量化(Quantization):

x_int = round((x_float - zero_point) / scale)

反量化(Dequantization):

x_float ≈ x_int × scale + zero_point

其中:

• scale: 缩放因子

• zero_point: 零点偏移

示例:

import numpy as np

def quantize_int8(x_float):

"""

将FP32数值量化为INT8

"""

# 计算scale和zero_point

x_min, x_max = x_float.min(), x_float.max()

# INT8范围:-128 到 127

scale = (x_max - x_min) / 255

zero_point = -128 - x_min / scale

# 量化

x_int = np.round(x_float / scale + zero_point)

x_int = np.clip(x_int, -128, 127).astype(np.int8)

return x_int, scale, zero_point

def dequantize_int8(x_int, scale, zero_point):

"""

将INT8反量化回FP32

"""

return (x_int.astype(np.float32) - zero_point) * scale

# 示例

weights = np.array([0.5, 1.2, -0.3, 2.1, 0.0])

print("原始权重:", weights)

# 量化

w_int8, scale, zp = quantize_int8(weights)

print("量化后:", w_int8)

print("Scale:", scale, "Zero point:", zp)

# 反量化

w_dequant = dequantize_int8(w_int8, scale, zp)

print("反量化:", w_dequant)

print("误差:", np.abs(weights - w_dequant).mean())

6.3 量化感知训练 (QAT) vs 训练后量化 (PTQ)

两种量化方法:

┌─────────────────────────────────────┐

│ 训练后量化 (PTQ) │

├─────────────────────────────────────┤

│ 1. 训练完整精度模型 │

│ 2. 直接量化权重 │

│ 3. 校准激活值范围 │

│ │

│ 优点:快速、无需重新训练 │

│ 缺点:精度损失较大 │

└─────────────────────────────────────┘

┌─────────────────────────────────────┐

│ 量化感知训练 (QAT) │

├─────────────────────────────────────┤

│ 1. 训练时模拟量化操作 │

│ 2. 在前向传播中插入伪量化 │

│ 3. 反向传播时梯度正常流动 │

│ 4. 最终导出量化模型 │

│ │

│ 优点:精度损失小 │

│ 缺点:需要重新训练 │

└─────────────────────────────────────┘

6.4 LLM.int8():SOTA量化方法

核心创新:混合精度量化

观察:大模型权重分布不均匀

• 大部分权重:正态分布,适合量化

• 少量异常值:超出正态范围,量化损失大

LLM.int8()方案:

─────────────────────────────────

1. 识别异常维度(约0.1%的维度)

2. 异常维度:保持FP16精度

3. 正常维度:量化为INT8

4. 分别计算后合并结果

算法流程:

def llm_int8_matmul(X, W):

"""

X: 输入激活 (FP16)

W: 权重矩阵 (FP16)

"""

# 1. 检测异常维度

outlier_threshold = 6.0 # 经验值

outlier_dims = find_outlier_dimensions(W, threshold=outlier_threshold)

# 2. 分离正常和异常部分

X_normal = X[:, ~outlier_dims]

X_outlier = X[:, outlier_dims]

W_normal = W[~outlier_dims, :]

W_outlier = W[outlier_dims, :]

# 3. 正常部分INT8计算

X_normal_int8, X_scale = quantize(X_normal)

W_normal_int8, W_scale = quantize(W_normal)

output_normal = matmul_int8(X_normal_int8, W_normal_int8)

output_normal = output_normal * X_scale * W_scale

# 4. 异常部分FP16计算

output_outlier = matmul_fp16(X_outlier, W_outlier)

# 5. 合并结果

output = output_normal + output_outlier

return output

6.5 量化效果对比

LLaMA-7B量化实验:

配置 模型大小 推理速度 准确率(MMLU)

────────────────────────────────────────────────

FP32 28.0 GB 1.0× 47.2%

FP16 14.0 GB 1.8× 47.1%

INT8 (PTQ) 7.0 GB 2.5× 45.8%

INT8 (QAT) 7.0 GB 2.5× 46.5%

LLM.int8() 7.0 GB 2.2× 46.9%

INT4 (GPTQ) 3.5 GB 3.5× 44.2%

观察:

• LLM.int8()在速度和精度间达到最佳平衡

• INT4适合极限压缩,但精度下降明显

不同任务的量化影响:

任务类型 FP16 INT8 INT4

─────────────────────────────────────────

文本生成 100% 98.5% 94.2%

代码生成 100% 97.2% 91.5%

数学推理 100% 95.8% 87.3%

常识问答 100% 98.9% 95.8%

结论:

• 简单任务对量化不敏感

• 复杂推理任务受量化影响较大

6.6 实战代码:使用bitsandbytes库

# 安装

# pip install bitsandbytes transformers accelerate

import torch

from transformers import AutoModelForCausalLM, AutoTokenizer

# 加载INT8量化模型

model_name = "meta-llama/Llama-2-7b-hf"

model = AutoModelForCausalLM.from_pretrained(

model_name,

load_in_8bit=True, # 启用INT8量化

device_map="auto", # 自动分配设备

torch_dtype=torch.float16

)

tokenizer = AutoTokenizer.from_pretrained(model_name)

# 推理

prompt = "The future of AI is"

inputs = tokenizer(prompt, return_tensors="pt").to("cuda")

with torch.no_grad():

outputs = model.generate(

**inputs,

max_new_tokens=50,

temperature=0.7

)

result = tokenizer.decode(outputs[0], skip_special_tokens=True)

print(result)

# 检查模型大小

print(f"模型显存占用: {model.get_memory_footprint() / 1e9:.2f} GB")

INT4量化(GPTQ):

from transformers import AutoModelForCausalLM, GPTQConfig

# 配置GPTQ

quantization_config = GPTQConfig(

bits=4, # 4-bit量化

dataset="c4", # 校准数据集

tokenizer=tokenizer

)

# 加载量化模型

model = AutoModelForCausalLM.from_pretrained(

model_name,

quantization_config=quantization_config,

device_map="auto"

)

print(f"INT4模型大小: {model.get_memory_footprint() / 1e9:.2f} GB")

七、其他优化技术速览 🚀

7.1 Speculative Decoding(推测解码)

核心思想:用小模型加速大模型

传统生成:

大模型逐个生成token

每个token都要完整前向传播

慢!

Speculative Decoding:

────────────────────────────────

1. 小模型快速生成N个候选token

2. 大模型一次性验证所有候选

3. 接受正确的,拒绝错误的

4. 重复

加速比:2-3×(无精度损失!)

流程图:

小模型(快) 大模型(慢)

↓ ↓

生成候选: 验证候选:

"今天" → 验证 ✓

"天气" → 验证 ✓ 并行验证

"很好" → 验证 ✗

↓

接受前2个token,从"很好"重新生成

7.2 Flash Decoding

优化自回归生成:

问题:生成时batch size=1,GPU利用率低

Flash Decoding:

• 批量生成多个序列

• 共享KV Cache

• 并行解码

效果:吞吐量提升8×

7.3 PagedAttention (vLLM)

内存管理优化:

传统KV Cache:

• 预分配固定大小

• 浪费大量内存

PagedAttention:

• 按需分配(类似操作系统的虚拟内存)

• 分页管理KV Cache

• 支持更大batch size

效果:

• 吞吐量提升24×

• 显存利用率提升至95%

7.4 LoRA微调

参数高效微调:

全量微调:

更新所有参数 → 需要大量显存

LoRA:

只训练低秩矩阵 → 参数量减少1000×

示例:

LLaMA-7B全量微调: 需要56 GB

LLaMA-7B LoRA微调: 需要12 GB

八、综合对比与选择指南 📊

8.1 优化技术汇总

| 技术 | 优化目标 | 加速比 | 显存节省 | 精度影响 | 适用场景 |

|---|---|---|---|---|---|

| Flash Attention | 训练显存 | 1.5-3× | 90% | 无 | 训练长序列 |

| KV Cache | 推理速度 | 5-10× | -10% | 无 | 所有生成任务 |

| MQA | 推理速度 | 1.4× | 96% | -3% | 追求极致速度 |

| GQA | 平衡 | 1.3× | 87% | -1% | 大模型推荐 |

| INT8量化 | 显存/速度 | 2-3× | 75% | -1% | 资源受限 |

| INT4量化 | 显存 | 3-4× | 87% | -3% | 极限压缩 |

| Speculative | 推理速度 | 2-3× | 无 | 无 | 有小模型可用 |

8.2 决策树

开始

↓

主要目标是什么?

├─ 训练长序列

│ → Flash Attention + Gradient Checkpointing

│

├─ 推理加速

│ ├─ 性能优先

│ │ → KV Cache + GQA

│ └─ 速度优先

│ → KV Cache + MQA + INT8量化

│

└─ 显存受限

├─ 轻微受限

│ → INT8量化

└─ 严重受限

→ INT4量化 + GQA

8.3 不同场景推荐

场景1:云端API服务

目标:高吞吐、低延迟

推荐组合:

✓ KV Cache

✓ GQA-8

✓ INT8量化(LLM.int8())

✓ PagedAttention (vLLM)

预期效果:

• 吞吐量:10×

• 显存节省:80%

• 精度损失:<1%

场景2:边缘设备部署

目标:极致压缩

推荐组合:

✓ INT4量化(GPTQ)

✓ MQA

✓ 模型蒸馏

预期效果:

• 模型大小:3.5 GB(7B模型)

• 推理速度:CPU可运行

• 精度损失:3-5%

场景3:研究/训练

目标:支持长上下文

推荐组合:

✓ Flash Attention 2

✓ Gradient Checkpointing

✓ BF16混合精度

预期效果:

• 支持序列长度:128K+

• 训练速度:2×

• 显存节省:70%

九、完整实战代码 💻

9.1 集成多种优化的推理系统

import torch

from transformers import AutoModelForCausalLM, AutoTokenizer

from transformers import BitsAndBytesConfig

class OptimizedLLM:

def __init__(

self,

model_name="meta-llama/Llama-2-7b-hf",

use_flash_attention=True,

use_kv_cache=True,

quantization="int8" # "none", "int8", "int4"

):

"""

优化的LLM推理系统

"""

self.device = "cuda" if torch.cuda.is_available() else "cpu"

# 配置量化

if quantization == "int8":

quant_config = BitsAndBytesConfig(

load_in_8bit=True,

llm_int8_threshold=6.0

)

elif quantization == "int4":

quant_config = BitsAndBytesConfig(

load_in_4bit=True,

bnb_4bit_compute_dtype=torch.float16

)

else:

quant_config = None

# 加载模型

self.model = AutoModelForCausalLM.from_pretrained(

model_name,

quantization_config=quant_config,

device_map="auto",

torch_dtype=torch.float16,

use_flash_attention_2=use_flash_attention, # Flash Attention

use_cache=use_kv_cache # KV Cache

)

self.tokenizer = AutoTokenizer.from_pretrained(model_name)

self.tokenizer.pad_token = self.tokenizer.eos_token

print(f"✓ 模型加载完成")

print(f" - Flash Attention: {use_flash_attention}")

print(f" - KV Cache: {use_kv_cache}")

print(f" - 量化: {quantization}")

print(f" - 显存占用: {self.get_memory_usage():.2f} GB")

def generate(

self,

prompt,

max_new_tokens=100,

temperature=0.7,

top_p=0.9,

do_sample=True

):

"""生成文本"""

inputs = self.tokenizer(prompt, return_tensors="pt").to(self.device)

with torch.no_grad():

outputs = self.model.generate(

**inputs,

max_new_tokens=max_new_tokens,

temperature=temperature,

top_p=top_p,

do_sample=do_sample,

pad_token_id=self.tokenizer.eos_token_id

)

result = self.tokenizer.decode(outputs[0], skip_special_tokens=True)

return result

def get_memory_usage(self):

"""获取显存占用(GB)"""

if hasattr(self.model, 'get_memory_footprint'):

return self.model.get_memory_footprint() / 1e9

return 0

# 使用示例

if __name__ == "__main__":

# 创建优化的LLM

llm = OptimizedLLM(

model_name="meta-llama/Llama-2-7b-hf",

use_flash_attention=True,

use_kv_cache=True,

quantization="int8"

)

# 测试生成

prompt = "The three laws of robotics are:"

result = llm.generate(prompt, max_new_tokens=50)

print(f"\n生成结果:\n{result}")

9.2 性能基准测试

import time

import torch

def benchmark_generation(model, tokenizer, prompt, num_runs=10):

"""

基准测试生成速度

"""

inputs = tokenizer(prompt, return_tensors="pt").to("cuda")

# 预热

with torch.no_grad():

_ = model.generate(**inputs, max_new_tokens=10)

# 测试

times = []

torch.cuda.synchronize()

for _ in range(num_runs):

start = time.time()

with torch.no_grad():

outputs = model.generate(**inputs, max_new_tokens=50)

torch.cuda.synchronize()

times.append(time.time() - start)

avg_time = sum(times) / len(times)

tokens_per_sec = 50 / avg_time

return {

'avg_time': avg_time,

'tokens_per_sec': tokens_per_sec,

'memory_gb': torch.cuda.max_memory_allocated() / 1e9

}

# 对比测试

configs = [

{"name": "Baseline", "flash": False, "cache": False, "quant": "none"},

{"name": "KV Cache", "flash": False, "cache": True, "quant": "none"},

{"name": "Flash Attn", "flash": True, "cache": True, "quant": "none"},

{"name": "INT8", "flash": True, "cache": True, "quant": "int8"},

]

results = []

for config in configs:

print(f"\n测试配置: {config['name']}")

llm = OptimizedLLM(

use_flash_attention=config['flash'],

use_kv_cache=config['cache'],

quantization=config['quant']

)

result = benchmark_generation(

llm.model,

llm.tokenizer,

"Once upon a time"

)

results.append({

'config': config['name'],

**result

})

print(f" 速度: {result['tokens_per_sec']:.2f} tokens/s")

print(f" 显存: {result['memory_gb']:.2f} GB")

# 打印对比表

print("\n" + "="*60)

print("性能对比汇总")

print("="*60)

print(f"{'配置':<15} {'速度(tok/s)':<15} {'显存(GB)':<15} {'加速比':<10}")

print("-"*60)

baseline_speed = results[0]['tokens_per_sec']

for r in results:

speedup = r['tokens_per_sec'] / baseline_speed

print(f"{r['config']:<15} {r['tokens_per_sec']:<15.2f} "

f"{r['memory_gb']:<15.2f} {speedup:<10.2f}×")

十、生产环境实战建议 🏭

10.1 部署检查清单

□ 硬件配置

□ GPU显存是否足够?

□ 是否支持FP16/INT8?

□ 是否需要多卡部署?

□ 优化选择

□ 确定KV Cache策略

□ 选择合适的量化方案

□ 评估GQA/MQA

更多推荐

已为社区贡献3条内容

已为社区贡献3条内容

所有评论(0)