手把手教你用MCP封装火山“即梦”API,搭建一个“即插即用”的AI绘画服务

而用MCP这样的技术,把火山引擎这样强大的AI能力“拽”过来,为自己量身定做一个“清道夫”,这种感觉是无可替代的。以后我想给我的AI增加一个新能力,比如读取Gmail邮件,我需要做的,只是把Gmail包装成一个新的“USB-C插头”插到集线器上。现在,我写完文章,只需要来这里,输入标题,就能生成一张风格统一、带Logo的封面图。,都能在这儿一键操作。之前我也折腾过,用AI搓了个简单的HTML生成器

我们团队一直在坚持做公众号干货内容输出,说实话,这活儿挺耗心力的。每一篇文章,从选题、研究到最终成稿,都得花不少功夫。但在整个流程里,有个事儿,虽然不大,却总让我感觉不顺畅,像鞋里进了颗小石子,走起路来总觉得硌得慌。

这个“小石子”,就是文章的封面图。

之前我也折腾过,用AI搓了个简单的HTML生成器,直接简单DeepSeek的API就可以生成公众号封面,但那玩意儿太单调了,一股子机器味儿,用两次就腻了。

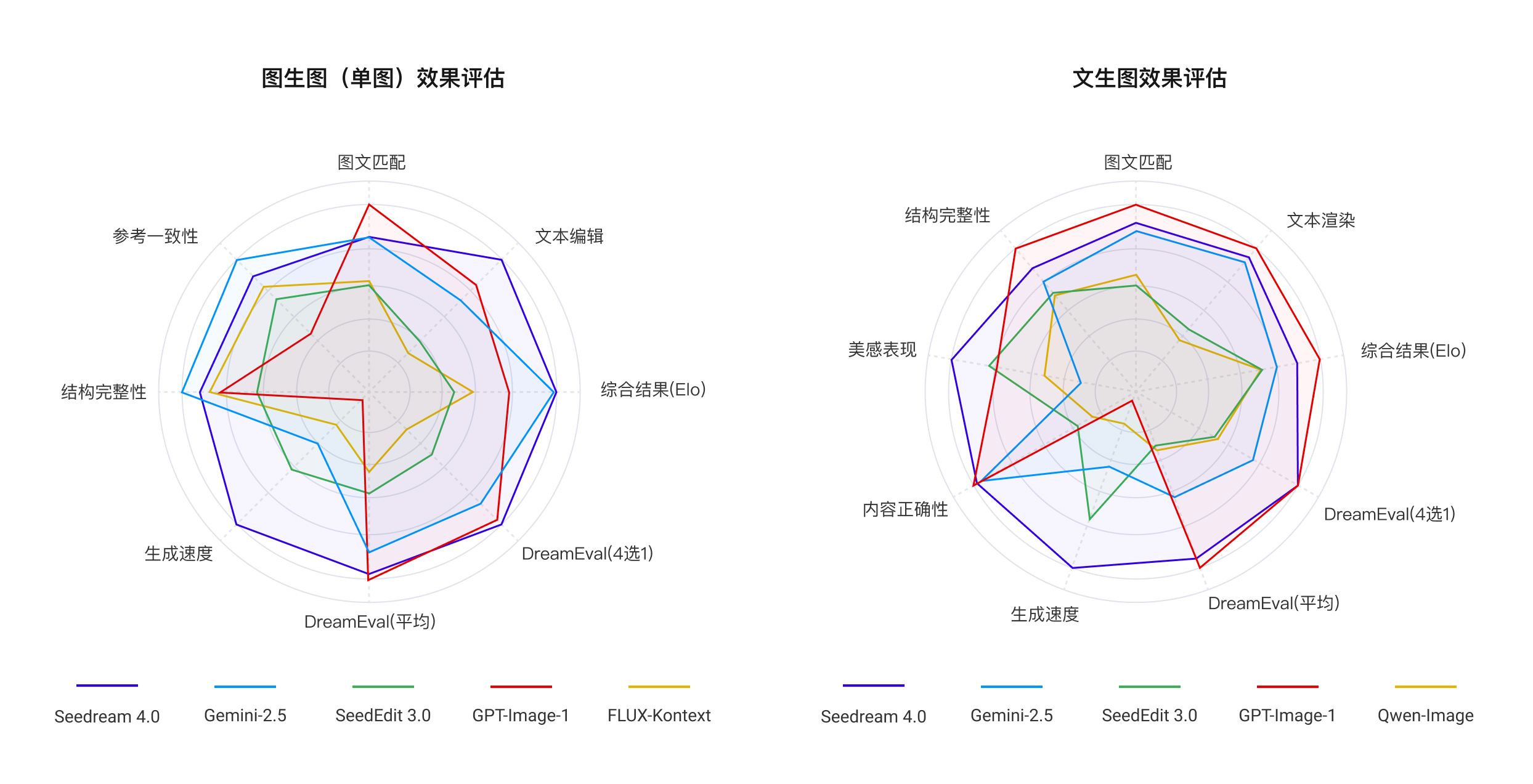

这事儿就这么一直悬着。直到上个月,我记得很清楚,圈子里先是铺天盖地地宣传即梦(Seedream)上线了4.0版本,生图能力确实不错,各种案例看得我心痒痒。

结果第二天,火山引擎紧跟着就官宣了火山方舟(Volcano Ark)平台正式上线,把这个能力变成了开发者可以随时调用的API。

这一下就戳到我了。一个顶级的图像模型,加上一个为开发者准备的API平台,这两件事凑在一起,不就是冲着我心里那个“封面图自动化”的疙瘩来的吗?

但你知道,开发者就是这样,脑子里惦记着一百个“待办”,手头永远有忙不完的“优先”。这事儿就一直在我的任务列表里吃灰。正好赶上国庆假期,我决定啥也不想,就把鞋里这颗硌脚的石子给彻底清出去。

这次我不只想解决问题,我想用一种更“开发者”的方式,优雅地解决它。 于是,我想到了MCP。

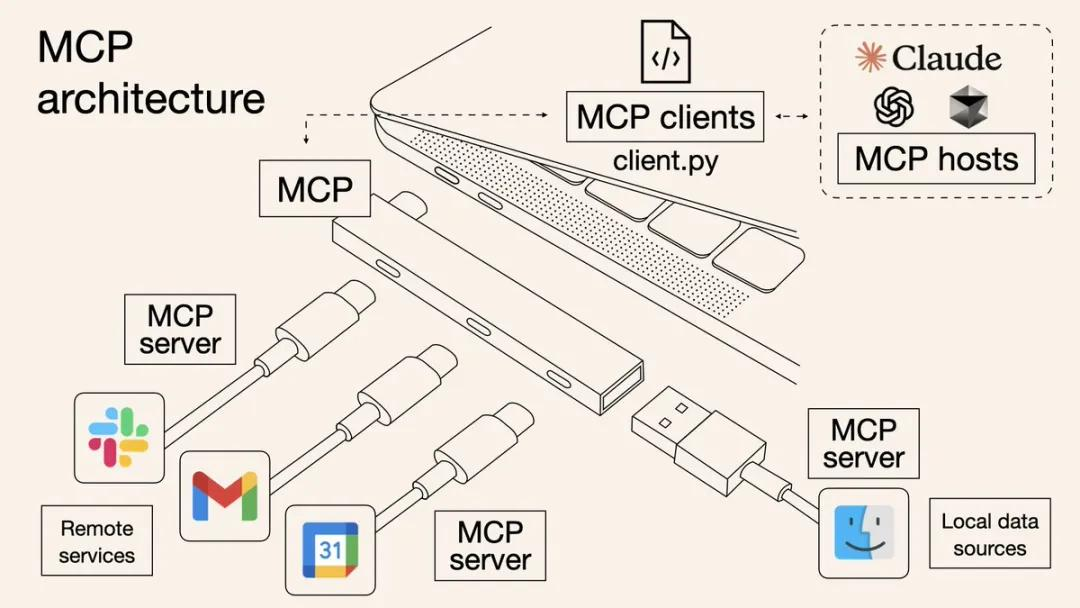

01|到底什么是MCP?一张图,比我说一万句都管用

在动手之前,我得先跟你盘盘MCP这东西。因为搞懂了它的“魂”,你才能理解为啥我非要用它。

网上有很多解释,说它是个“开源标准”、“交互协议”,听着都对,但都像隔着层纱。在我这个一线开发者看来,那些都不重要,重要的是它解决了什么“痛点”。

✅ 痛点:为每个新工具都重写一套连接代码,太蠢了

我们做AI应用开发,最烦的是什么?就是不停地为AI接入新的工具。今天想让AI会发飞书消息,我就得写一套专门的代码去对接飞书的接口;明天想让它能查数据库,我又得再写一套完全不同的代码连到数据库上;后天想让它画图,又得去对接生图模型的API。

我们大部分时间,都耗在干这种重复的“连接”工作上了。 为飞书写一套,为数据库写一套,为生图模型再写一套。每个工具的接口、认证、数据格式全都不一样,每次都得从头研究、从头开始写。这活儿毫无创造性,简直是在浪费生命。

✅ MCP的解法:一张图看懂“万能插座”

很多人把MCP比作“万能插座”,下面这张图,是我见过对这个比喻诠释得最到位的一张图,比我废话一万句都管用。

这张图的核心,就是“解耦”,把事情分成三块来看:

-

左下角 - 工具端(各种插头): 你看,无论是Slack、Gmail这些远程服务,还是你电脑本地的文件(那个Finder图标),每一个都被一个

MCP server给包装起来了。这个MCP server干的活儿,就是把这些原来接口各异的工具,全都统一改造成了标准的“USB-C插头”。 -

中间 - 连接端(集线器/插座): 这些被改造好的标准“USB-C插头”,现在都可以插到中间那个“集线器”上了。这个集线器,就代表了MCP的运行环境。它不关心你插上来的是啥,只要你符合标准,我就认你。

-

右上角 - AI应用端(用电设备): 你的AI大模型(比如Claude)或者你自己写的Python脚本,就像一台笔记本电脑。它现在需要调用各种工具,但它再也不用去认识一大堆乱七八糟的接口了。它只需要一个标准的“USB-C”口,往集线器上一插,就能使用集线器上连接的所有工具和服务了。

看明白了吧?

AI应用和外部工具被彻底分开了。 以后我想给我的AI增加一个新能力,比如读取Gmail邮件,我需要做的,只是把Gmail包装成一个新的“USB-C插头”插到集线器上。我的AI应用那边,一行代码都不用改,就能立刻拥有这个新能力。

这就是架构的威力。它让我从一个到处写连接代码的“码农”,变成了一个设计“即插即用”系统的架构师。

这,就是我选择MCP的根本原因。

02|光说不练假把式,把这个最简单的“插头”搓出来

道理盘明白了,但好不好用,还得手上见真章。官方给的入门案例只有一个加法,我觉得不够过瘾,咱们把它改造一下,多加个减法,让AI能同时学会使用工具进行加减法运算。咱们就严格按照步骤,把这个改造后的例子跑通一遍,让你彻底体会到给AI批量增加工具有多直接,以及中间会遇到哪些“坑”。

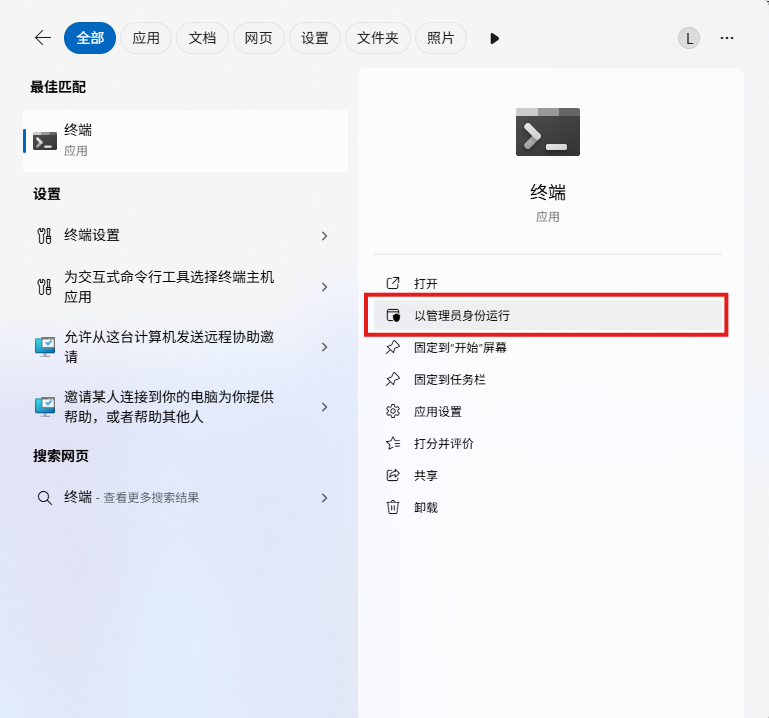

✅ 第一步:搭好工作台

工欲善其事,必先利其器。现在搞Python开发,我首推uv,这玩意儿是真快。

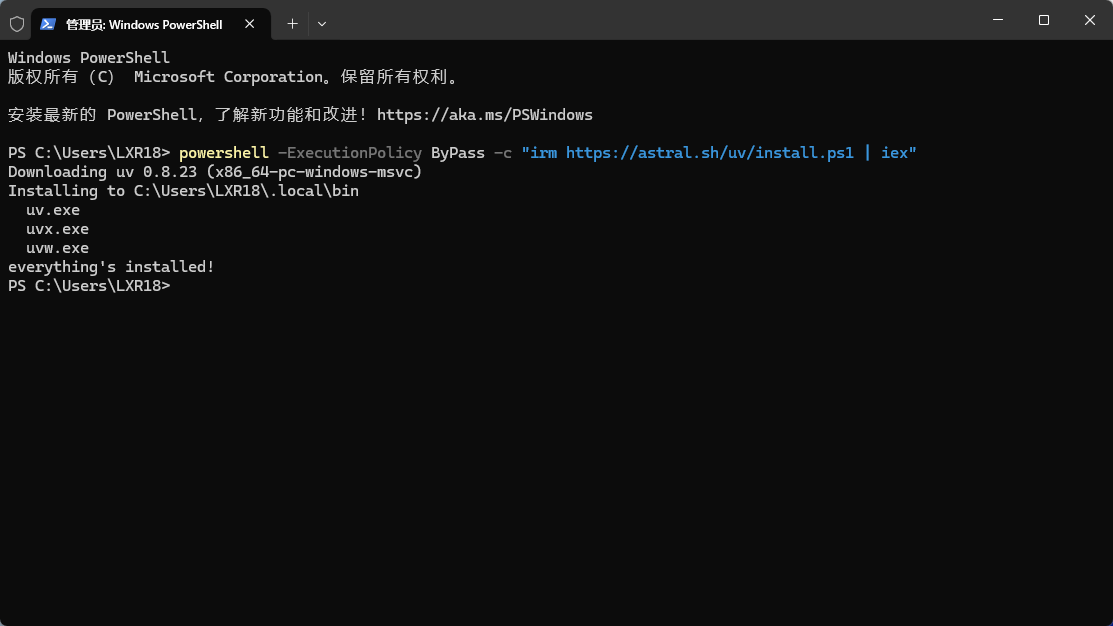

1、安装 uv

-

打开PowerShell(最好用管理员身份),运行下面这行命令。

powershell -ExecutionPolicy ByPass -c "irm https://astral.sh/uv/install.ps1 | iex"

-

看到

Downloading就说明开始了。当然,装完十有八九会遇到经典问题:系统不认uv这个命令。别慌,老把戏了,就是没把它的路径加到系统的环境变量(Path)里去。手动给它加上,这事儿就算翻篇了。

2、Windows用户按着下面这几步操作就行

-

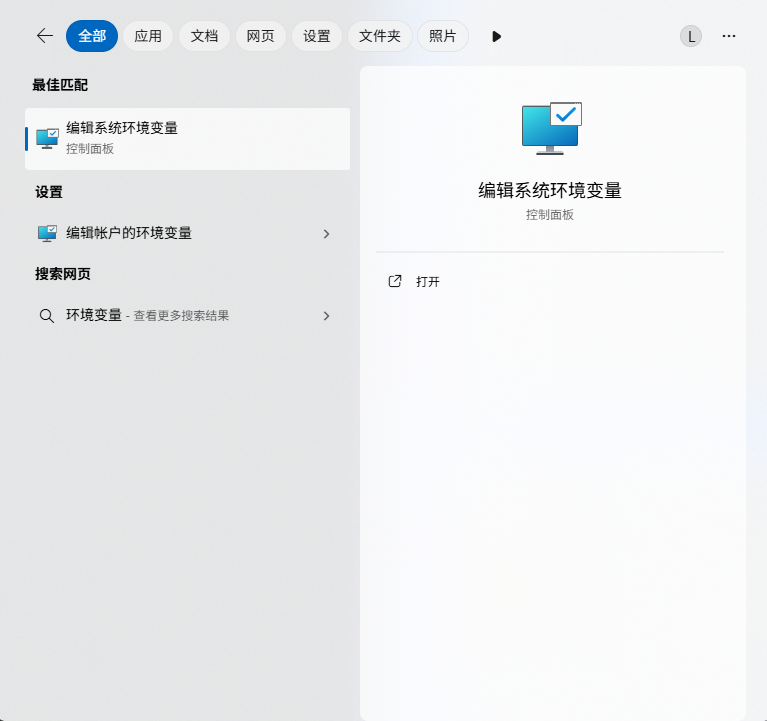

在系统搜索栏搜“环境变量”

-

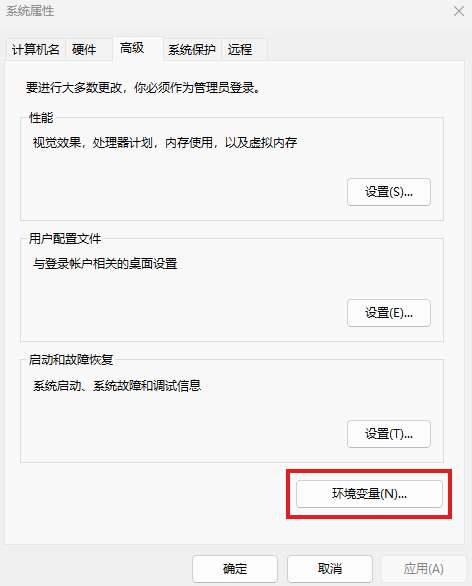

打开“编辑系统环境变量”。在弹出的窗口里点“环境变量”按钮

-

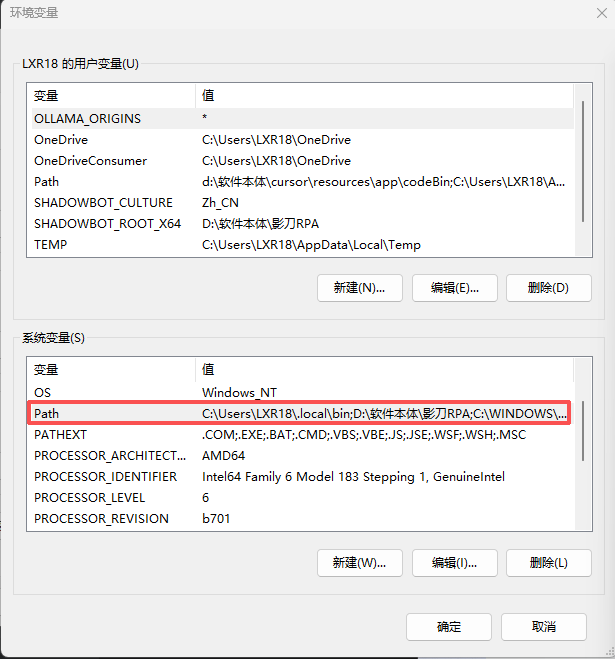

在“系统变量”那个框里找到“Path”,选中它,点“编辑”。

-

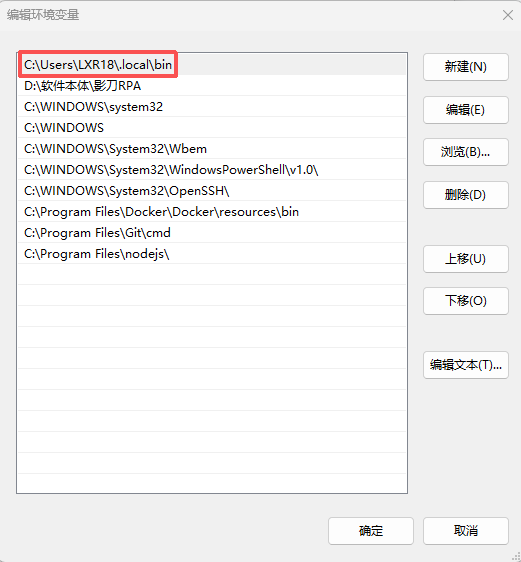

点“新建”,把你

uv的安装路径(通常是C:\Users\你的用户名\.local\bin)粘贴进去,一路确定回来就行了。

-

为了确认咱们搞定了,重新打开一个终端(这点很重要,不然不生效),敲下面这个命令检测一下:

uv --version3、创建项目并安装依赖

-

找个地方新建个文件夹,比如叫

mcp_test。这里得注意,千万别图省事叫mcp。我当时顺手就建了个名叫mcp的文件夹,结果安装依赖的时候直接报错,说找不到mcp。后来才反应过来,项目名不能和你要装的库同名,这不就是自己依赖自己吗?蠢了蠢了。 -

进到你新建的

mcp_test文件夹里,打开终端,开始干活:

# 初始化一个Python 3.13的环境

uv init . -p 3.13

# 安装mcp的开发包

uv add "mcp[cli]"-

等它跑完,把这个文件夹拖进你的代码编辑器(我用的是VS Code),顺手装上Python官方那几个插件,代码写起来有高亮和提示,舒服。

✅ 第二步:亮出代码

在mcp_test文件夹里新建一个main.py文件,把下面这段我们改造后的代码粘进去。

from mcp.server.fastmcp import FastMCP

mcp = FastMCP("CalculatorDemo")

# 工具1:加法

@mcp.tool()

def add(a: int, b: int) -> int:

"""计算两个整数的和。"""

return a + b

# 工具2:减法

@mcp.tool()

def subtract(a: int, b: int) -> int:

"""计算两个整数的差 (a - b)。"""

return a - b

if __name__ == "__main__":

# 我们先用stdio协议,后面再解释

mcp.run(transport="stdio")你看,现在我们有两个@mcp.tool工具:add和subtract。你想给AI增加多少个工具,就照着这个格式加多少个函数就行,简单粗暴。例子里还带了@mcp.resource,说白了,tool是让AI干活的,resource是让AI查数的。

✅ 第三步:搞懂三种“连接方式”

在运行之前,你必须搞懂mcp.run(transport="...")里那个transport是啥。它决定了你的MCP服务用什么方式和AI客户端“对话”,选错了就白干。

-

stdio(标准输入/输出): 最直接的本地模式。AI客户端和MCP服务在同一台电脑里,直接通过命令行管道通信,不走网络。本地开发调试最省心,我们待会就先用它。 -

http(标准Web API): 标准的Web模式。MCP服务变成一个API网址,客户端发一个“请求”,服务端回一个“响应”。通用、规范,但一来一回,实时性差。 -

sse(服务器发送事件): 服务器单向推送模式。客户端发起一次连接后,服务器就能持续不断地把新数据“推”给客户端,形成一个单向的数据流。AI生成长文本时,文字一个个冒出来的效果,就是靠它。用户体验好,但客户端没法反过来给服务器发消息。

✅ 第四步:启动服务,跑通两种模式

理论搞定,开练。

1、本地“直连”模式 (stdio): 确保你的main.py最后一行是 mcp.run(transport="stdio")。然后在终端里运行:

python main.py-

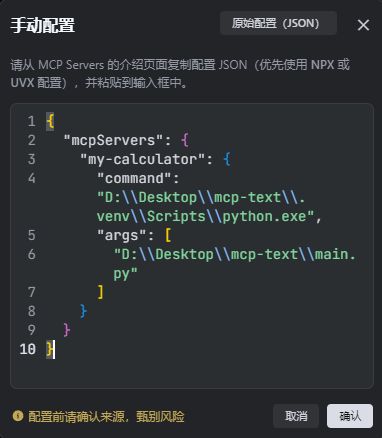

程序会停在这里,等待连接。现在,打开你的MCP客户端,把下面这段JSON加到它的服务器配置里:

{

"mcpServers": {

"my-calculator": {

"command": "D:\\path\\to\\your\\mcp_test\\.venv\\Scripts\\python.exe",

"args": [

"D:\\path\\to\\your\\mcp_test\\main.py"

]

}

}

}

-

注意!注意!注意!

command和args里的路径,一定要换成你自己电脑上的绝对路径。并且,command要指向.venv虚拟环境里的python.exe,否则99%会报“找不到mcp模块”的错。这个坑我踩过,别再掉了。 -

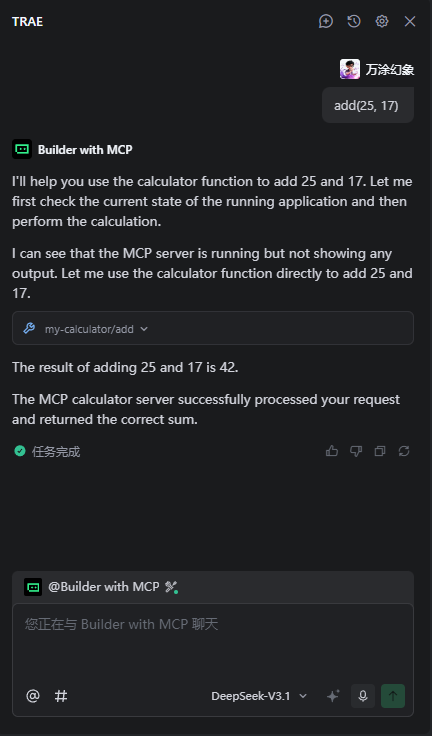

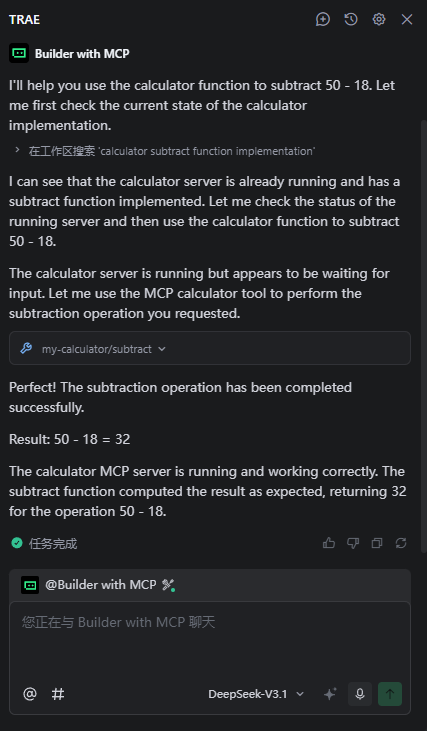

配好后,你就能成功调用

add(25, 17)得到42,也能调用subtract(50, 18)得到32了。AI现在同时学会了加减法。

|

|

2、“单向推送”模式 (sse): 咱们再试试sse模式。 首先,把main.py的最后一行改成:

mcp.run(transport="sse")-

然后重新运行

python main.py。这次它不会干等着,会告诉你服务跑起来了,监听一个网址,通常是http://127.0.0.1:8000/sse。 -

接着,客户端的配置也得换一下,这次不用

command了,直接告诉它网址:

{

"mcpServers": {

"my-calculator-sse": {

"url": "http://127.0.0.1:8000/sse"

}

}

}-

重启客户端,再调用工具。这次你会发现,服务器的终端里会不停地有

ping之类的消息跳出来,说明数据通道已经建好了。

至此,一个最简单的MCP“插头”就算成功通上电了,而且两种主要的“通电”方式你也掌握了。

03|重头戏:给火山“即梦”装上这个“万能插座”

有了上面的热身,现在我们来干正事:把我那个公众号封面的需求,用MCP的方式给实现了。

思路完全一样,无非是把上面那个简单的add和subtract函数,换成一个调用火山引擎“即梦”API的真实函数。

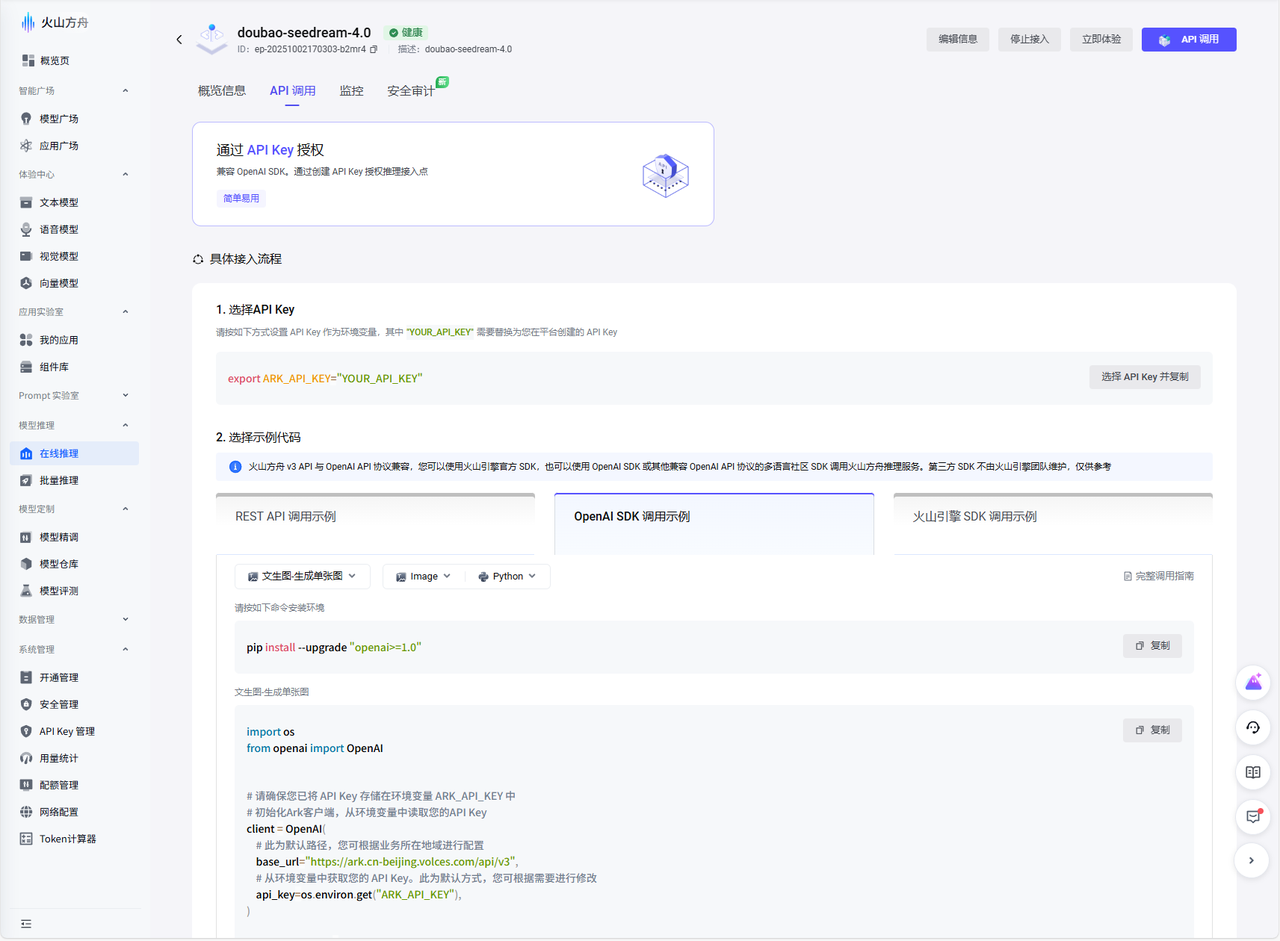

✅ 第一步:安装依赖库

这次我们需要真的去请求API了,所以要多装两个库:openai和requests。

# 在刚才的环境里,继续添加依赖

uv add openai requests你可能好奇为啥要装openai?

这是因为火山引擎方舟平台非常上道地提供了OpenAI兼容的API接口,这意味着我们可以用大家最熟悉的openai库来调用它,极大降低了学习成本,必须给个好评。

✅ 第二步:编写“AI绘画”工具的真实代码

接下来,我们把main.py升级一下,写上调用火山引擎API的真实逻辑。

import os

from openai import OpenAI

from mcp.server.fastmcp import FastMCP

mcp = FastMCP("VolcanoCoverTool")

@mcp.tool()

def generate_cover_image(prompt: str) -> str:

"""

根据输入的文本prompt,调用火山引擎Seedream 4.0模型生成一张公众号封面图。

成功则返回包含图片URL的Markdown字符串,失败则返回错误信息。

"""

# 1. 从环境变量读取API Key,这是最规范的做法

api_key = os.environ.get("ARK_API_KEY")

if not api_key:

return "错误:环境变量'ARK_API_KEY'未设置,请检查配置。"

try:

# 2. 初始化客户端,注意要指定火山引擎的base_url

client = OpenAI(

api_key=api_key,

base_url="https://ark.cn-beijing.volces.com/api/v3",

)

# 3. 发起API调用,请求生成图片。注意,这里的model ID是关键

response = client.images.generate(

model="doubao-seedream-4-0-250828", # 这是Seedream 4.0在火山方舟上的官方ID

prompt=prompt,

n=1, # 我们只需要一张图

size="1024x1024", # 或者其他支持的尺寸,比如 "1280x720"

)

# 4. 从返回结果中解析出图片URL

image_url = response.data[0].url

if image_url:

print(f"成功生成图片,URL: {image_url}") # 在服务器端打个日志,好习惯

return f""

else:

return "错误:API调用成功,但未返回图片URL。"

except Exception as e:

print(f"调用API时发生异常: {e}") # 详细的错误日志对排错至关重要

return f"错误:调用火山引擎API失败,详情请查看服务器日志。"

if __name__ == "__main__":

mcp.run(transport="stdio")这段代码就是实打实的干货了,没一句废话:

-

安全规范: 从环境变量里读取敏感的

API_KEY。 -

兼容接口: 利用

OpenAI库来初始化客户端,但把base_url指向火山引擎的地址,这是关键一步。 -

ID准确:

model参数我直接用了火山方舟上Seedream 4.0的官方IDdoubao-seedream-4-0-250828,保证调用的就是这个最新的、能力最强的模型。 -

异常处理: 用

try...except把整个API调用包起来,保证程序健壮。

这就是一个一线开发者应该有的代码素养。

✅ 第三步:配置并连接

最后,在MCP客户端的配置文件里,把环境变量配置好,让我们的代码能读到密钥。

{

"mcpServers": {

"volc-image-generator": {

"command": "D:\\path\\to\\your\\mcp_test\\.venv\\Scripts\\python.exe",

"args": [

"D:\\path\\to\\your\\mcp_test\\main.py"

],

"env": {

"ARK_API_KEY": "你的火山API密钥放在这里"

}

}

}

}还是那个“笨”办法,command用绝对路径,然后把ARK_API_KEY加到env里。

配置好,重启客户端。现在,我的AI就拥有了一个能干活、不出错、有日志的generate_cover_image工具。我心里的那颗“石子”,总算被清出去了。

我不光是解决了一个封面图的问题。有了这个接通了Seedream 4.0的“万能插座”,我等于拥有了一个专业的视觉设计团队。我看过官方那些案例,什么多图融合,把A的衣服穿在B身上;什么主体一致性,让一个IP形象出现在各种场景里;还有电商主图、装修效果图、游戏分镜... 以前觉得那是大厂才能玩的高级功能,现在,通过我这个小小的MCP服务器,这些能力都成了我随手可用的工具。

这才是技术带给实践者的真正快感。

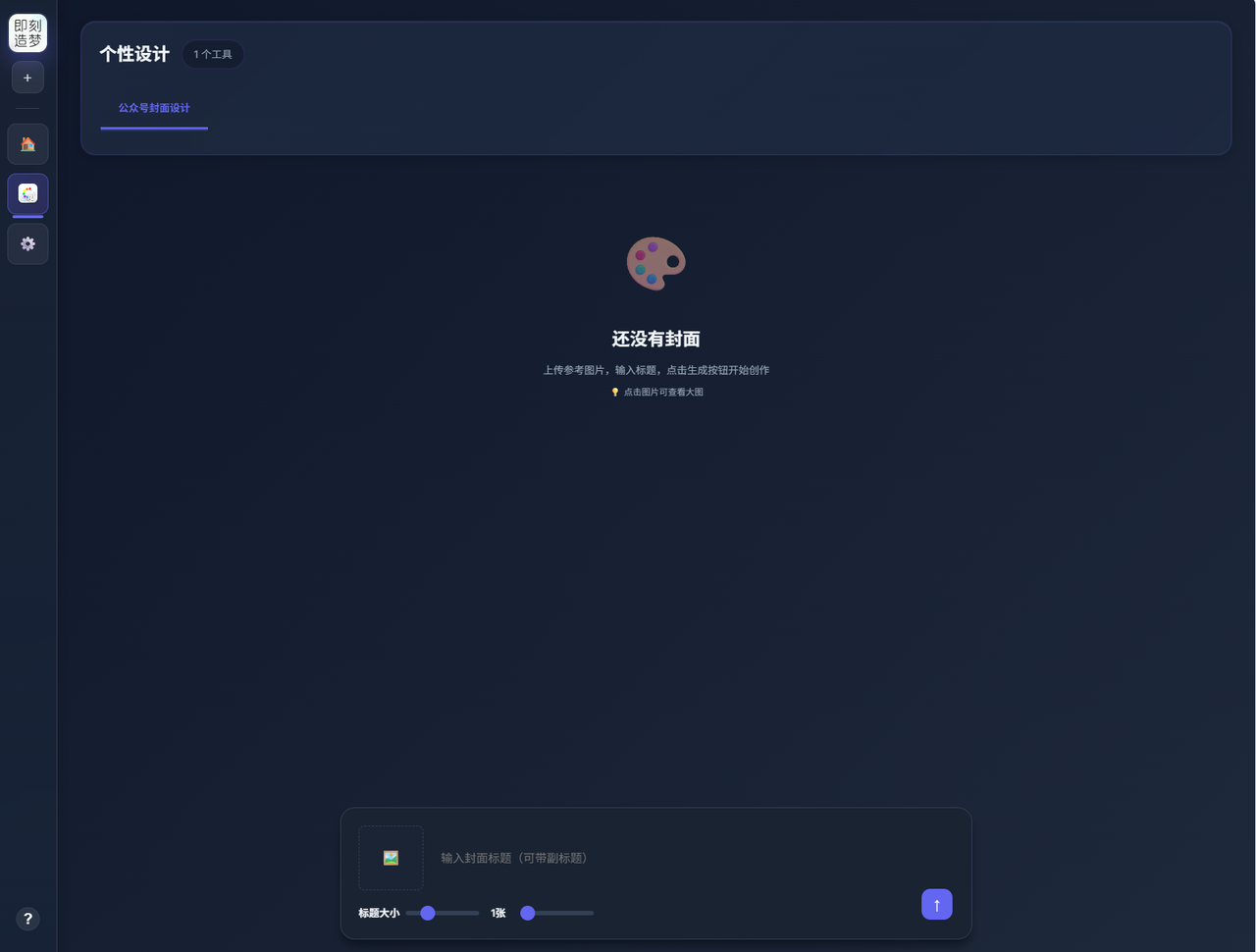

04|我的新玩具:“即刻造梦”工作台

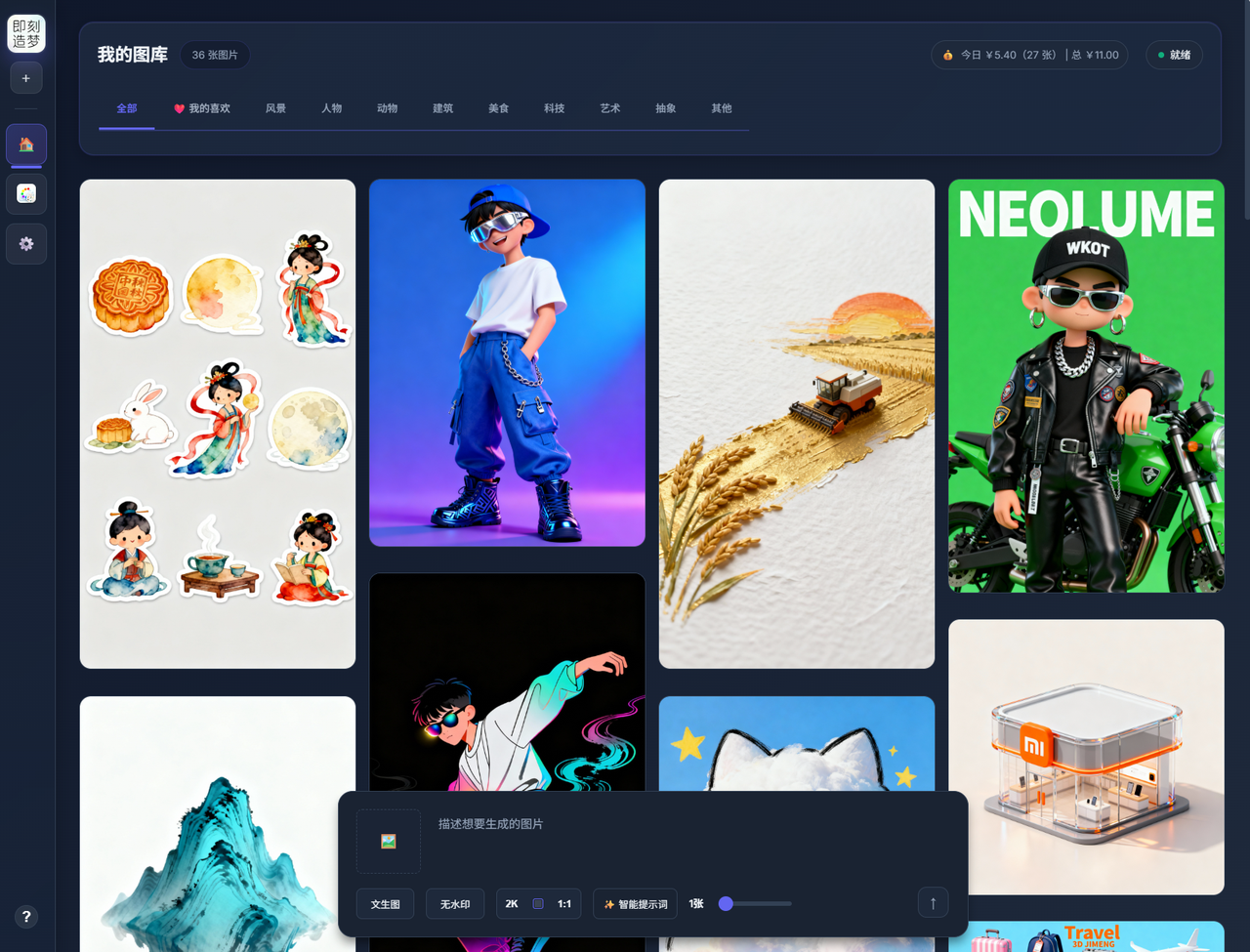

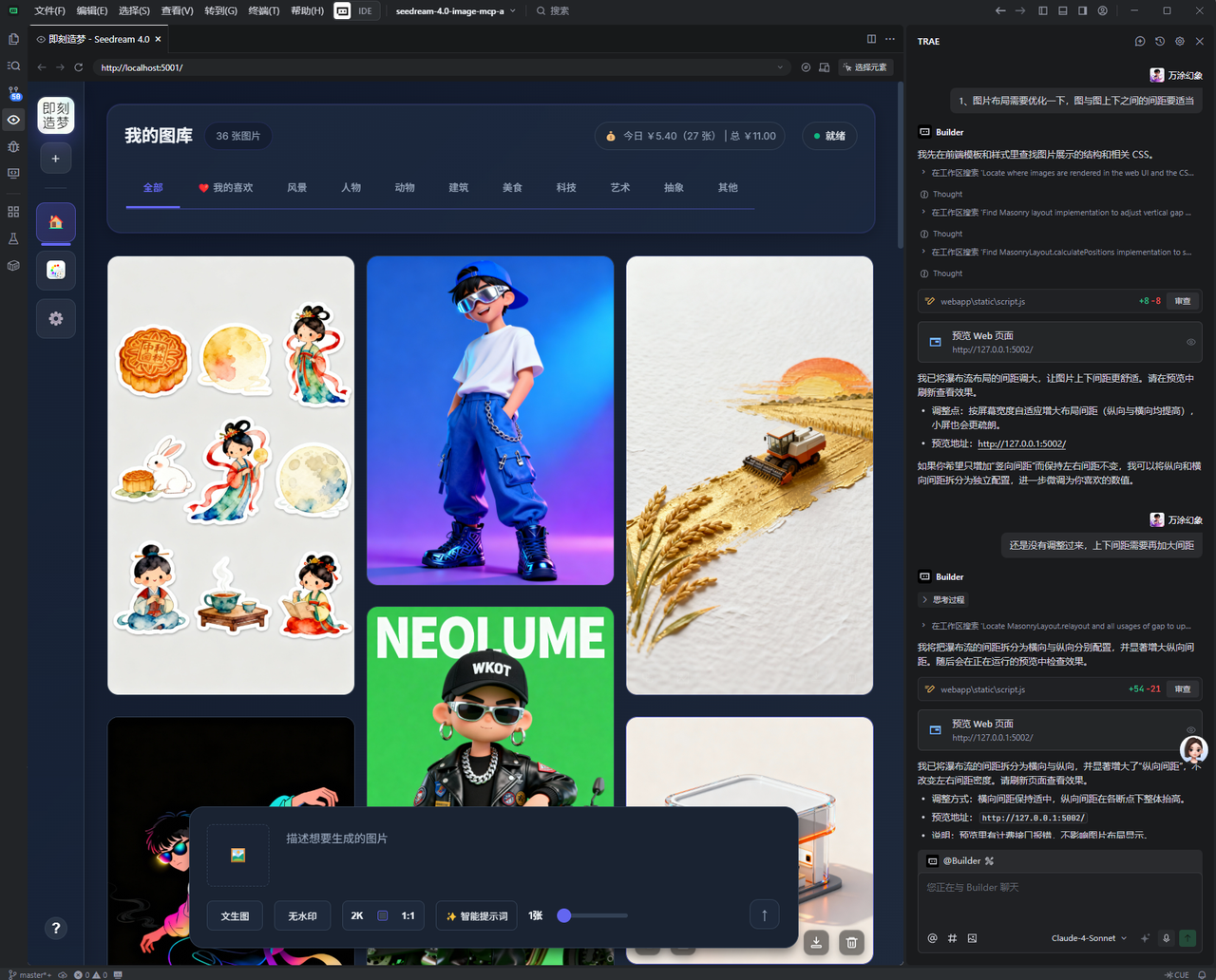

光有后端的MCP服务还不够带劲,我得给它配个好用的“遥控器”。于是,我又花了点时间,给自己封装了个前端应用,我管它叫“即刻造梦”工作台,就是下面这个样子:

这个小工具的核心,就是调用我们前面搭好的那个MCP服务。它把Seedream 4.0的核心能力都封装成了简单的按钮:文生图、图生图、甚至是多图融合,都能在这儿一键操作。我还加了几个自己常用的功能,比如“无水印”模式,省得我再去P图;还有“一键参考”,看到哪张图不错,可以直接把它当成新创作的参考图,不断迭代。

最有意思的是,这个工具的前后端代码,基本都是我用AI生成的。我只负责提需求和架构,AI帮我码代码。这才是AI时代该有的开发模式,对吧?

当然,我也没忘了最初的目标。我给它内置了一个“公众号封面”模板。现在,我写完文章,只需要来这里,输入标题,就能生成一张风格统一、带Logo的封面图。开头那个“鞋里的小石子”,算是彻底被我碾碎了。

所有生成的图片,都会自动保存在“我的图库”里。这对我来说太重要了。它不再是生成完就拉倒的一次性消费,而是一个能不断积累、能随时翻出来找灵感的个人素材库。下次打开,之前的杰作都还在。

关于这个工作台的搭建过程,特别是怎么用自然语言让AI帮你写前后端,也挺有意思的。但今天篇幅实在是打不住了,这个话题我们下次有机会再单独盘盘。

写在最后:工具只是个开始,思路才是那把钥匙

你看,从一个让人烦躁的封面图问题出发,我们一步步把一个想法,变成了一个能用的工具“即刻造梦”。

这篇文章折腾了这么久,其实我就想盘明白一件事:我们这些一线开发者,学习新技术的最终目的,不是为了追赶时髦,而是为了打造出能解决自己实际需求的工具。

市面上的工具再多,功能再强大,也总有不顺手、不贴合我们自己工作流的地方。那个“鞋里的小石子”,只有我们自己最清楚它在哪,有多硌脚。而用MCP这样的技术,把火山引擎这样强大的AI能力“拽”过来,为自己量身定做一个“清道夫”,这种感觉是无可替代的。

如果本文内容对您有启发,欢迎点个【赞】、【在看】或【转发】支持一下;也可以加个星标⭐,第一时间收到更多实战案例。

感谢您的阅读,我们下次再见👋!

更多推荐

已为社区贡献3条内容

已为社区贡献3条内容

所有评论(0)