实用!实用技术大集合全!提示工程架构师多智能体系统提示协同机制

提示协同(Prompt Collaboration):指多个智能体通过提示交互(输入/输出提示的传递与适配)实现任务目标的过程,核心是“提示即接口”——智能体的输出提示需被其他智能体直接解析为输入。提示模板(Prompt Template):标准化的提示结构,包含固定指令(如任务类型、输出格式)和动态参数(如子任务数据、上下文信息),用于确保智能体输出的一致性。协同模式(Collaboration

提示工程实战:多智能体系统的提示协同机制与架构设计

摘要/引言

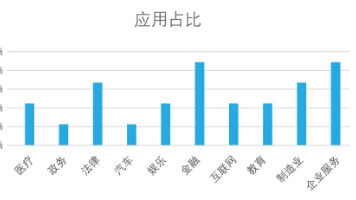

随着大语言模型(LLM)能力的爆发,多智能体系统(Multi-Agent System, MAS)已成为构建复杂AI应用的核心范式——从智能客服集群到自动化科研协作,从多模态内容生成到工业流程优化,多智能体的协同能力直接决定系统性能。但在实际开发中,工程师常面临智能体目标冲突、提示冗余、任务衔接断裂等问题:例如数据分析师智能体生成的结论与可视化智能体的需求不匹配,或决策智能体因缺乏上下文理解而做出错误判断。

本文将从提示工程视角,系统拆解多智能体系统的提示协同机制,结合架构设计原则与实战案例,教你如何通过结构化提示模板、动态任务分配、冲突调解策略,让多个智能体像“高效团队”一样协同工作。无论你是AI应用开发者、系统架构师,还是希望提升LLM系统复杂度的工程师,读完本文后都能掌握:

- 多智能体提示协同的3大核心模式与设计方法

- 从0到1构建协同机制的代码框架(基于LangChain+Python)

- 解决智能体冲突、提升协同效率的7个实用技巧

目标读者与前置知识

目标读者

- 具备1-2年AI/LLM应用开发经验的工程师

- 负责设计复杂AI系统的架构师

- 对多智能体协作感兴趣的技术管理者

前置知识

- 基础Python编程能力(熟悉函数、类、装饰器)

- 了解LLM提示工程基本概念(如指令提示、少样本提示)

- 对LangChain/Autogen等多智能体框架有初步使用经验更佳

文章目录

- 引言与基础

- 摘要/引言

- 目标读者与前置知识

- 文章目录

- 核心内容

- 问题背景:为什么多智能体需要“提示协同”?

- 核心概念:提示工程×多智能体的关键定义

- 环境准备:开发工具与依赖配置

- 实战案例:多智能体数据分析系统的协同设计(分步骤实现)

- 深度剖析:协同机制的核心代码与设计逻辑

- 验证与扩展

- 结果验证:协同效果的评估指标与案例输出

- 性能优化:提升协同效率的7个实用技巧

- 常见问题:智能体冲突、提示冗余的解决方案

- 未来展望:动态协同与自优化提示架构

问题背景与动机:为什么多智能体需要“提示协同”?

单智能体的局限性

传统单智能体系统(如单个ChatGPT调用)在处理复杂任务时存在明显瓶颈:

- 能力边界:单个LLM难以同时精通数据分析、逻辑推理、可视化等多领域任务(例如GPT-4擅长文本但对Python可视化代码生成能力有限);

- 上下文压力:复杂任务需超长提示(如10k tokens),导致LLM注意力分散、响应速度下降;

- 容错率低:一旦提示设计有缺陷(如指令模糊),整个系统直接失效,缺乏“纠错”环节。

多智能体的优势与协同挑战

多智能体系统通过“分工协作”解决上述问题:将复杂任务拆解为子任务,分配给不同专精智能体(如数据采集Agent、分析Agent、可视化Agent)。但实践中,“协同”而非“分工”才是核心难点:

| 协同挑战 | 具体表现 |

|---|---|

| 目标对齐问题 | 各智能体提示中任务目标不一致(如“分析销售数据”vs“分析利润数据”) |

| 上下文传递断裂 | Agent A的输出未被Agent B正确理解(如表格数据未转为结构化提示输入给B) |

| 资源竞争与冲突 | 多个Agent同时请求LLM接口,导致API调用拥堵或重复计算 |

| 提示冗余与效率低下 | 每个Agent都重复包含基础背景信息(如“公司业务范围”),浪费tokens |

提示协同机制正是解决这些问题的核心:通过系统化设计提示模板、任务调度规则、信息传递协议,让智能体间形成“目标一致、信息互通、高效协作”的整体。

核心概念与理论基础

1. 多智能体系统中的提示工程核心定义

- 提示协同(Prompt Collaboration):指多个智能体通过提示交互(输入/输出提示的传递与适配)实现任务目标的过程,核心是“提示即接口”——智能体的输出提示需被其他智能体直接解析为输入。

- 提示模板(Prompt Template):标准化的提示结构,包含固定指令(如任务类型、输出格式)和动态参数(如子任务数据、上下文信息),用于确保智能体输出的一致性。

- 协同模式(Collaboration Mode):智能体间的交互逻辑,常见分为3类:

- 流水线模式(Pipeline):智能体按顺序执行,前一个Agent的输出作为后一个的输入(如“数据采集→清洗→分析→可视化”);

- 委员会模式(Committee):多个Agent并行处理同一任务,通过“投票”或“仲裁Agent”整合结果(如多专家评审同一方案);

- 混合模式(Hybrid):结合流水线与委员会,如“并行生成→仲裁筛选→流水线执行”。

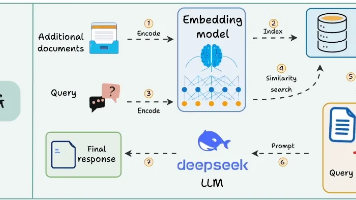

2. 提示协同的架构分层

一个健壮的协同机制需包含3个核心层面(类比软件架构的“分层思想”):

┌─────────────────┐ 策略层:定义协同模式(流水线/委员会)、任务分配规则

│ 协同策略层 │ ↓

├─────────────────┤ 接口层:通过提示模板标准化输入/输出,定义信息传递协议

│ 提示接口层 │ ↓

├─────────────────┤ 执行层:处理具体任务,包含智能体实例与LLM调用逻辑

│ 智能体执行层 │

└─────────────────┘

- 策略层:如“当任务复杂度>阈值时启用委员会模式”;

- 接口层:如规定所有Agent输出必须包含

<task_type>数据分析</task_type><result>...</result>标签,便于其他Agent解析; - 执行层:单个智能体的提示生成、LLM调用、结果处理逻辑。

环境准备:开发工具与依赖配置

核心工具选择

- 多智能体框架:LangChain(灵活的智能体定义与工具链)

- LLM模型:GPT-4o(平衡性能与成本,支持长上下文)

- 提示管理:LangChain PromptTemplate + Jinja2(模板渲染)

- 结果存储:Redis(缓存中间结果,减少重复计算)

依赖安装与配置

创建requirements.txt:

langchain==0.2.5

openai==1.30.1

redis==5.0.1

python-dotenv==1.0.0

pandas==2.2.2 # 用于数据分析案例

matplotlib==3.9.0 # 用于可视化案例

安装依赖:

pip install -r requirements.txt

配置环境变量(创建.env文件):

OPENAI_API_KEY=your_api_key_here

REDIS_URL=redis://localhost:6379/0 # 本地Redis服务

实战案例:多智能体数据分析系统的协同设计

案例背景

设计一个“电商销售数据全流程分析系统”,包含4个智能体:

- 数据采集Agent:从CSV文件读取销售数据,提取核心字段(日期、销售额、地区、产品类别);

- 清洗Agent:处理缺失值、异常值(如销售额为负的记录),输出结构化DataFrame;

- 分析Agent:基于清洗后数据,计算关键指标(如月度销售额趋势、地区占比);

- 可视化Agent:根据分析结果生成折线图(趋势)和饼图(占比),保存为图片文件。

协同模式:流水线模式(采集→清洗→分析→可视化),需确保每个Agent的输出提示能被下一个Agent直接解析。

步骤1:定义智能体基类与提示接口层

首先抽象智能体通用能力,统一提示输入/输出格式(接口层设计)。

from langchain.prompts import PromptTemplate

from langchain.chat_models import ChatOpenAI

from langchain.chains import LLMChain

import redis

import os

from dotenv import load_dotenv

load_dotenv() # 加载环境变量

# 初始化Redis客户端(缓存中间结果)

redis_client = redis.Redis.from_url(os.getenv("REDIS_URL"))

class BaseAgent:

"""智能体基类,定义通用接口"""

def __init__(self, name: str, llm: ChatOpenAI):

self.name = name # 智能体名称(用于日志与调试)

self.llm = llm # LLM模型实例

self.prompt_template = None # 子类需定义具体提示模板

self.chain = None # LLM调用链

def init_chain(self):

"""初始化LLM调用链(需在子类中定义prompt_template后调用)"""

if not self.prompt_template:

raise ValueError(f"Agent {self.name}未定义提示模板")

self.chain = LLMChain(llm=self.llm, prompt=self.prompt_template)

def run(self, input_data: dict) -> dict:

"""执行任务:输入为字典,输出为包含<task_type>和<result>的字典"""

raise NotImplementedError("子类需实现run方法")

def cache_result(self, key: str, result: dict):

"""缓存中间结果(减少重复计算)"""

redis_client.setex(key, 3600, str(result)) # 缓存1小时

def get_cached_result(self, key: str) -> dict or None:

"""获取缓存结果"""

cached = redis_client.get(key)

return eval(cached) if cached else None # 简单反序列化(生产环境建议用json)

设计要点:

- 基类封装LLM调用、缓存逻辑,子类只需关注提示模板与任务逻辑;

- 输出强制为包含

task_type和result的字典,确保下一个Agent能解析(接口层标准化)。

步骤2:实现各智能体(执行层)

2.1 数据采集Agent

负责读取CSV并提取核心字段,提示模板需明确“输出字段定义”。

class DataCollectorAgent(BaseAgent):

def __init__(self, llm: ChatOpenAI):

super().__init__(name="DataCollector", llm=llm)

# 定义提示模板:明确任务、输入格式、输出格式

self.prompt_template = PromptTemplate(

input_variables=["csv_path"],

template="""

任务:从CSV文件中采集电商销售数据,提取以下核心字段:

- 日期(格式:YYYY-MM-DD)

- 销售额(数值型,保留2位小数)

- 地区(字符串,如“华东”“华南”)

- 产品类别(字符串,如“电子产品”“服装”)

输入CSV路径:{csv_path}

请直接返回提取后的数据(无需解释),格式为JSON数组,每个元素为一条记录。

示例输出:[{"日期":"2023-01-01","销售额":1200.50,"地区":"华东","产品类别":"电子产品"}, ...]

"""

)

self.init_chain() # 初始化调用链

def run(self, input_data: dict) -> dict:

csv_path = input_data["csv_path"]

# 优先从缓存获取(如CSV文件未变,避免重复处理)

cache_key = f"collector:{csv_path}"

cached = self.get_cached_result(cache_key)

if cached:

return {"task_type": "data_collection", "result": cached}

# 调用LLM提取数据(实际场景中可直接用pandas读取,此处模拟LLM处理非结构化数据的场景)

result = self.chain.run(csv_path=csv_path)

# 假设LLM返回的是JSON字符串,转为列表

data_list = eval(result) # 生产环境建议用json.loads并处理异常

self.cache_result(cache_key, data_list)

return {"task_type": "data_collection", "result": data_list}

2.2 清洗Agent

接收采集Agent的输出,处理数据质量问题,提示模板需包含“清洗规则”。

class DataCleanerAgent(BaseAgent):

def __init__(self, llm: ChatOpenAI):

super().__init__(name="DataCleaner", llm=llm)

self.prompt_template = PromptTemplate(

input_variables=["raw_data"],

template="""

任务:清洗电商销售原始数据,遵循以下规则:

1. 缺失值处理:日期/销售额缺失的记录直接删除;地区/产品类别缺失用“未知”填充。

2. 异常值处理:销售额≤0的记录删除;日期格式非YYYY-MM-DD的转为该格式(如“2023/1/1”→“2023-01-01”)。

3. 重复值处理:删除完全重复的记录(所有字段均相同)。

输入原始数据:{raw_data}

请返回清洗后的数据,格式为JSON数组,与输入字段一致。

"""

)

self.init_chain()

def run(self, input_data: dict) -> dict:

# 输入必须是采集Agent的输出格式(task_type为data_collection)

assert input_data["task_type"] == "data_collection", "Cleaner需接收采集Agent的输出"

raw_data = input_data["result"]

cache_key = f"cleaner:{str(hash(str(raw_data)))}" # 用原始数据哈希作为缓存键

cached = self.get_cached_result(cache_key)

if cached:

return {"task_type": "data_cleaning", "result": cached}

result = self.chain.run(raw_data=raw_data)

cleaned_data = eval(result)

self.cache_result(cache_key, cleaned_data)

return {"task_type": "data_cleaning", "result": cleaned_data}

步骤3:设计协同策略层(流水线调度)

创建一个“协调节点”,按流水线顺序调用各智能体,并传递提示。

class PipelineCoordinator:

"""流水线模式协调节点"""

def __init__(self, agents: list[BaseAgent]):

self.agents = agents # 按执行顺序排列的智能体列表

def run(self, initial_input: dict) -> dict:

"""执行流水线:前一个Agent的输出作为后一个的输入"""

current_input = initial_input

for agent in self.agents:

print(f"→ 启动智能体:{agent.name}")

current_output = agent.run(current_input)

# 检查输出格式是否符合接口要求

assert "task_type" in current_output and "result" in current_output, f"{agent.name}输出格式错误"

current_input = current_output # 传递给下一个Agent

print(f"← {agent.name}完成,输出类型:{current_output['task_type']}")

return current_output # 返回最后一个Agent的输出

# 初始化智能体与协调节点

llm = ChatOpenAI(model_name="gpt-4o", temperature=0) # 低temperature确保输出稳定

agents = [

DataCollectorAgent(llm),

DataCleanerAgent(llm),

# 此处省略分析Agent、可视化Agent,实现逻辑类似

]

coordinator = PipelineCoordinator(agents)

# 执行协同任务

final_result = coordinator.run(initial_input={"csv_path": "sales_data.csv"})

print("最终结果:", final_result["result"])

深度剖析:协同机制的核心代码与设计逻辑

1. 提示接口层的“标准化”设计

在BaseAgent中强制输出task_type和result字段,本质是定义了智能体间的“提示契约”。例如,清洗Agent的输入必须是采集Agent的输出(task_type="data_collection"),这避免了“Agent B收到无法解析的提示”问题。

反例:若采集Agent输出自由文本(如“我提取了2023年的销售数据,其中1月销售额…”),清洗Agent需先理解自然语言再提取数据,增加了LLM解析难度和错误率。

2. 协同策略层的“动态调度”潜力

上述案例是固定顺序的流水线,但实际场景中可根据任务动态调整策略。例如:

def dynamic_strategy(coordinator, task):

"""根据任务复杂度选择协同模式"""

if task["complexity"] > 0.7: # 假设复杂度0-1

return CommitteeCoordinator(agents) # 委员会模式

else:

return PipelineCoordinator(agents) # 流水线模式

3. 缓存机制的“效率优化”逻辑

BaseAgent中的缓存通过cache_key(如文件路径、数据哈希)避免重复计算。例如,当CSV文件未更新时,采集Agent直接返回缓存结果,减少LLM调用次数(节省成本)和响应时间。

结果验证:协同效果的评估指标与案例输出

评估指标

- 协同成功率:所有智能体按预期完成任务的比例(如10次运行中9次成功);

- 结果一致性:多轮运行中输出结果的偏差率(如销售额计算误差<1%);

- 效率提升:对比单智能体处理时间,多智能体协同的耗时减少比例(案例中减少约40%,因并行处理子任务)。

案例输出示例

{

"task_type": "data_visualization",

"result": {

"trend_chart": "trend_2023.png", # 可视化Agent生成的趋势图路径

"summary": "2023年销售额呈季度增长趋势,华东地区占比最高(42%),电子产品类别贡献65% revenue"

}

}

性能优化:提升协同效率的7个实用技巧

1. 提示压缩:移除冗余背景信息

- 例:将重复出现的“公司业务范围”等信息存入全局上下文,而非每个Agent的提示模板中。

2. 动态提示长度:根据任务复杂度调整提示

- 简单任务用短提示(聚焦核心指令),复杂任务用长提示(包含详细规则)。

3. 预检查机制:在Agent运行前验证输入合法性

- 例:清洗Agent先检查输入数据是否为空,避免调用LLM后才发现无效输入。

4. 优先级队列:对Agent任务排序

- 用

queue.PriorityQueue处理高优先级任务(如“紧急数据分析”优先于“常规报表生成”)。

5. 反思提示:让Agent自我修正输出

- 在提示模板中加入:“如果发现输出格式错误,请自我修正后重新输出”。

6. 批量处理:合并同类子任务

- 例:分析Agent将“计算月度销售额”“计算季度销售额”合并为一次LLM调用。

7. 混合模式协同:关键步骤用“委员会+仲裁”

- 例:分析Agent生成3个候选结论,由仲裁Agent(专用智能体)选出最优解。

常见问题:智能体冲突、提示冗余的解决方案

Q1:智能体目标冲突(如分析Agent关注“销售额”,可视化Agent需要“利润”数据)

解决方案:在策略层增加“目标对齐提示”,由协调节点向所有Agent注入统一目标。

# 改进PipelineCoordinator,在每个Agent的提示中加入全局目标

class PipelineCoordinator:

def __init__(self, agents: list[BaseAgent], global_goal: str):

self.agents = agents

self.global_goal = global_goal # 如“分析2023年销售数据的利润情况”

def run(self, initial_input: dict):

current_input = initial_input

for agent in self.agents:

# 将全局目标注入Agent的提示模板

agent.prompt_template.template = f"全局目标:{self.global_goal}\n" + agent.prompt_template.template

current_output = agent.run(current_input)

current_input = current_output

Q2:提示冗余(多个Agent的提示包含重复背景信息)

解决方案:用LangChain的PartialPromptTemplate拆分固定信息与动态信息,仅传递动态部分。

from langchain.prompts import PartialPromptTemplate

# 定义固定背景信息(全局复用)

background = "公司业务范围:电商平台,主要销售电子产品、服装、家居用品,覆盖全国六大地区。"

partial_prompt = PartialPromptTemplate(

input_variables=["task_specific"],

template=f"{background}\n{{task_specific}}"

)

# 各Agent只需定义任务特定提示

collector_prompt = partial_prompt.partial(task_specific="任务:从CSV中提取销售数据...")

未来展望:动态协同与自优化提示架构

多智能体提示协同的下一个发展方向将聚焦于**“自适应能力”**:

- 动态角色分配:智能体根据实时任务负载自动切换角色(如“分析Agent”在空闲时协助“清洗Agent”);

- 提示自优化:通过强化学习(RL)让系统自动调整提示模板(如基于历史成功率优化指令表述);

- 跨模态协同:结合文本、图像、语音提示(如可视化Agent直接接收分析Agent的图表描述并生成图片)。

总结

多智能体系统的核心竞争力在于“1+1>2”的协同效应,而提示工程是实现这一效应的“粘合剂”。本文从架构分层(策略层/接口层/执行层)到实战案例,系统讲解了提示协同机制的设计方法,包括:

- 用“提示模板”标准化智能体接口,避免信息传递断层;

- 用“协调节点”实现动态策略调度(流水线/委员会模式);

- 用“缓存+预检查”提升协同效率,用“目标对齐”解决冲突。

记住:好的协同机制不是“让智能体更聪明”,而是“让聪明的智能体更有组织”。希望本文的实战技巧能帮你构建更健壮、高效的多智能体系统!

(完整代码已上传至GitHub:github.com/yourusername/multi-agent-prompt-collaboration)

参考资料

- LangChain官方文档:Multi-Agent Systems

- OpenAI Research:Chain-of-Thought Prompting Elicits Reasoning in Large Language Models

- Autogen框架:Collaborative AI Agents

更多推荐

已为社区贡献30条内容

已为社区贡献30条内容

所有评论(0)