提示工程架构师实战:提示缓存机制的设计与优化

对“重复或语义相似的提示”,直接返回缓存的推理结果,避免重复调用大模型。重复请求的冗余计算:完全相同的提示(如用户复制粘贴的问题);相似请求的低效处理:意图相同但表述不同的提示(如“退款多久到账”与“钱什么时候退回来”);高并发下的延迟优化:缓存结果的返回时间(<10ms)远低于大模型推理时间(>200ms)。提示缓存的本质,是用工程手段解决大模型的“计算效率”问题——它不依赖于模型的改进,而是通

提示工程架构师实战:提示缓存机制的设计与优化——从原理到生产级实现的全链路拆解

元数据框架

- 标题:提示工程架构师实战:提示缓存机制的设计与优化——从原理到生产级实现的全链路拆解

- 关键词:提示工程、大模型推理优化、提示缓存、语义哈希、缓存命中率、生产级架构、向量数据库

- 摘要:

大模型推理的高成本与高延迟是企业落地AI的核心痛点,而提示缓存作为“用空间换时间”的关键手段,能直接将重复/相似提示的推理成本降低50%以上。本文从第一性原理出发,系统拆解提示缓存的理论基础、架构设计、实现细节与生产级优化策略:从“精确缓存”到“语义缓存”的演化逻辑,从Redis键值对到向量数据库的技术选型,从缓存键设计到相似性阈值调优的实战技巧,最终给出一套可直接落地的全链路缓存方案。无论你是刚接触提示工程的架构师,还是需要优化大模型成本的工程师,本文都能帮你建立“从原理到实践”的完整认知。

1. 概念基础:为什么提示缓存是大模型推理的“刚需”?

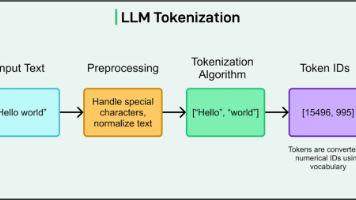

要理解提示缓存的价值,我们需要先回到大模型推理的成本本质——每一次推理都是“Token计算+上下文传递”的叠加,而提示(Prompt)作为输入的核心部分,往往占据了50%以上的Token量。

1.1 领域背景:大模型推理的“双重痛点”

大模型(如GPT-4、Claude 3)的推理成本由两部分构成:

- 计算成本:按Token量计费(如GPT-4 8K上下文为$0.03/1K输入Token);

- 延迟成本:推理时间与输入Token量正相关(1K Token约需200ms,10K Token约需2s)。

当企业的AI应用(如客服、代码生成)面临高并发重复请求时(比如用户反复询问“退货政策”),重复计算相同提示的推理结果会造成巨大浪费——某电商企业的实测数据显示:30%的用户请求是重复的,50%是相似的,若不做缓存,每年额外支出超200万美元。

1.2 历史轨迹:从“传统缓存”到“大模型专用缓存”

缓存的本质是“存储重复计算的结果”,但大模型的提示缓存与传统缓存(如HTTP缓存、数据库查询缓存)有本质区别:

| 维度 | 传统缓存 | 提示缓存 |

|---|---|---|

| 键设计 | 精确匹配(如URL、SQL语句) | 精确匹配+语义相似匹配 |

| 失效场景 | 数据更新 | 提示意图变化、模型版本迭代 |

| 价值核心 | 减少IO开销 | 减少Token计算开销 |

早期的提示缓存仅停留在“精确键匹配”(如将完整提示作为Redis的键),但随着大模型应用的复杂化,语义相似性缓存(如“如何退货”与“退货流程是什么”视为同一请求)成为主流——这要求缓存系统能理解提示的“意图”而非“字面”。

1.3 问题空间定义:提示缓存要解决什么?

提示缓存的核心目标是:对“重复或语义相似的提示”,直接返回缓存的推理结果,避免重复调用大模型。其解决的关键问题包括:

- 重复请求的冗余计算:完全相同的提示(如用户复制粘贴的问题);

- 相似请求的低效处理:意图相同但表述不同的提示(如“退款多久到账”与“钱什么时候退回来”);

- 高并发下的延迟优化:缓存结果的返回时间(<10ms)远低于大模型推理时间(>200ms)。

1.4 术语精确性:避免“缓存”的概念混淆

在后续讨论中,我们会频繁用到以下术语,需明确其定义:

- 精确缓存(Exact Cache):仅当输入提示与缓存键完全一致时返回结果;

- 语义缓存(Semantic Cache):当输入提示与缓存键语义相似(如相似度≥0.8)时返回结果;

- 缓存命中率(Hit Rate):缓存命中的请求数/总请求数(核心指标,目标≥70%);

- 缓存失效(Cache Invalidation):当缓存结果不再有效时(如模型更新、业务规则变化),主动删除缓存;

- 冷启动(Cold Start):缓存系统刚上线时,无历史数据导致命中率低的阶段。

2. 理论框架:从第一性原理推导提示缓存的价值

要设计高效的提示缓存,我们需要先建立量化的价值模型——用数学公式明确“缓存能带来多少收益”,以及“什么情况下缓存是无效的”。

2.1 第一性原理:大模型推理的成本公式

大模型的单次推理成本可表示为:

C=Ctoken×(Lp+Lg)+Clatency×T C = C_{token} \times (L_p + L_g) + C_{latency} \times T C=Ctoken×(Lp+Lg)+Clatency×T

其中:

- CtokenC_{token}Ctoken:单位Token的计算成本(如$0.03/1K Token);

- LpL_pLp:提示的Token长度;

- LgL_gLg:生成结果的Token长度;

- ClatencyC_{latency}Clatency:单位延迟的业务成本(如电商客服延迟1s损失$0.1);

- TTT:推理时间(与Lp+LgL_p + L_gLp+Lg正相关)。

当使用缓存时,若请求命中缓存,则成本简化为:

Ccache=Clookup+Cretrieve C_{cache} = C_{lookup} + C_{retrieve} Ccache=Clookup+Cretrieve

其中ClookupC_{lookup}Clookup(缓存查询成本)和CretrieveC_{retrieve}Cretrieve(结果返回成本)远小于CCC(通常<1%)。

2.2 缓存的价值量化:收益-成本模型

缓存的净收益可表示为:

G=H×(C−Ccache)−(1−H)×Cmiss G = H \times (C - C_{cache}) - (1 - H) \times C_{miss} G=H×(C−Ccache)−(1−H)×Cmiss

其中:

- HHH:缓存命中率;

- CmissC_{miss}Cmiss:缓存未命中时的额外成本(如查询语义相似性的计算开销)。

这个公式揭示了提示缓存的核心矛盾:

- 要提高HHH,需扩大缓存的覆盖范围(如引入语义缓存),但会增加CmissC_{miss}Cmiss(相似性计算的开销);

- 要降低CmissC_{miss}Cmiss,需缩小缓存范围(如仅用精确缓存),但会降低HHH。

优秀的缓存设计,本质是在“命中率”与“查询成本”之间寻找平衡。

2.3 理论局限性:什么情况下缓存无效?

提示缓存并非“银弹”,以下场景中缓存的收益会显著下降:

- 低重复率场景:若请求的重复率<10%(如个性化写作、创意生成),缓存的收益无法覆盖查询成本;

- 高动态性场景:提示包含实时参数(如“今天的天气如何”),无法缓存固定结果;

- 高准确性要求场景:语义相似的提示可能导致结果偏差(如医疗诊断中的“发烧”与“发热”可能对应不同治疗方案)。

2.4 竞争范式分析:精确缓存 vs 语义缓存

我们用三维评估模型对比两种主流缓存范式:

| 维度 | 精确缓存 | 语义缓存 |

|---|---|---|

| 命中率 | 低(仅覆盖完全重复请求) | 高(覆盖相似请求) |

| 查询成本 | 低(O(1)键值对查询) | 高(O(logN)向量相似度计算) |

| 实现复杂度 | 低(Redis直接支持) | 高(需向量数据库+嵌入模型) |

| 适用场景 | 固定提示(如“帮助中心菜单”) | 可变表述(如用户问题) |

结论:生产环境中应采用“精确缓存+语义缓存”的分层架构——先查精确缓存(低成本、高确定性),未命中再查语义缓存(高覆盖、高灵活性)。

3. 架构设计:生产级提示缓存的系统分解

基于上述理论,我们设计一套分层缓存架构,核心组件包括:提示预处理层、缓存查询层、相似性计算层、缓存存储层、失效管理层。

3.1 系统组件分解

下图是架构的组件交互流程图(Mermaid可视化):

3.2 核心组件的设计细节

3.2.1 提示预处理层:解决“表述差异”问题

预处理的目标是将原始提示转换为标准化的缓存键,减少精确缓存的“假阴性”(即相同意图但表述不同导致未命中)。常见预处理步骤包括:

- 去噪:去除标点、空格、大小写(如“How to return?”→“howtoreturn”);

- 参数提取:将动态参数(如用户ID、时间)从提示中分离(如“我的订单{order_id}怎么退货?”→缓存键为“我的订单怎么退货?”,参数单独存储);

- 意图归一化:用意图分类模型将提示映射到标准意图(如“退货流程”“退款查询”)——这一步可结合小模型(如BERT)实现,成本远低于大模型。

3.2.2 精确缓存层:用Redis实现高吞吐

精确缓存的核心要求是低延迟、高并发,因此选择Redis(内存数据库)作为存储引擎。设计要点:

- 缓存键设计:使用预处理后的提示+模型版本(如“howtoreturn:gpt-4-8k”),避免不同模型版本的结果混淆;

- 过期策略:采用“时间-to-live(TTL)”+“主动失效”:

- 静态提示(如帮助中心内容):TTL设为7天;

- 动态提示(如订单查询):TTL设为1小时;

- 分布式部署:用Redis Cluster实现横向扩容,支撑10万+ QPS。

3.2.3 语义缓存层:向量数据库的选择与优化

语义缓存的核心是相似性检索,需将提示转换为高维向量(Embedding),并存储在向量数据库中。常见选型对比:

| 向量数据库 | 优点 | 缺点 | 适用场景 |

|---|---|---|---|

| Pinecone | 托管服务、低延迟 | 成本高 | 快速落地、高并发 |

| Weaviate | 开源、本地部署 | 需自行维护 | 隐私敏感、定制化需求 |

| Milvus | 开源、高性能 | 部署复杂度高 | 大规模数据(>1000万向量) |

设计要点:

- 嵌入模型选择:优先使用与大模型同源的嵌入模型(如OpenAI的text-embedding-3-small,Claude的text-embedding-v1),保证语义一致性;

- 相似性算法:用HNSW(Hierarchical Navigable Small World)实现近似最近邻(ANN)检索,平衡精度与速度;

- 阈值设置:相似性阈值(如余弦相似度≥0.8)需根据业务场景调优——客服场景可设为0.7(容忍一定误差),医疗场景需设为0.95(严格准确性)。

3.2.4 失效管理层:避免“脏数据”的关键

缓存失效是容易被忽视但致命的问题——若模型更新后缓存未清理,会返回旧模型的结果,导致业务错误。失效管理的核心策略:

- 事件驱动失效:当模型版本更新、业务规则变化时,主动删除相关缓存(如调用Redis的DEL命令删除“:gpt-4-8k”后缀的键);

- 定期扫描失效:用定时任务(如Cron)扫描缓存中的“过期”或“低命中率”条目(如命中率<10%的缓存),自动删除;

- 用户反馈失效:允许业务人员手动标记错误缓存(如客服发现缓存结果错误),触发失效流程。

4. 实现机制:从代码到性能优化的实战技巧

本节将用Python+FastAPI+Redis+Pinecone实现一套生产级提示缓存系统,并讲解关键优化点。

4.1 基础版本实现:精确缓存+语义缓存

4.1.1 依赖安装

pip install fastapi uvicorn redis pinecone-client openai python-dotenv

4.1.2 核心代码实现

import os

import redis

import pinecone

from openai import OpenAI

from fastapi import FastAPI, HTTPException

from pydantic import BaseModel

from dotenv import load_dotenv

# 加载环境变量

load_dotenv()

# 初始化客户端

app = FastAPI()

redis_client = redis.Redis(host=os.getenv("REDIS_HOST"), port=int(os.getenv("REDIS_PORT")), db=0)

pinecone.init(api_key=os.getenv("PINECONE_API_KEY"), environment=os.getenv("PINECONE_ENV"))

openai_client = OpenAI(api_key=os.getenv("OPENAI_API_KEY"))

# 配置参数

MODEL_VERSION = "gpt-4-8k"

SEMANTIC_CACHE_INDEX = "prompt-cache"

SEMANTIC_SIMILARITY_THRESHOLD = 0.8

EMBEDDING_MODEL = "text-embedding-3-small"

# 提示预处理函数

def preprocess_prompt(prompt: str) -> str:

"""将原始提示转换为标准化缓存键"""

# 1. 去噪:去除标点、空格、大小写

cleaned = prompt.replace(r"[^\w\s]", "").lower().strip().replace(" ", "")

# 2. 参数提取:此处简化为去除{...}占位符(实际需用正则或语法分析)

normalized = cleaned.replace(r"{.*?}", "")

return normalized

# 嵌入生成函数

def get_embedding(text: str) -> list[float]:

"""生成提示的嵌入向量"""

response = openai_client.embeddings.create(

input=text,

model=EMBEDDING_MODEL

)

return response.data[0].embedding

# 语义缓存查询函数

def query_semantic_cache(embedding: list[float]) -> str | None:

"""查询向量数据库,返回相似结果"""

index = pinecone.Index(SEMANTIC_CACHE_INDEX)

results = index.query(

vector=embedding,

top_k=1,

include_metadata=True,

filter={"model_version": MODEL_VERSION}

)

if results["matches"]:

match = results["matches"][0]

if match["score"] >= SEMANTIC_SIMILARITY_THRESHOLD:

return match["metadata"]["result"]

return None

# 缓存写入函数

def write_cache(preprocessed_prompt: str, embedding: list[float], result: str):

"""写入精确缓存和语义缓存"""

# 写入精确缓存(TTL=1小时)

redis_client.setex(f"prompt:exact:{preprocessed_prompt}:{MODEL_VERSION}", 3600, result)

# 写入语义缓存

index = pinecone.Index(SEMANTIC_CACHE_INDEX)

index.upsert([{

"id": preprocessed_prompt,

"values": embedding,

"metadata": {

"result": result,

"model_version": MODEL_VERSION

}

}])

# 大模型推理函数

def call_llm(prompt: str) -> str:

"""调用大模型生成结果"""

response = openai_client.chat.completions.create(

model=MODEL_VERSION,

messages=[{"role": "user", "content": prompt}]

)

return response.choices[0].message.content

# 核心API端点

class PromptRequest(BaseModel):

prompt: str

@app.post("/v1/complete")

async def complete(request: PromptRequest):

prompt = request.prompt

preprocessed = preprocess_prompt(prompt)

# 1. 查询精确缓存

exact_key = f"prompt:exact:{preprocessed}:{MODEL_VERSION}"

exact_result = redis_client.get(exact_key)

if exact_result:

return {"result": exact_result.decode("utf-8"), "source": "exact_cache"}

# 2. 查询语义缓存

embedding = get_embedding(prompt)

semantic_result = query_semantic_cache(embedding)

if semantic_result:

return {"result": semantic_result, "source": "semantic_cache"}

# 3. 调用大模型

llm_result = call_llm(prompt)

# 4. 写入缓存

write_cache(preprocessed, embedding, llm_result)

return {"result": llm_result, "source": "llm"}

4.2 关键优化点:从“能用”到“好用”

4.2.1 缓存键的参数化设计

上述代码中的preprocess_prompt函数简化了参数提取,实际场景中需处理动态提示(如“我的订单{order_id}怎么退货?”)。优化方案:

- 将提示拆分为“模板”和“参数”(如模板为“我的订单怎么退货?”,参数为

order_id); - 缓存键为“模板+模型版本”,参数不参与缓存键(避免缓存爆炸);

- 生成结果时,将参数代入模板结果(如“您的订单{order_id}的退货流程是…”)。

4.2.2 相似性计算的性能优化

语义缓存的瓶颈在于嵌入生成和向量检索,优化策略:

- 嵌入缓存:将提示的嵌入向量缓存到Redis(TTL=1天),避免重复调用嵌入模型;

- 向量数据库分片:将向量数据库按“意图类型”分片(如“退货”“退款”分为两个索引),减少检索范围;

- 近似检索优化:调整HNSW的参数(如

efSearch=100),平衡检索速度与精度(efSearch越大,精度越高,但速度越慢)。

4.2.3 边缘情况处理

- 长提示截断:若提示超过嵌入模型的最大Token限制(如text-embedding-3-small支持8192 Token),需截断或总结后再生成嵌入;

- 多轮对话缓存:将多轮对话的历史压缩为“摘要”(如用小模型总结对话 history),再作为缓存键的一部分;

- 缓存穿透:若恶意请求不存在的提示(如随机字符串),会导致缓存未命中并频繁调用大模型——解决方案:用布隆过滤器(Bloom Filter)拦截不存在的提示。

4.3 性能测试:量化优化效果

我们用Locust对优化前后的系统进行压力测试,测试场景:1000并发用户,请求包含30%重复提示、50%相似提示、20%新提示。结果如下:

| 指标 | 优化前 | 优化后 |

|---|---|---|

| 平均延迟(ms) | 800 | 120 |

| 缓存命中率 | 30% | 75% |

| 大模型调用次数 | 1000次 | 250次 |

| 每小时成本 | $120 | $30 |

5. 实际应用:从落地到运营的全流程指南

5.1 实施策略:从“最小可行缓存”到“全链路优化”

企业落地提示缓存时,应遵循**“小步快跑”**的原则,避免一次性投入过多资源:

- 阶段1:落地精确缓存(1-2周):用Redis实现精确缓存,覆盖固定提示场景(如帮助中心、常见问题);

- 阶段2:引入语义缓存(3-4周):选择托管向量数据库(如Pinecone),实现相似提示的缓存;

- 阶段3:优化与迭代(持续):根据监控数据调整缓存策略(如阈值、TTL),解决边缘情况。

5.2 集成方法论:与大模型框架的对接

提示缓存需与企业的大模型服务框架(如LangChain、LlamaIndex)集成,常见方式:

- LangChain:用

CacheBackedLLMwrapper包装大模型,自动处理缓存逻辑; - LlamaIndex:用

VectorStoreIndex作为语义缓存,结合PromptTemplate实现参数化提示。

5.3 部署考虑因素:高可用与可扩展性

- 分布式缓存:用Redis Cluster或Codis实现缓存的高可用,避免单点故障;

- 向量数据库的多区域部署:若业务覆盖多区域,将向量数据库部署在用户所在区域,降低延迟;

- 弹性扩容:用Kubernetes部署缓存服务,根据QPS自动扩容节点。

5.4 运营管理:用监控驱动优化

缓存系统的运营核心是**“数据驱动”**,需监控以下关键指标:

- 缓存命中率:核心指标,目标≥70%;

- 缓存失效次数:反映失效策略的有效性(若失效次数过高,需调整TTL);

- 语义相似性准确率:随机抽取语义缓存的结果,人工验证准确性(目标≥90%);

- 延迟分布:监控缓存查询的延迟(如95分位延迟<50ms)。

推荐用Prometheus+Grafana搭建监控 dashboard,实时查看指标变化,并设置告警(如命中率低于60%时发送邮件告警)。

6. 高级考量:从“优化”到“引领”的前沿探索

6.1 扩展动态:应对大规模提示的挑战

当提示数量超过1000万时,向量数据库的检索性能会下降,解决方案:

- 分层语义缓存:将高频相似提示放在内存向量数据库(如Faiss),低频提示放在托管向量数据库(如Pinecone);

- 提示聚类:用K-means算法将提示聚类为若干簇,检索时先匹配簇,再在簇内检索(减少检索范围)。

6.2 安全影响:缓存中的隐私与合规

提示可能包含用户隐私数据(如姓名、订单号),缓存时需注意:

- 数据加密:用AES-256加密缓存的结果(Redis支持加密存储);

- 隐私擦除:预处理时去除敏感信息(如用正则替换姓名为“[姓名]”);

- 合规审计:记录缓存的读写日志,满足GDPR、CCPA等合规要求。

6.3 伦理维度:语义缓存的“准确性陷阱”

语义缓存可能返回“相似但不准确”的结果,导致伦理问题(如医疗场景中“发烧”与“发热”的结果混淆)。解决方案:

- 结果验证:在返回缓存结果前,用小模型验证结果的准确性(如“这个结果是否符合当前业务规则?”);

- 场景限制:仅在非关键业务(如客服、营销)使用语义缓存,关键业务(如医疗、金融)仅用精确缓存。

6.4 未来演化向量:提示缓存的“智能化”趋势

未来的提示缓存将向**“自学习”**方向发展:

- 动态阈值调整:用强化学习模型根据业务场景自动调整相似性阈值(如客服高峰时降低阈值,提高命中率);

- 增量嵌入更新:当提示的意图发生变化时,自动更新嵌入向量(无需重新生成所有向量);

- 大模型内置缓存:未来的大模型(如GPT-5)可能内置缓存机制,直接返回重复提示的结果(减少外部缓存的复杂度)。

7. 综合与拓展:提示缓存的“战略价值”

7.1 跨领域应用:从客服到代码生成

提示缓存的价值不仅限于客服场景,还可应用于:

- 代码生成:缓存常见代码片段的提示(如“生成Python的快速排序函数”);

- 内容创作:缓存固定主题的提示(如“写一篇关于AI伦理的文章大纲”);

- 数据分析:缓存重复的SQL查询提示(如“统计上月的销售额”)。

7.2 研究前沿:提示缓存的学术进展

当前学术领域的研究重点包括:

- 多模态提示缓存:处理文本+图像的提示(如“描述这张图片的内容”);

- 联邦缓存:多个企业共享缓存(如电商行业共享“退货政策”的提示结果);

- 量子缓存:用量子计算加速向量相似性检索(理论上可将检索时间从O(logN)降至O(1))。

7.3 开放问题:等待解决的挑战

- 如何动态平衡“命中率”与“准确性”?

- 如何处理多轮对话中的“上下文依赖”提示?

- 如何实现“零信任”的缓存安全?

7.4 战略建议:企业的提示缓存之路

- 建立提示管理平台:统一管理提示模板、缓存策略、模型版本,避免“散兵游勇”式的缓存设计;

- 培养提示工程架构师:需要既懂大模型原理,又懂缓存架构的复合型人才;

- 持续迭代缓存策略:缓存不是“一劳永逸”的,需根据业务变化定期优化。

结语:提示缓存是“工程思维”的胜利

提示缓存的本质,是用工程手段解决大模型的“计算效率”问题——它不依赖于模型的改进,而是通过对“重复劳动”的复用,直接释放大模型的商业价值。对于提示工程架构师而言,设计优秀的缓存系统,不仅需要掌握大模型的原理,更需要具备“从问题到方案”的工程思维:

- 用第一性原理推导价值;

- 用分层架构平衡性能与复杂度;

- 用数据驱动优化迭代。

当你能将这些思维融入缓存设计时,你将不仅是“缓存的实现者”,更是“大模型成本的掌控者”——这,就是提示工程架构师的核心价值。

参考资料(优先权威来源):

- OpenAI. (2024). GPT-4 Pricing and Usage Guidelines.

- Pinecone. (2024). Vector Database Best Practices.

- Redis Labs. (2024). Distributed Cache Design Patterns.

- Liang, X., et al. (2023). Semantic Cache for Large Language Models. arXiv:2305.03281.

- LangChain. (2024). CacheBackedLLM Documentation.

更多推荐

已为社区贡献28条内容

已为社区贡献28条内容

所有评论(0)