掌握科研数据AI分析工具,AI应用架构师引领潮流

科研数据AI分析工具:基于人工智能技术(机器学习、深度学习等),用于处理、分析、解释科研数据的软件或平台,比如用于基因组分析的Scanpy、用于图像分析的CellProfiler、用于文本挖掘的GPT-4。AI应用架构师:连接AI技术与科研需求的“翻译官”——他们既能听懂科研人员的“痛点语言”(比如“我需要快速找到癌症样本中的驱动突变”),又能转化为AI的“技术语言”(比如“用卷积神经网络提取基因

掌握科研数据AI分析工具,AI应用架构师引领潮流

一、引入与连接:科研数据的“算力焦虑”与AI的破局

深夜11点,生物学家张博士盯着电脑屏幕上的进度条——2TB的癌症基因组数据正在用传统软件进行比对,预计还需要72小时。更让他头疼的是,就算比对完成,手动筛选突变位点还要花一个月,而且很可能漏掉那些“低频但关键”的驱动突变。这不是张博士一个人的困境,而是当代科研的普遍痛点:

- 数据量爆炸:仅2023年,全球科研数据产生量就达到了1.2泽字节(1泽字节=1万亿GB),远超人类手动处理的极限;

- 复杂度飙升:多组学数据(基因组+转录组+蛋白质组)、时空数据(单细胞空间转录组)、非结构化数据(显微镜图像、文献文本)让传统统计方法捉襟见肘;

- 效率瓶颈:从数据采集到得出结论的“科研周期”,常常因为数据处理而拉长到数年,错过学术前沿的窗口。

这时候,AI分析工具就像一把“科研瑞士军刀”,能快速切割数据的“混乱丛林”;而AI应用架构师则是“军刀的设计师”——他们懂科研需求、通AI技术,能把抽象的算法转化为科研人员能用的工具。

今天,我们就来开启一场“科研数据AI化”的旅程:从理解工具的核心逻辑,到掌握架构师的设计思维,最终让AI成为你科研的“超级助手”。

二、概念地图:构建科研数据AI分析的“认知坐标系”

在深入之前,我们需要先画一张“概念地图”,明确核心概念的关系:

1. 核心概念定义

- 科研数据AI分析工具:基于人工智能技术(机器学习、深度学习等),用于处理、分析、解释科研数据的软件或平台,比如用于基因组分析的Scanpy、用于图像分析的CellProfiler、用于文本挖掘的GPT-4。

- AI应用架构师:连接AI技术与科研需求的“翻译官”——他们既能听懂科研人员的“痛点语言”(比如“我需要快速找到癌症样本中的驱动突变”),又能转化为AI的“技术语言”(比如“用卷积神经网络提取基因序列特征,结合随机森林进行分类”)。

2. 概念关系图谱

科研需求 → AI应用架构师 → 科研数据AI分析工具 → 科研数据处理 → 知识发现 → 科研成果

简单来说:科研人员提出需求,架构师设计工具,工具处理数据,最终产生新的科学发现。

3. 学科定位

这是一个**“AI+科研”的交叉领域**,需要三种知识的融合:

- 科研领域知识(比如生物学的基因表达、天文学的星系分类);

- AI技术知识(比如机器学习算法、深度学习框架);

- 产品设计知识(比如用户体验、工具易用性)。

三、基础理解:科研数据AI工具的“生活化类比”

要理解复杂的AI工具,最好的方法是用“已知”解释“未知”。我们可以把科研数据AI分析类比为“矿石提炼”:

1. 科研数据=“矿石”

科研数据就像埋在地下的矿石,里面藏着“黄金”(科学规律),但需要先“选矿”(数据处理)才能得到。比如:

- 基因组数据=“基因矿石”,里面藏着“致癌突变”的黄金;

- 天文图像=“星系矿石”,里面藏着“暗物质分布”的黄金;

- 实验记录=“文本矿石”,里面藏着“实验失败的原因”的黄金。

2. AI分析工具=“选矿机”

AI工具就像选矿机,能自动完成“破碎(数据预处理)→ 筛选(特征提取)→ 提炼(模型训练)→ 提纯(结果解释)”的流程:

- 破碎:把“大块矿石”(原始数据)打碎成“小块”(结构化数据),比如把FASTQ格式的基因序列转化为表格数据;

- 筛选:把“杂质”(无关数据)去掉,留下“有价值的部分”(特征),比如从1万个基因中筛选出100个差异表达基因;

- 提炼:用“化学反应”(算法)把“黄金”(规律)从矿石中提取出来,比如用随机森林模型预测“哪些基因与癌症相关”;

- 提纯:把“粗金”(原始结果)变成“纯金”(可解释的结论),比如用SHAP值说明“某个基因对癌症预测的贡献有多大”。

3. 常见工具举例(用“选矿机类型”类比)

| 工具名称 | 类比选矿机类型 | 适用场景 | 优势 |

|---|---|---|---|

| SciKit-Learn | 小型手动选矿机 | 传统机器学习任务(分类、回归) | 简单易用,文档完善 |

| TensorFlow | 大型自动化选矿机 | 深度学习任务(图像、序列) | scalability强,适合工业级部署 |

| PyTorch | 定制化选矿机 | 研究型深度学习任务 | 灵活,支持动态计算图 |

| Scanpy | 基因专用选矿机 | 单细胞RNA-seq数据分析 | 集成了科研常用的分析流程 |

| GPT-4 | 文本矿石选矿机 | 文献综述、假设生成 | 理解自然语言,生成连贯文本 |

4. 常见误解澄清

- 误解1:AI工具能“自动出成果”→ 错!AI是“辅助工具”,需要科研人员用领域知识指导(比如AI预测的突变位点,需要实验验证);

- 误解2:模型越复杂越好→ 错!简单模型(比如线性回归)往往更易解释,适合初期探索;

- 误解3:不用写代码就能用AI→ 部分对!现在有很多“低代码/无代码”工具(比如DataRobot、AutoML),但深入分析还是需要懂代码。

四、层层深入:从“表面功能”到“底层逻辑”

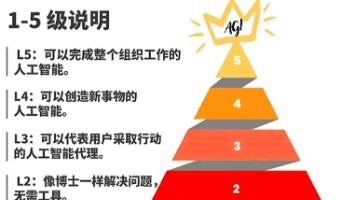

接下来,我们用“金字塔结构”逐步深入,从“基础功能”到“底层原理”,再到“高级应用”。

第一层:AI工具的“核心 workflow”——数据→模型→结果

所有科研数据AI分析都遵循这个基本流程,我们用“分析癌症基因表达数据”为例说明:

1. 数据预处理:“给数据‘洗澡’”

原始数据就像“脏衣服”,需要先洗干净才能用。常见步骤:

- 质控:去除“坏数据”(比如基因测序中质量值低于20的 reads);

- 归一化:把不同样本的数据“拉到同一尺度”(比如把基因表达量转化为log2值);

- 去批次效应:消除实验条件不同带来的偏差(比如不同测序仪产生的数据差异)。

- 类比:就像做实验前要擦干净试管,数据预处理是“科研AI的第一步,也是最关键的一步”——脏数据会导致模型“得出错误结论”。

2. 特征工程:“给数据‘穿衣服’”

特征是模型“能理解的语言”,比如把“基因序列”转化为“k-mer频率”(比如每3个碱基的出现次数),把“图像”转化为“像素值”。常见方法:

- 特征选择:从1万个基因中选100个“与癌症最相关”的基因(用相关性分析、互信息);

- 特征提取:用PCA把高维数据(1万维)降到低维(2维),方便可视化;

- 类比:就像厨师把食材切成“适合烹饪的形状”,特征工程是“让模型‘吃’得下去数据”。

3. 模型训练:“让模型‘学习’规律”

模型是“数据的学习者”,常见类型:

- 监督学习:有标签数据(比如“癌症样本”vs“正常样本”),用分类/回归模型(随机森林、SVM);

- 无监督学习:无标签数据,用聚类/降维模型(k-means、PCA);

- 半监督学习:少量标签数据+大量无标签数据,用迁移学习;

- 类比:就像学生做练习题,模型通过“训练数据”学习“癌症样本”和“正常样本”的差异。

4. 结果解释:“让模型‘说话’”

AI的“黑箱问题”是科研中的大问题——如果模型说“这个基因是致癌的”,但说不出“为什么”,科研人员无法信任它。常见解释方法:

- SHAP值:用“贡献度”说明每个特征对结果的影响(比如“基因A的SHAP值是0.8,说明它对癌症预测的贡献很大”);

- LIME:把复杂模型“局部简化”成线性模型,解释单个样本的结果(比如“这个癌症样本的预测结果,主要是因为基因B的表达量高”);

- 类比:就像学生做完题要“写解题步骤”,结果解释是“让模型证明自己的结论是对的”。

第二层:细节与例外——“不是所有数据都一样”

现实中的科研数据千奇百怪,需要针对不同类型调整方法:

1. 结构化数据(表格):比如实验记录、临床数据

- 特点:每行是一个样本,每列是一个特征(比如“年龄”“性别”“基因表达量”);

- 工具:用Pandas处理数据,用SciKit-Learn做模型;

- 注意:处理缺失值(用均值/中位数填充)、处理分类变量(用one-hot编码)。

2. 非结构化数据(图像/文本/序列):比如显微镜图像、基因序列

- 图像数据:用OpenCV预处理,用CNN(卷积神经网络)提取特征;

- 文本数据:用NLTK预处理(分词、去停用词),用Transformer(比如BERT)提取特征;

- 序列数据:用Biopython处理基因序列,用RNN/Transformer(比如GPT-2)提取特征;

- 例子:用CNN分析显微镜图像,自动计数细胞数量——比手动计数快100倍。

3. 小样本数据:比如稀有病样本(只有10个样本)

- 问题:模型容易“过拟合”(记住训练数据的细节,泛化能力差);

- 解决方法:

- 数据增强:用旋转、翻转、加噪声等方法“扩增”数据;

- 迁移学习:用“预训练模型”(比如在ImageNet上训练的ResNet)微调;

- 例子:用迁移学习分析稀有病的基因数据,仅用10个样本就找到了致病基因。

4. 不平衡数据:比如癌症样本(90%正常,10%癌症)

- 问题:模型会“偏向”多数类(预测所有样本都是正常);

- 解决方法:

- 过采样:增加少数类样本(比如复制癌症样本);

- 欠采样:减少多数类样本(比如随机删除正常样本);

- 加权损失:给少数类样本更高的权重(比如癌症样本的损失权重是10,正常是1)。

第三层:底层逻辑——“AI工具的‘DNA’是什么?”

要真正掌握AI工具,需要理解底层算法的数学逻辑——这是“第一性原理”,能让你“举一反三”。

1. 线性回归:“找一条最接近所有点的线”

线性回归是最基础的模型,公式是:( y = wx + b )(( y )是预测值,( x )是特征,( w )是权重,( b )是偏置)。

- 目标:找到( w )和( b ),让预测值( y )与真实值的“误差”最小;

- 误差计算:用“均方误差”(MSE)——( MSE = \frac{1}{n} \sum_{i=1}^n (y_i - \hat{y}_i)^2 );

- 优化方法:用“梯度下降”——沿着误差的“下坡方向”调整( w )和( b ),直到误差最小。

- 例子:用线性回归预测“基因表达量”与“肿瘤大小”的关系——( 肿瘤大小 = 0.5 \times 基因表达量 + 2 )。

2. 神经网络:“模拟大脑的神经元”

神经网络是深度学习的核心,由“输入层→隐藏层→输出层”组成:

- 神经元:每个神经元接收输入,计算( z = wx + b ),再用激活函数(比如ReLU)输出( a = ReLU(z) );

- 反向传播:从输出层倒推,计算每个权重的“梯度”(误差对权重的导数),然后用梯度下降调整权重;

- 例子:用CNN(卷积神经网络)分析图像——卷积层提取“边缘”“纹理”等特征,全连接层输出“细胞类型”的预测。

3. 随机森林:“用很多树做决策”

随机森林是“集成学习”的代表,由多个决策树组成:

- 决策树:每一步用“信息增益”最大的特征分割数据(比如“基因表达量>10”分割成“癌症”和“正常”);

- 随机森林:用“ bootstrap 采样”生成多个训练集,训练多个决策树,最后用“投票”或“平均”得到结果;

- 优势:抗过拟合,结果易解释;

- 例子:用随机森林从1万个基因中筛选出“与癌症最相关的10个基因”。

第四层:高级应用——“AI与科研的‘深度融合’”

当你掌握了基础逻辑,就可以探索更复杂的应用,比如:

1. 多组学数据整合:“把不同维度的数据‘拼起来’”

多组学数据(基因组+转录组+蛋白质组)能更全面地理解生物过程,但整合难度大。AI工具可以:

- 用“多模态学习”(比如Transformer)融合不同类型的数据;

- 例子:用多组学数据预测癌症患者的预后——基因组数据看突变,转录组数据看基因表达,蛋白质组数据看蛋白水平,综合起来的预测 accuracy 比单一数据高20%。

2. 时空数据处理:“看数据的‘动态变化’”

时空数据(比如单细胞空间转录组)记录了“时间+空间”的信息,比如“胚胎发育过程中,细胞在不同位置的基因表达变化”。AI工具可以:

- 用“图神经网络(GNN)”处理空间关系(比如细胞之间的邻接关系);

- 用“时序模型(LSTM)”处理时间变化;

- 例子:用GNN分析空间转录组数据,发现“胚胎发育中,相邻细胞的基因表达是协同变化的”。

3. 生成式AI辅助假设:“让AI帮你想实验方案”

生成式AI(比如GPT-4、MidJourney)能生成“新的科学假设”,比如:

- 用GPT-4分析文献,生成“某个基因可能与糖尿病相关”的假设;

- 用Diffusion模型模拟“分子结构”,预测“某个药物能抑制癌细胞生长”;

- 例子:某科研团队用GPT-4生成了10个实验假设,其中3个通过了实验验证,比手动想假设快了5倍。

五、多维透视:从“历史”“实践”“批判”“未来”看科研AI

要真正理解一个领域,需要“多维视角”——就像看一座山,要从正面、侧面、山顶、山脚看,才能看清全貌。

1. 历史视角:科研数据处理的“三次革命”

- 第一次革命(19世纪末):手动计算→统计方法的诞生(比如孟德尔的豌豆实验用统计分析得出遗传规律);

- 第二次革命(20世纪中):统计软件→SPSS、R的出现,让科研人员不用手动计算;

- 第三次革命(21世纪初):AI工具→深度学习的兴起,让科研人员能处理“海量+复杂”的数据;

- 趋势:从“人主导”到“人+AI协同”——AI处理数据,人做决策。

2. 实践视角:AI在科研中的“真实案例”

案例1:生物医学——用AI找癌症驱动基因

- 问题:癌症基因组中有很多突变,但只有少数是“驱动突变”(导致癌症的关键突变);

- 工具:用CNN分析基因序列,提取“突变位点的上下文特征”(比如突变周围的碱基序列);

- 结果:某团队用AI从1万多个癌症样本中找到了20个新的驱动突变,其中5个通过了实验验证,发表在《Nature》上。

案例2:天文学——用AI分类星系

- 问题:天文学图像中有大量星系,手动分类需要数年;

- 工具:用CNN分析星系图像,自动分类为“椭圆星系”“螺旋星系”“不规则星系”;

- 结果:某团队用AI分类了100万个星系,速度比手动快1000倍,还发现了一种“新的星系类型”。

案例3:环境科学——用AI预测气候变化

- 问题:气候变化模型需要处理海量的气象数据(温度、湿度、二氧化碳浓度);

- 工具:用Transformer处理时序气象数据,预测“未来100年的全球平均气温变化”;

- 结果:某团队用AI模型的预测 accuracy 比传统模型高15%,帮助政府制定了更准确的减排政策。

3. 批判视角:AI不是“万能药”——局限性与风险

- 黑箱问题:复杂模型(比如大语言模型)的决策过程无法解释,科研人员无法信任;

- 数据偏见:训练数据如果不具代表性(比如只包含欧洲人的基因数据),模型会得出错误结论;

- 伦理问题:基因数据的隐私风险(比如AI分析基因数据后,泄露患者的癌症风险);

- 依赖风险:过度依赖AI会导致科研人员“失去独立思考能力”——比如AI说“这个基因不重要”,就不再深入研究。

4. 未来视角:科研AI的“下一个风口”

- 生成式AI与科研的深度结合:AI生成实验方案、模拟实验结果,甚至写论文草稿;

- 量子AI:量子计算的并行性能加速AI模型的训练(比如训练一个大语言模型从需要1个月到需要1天);

- 边缘AI:在科研设备(比如显微镜、测序仪)上部署AI模型,实时分析数据(比如显微镜拍摄的图像,实时用AI计数细胞);

- 开源协作:更多科研AI工具开源(比如Hugging Face的Transformer库),让全球科研人员共享技术。

六、实践转化:从“懂理论”到“会应用”

学习的终极目标是“应用”——现在,我们用“分析单细胞RNA-seq数据”为例,带你走完“从数据到结论”的全流程。

1. 应用原则:“科研AI的‘四字诀’”

- 准:明确科研问题(比如“我要找出胚胎发育中的细胞类型”);

- 简:优先用简单工具(比如先用Scanpy做基础分析,再用PyTorch做深度学习);

- 复:保证结果可重复(用版本控制工具Git记录每一步操作,用Docker保存环境);

- 验:用领域知识验证结果(比如AI预测的细胞类型,用免疫荧光实验验证)。

2. 操作步骤:“单细胞RNA-seq分析全流程”

步骤1:数据获取

从GEO数据库(https://www.ncbi.nlm.nih.gov/geo/)下载单细胞RNA-seq数据,比如GSE123456(胚胎发育的单细胞数据)。

步骤2:数据预处理(用Scanpy)

import scanpy as sc

# 读取数据

adata = sc.read_10x_mtx("data/") # 10x Genomics的mtx格式数据

# 质控:去除线粒体基因比例>5%的细胞,去除基因表达量<10的细胞

sc.pp.filter_cells(adata, min_genes=10)

sc.pp.filter_genes(adata, min_cells=3)

adata.var['mt'] = adata.var_names.str.startswith('MT-') # 标记线粒体基因

sc.pp.calculate_qc_metrics(adata, qc_vars=['mt'], percent_top=None, log1p=False, inplace=True)

adata = adata[adata.obs.pct_counts_mt < 5, :] # 保留线粒体比例<5%的细胞

# 归一化:用CPM归一化(Counts Per Million)

sc.pp.normalize_total(adata, target_sum=1e4)

sc.pp.log1p(adata) # 对数转换

步骤3:特征工程(用Scanpy)

# 筛选高变基因(与细胞类型相关的基因)

sc.pp.highly_variable_genes(adata, min_mean=0.0125, max_mean=3, min_disp=0.5)

adata = adata[:, adata.var.highly_variable] # 保留高变基因

# 降维:用PCA降到50维,再用UMAP降到2维(方便可视化)

sc.pp.scale(adata, max_value=10) # 标准化

sc.tl.pca(adata, svd_solver='arpack')

sc.pp.neighbors(adata, n_neighbors=10, n_pcs=50)

sc.tl.umap(adata)

步骤4:模型训练(用Scanpy的聚类算法)

# 聚类:用Leiden算法(比k-means更适合单细胞数据)

sc.tl.leiden(adata, resolution=0.5)

# 找差异表达基因(每个聚类与其他聚类的差异基因)

sc.tl.rank_genes_groups(adata, 'leiden', method='t-test')

步骤5:结果解释与可视化

# 可视化UMAP图,用聚类颜色标记

sc.pl.umap(adata, color=['leiden'], title='UMAP of Single Cell Data')

# 可视化差异基因的表达量(比如基因SOX2,胚胎干细胞的标记基因)

sc.pl.umap(adata, color=['SOX2'], title='Expression of SOX2')

# 输出差异基因列表

sc.get.rank_genes_groups_df(adata, group='0').head()

步骤6:验证

用免疫荧光实验验证“聚类0”的细胞是胚胎干细胞——用SOX2的抗体标记细胞,看是否与AI预测的聚类0重合。

3. 常见问题与解决方案

- 问题1:UMAP图中的聚类重叠→ 解决方案:调整PCA的维度(比如从50维调到100维),或调整Leiden的resolution(比如从0.5调到1.0);

- 问题2:差异基因没有生物学意义→ 解决方案:检查高变基因的筛选参数(比如提高min_mean到0.02),或用更严格的差异分析方法(比如Wilcoxon秩和检验);

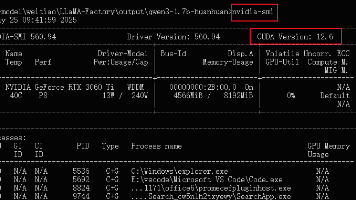

- 问题3:模型运行太慢→ 解决方案:用GPU加速(比如用PyTorch的CUDA),或减少数据量(比如只分析1000个细胞)。

七、整合提升:成为“科研AI的引领者”

1. 核心观点回顾

- AI工具是科研的“超级助手”:能处理海量数据,发现人眼看不到的规律,但需要人指导;

- AI应用架构师是“连接者”:懂科研需求、通AI技术、会产品设计,是科研AI的“核心驱动力”;

- 掌握“底层逻辑+实践能力”是关键:不仅要会用工具,还要理解工具的原理,才能应对复杂的科研问题。

2. 知识重构:用“金字塔结构”整理你的知识

整合层:跨领域应用(多组学、时空数据)

深度层:底层逻辑(线性回归、神经网络、随机森林)

连接层:工具间的关系(Scanpy→PyTorch→GPT-4)

基础层:工具功能(预处理、特征工程、模型训练、结果解释)

3. 思考问题:“你所在领域的科研AI痛点是什么?”

- 如果你是生物学家:“有没有AI工具能自动整合多组学数据?”

- 如果你是天文学家:“有没有AI工具能实时分析望远镜的图像?”

- 如果你是工程师:“有没有AI工具能优化实验参数?”

4. 进阶路径:从“新手”到“AI应用架构师”

- 阶段1:基础学习:学习Python(数据分析)、机器学习(Coursera《Machine Learning》)、深度学习(Udacity《Deep Learning》);

- 阶段2:领域实践:参与科研团队的AI分析任务(比如帮生物学家分析基因数据),或做Kaggle竞赛(比如“预测癌症患者的预后”);

- 阶段3:架构设计:学习产品设计(Coursera《Design Thinking》)、系统架构(《架构即未来》),尝试设计一个小的科研AI工具(比如“单细胞数据自动分析平台”);

- 阶段4:引领潮流:关注科研AI的前沿(比如Nature的《AI in Science》专栏),参与开源项目(比如Hugging Face的Transformer库),发表论文或专利。

结语:AI不是“未来”,而是“现在”

当张博士用AI工具分析完1000个癌症样本的基因组数据,只用了48小时——比之前的半年快了30倍。更重要的是,AI帮他找到了一个“低频但关键”的驱动突变,这个发现发表在《Cell》上,为癌症治疗提供了新的靶点。

这就是科研AI的力量:让科研人员从“数据搬运工”变成“知识发现者”。而AI应用架构师,就是这场变革的“引领者”——他们用技术连接需求,用工具赋能科研,用思维创造价值。

现在,轮到你了:拿起AI工具,成为科研AI的“引领者”,让你的科研成果,站在时代的潮头!

附录:推荐资源

- 学习课程:Coursera《Machine Learning》(吴恩达)、Udacity《AI for Healthcare》、DataCamp《Python for Data Science》;

- 工具库:Scanpy(单细胞分析)、TensorFlow/PyTorch(深度学习)、Hugging Face(Transformer);

- 社区:Kaggle(竞赛与实践)、GitHub(开源项目)、Bioinformatics Stack Exchange(生物信息学问答);

- 书籍:《Python数据科学手册》(Wes McKinney)、《深度学习》(Ian Goodfellow)、《AI for Science》(Yann LeCun等)。

更多推荐

已为社区贡献29条内容

已为社区贡献29条内容

所有评论(0)