大显存显卡全面解析:从 8K 视频剪辑到 AI 模型训练的实战经验

大显存显卡不仅仅是一种硬件升级,更是高负载任务的“命门保障”。对于 8K 剪辑,它决定了画面的流畅度与创作效率;对于 AI 训练,它决定了模型规模与训练速度。未来几年,无论是影视行业还是人工智能领域,大显存显卡都将是必不可少的生产力工具。如果你正面临显存不足的困扰,不妨从硬件升级和优化技巧两方面着手,让显卡真正释放潜能。

在过去十年里,显卡的角色已经从“游戏利器”演变为“生产力核心”。尤其是在影视后期和人工智能领域,显卡的性能与显存大小,直接决定了生产效率和技术边界。很多创作者和工程师都有过这样的经历:明明显卡算力不弱,但在 8K 视频项目或 AI 模型训练中频繁卡顿、报错,最后发现问题根源在显存不足。

显存(VRAM)的重要性正在被越来越多的人重视。本文将从原理、场景、硬件选择、优化技巧、案例和未来趋势六大部分,全面解析“大显存”的价值,并提供实战经验,帮助你在高负载环境下高效工作。

一、显存的本质与作用

显存是显卡上的专用存储器,主要负责存放渲染所需的数据,包括:

-

视频帧数据

-

模型参数与梯度

-

中间计算缓存

-

纹理、特效、光影数据

它的工作原理与电脑内存类似,但速度更快,延迟更低。

显存不足会带来什么问题?

-

在视频剪辑中:掉帧、预览卡顿、导出失败。

-

在 AI 训练中:Batch size 降低、训练效率下降、频繁出现 OOM(Out of Memory)。

一句话总结:显卡的算力是“马力”,显存则是“油箱”。油箱太小,再快的车也跑不远。

二、8K 视频剪辑对显存的需求

1. 为什么 8K 剪辑如此“吃显存”?

-

分辨率超高:8K 分辨率为 7680×4320,是 4K 的 4 倍,是 1080p 的 16 倍。

-

帧数据庞大:一秒钟 30 帧,原始素材体量极其惊人。

-

多轨道与特效:在非线性剪辑软件中,多轨叠加、调色、转场、特效都需要更多缓存空间。

2. 软件显存占用情况

-

Adobe Premiere Pro:项目越大,缓存越多,显存需求激增。

-

DaVinci Resolve:调色节点复杂时,显存占用可能飙升。

-

After Effects:合成和特效渲染几乎是显存“黑洞”。

结论:8GB 显存只能勉强做 4K 项目,8K 项目至少需要 24GB 才能流畅运行,48GB 更加稳妥。

三、AI 模型训练的显存瓶颈

1. 模型规模的爆炸性增长

-

ResNet-50(经典 CV (*.www.tangclouds.com/post/262.html.*)模型):几乎任何显卡都能跑。

-

GPT-3、LLaMA、Stable Diffusion XL:参数量上百亿,显存需求超过 40GB。

2. 显存使用的三大部分

-

模型参数存储

-

参数量越大,显存占用越高。

-

-

前向计算缓存

-

每一层的中间结果都需要保存。

-

-

梯度与优化器状态

-

训练需要存储梯度和优化器参数,显存翻倍增长。

-

3. OOM 错误的常见场景

-

Batch size 设置过大。

-

模型层数过深。

-

同时加载多个模型或任务。

四、大显存显卡的硬件选择

1. 消费级显卡

-

RTX 4090(24GB):消费级顶配,适合个人创作者和中小规模 AI 任务。

-

RTX 3090(24GB):二手市场热门,性价比高。

2. 专业级显卡

-

RTX A6000(48GB):影视后期和企业 AI 训练首选。

-

Quadro 系列:驱动稳定,适合大型工作站。

3. 数据中心显卡

-

A100(40GB/80GB):科研和大模型训练标准配置。

-

H100(80GB+):面向未来的超大显存显卡,AI 领域梦幻选择。

五、显存优化的实战技巧

1. 针对视频剪辑

-

使用代理文件:低分辨率代理文件编辑,导出时回到 8K 源文件。

-

优化缓存目录:放到 NVMe SSD 上,读写更快。

-

分层渲染:复杂项目先分段渲染,再合成最终版本。

2. 针对 AI 训练

-

混合精度训练(AMP):FP16 精度可减少一半显存占用。

-

梯度检查点:用计算换空间,减少缓存显存。

-

梯度累积:通过多次小 batch 累积,实现大 batch 效果。

-

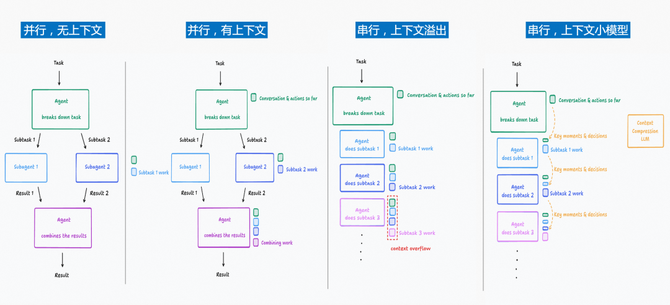

模型并行/数据并行:在多卡上分散显存负担。

3. 系统层面优化

-

内存(RAM)至少 32GB,推荐 64GB。

-

电源与散热要充足,避免显卡因过热降频。

-

合理分配任务,避免显卡资源被无关程序占用。

六、实战案例分享

1. 影视工作室案例

某纪录片工作室在 8K 项目中使用 RTX 3080(10GB 显存),结果预览卡顿严重。升级到 RTX 4090(24GB)后,配合代理文件和 SSD 缓存,剪辑流畅度提升 300%,最终导出时间缩短一半。

2. AI 研究团队案例

某高校实验室在训练 LLaMA 模型时,原先使用 3090(24GB),batch size 只能设置为 1,训练效率极低。后来换成 A100(80GB),不仅 batch size 提升到 8,训练速度也提高了近 5 倍。

七、未来趋势

-

显存普及化:消费级显卡显存容量不断扩大,未来 32GB 显卡可能成为常见配置。

-

软件智能化:视频剪辑软件和 AI 框架会进一步优化显存利用率,让用户在有限显存下完成更大任务。

-

硬件专业化:数据中心级显卡将向 128GB 显存演进,以支撑更复杂的 AI 模型。

八、结语

大显存显卡不仅仅是一种硬件升级,更是高负载任务的“命门保障”。对于 8K 剪辑,它决定了画面的流畅度与创作效率;对于 AI 训练,它决定了模型规模与训练速度。

未来几年,无论是影视行业还是人工智能领域,大显存显卡都将是必不可少的生产力工具。如果你正面临显存不足的困扰,不妨从硬件升级和优化技巧两方面着手,让显卡真正释放潜能。

更多推荐

已为社区贡献8条内容

已为社区贡献8条内容

所有评论(0)