分布式训练框架DeepSpeed与Megatron

本文对比了四大AI训练工具的核心特点:DeepSpeed(微软)以ZeRO技术优化显存和速度,适合大模型训练;Colossal-AI(国产)通过自动并行策略降低训练门槛;Megatron-LM(NVIDIA)针对GPU深度优化语言模型训练;Hugging Face提供完整AI生态,适合快速原型开发。选择建议:追求效率选DeepSpeed/Megatron-LM,注重易用性选Hugging Face

下面这个表格汇总了 DeepSpeed、Colossal-AI、Megatron-LM 和 Hugging Face 这四大工具的核心特点,方便你快速对比和建立整体认知。

| 工具名称 | 主要开发方 | 核心目标 | 技术亮点 | 典型应用场景 |

|---|---|---|---|---|

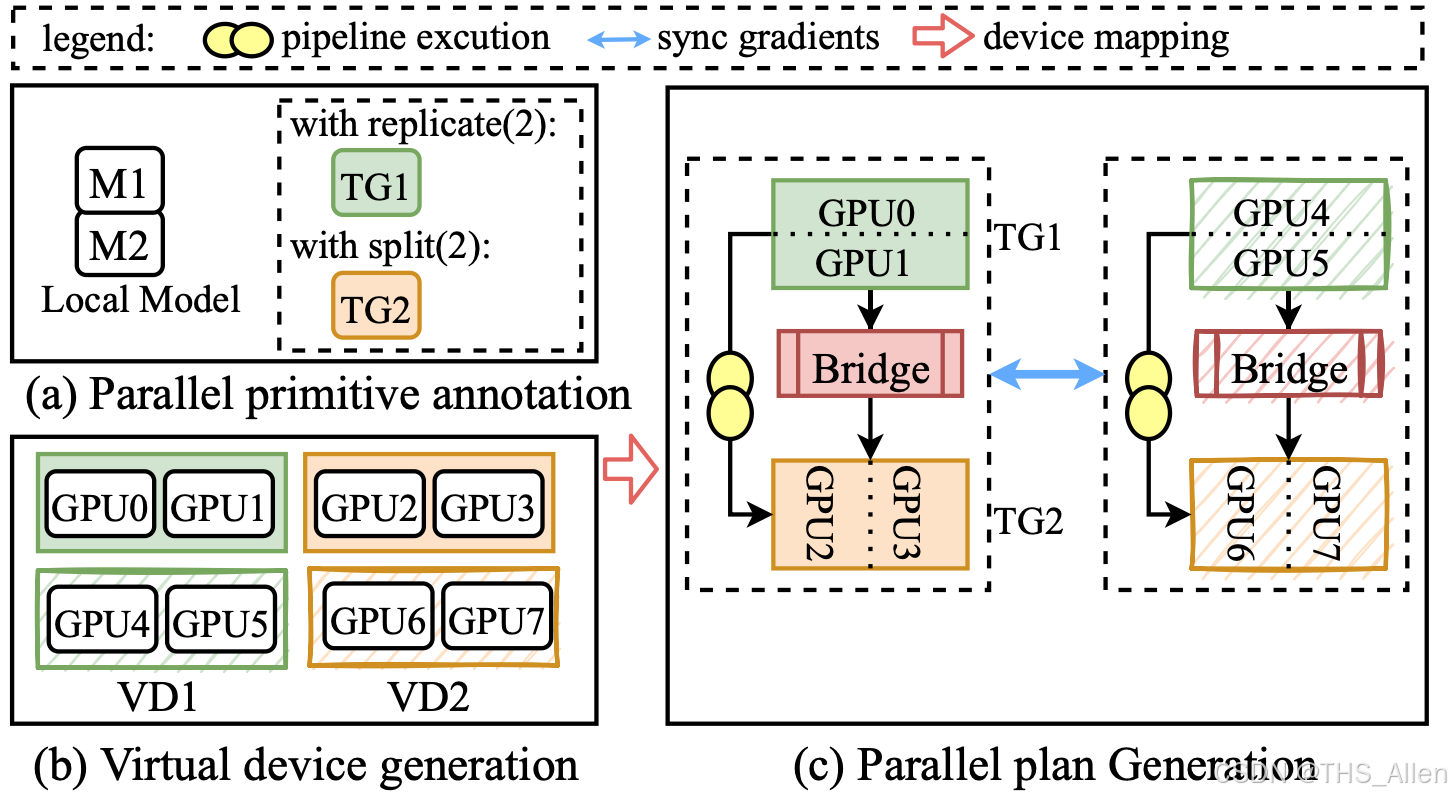

| DeepSpeed | Microsoft | 极致优化训练效率与规模,解决大模型训练中的显存和速度瓶颈。 | ZeRO 系列技术(阶段1-3、Offload)、融合CUDA内核、3D并行。 | 训练百亿/千亿参数大模型、在有限资源(如单卡)下进行大模型微调。 |

| Colossal-AI | 潞晨科技(国产) | 降低大规模分布式训练的门槛,实现高效且低成本的AI大模型训练。 | 自动搜索并行策略、多维混合并行、显存优化技术(如Flash Attention)。 | 追求高硬件利用率和降低训练成本、AIGC模型(如Stable Diffusion)训练与微调。 |

| Megatron-LM | NVIDIA (MT-MegatronLM为摩尔线程国产版本) | 实现大规模语言模型的高效训练,尤其针对NVIDIA GPU深度优化。 | 张量模型并行、高效的融合CUDA内核、FP8混合精度训练。 | 超大规模语言模型(如GPT系列)的预训练、对训练速度和硬件性能有极致要求的场景。 |

| Hugging Face | Hugging Face | ** democratize AI**,提供构建、训练和部署AI模型(尤其是NLP)的完整平台和生态。 | Transformers 库(海量预训练模型)、Datasets 库、Hub 模型仓库、友好的API。 | 模型快速原型设计、实验与微调、利用预训练模型进行推理部署、AI社区协作与共享。 |

|

💡 如何选择适合你的工具

了解了它们各自的特点后,你可以根据具体目标来决定使用哪个工具:

-

追求快速上手、实验和微调模型:Hugging Face 是你的不二之选。其丰富的预训练模型和简洁的API能让你专注于模型本身,而非底层工程细节。

-

需要训练或微调非常大的模型,且对效率和规模有极高要求:

- DeepSpeed 特别适合当你受限于GPU显存时,它的ZeRO和Offload技术能让你在有限的硬件上完成原本不可能的任务。

- Colossal-AI 的优势在于其自动化和高效率,旨在通过自动并行策略和显存优化,帮助用户以更低的成本进行大规模训练。

- Megatron-LM 则在极致性能上表现突出,尤其在与NVIDIA硬件结合时,能为超大规模模型训练提供顶尖的速度。

-

应对特别复杂的模型架构(如MoE):Colossal-AI和MT-MegatronLM等框架对混合专家模型有专门的优化和支持。

-

组合使用是常见策略:在实际工业级应用中,这些工具常常被组合起来使用,形成强大的技术栈。一个典型的例子就是 “PyTorch + DeepSpeed + Megatron-LM” ,利用PyTorch的灵活性、DeepSpeed的优化器以及Megatron-LM的高效并行能力。

💎 简单总结

总的来说,这四个项目虽然都在AI大模型的领域内,但侧重点不同:

- Hugging Face 是一个全面的平台和生态,旨在让所有人都能更容易地使用AI。

- DeepSpeed、Colossal-AI 和 Megatron-LM 则更像是底层引擎或高性能工具包,专注于解决训练大规模模型时遇到的分布式、并行化和显存管理等核心系统级难题。

希望这些介绍能帮助你更好地理解它们。如果你有更具体的应用场景(比如你想训练什么类型的模型,硬件资源如何),我可以尝试提供更细致的建议。

更多推荐

已为社区贡献14条内容

已为社区贡献14条内容

所有评论(0)