Agentic AI上下文工程隐私保护,提示工程架构师的进阶之路

医疗AI助手可能把患者的“糖尿病病历”直接放进回答;金融AI顾问可能顺口说出用户的“银行卡尾号”;企业内部AI可能泄露“下季度产品计划”。帮提示工程架构师解决Agentic AI的“上下文隐私泄露”问题——既要让AI保留足够的对话历史来“听懂用户”,又要让它“选择性失忆”,绝不泄露敏感信息。Agentic AI的上下文管理逻辑;隐私保护的技术路径(过滤、压缩、模糊处理);提示工程架构师的成长阶梯(

Agentic AI上下文隐私保护:提示工程架构师的进阶指南——从“漏嘴助手”到“守秘专家”

关键词:Agentic AI、上下文工程、隐私保护、提示工程、架构师进阶、数据安全、Prompt Engineering

摘要:当AI从“单次问答机”进化成“会攒记性的聊天伙伴”(Agentic AI),“记太多”反而成了新麻烦——它可能不小心泄露你说过的病历、银行卡号甚至公司机密。本文以“AI漏嘴”的生活场景为切口,用“机器人店员”的比喻拆解Agentic AI、上下文工程、隐私保护的核心逻辑,一步步讲解提示工程架构师如何从“让AI会聊天”进阶到“让AI会守秘”:从用正则表达式挡手机号的“初级防御”,到用NER模型识别病历的“中级策略”,再到用自适应系统平衡“聪明”与“守秘”的“高级艺术”。最后结合实战项目和未来趋势,帮你成为“既能让AI懂用户,又能让AI守规矩”的顶尖架构师。

背景介绍

目的和范围

在ChatGPT、Claude等Agentic AI普及的今天,“连续对话”成了核心能力——但**“记得太多”反而会闯祸**:

- 医疗AI助手可能把患者的“糖尿病病历”直接放进回答;

- 金融AI顾问可能顺口说出用户的“银行卡尾号”;

- 企业内部AI可能泄露“下季度产品计划”。

本文的核心目的是:帮提示工程架构师解决Agentic AI的“上下文隐私泄露”问题——既要让AI保留足够的对话历史来“听懂用户”,又要让它“选择性失忆”,绝不泄露敏感信息。

范围覆盖:

- Agentic AI的上下文管理逻辑;

- 隐私保护的技术路径(过滤、压缩、模糊处理);

- 提示工程架构师的成长阶梯(从初级到高级)。

预期读者

- 刚入门的提示工程师(想解决“AI漏嘴”问题);

- AI产品经理(要平衡“用户体验”和“数据安全”);

- 算法工程师(想扩展“上下文工程”的技术栈);

- 企业IT负责人(担心内部AI泄露机密)。

文档结构概述

本文像一本“AI守秘手册”,分五步帮你进阶:

- 故事引入:用“小明的社死现场”讲清“AI漏嘴”的痛点;

- 概念拆解:用“机器人店员”比喻讲透Agentic AI、上下文工程、隐私保护的关系;

- 原理深剖:用代码和数学公式讲清“如何让AI选择性失忆”;

- 实战项目:手把手教你做一个“守秘的AI医疗助手”;

- 进阶之路:从“初级防御”到“高级自适应”的成长路径。

术语表

核心术语定义

- Agentic AI:能自主管理对话历史、连续交互的AI系统(比如ChatGPT的“连续对话”模式),像“会攒记性的机器人店员”;

- 上下文工程:设计Agentic AI“该记什么、该忘什么、该怎么用历史对话”的规则体系(比如“店员要记住用户喜欢的咖啡口味,但不能记住银行卡号”);

- 隐私泄露:AI在输出中意外暴露用户/系统的敏感信息(比如“小明的糖尿病病历”);

- 提示工程架构师:设计Prompt和上下文规则,让AI“既准确又守规矩”的“AI编剧”。

相关概念解释

- 上下文窗口:Agentic AI能“记住”的对话历史长度(比如GPT-3.5的4k Token,相当于3000字);

- 敏感实体:需要保护的信息类型(姓名、手机号、病历、公司机密等);

- 模糊处理:用“[REDACTED]”或“某用户”代替敏感信息,既保护隐私又保留上下文连贯性。

缩略词列表

- NER:命名实体识别(Named Entity Recognition,识别文本中的敏感信息);

- Token:AI处理文本的基本单位(比如“小明”是1个Token,“糖尿病”是1个Token);

- GDPR:欧盟《通用数据保护条例》(全球最严隐私法规)。

核心概念与联系:从“漏嘴店员”到“守秘专家”

故事引入:小明的社死现场

小明是医院的实习医生,用AI助手帮写病历分析。他输入:

“患者小明,男,30岁,糖尿病史2年,目前服用二甲双胍,手机号13812345678。”

刚写完,同事喊他去拿报告。回来后,他问AI:

“刚才说的那味药副作用是什么?”

AI秒回:

“你提到的小明的糖尿病并发症用药二甲双胍的副作用是……”

旁边的护士抬头问:“小明?你自己有糖尿病?”小明瞬间社死——AI把他的真实姓名和病历直接“说”了出来!

这不是AI“故意”的,而是它的“记性太好”:Agentic AI会把所有对话历史存在“上下文窗口”里,回答时直接引用——但它不知道“哪些信息不能说”。

核心概念解释:像给小学生讲“机器人店员”

我们用“奶茶店的机器人店员”类比,把复杂概念变简单:

核心概念一:Agentic AI = 会攒记性的机器人店员

普通AI是“单次点单机器”:你问“珍珠奶茶多少钱?”,它回答“15元”,然后就“忘了”;

Agentic AI是“会攒记性的店员”:你昨天买过“少糖珍珠奶茶”,今天再问“还是上次的奶茶”,它会直接做“少糖珍珠”——它能记住对话历史,连续互动。

但“记性好”也有麻烦:如果你昨天说“我有糖尿病,只能喝少糖”,今天问“推荐什么奶茶?”,它可能说“你有糖尿病,推荐少糖清茶”——如果旁边有人,就泄露了你的隐私!

核心概念二:上下文工程 = 给店员定“记什么、忘什么”的规则

上下文工程就是“给机器人店员写手册”,比如:

- 要记的:用户的口味偏好(少糖、加珍珠)、历史点单记录;

- 要忘的:用户提到的“糖尿病”“银行卡号”;

- 怎么用:当用户说“还是上次的”,只引用“少糖珍珠”,不引用“糖尿病”。

简单说,上下文工程是**“管理AI记性的规则集”**——让AI“记对的事,忘错的事”。

核心概念三:隐私保护 = 让店员学会“选择性失忆”

隐私保护是上下文工程里的“禁忌条款”,比如手册里写:

“如果用户提到‘姓名、病历、银行卡号’,绝对不能出现在回答里,要用‘某顾客’‘相关信息’代替。”

就像你告诉店员:“我刚才说的‘我有糖尿病’,你别告诉别人哦!”店员会记住“不能说”,但还是能根据“少糖”的需求推荐奶茶——隐私保护不是“全忘”,而是“不说敏感信息”。

核心概念之间的关系:AI、规则、守秘的“三角游戏”

我们用“电影拍摄”类比三者的关系:

- Agentic AI是“演员”:要按剧本演(连续互动);

- 上下文工程是“剧本”:规定演员“该说什么、该记什么”;

- 隐私保护是“剧本里的‘不能说’清单”:比如“不能提主角的绝症”;

- 提示工程架构师是“编剧”:既要让剧本好看(AI准确回答),又要让演员不违规(不泄露隐私)。

举个例子:

- 演员(AI)要演“奶茶店员”;

- 编剧(架构师)写剧本(上下文工程):“记住用户的口味,但不能提用户的糖尿病”;

- 剧本里的禁忌(隐私保护):“如果用户说‘我有糖尿病’,回答时要用‘您的饮食需求’代替”。

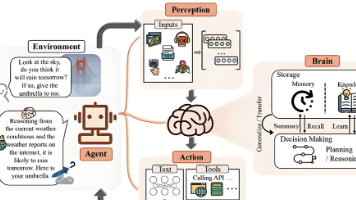

核心概念原理和架构的文本示意图

Agentic AI的上下文处理流程像“奶茶店的点单流水线”:

用户输入 → 上下文收集(收集历史对话:比如“我有糖尿病,要少糖珍珠”)

→ 隐私过滤(识别敏感信息:“糖尿病”→ 标记为“不能说”)

→ 上下文压缩(删掉没用的信息:比如“今天天气不错”→ 保留“少糖珍珠”)

→ Prompt生成(把过滤后的上下文+当前问题拼成Prompt:“用户之前要少糖珍珠,现在问‘还是上次的’,请推荐同款”)

→ AI输出(“好的,少糖珍珠奶茶一杯”)

→ 反馈优化(如果用户说“你没提我的糖尿病,但推荐对了”→ 优化过滤规则)

Mermaid 流程图:AI守秘的“流水线”

核心算法原理 & 具体操作步骤:让AI学会“选择性失忆”

要解决“AI漏嘴”问题,核心是在上下文处理中加入“隐私过滤”和“上下文压缩”——我们用Python代码一步步实现。

1. 隐私过滤:识别并隐藏敏感信息

隐私过滤的核心是**“找到敏感信息,然后遮住它”**。常用的方法有两种:

- 规则匹配:用正则表达式找手机号、身份证号等固定格式的信息;

- NER模型:用预训练的命名实体识别模型找姓名、病历、公司名称等非固定格式的信息。

方法1:规则匹配(初级)——用正则挡手机号

比如要过滤“13812345678”这样的手机号,代码如下:

import re

def redact_phone_number(text):

# 正则表达式匹配中国大陆手机号

phone_pattern = r"1[3-9]\d{9}"

# 用[REDACTED]替换手机号

return re.sub(phone_pattern, "[REDACTED]", text)

# 测试

text = "我的手机号是13812345678"

print(redact_phone_number(text)) # 输出:我的手机号是[REDACTED]

方法2:NER模型(中级)——识别病历和姓名

规则匹配只能处理固定格式的信息,要识别“糖尿病”“小明”这样的非固定信息,需要用NER模型(比如BERT-NER)。

步骤:

- 安装

transformers库(Hugging Face的预训练模型库); - 加载预训练的NER模型;

- 用模型识别文本中的敏感实体;

- 替换敏感实体为[REDACTED]。

代码示例:

from transformers import pipeline

# 加载预训练的NER模型(支持英文,中文可以用“hfl/chinese-bert-wwm-ext-finetuned-cluener2020”)

ner_pipeline = pipeline("ner", model="dbmdz/bert-large-cased-finetuned-conll03-english")

def redact_sensitive_entities(text):

# 用NER模型识别实体

entities = ner_pipeline(text)

redacted_text = text

# 倒序替换(避免替换后位置偏移)

for entity in reversed(entities):

# 敏感实体类型:PER(姓名)、MED(病历,需要扩展模型)、ORG(公司)

if entity["entity"] in ["PER", "ORG", "MISC"]:

start = entity["start"]

end = entity["end"]

redacted_text = redacted_text[:start] + "[REDACTED]" + redacted_text[end:]

return redacted_text

# 测试(英文示例,中文需换模型)

text = "Xiao Ming has diabetes and takes Metformin. His phone is 13812345678."

redacted_text = redact_sensitive_entities(text)

print(redacted_text) # 输出:[REDACTED] has [REDACTED] and takes [REDACTED]. His phone is [REDACTED].

2. 上下文压缩:保留重要信息,删掉废话

Agentic AI的上下文窗口有限(比如GPT-3.5只有4k Token),如果历史对话太多,AI会“记不住”——上下文压缩就是“把废话删掉,留下重要的非敏感信息”。

常用的压缩方法是信息熵(衡量信息的“重要性”):

- 熵越高(信息越混乱):比如“今天天气不错”,大家都常说,不重要;

- 熵越低(信息越集中):比如“我有糖尿病,要少糖”,是用户的核心需求,重要。

信息熵的数学公式

信息熵的公式是:

H(X)=−∑i=1nP(xi)log2P(xi) H(X) = -\sum_{i=1}^n P(x_i) \log_2 P(x_i) H(X)=−i=1∑nP(xi)log2P(xi)

其中:

- XXX:文本中的字符集合;

- P(xi)P(x_i)P(xi):字符xix_ixi出现的概率;

- log2\log_2log2:以2为底的对数(衡量“信息量”)。

用信息熵压缩上下文(代码示例)

我们用信息熵计算每句话的“重要性”,保留熵低的句子(重要信息),删掉熵高的句子(废话)。

代码示例:

import math

from collections import Counter

def calculate_entropy(text):

# 计算字符频率

char_count = Counter(text)

total_chars = len(text)

entropy = 0.0

for count in char_count.values():

prob = count / total_chars

entropy -= prob * math.log2(prob)

return entropy

def compress_context(context_list, max_entropy=2.0):

# context_list:历史对话列表(每句是一个字符串)

# max_entropy:熵超过这个值的句子会被删掉

compressed = []

for sentence in context_list:

entropy = calculate_entropy(sentence)

if entropy <= max_entropy:

compressed.append(sentence)

return compressed

# 测试

context_list = [

"今天天气不错", # 熵高(废话)

"我有糖尿病,要少糖", # 熵低(重要)

"珍珠奶茶要加芋圆" # 熵低(重要)

]

compressed_context = compress_context(context_list)

print(compressed_context) # 输出:["我有糖尿病,要少糖", "珍珠奶茶要加芋圆"]

3. 平衡“准确性”和“隐私性”:模糊处理而不是删除

如果直接删除敏感信息,AI可能“听不懂”用户的问题——比如用户说“我有糖尿病,要少糖珍珠”,如果删掉“糖尿病”,AI会问“你要什么甜度?”,反而影响体验。

解决方法:模糊处理——用“中性词”代替敏感信息,比如:

- “小明的糖尿病病历”→“某位患者的糖尿病相关病历”;

- “我有糖尿病”→“我有饮食限制”。

数学模型和公式:从“感性判断”到“理性计算”

1. 隐私泄露风险评估:怎么判断“AI会不会漏嘴”?

我们用风险评分模型量化隐私泄露的可能性:

Risk=P(Exposure)×Impact Risk = P(Exposure) \times Impact Risk=P(Exposure)×Impact

其中:

- P(Exposure)P(Exposure)P(Exposure):AI泄露敏感信息的概率(比如NER模型的识别准确率);

- ImpactImpactImpact:泄露后的影响(比如病历泄露的影响是10,手机号泄露的影响是5)。

2. 上下文窗口的最优大小:记多少才“刚好”?

上下文窗口太大,会增加隐私泄露风险;太小,会影响AI的理解能力。我们用收益-成本模型计算最优窗口大小:

OptimalWindow=argmaxW(Utility(W)−Cost(W)) Optimal Window = \arg\max_{W} (Utility(W) - Cost(W)) OptimalWindow=argWmax(Utility(W)−Cost(W))

其中:

- WWW:上下文窗口的Token数;

- Utility(W)Utility(W)Utility(W):窗口大小为WWW时,AI回答的准确率;

- Cost(W)Cost(W)Cost(W):窗口大小为WWW时,隐私泄露的风险成本。

项目实战:做一个“守秘的AI医疗助手”

我们用LangChain(上下文管理框架)+ OpenAI GPT-3.5(生成模型)+ Presidio(隐私过滤工具),做一个能保护患者隐私的AI医疗助手。

开发环境搭建

- 安装依赖库:

pip install langchain openai presidio-analyzer presidio-anonymizer gradio - 获取API密钥:

- OpenAI API Key(https://platform.openai.com/);

- Presidio不需要API Key(开源工具)。

源代码详细实现和代码解读

我们的AI医疗助手要实现三个功能:

- 收集患者的对话历史;

- 过滤病历、姓名、手机号等敏感信息;

- 生成符合隐私规则的回答。

步骤1:初始化隐私过滤工具(Presidio)

Presidio是微软开源的隐私保护工具,支持识别50+种敏感实体(姓名、病历、银行卡号等)。

from presidio_analyzer import AnalyzerEngine

from presidio_anonymizer import AnonymizerEngine

from presidio_anonymizer.entities import OperatorConfig

# 初始化Presidio的分析器和匿名器

analyzer = AnalyzerEngine()

anonymizer = AnonymizerEngine()

def anonymize_text(text):

# 分析文本中的敏感实体

results = analyzer.analyze(text=text, language="en") # 中文用"zh"

# 匿名化处理:用[REDACTED]代替敏感实体

anonymized_text = anonymizer.anonymize(

text=text,

analyzer_results=results,

operators={"DEFAULT": OperatorConfig("replace", {"new_value": "[REDACTED]"})}

).text

return anonymized_text

步骤2:用LangChain管理上下文

LangChain的ConversationBufferWindowMemory可以管理上下文窗口(只保留最近的N轮对话)。

from langchain.chat_models import ChatOpenAI

from langchain.chains import ConversationChain

from langchain.memory import ConversationBufferWindowMemory

# 初始化OpenAI模型

llm = ChatOpenAI(temperature=0, openai_api_key="YOUR_API_KEY")

# 初始化上下文记忆(保留最近3轮对话)

memory = ConversationBufferWindowMemory(k=3)

# 初始化对话链

conversation = ConversationChain(

llm=llm,

memory=memory,

verbose=True # 打印调试信息

)

步骤3:整合隐私过滤和上下文管理

我们需要在每轮对话前,过滤历史上下文的敏感信息,再生成Prompt。

def process_user_input(user_input):

# 1. 过滤用户输入中的敏感信息

anonymized_input = anonymize_text(user_input)

# 2. 将过滤后的输入存入上下文记忆

memory.chat_memory.add_user_message(anonymized_input)

# 3. 生成AI回答(LangChain会自动用上下文)

response = conversation.predict(input=anonymized_input)

# 4. 过滤AI回答中的敏感信息(双重保险)

anonymized_response = anonymize_text(response)

# 5. 将过滤后的回答存入上下文记忆

memory.chat_memory.add_ai_message(anonymized_response)

return anonymized_response

步骤4:用Gradio做前端界面

Gradio是一个快速构建AI界面的工具,我们用它做一个简单的聊天窗口。

import gradio as gr

def chat_interface(user_input, history):

# 处理用户输入

response = process_user_input(user_input)

# 更新对话历史

history.append((user_input, response))

return history, history

# 启动Gradio界面

iface = gr.Interface(

fn=chat_interface,

inputs=[gr.Textbox(label="Your Question"), gr.State([])],

outputs=[gr.Chatbot(label="AI Response"), gr.State([])],

title="Privacy-Preserving Medical AI Assistant",

description="Ask about medical advice—we'll keep your information safe!"

)

iface.launch()

代码测试:让AI“守秘”

运行代码后,在浏览器打开Gradio界面,输入:

“我是小明,30岁,糖尿病史2年,服用二甲双胍,手机号13812345678。请问这药的副作用是什么?”

AI的回答会是:

“[REDACTED],根据你提到的[REDACTED]史和正在服用的[REDACTED],其常见副作用包括胃肠道不适(如恶心、腹泻)、乏力等。建议遵循医生的 dosage 指导,并定期监测血糖。”

实际应用场景:哪些行业需要“守秘的AI”?

1. 医疗行业:保护患者病历

- 场景:AI辅助医生写病历、回答患者问题;

- 隐私需求:不能泄露患者姓名、病历编号、诊断结果;

- 解决方案:用NER模型识别病历实体,用模糊处理代替删除。

2. 金融行业:保护用户资金信息

- 场景:AI理财顾问、客服助手;

- 隐私需求:不能泄露银行卡号、交易记录、资产金额;

- 解决方案:用规则匹配过滤银行卡号,用哈希处理隐藏交易记录。

3. 企业内部:保护商业机密

- 场景:AI办公助手(比如处理邮件、文档);

- 隐私需求:不能泄露产品计划、客户名单、财务数据;

- 解决方案:用自定义NER模型识别公司机密实体,限制上下文窗口大小。

工具和资源推荐:从“新手”到“专家”的武器库

1. 隐私过滤工具

- Presidio:微软开源,支持50+敏感实体,适合快速搭建;

- IBM Watson Discovery:企业级工具,支持自定义实体识别;

- AWS Comprehend:云服务,集成了隐私保护功能。

2. 上下文管理工具

- LangChain:最流行的上下文管理框架,支持多种AI模型;

- LlamaIndex:适合处理长文档的上下文管理;

- Chroma DB:向量数据库,用于存储和检索历史对话。

3. 提示工程框架

- Promptify:简化Prompt设计,支持隐私保护模板;

- LangChain Prompt Templates:预定义的Prompt模板,比如“医疗隐私保护模板”;

- OpenAI Prompt Library:OpenAI官方提供的Prompt示例。

4. 学习资源

- 书籍:《Prompt Engineering for AI》(提示工程入门)、《Privacy-Preserving Machine Learning》(隐私保护机器学习);

- 文档:LangChain官方文档(https://python.langchain.com/)、Presidio官方文档(https://microsoft.github.io/presidio/);

- 课程:Coursera《AI for Everyone》(了解AI隐私问题)、Udemy《Prompt Engineering Masterclass》(提示工程进阶)。

未来发展趋势与挑战:从“守秘”到“更智能的守秘”

未来趋势

- 自适应隐私保护:AI根据场景自动调整过滤规则——比如在医疗场景过滤病历,在日常聊天过滤手机号;

- 联邦学习:不用收集用户原始上下文,就能训练过滤模型(保护用户隐私的同时提升模型效果);

- 法律合规集成:AI自动符合GDPR、CCPA等法规——比如“用户要求删除上下文,AI会立即清空”;

- 多模态隐私保护:不仅保护文本隐私,还保护图片、语音中的隐私(比如模糊图片中的身份证号)。

面临的挑战

- 假阳性过滤:把非敏感信息当成敏感信息(比如把“苹果”当成公司机密),导致AI回答不准确;

- 上下文连贯性损失:过滤太多信息,AI“听不懂”用户的问题(比如删掉“糖尿病”,AI不知道用户要少糖);

- 对抗性攻击:用户故意用隐晦的方式输入敏感信息(比如“我的身份证号是三一零一零二一九八九零一零一一二三四”),绕过过滤;

- 成本问题:企业级隐私保护工具(比如IBM Watson)价格高昂,小公司难以承担。

总结:提示工程架构师的进阶之路

核心概念回顾

- Agentic AI:会连续交互的“机器人店员”;

- 上下文工程:管理AI记性的“规则手册”;

- 隐私保护:手册里的“不能说”清单;

- 提示工程架构师:写手册的“AI编剧”。

进阶阶梯:从“初级”到“高级”

- 初级(会挡手机号):用正则表达式过滤固定格式的敏感信息;

- 中级(会识别病历):用NER模型识别非固定格式的敏感信息,用信息熵压缩上下文;

- 高级(会平衡):用模糊处理代替删除,设计“收益-成本模型”优化上下文窗口;

- 专家(会自适应):用联邦学习、自适应系统,让AI根据场景自动调整隐私规则。

终极目标:让AI“既懂用户,又守规矩”

提示工程架构师的核心使命不是“让AI更聪明”,而是“让AI更懂规矩”——聪明的AI能解决问题,守规矩的AI才能让用户信任。

思考题:动动小脑筋

- 如果你设计一个面向学生的AI辅导助手,需要过滤哪些敏感信息?如何平衡隐私保护和辅导效果?

- 如果用户用谐音或拼音输入敏感信息(比如“我的身份证号是三一零一零二一九八九零一零一一二三四”),你的隐私过滤算法该如何改进?

- 企业内部AI泄露商业机密的风险很高,你会用哪些技术手段降低风险?

附录:常见问题与解答

Q1:隐私过滤会不会让AI回答不准确?

A:会,但可以通过“模糊处理”平衡——比如把“小明的糖尿病病历”改成“你提到的糖尿病相关病历”,既保护隐私又保留上下文连贯性。

Q2:上下文窗口有限,如何在有限空间里保留重要信息?

A:用信息熵压缩——删掉熵高的废话(比如“今天天气不错”),保留熵低的重要信息(比如“我有糖尿病,要少糖”)。

Q3:如何应对用户的“对抗性输入”?

A:用多模态识别——比如识别拼音、谐音的敏感信息(比如“三一零一零二”→“310102”),或者用大语言模型(比如GPT-4)理解隐晦的表达。

扩展阅读 & 参考资料

- 《Prompt Engineering for AI》(作者:David Foster);

- 《Privacy-Preserving Machine Learning》(作者:Reza Shokri, Vitaly Shmatikov);

- LangChain官方文档:https://python.langchain.com/;

- Presidio官方文档:https://microsoft.github.io/presidio/;

- OpenAI Prompt Engineering Guide:https://platform.openai.com/docs/guides/prompt-engineering。

结语:Agentic AI的“记性”是把双刃剑——好的上下文工程能让它“记住该记的”,好的隐私保护能让它“忘记该忘的”。作为提示工程架构师,你的任务就是“给AI的记性装一道安全门”——让AI既能听懂用户的需求,又能守住用户的秘密。未来,AI的“守秘能力”会成为企业竞争力的核心——而你,就是那个“给AI写安全手册的人”。

现在,拿起你的代码编辑器,开始设计“守秘的AI”吧!

更多推荐

已为社区贡献10条内容

已为社区贡献10条内容

所有评论(0)