提示工程架构师职业规划:开启璀璨职业的密码

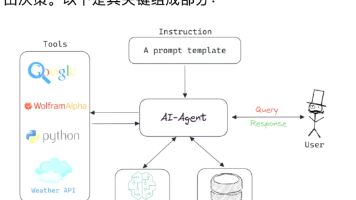

当ChatGPT、Claude等大模型从实验室走进企业,“如何让AI听懂人类需求”成了比“训练大模型”更紧迫的问题。此时,「提示工程架构师」(Prompt Engineering Architect)这个新职业站到了AI落地的核心位置——他们不是“写Prompt的人”,而是“设计AI与人类交互规则的人”。提示工程架构师到底是做什么的?(区别于普通Prompt工程师)要成为这个职业,需要搭建怎样的技

提示工程架构师职业规划:从「Prompt玩家」到「AI交互设计师」的进阶密码

关键词

提示工程、AI交互设计、职业规划、大模型应用、Prompt体系架构、Prompt优化、AI产品落地

摘要

当ChatGPT、Claude等大模型从实验室走进企业,“如何让AI听懂人类需求” 成了比“训练大模型”更紧迫的问题。此时,「提示工程架构师」(Prompt Engineering Architect)这个新职业站到了AI落地的核心位置——他们不是“写Prompt的人”,而是“设计AI与人类交互规则的人”。

这篇文章会帮你解开三个关键问题:

- 提示工程架构师到底是做什么的?(区别于普通Prompt工程师)

- 要成为这个职业,需要搭建怎样的技能栈?

- 从新手到专家,有哪些可复制的成长路径?

我们会用“餐厅运营”“给朋友指路”这样的生活化比喻,拆解复杂的Prompt体系设计;用电商客服、代码生成的真实案例,展示技术如何落地;甚至会写一段能直接跑起来的Prompt管理代码——让你从“听说过提示工程”,变成“能设计提示工程”。

一、背景:为什么提示工程架构师是大模型时代的「黄金职业」?

1. 大模型的“能力陷阱”:会做题,但不会“听懂需求”

2023年,我在某互联网公司做AI产品咨询时,遇到了一个典型问题:

产品经理小张用ChatGPT对接了智能客服系统,Prompt写的是“你是专业的手机客服,请耐心解答用户问题”。结果用户问“我买的手机充电慢怎么办?”,系统回复“请检查你的网络连接”——明显答非所问。

小张的困惑很常见:大模型有强大的生成能力,但没有“理解场景”的能力。就像你给一个数学天才出了道题,却没说“要用微积分还是代数”,他可能给你一个正确但没用的答案。

此时,提示工程架构师的价值 就在于:把模糊的人类需求,转化为大模型能理解的“精确指令体系”——不是写一个Prompt,而是设计一整套“让AI适配场景”的规则。

2. 职业爆发的底层逻辑:企业需要“AI落地的翻译官”

根据Gartner 2024年的报告:

- 85%的企业已经或计划使用大模型,但只有17%能实现“稳定的业务价值”;

- 阻碍落地的核心原因不是“模型不够强”,而是“不知道如何让模型适配业务场景”。

举个例子:

- 电商行业需要“能区分‘咨询商品参数’‘投诉快递延误’‘申请退换货’的客服Prompt”;

- 金融行业需要“能识别‘理财咨询’‘贷款申请’‘风险提示’的智能助手Prompt”;

- 软件行业需要“能生成‘符合公司编码规范’‘注释清晰’的代码Prompt”。

这些需求不是“写几个Prompt”能解决的——它们需要体系化的Prompt设计、版本管理、效果评估,而这正是提示工程架构师的核心工作。

3. 目标读者:谁该关注这个职业?

如果你符合以下任一情况,这篇文章会帮你打开新的职业赛道:

- 程序员/算法工程师:想从“训练模型”转向“用模型解决业务问题”;

- 产品经理/运营:想掌握AI产品的核心设计逻辑,不再依赖技术团队;

- Prompt工程师:已经会写Prompt,但想进阶到“设计Prompt体系”;

- 职场新人:想进入AI领域,寻找“门槛不高但潜力大”的职业。

二、核心概念:提示工程架构师≠Prompt工程师,差的是「体系思维」

很多人对提示工程的认知停留在“写Prompt的技巧”,比如“用Few-Shot学习”“加Chain of Thought”。但提示工程架构师的工作,是把这些技巧整合成“可复用、可迭代的系统”——就像建筑设计师不是砌砖的,而是设计整个建筑的结构、水电线路和承重体系。

1. 用“餐厅运营”比喻:Prompt体系的三层结构

我们可以把大模型比作“智能厨师”,那么:

- 普通Prompt工程师:给厨师写“番茄炒蛋的 recipe”(单个Prompt);

- 提示工程架构师:设计“餐厅的运营体系”(Prompt体系),包含三个层次:

| 层级 | 类比餐厅运营 | Prompt体系的核心内容 |

|---|---|---|

| 场景层 | 餐厅类型(川菜馆/西餐厅/快餐) | 定义业务场景(客服/营销/代码生成) |

| 模块层 | 菜单设计/厨师培训/服务流程 | 拆解场景为模块(问题分类/回答模板/多轮交互) |

| 执行层 | 点餐系统/后厨管理/客户反馈 | 实现Prompt的调用、版本控制、效果监控 |

举个具体例子:电商客服的Prompt体系

- 场景层:明确“客服场景”的核心目标——“快速解决用户问题,提升满意度”;

- 模块层:

- 问题分类模块:把用户问题分成“商品咨询”“售后问题”“投诉建议”三类;

- 回答模板模块:针对每类问题设计Prompt(比如“商品咨询”要强调“准确回答参数”,“售后问题”要强调“优先解决问题”);

- 多轮交互模块:记录上下文(比如用户先问“能不能机洗”,再问“水温要求”,Prompt要包含之前的对话);

- 执行层:

- 用系统自动匹配用户问题到对应模块;

- 对Prompt进行版本管理(比如商品信息更新时,自动同步Prompt中的参数);

- 用“用户满意度”“响应时间”评估Prompt效果。

2. 用Mermaid流程图:Prompt体系的工作逻辑

我们用Mermaid画一个“从用户需求到AI回复”的流程图,直观理解提示工程架构师的工作:

flowchart LR

A[用户需求] --> B{场景分类}

B -->|商品咨询| C[调用“商品参数Prompt模板”]

B -->|售后问题| D[调用“售后解决Prompt模板”]

B -->|投诉建议| E[调用“投诉处理Prompt模板”]

C --> F[注入商品上下文信息]

D --> F

E --> F

F --> G[生成AI回复]

G --> H{效果评估}

H -->|达标| I[输出回复]

H -->|不达标| J[迭代Prompt模板]

3. 关键区别:Prompt工程师vs提示工程架构师

| 维度 | Prompt工程师 | 提示工程架构师 |

|---|---|---|

| 核心目标 | 写好单个Prompt | 设计可复用的Prompt体系 |

| 思维方式 | 聚焦“技巧”(比如加Few-Shot) | 聚焦“系统”(比如场景拆解、迭代) |

| 输出物 | 单个Prompt字符串 | Prompt模板库+调用逻辑+评估体系 |

| 价值 | 解决“一个问题” | 解决“一类问题” |

三、技术原理:成为提示工程架构师,需要掌握的4项核心技能

提示工程架构师的技能栈不是“会写Prompt”,而是“能设计Prompt体系”。我们用“给朋友指路”的比喻,拆解4项核心技能:

1. 技能1:场景化Prompt设计——像“精准指路”一样定义需求

你给朋友指路时,说“往那边走”肯定不如“从这个路口左转,走50米看到红色招牌就是”——场景化Prompt的核心就是“把模糊需求变具体”。

核心方法:5W1H原则

设计Prompt时,用5W1H(Who/What/When/Where/Why/How)明确约束条件:

- Who:AI的角色(比如“你是电商客服”“你是Java程序员”);

- What:AI要做的事(比如“回答商品洗涤方式”“生成斐波那契数列代码”);

- When/Where:场景限制(比如“在用户问售后问题时”“在生成Java代码时”);

- Why:目标(比如“提升用户满意度”“符合编码规范”);

- How:要求(比如“简洁回答”“使用递归实现”)。

案例:从“通用Prompt”到“场景化Prompt”

通用Prompt(无效):“你是客服,回答用户问题。”

场景化Prompt(有效):

你是电商平台的专业客服,负责解答用户的商品洗涤问题。

要求:

1. 必须根据提供的商品信息回答(商品名:[商品名],洗涤说明:[洗涤说明]);

2. 回答要简洁,直接给出结论(比如“可以机洗,水温30℃以下”);

3. 避免使用“请查看详情页”这类引导语。

用户问题:这件衣服能不能机洗?

2. 技能2:多轮对话管理——像“聊天”一样保持上下文

你和朋友聊天时,不会每次都重复“我是谁”——多轮对话的核心是“让AI记住之前的对话”。

核心方法:上下文注入

把之前的对话记录(用户问题+AI回复)注入到当前Prompt中,让AI理解上下文。

代码示例:用Python实现多轮对话Prompt

我们用OpenAI API演示如何管理多轮上下文:

import openai

import json

# 初始化上下文(存储之前的对话)

context = []

def generate_response(user_input, product_info):

# 1. 构建Prompt模板(包含上下文和商品信息)

prompt_template = """

你是电商客服,需要根据上下文和商品信息回答用户问题。

上下文:{context}

商品信息:{product_info}

要求:回答简洁准确,符合之前的对话逻辑。

用户当前问题:{user_input}

"""

# 2. 注入上下文和商品信息

prompt = prompt_template.format(

context=json.dumps(context),

product_info=json.dumps(product_info),

user_input=user_input

)

# 3. 调用OpenAI API

response = openai.ChatCompletion.create(

model="gpt-4",

messages=[{"role": "user", "content": prompt}]

)

ai_response = response.choices[0].message.content

# 4. 更新上下文(添加当前对话)

context.append({"user": user_input, "assistant": ai_response})

return ai_response

# 测试多轮对话

product_info = {"商品名": "纯棉T恤", "洗涤说明": "可机洗,水温30℃以下,不可漂白"}

user_question1 = "这件衣服能不能机洗?"

print(generate_response(user_question1, product_info)) # 输出:可以机洗,水温30℃以下。

user_question2 = "那能不能用漂白剂?"

print(generate_response(user_question2, product_info)) # 输出:不可使用漂白剂。

3. 技能3:Prompt版本控制——像“管理代码”一样管理Prompt

你不会把代码直接写在生产环境里——Prompt版本控制的核心是“让Prompt可追溯、可回滚”。

核心工具:Prompt仓库(类似Git)

可以用数据库(比如MySQL)或配置管理工具(比如Apollo)存储Prompt版本,记录:

- Prompt的ID、名称、场景;

- 版本号、创建时间、修改人;

- Prompt内容、生效时间;

- 效果评估数据(比如准确率、用户满意度)。

案例:Prompt版本迭代流程

- V1.0:初始Prompt(“回答用户的洗涤问题”),效果:准确率70%;

- V1.1:添加“避免引导语”的要求,效果:准确率78%;

- V1.2:注入商品信息变量,效果:准确率85%;

- V1.3:添加多轮上下文,效果:准确率90%。

4. 技能4:效果评估体系——像“考试评分”一样衡量Prompt好坏

你不会凭感觉说“这个Prompt好用”——效果评估的核心是“用数据量化Prompt的价值”。

核心指标:从“技术指标”到“业务指标”

| 类型 | 指标 | 说明 |

|---|---|---|

| 技术指标 | 准确率(Accuracy) | 生成结果符合预期的比例 |

| 技术指标 | BLEU评分 | 生成文本与参考文本的相似性(用于文本生成) |

| 业务指标 | 用户满意度(CSAT) | 满意用户数/总用户数×100% |

| 业务指标 | 响应时间(Response Time) | AI回复的平均时间 |

| 业务指标 | 问题解决率(Resolution Rate) | 一次回复解决用户问题的比例 |

数学模型:BLEU评分的计算

BLEU(Bilingual Evaluation Understudy)是衡量文本生成质量的经典指标,公式如下:

BLEU=min(1,len(candidate)len(reference))×exp(∑n=1Nwnlogpn) BLEU = min\left(1, \frac{len(candidate)}{len(reference)}\right) × exp\left(\sum_{n=1}^N w_n log p_n\right) BLEU=min(1,len(reference)len(candidate))×exp(n=1∑Nwnlogpn)

- candidatecandidatecandidate:AI生成的文本;

- referencereferencereference:人工写的参考文本;

- pnp_npn:n-gram的精确率(比如2-gram是“机洗”“水温”这样的双词组合);

- wnw_nwn:n-gram的权重(通常取wn=1/Nw_n = 1/Nwn=1/N)。

四、实际应用:从0到1设计电商客服的Prompt体系

我们用一个真实案例,展示提示工程架构师如何解决业务问题:

1. 问题背景

某电商公司的智能客服系统遇到两个痛点:

- 回复不准确:用户问“能不能机洗”,系统经常回复“请查看详情页”;

- 效率低:客服需要手动复制商品信息到Prompt中,耗时久。

2. 解决步骤:Prompt体系的设计流程

步骤1:场景拆解——明确“客服场景”的核心需求

通过用户调研,我们把客服问题分成三类:

- 商品咨询:问参数(材质、尺寸、洗涤方式);

- 售后问题:问退换货、快递延误;

- 投诉建议:对服务或商品不满。

步骤2:模块设计——为每类问题设计Prompt模板

- 商品咨询Prompt模板:

你是电商客服,负责解答商品咨询问题。 商品信息:{product_info}(包含材质、尺寸、洗涤方式等) 用户问题:{user_question} 要求: 1. 必须用商品信息中的内容回答; 2. 回答简洁,不超过20字; 3. 避免引导语(比如“请查看详情页”)。 - 售后问题Prompt模板:

你是电商客服,负责处理售后问题。 用户问题:{user_question} 售后政策:{after_sales_policy}(比如“7天无理由退换货”) 要求: 1. 先道歉(比如“很抱歉给你带来不便”); 2. 再给出解决方案(比如“你可以申请退换货,流程是:...”); 3. 留下联系方式(比如“有问题可以联系客服电话:400-xxx-xxxx”)。

步骤3:执行层实现——自动调用与版本控制

- 自动匹配场景:用NLP模型(比如BERT)识别用户问题的类型(商品咨询/售后/投诉);

- 自动注入变量:从商品数据库中获取当前商品的信息(比如洗涤说明),注入到Prompt中;

- 版本控制:用Apollo配置中心存储Prompt模板,支持灰度发布(先给10%用户用新版本,没问题再全量)。

步骤4:效果评估——用数据验证价值

实施后,我们统计了30天的数据:

- 用户满意度(CSAT)从65%提升到85%;

- 问题解决率从50%提升到75%;

- 客服响应时间从60秒缩短到20秒。

3. 常见问题及解决方案

在项目中,我们遇到了两个常见问题,分享解决方案:

问题1:Prompt太长导致模型性能下降

原因:大模型的上下文窗口有限(比如GPT-4是8k/32k tokens),太长的Prompt会让模型“记不住”关键信息。

解决方案:用“Prompt压缩”技术——提取关键信息,去掉冗余内容。比如把“商品信息”中的“品牌故事”“促销信息”去掉,只保留“材质”“洗涤方式”等核心参数。

问题2:Prompt泛化能力差(只适用于某类商品)

原因:Prompt中的变量不够灵活,比如“洗涤说明”只适用于服装类商品,不适用于电子产品。

解决方案:用“场景化变量”——为不同商品类型设计不同的变量。比如:

- 服装类:洗涤说明、材质;

- 电子产品:充电时间、保修政策;

- 食品类:保质期、配料表。

五、未来展望:提示工程架构师的“进化方向”

大模型技术在快速发展,提示工程架构师的角色也在进化——从“设计Prompt体系”到“设计AI交互的底层规则”。

1. 技术趋势1:Prompt与微调的结合(LoRA+Prompt)

LoRA(Low-Rank Adaptation)是一种轻量级微调技术,可以在不修改大模型参数的情况下,让模型适配特定场景。未来,提示工程架构师会用“LoRA+Prompt”的组合:

- 用Prompt定义场景需求;

- 用LoRA微调模型,让模型更“懂”这个场景;

- 结果:比单独用Prompt更准确,比全量微调更高效。

2. 技术趋势2:自动Prompt生成(Auto-Prompt)

现在,已经有工具可以自动生成Prompt(比如ChatGPT的“生成Prompt”功能)。未来,提示工程架构师的工作会从“写Prompt”转向“设计自动Prompt的规则”:

- 定义Prompt的评估标准(比如“必须包含商品信息”“回答简洁”);

- 用大模型生成候选Prompt;

- 自动测试候选Prompt的效果,选择最优版本。

3. 技术趋势3:多模态Prompt设计

未来,大模型会支持多模态输入(文本+图像+语音),比如用户拍一张衣服的照片,问“能不能机洗?”。此时,提示工程架构师需要设计“多模态Prompt”:

- 文本部分:“回答衣服的洗涤方式”;

- 图像部分:“分析衣服的材质(比如纯棉、涤纶)”;

- 结合两者生成回复:“这件纯棉T恤可以机洗,水温30℃以下。”

4. 潜在挑战:大模型的“不确定性”

大模型的一个特点是“相同Prompt可能生成不同结果”(比如问“明天会不会下雨”,两次回答可能不同)。未来,提示工程架构师需要设计“鲁棒的Prompt体系”——即使模型输出有波动,也能保证结果符合业务要求。

六、职业规划:从新手到提示工程架构师的3阶段成长路径

现在,你已经理解了提示工程架构师的核心技能,接下来我们讲可复制的成长路径——从“Prompt新手”到“架构师”,需要经历3个阶段:

阶段1:Prompt工程师(0-1年)——掌握“写好Prompt的技巧”

核心目标:从“会用大模型”到“会写有效的Prompt”。

需要学习的内容:

- 大模型的基础原理(比如Transformer、注意力机制);

- Prompt设计技巧(Few-Shot、Chain of Thought、Role Prompting);

- 至少掌握一种大模型API(比如OpenAI、Anthropic、阿里云通义千问);

- 练习写不同场景的Prompt(比如客服、代码生成、文案写作)。

阶段2:Prompt体系设计师(1-3年)——掌握“设计Prompt系统”

核心目标:从“写单个Prompt”到“设计Prompt体系”。

需要学习的内容:

- 业务场景拆解(比如用用户旅程图拆解客服场景);

- 系统设计(比如Prompt的调用逻辑、版本控制);

- 数据评估(比如用CSAT、准确率衡量Prompt效果);

- 项目经验(参与至少1个AI产品落地项目,比如智能客服、智能助手)。

阶段3:提示工程架构师(3+年)——掌握“设计AI交互规则”

核心目标:从“设计Prompt体系”到“设计AI与人类交互的底层规则”。

需要学习的内容:

- 多模态技术(比如图像、语音的Prompt设计);

- 自动Prompt生成(比如用大模型生成优化的Prompt);

- 行业知识(比如电商、金融、医疗的业务逻辑);

- 团队管理(带领Prompt工程师团队,推进项目落地)。

七、总结:提示工程架构师的“核心竞争力”

最后,我们用三句话总结这个职业的本质:

- 不是“Prompt的搬运工”,而是“AI交互的设计师”——把人类需求转化为AI能理解的规则;

- 不是“技术的使用者”,而是“技术的翻译官”——把大模型的能力翻译成业务价值;

- 不是“单一技能的专家”,而是“跨领域的通才”——需要懂大模型、懂业务、懂用户体验。

思考问题:鼓励你进一步探索

- 如果你是提示工程架构师,遇到大模型生成有害内容(比如歧视性语言)的情况,你会怎么设计Prompt来避免?

- 多模态Prompt(比如结合图像和文本)需要哪些新的技能?

- 未来,自动Prompt生成工具会取代提示工程架构师吗?为什么?

参考资源

- 官方指南:OpenAI Prompt Engineering Guide(https://platform.openai.com/docs/guides/prompt-engineering);

- 书籍:《Prompt Engineering for Generative AI》(作者:David Foster);

- 工具:Apollo配置中心(用于Prompt版本控制)、LangChain(用于多轮对话管理);

- 社区:Hugging Face Prompt Engineering Forum(https://discuss.huggingface.co/c/prompt-engineering/13)。

结尾语:

大模型时代,最稀缺的不是“会用AI的人”,而是“会让AI服务于人的人”。提示工程架构师的职业密码,就藏在“理解人类需求”和“设计AI规则”的缝隙里——愿你能成为那个“让AI听懂人类的人”。

下一篇文章,我们会讲“如何用Prompt工程优化代码生成”——敬请期待!

(全文完)

更多推荐

已为社区贡献17条内容

已为社区贡献17条内容

所有评论(0)