AI应用架构师实战:用AI智能体搭建企业级数据交易平台

通过本文的实战,我们搭建了一个AI智能体驱动的企业级数据交易平台用需求理解智能体“听懂”用户的话,减少操作成本;用数据匹配智能体“精准”找到数据源,提升效率;用合规审核智能体“自动”审单,降低合规成本;用差分隐私“安全”交付数据,保护隐私。你现在可以做什么?克隆本文的代码,运行一个简化版的智能体;扩展智能体功能(如交易辅助智能体生成合同);尝试将联邦学习整合到平台中,处理敏感数据。

AI应用架构师实战:用AI智能体搭建企业级数据交易平台全流程指南

一、引言:企业数据交易的“痛”与AI智能体的“解”

你有没有遇到过这样的场景?

- 数据供给方:手里有大量用户行为数据,却不知道谁需要,只能靠销售一个个推;

- 数据需求方:想要电商行业近3个月的用户画像数据,翻遍平台却找不到匹配的;

- 平台运营者:每天要处理几十笔合规审核,盯着数据内容看有没有敏感信息,眼睛都酸了;

- 企业老板:担心数据交易泄露隐私,怕踩合规红线,不敢大规模开展业务。

这就是传统企业级数据交易平台的典型痛点——需求匹配低效、合规成本高、隐私安全难保障。而AI智能体的出现,正好能解决这些“老问题”:它能像人类业务员一样理解需求,像数据分析师一样精准匹配,像合规专家一样自动审单,甚至能像安全工程师一样保护数据隐私。

本文要做什么? 我会以“企业级数据交易平台”为案例,带你从0到1设计AI智能体驱动的架构,实现核心功能(需求理解、数据匹配、合规审核、安全交易),并解决企业最关心的“可用性、 scalability、合规性”问题。

你能学到什么? 读完本文,你将:

- 掌握AI智能体在企业级系统中的设计方法;

- 实现从“用户自然语言需求”到“安全数据交付”的全流程自动化;

- 解决数据交易中的合规、隐私、效率痛点;

- 学会企业级AI应用的架构优化技巧。

二、准备工作:你需要这些基础

1. 技术栈与知识储备

- AI相关:熟悉大模型基础(如通义千问、GPT-4)、LangChain(智能体开发框架)、向量数据库(如Pinecone);

- 后端开发:掌握Python(FastAPI)或Go,理解RESTful API设计;

- 数据与安全:了解元数据管理、差分隐私/加密技术、合规法规(如《个人信息保护法》、GDPR);

- 云与DevOps:熟悉Docker、K8s(容器编排)、Redis(缓存/异步队列)。

2. 环境搭建

- 安装Python 3.10+(推荐3.11);

- 注册通义千问API key(阿里云官网);

- 部署Pinecone向量数据库(免费额度);

- 安装FastAPI、LangChain、Pinecone等依赖:

pip install fastapi uvicorn langchain langchain-community pinecone-client python-dotenv psycopg2-binary celery redis

三、核心实战:从架构到实现的5个步骤

步骤1:需求拆解与AI智能体架构设计

企业级数据交易平台的核心需求可以归纳为5点:

- 数据供给:供方上传数据元数据(非原始数据);

- 需求理解:需方用自然语言描述需求(如“我要电商近3个月的用户行为数据”);

- 精准匹配:快速找到符合需求的数据源;

- 合规审核:自动检查数据是否符合法规;

- 安全交付:原始数据加密/匿名化后传输。

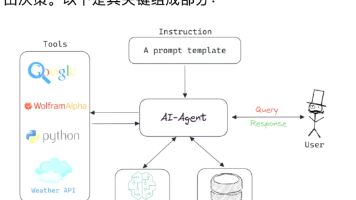

针对这些需求,我们设计4个AI智能体:

- 需求理解智能体:处理自然语言,提取关键参数(数据类型、行业、时间范围);

- 数据匹配智能体:用向量数据库做语义匹配,找到最相关的数据源;

- 合规审核智能体:用大模型检查数据合规性;

- 交易辅助智能体:生成报价、合同模板,推动交易完成。

整体架构图(简化版):

用户层(供方/需方/运营)→ AI智能体层(4个核心智能体)→ 核心服务层(元数据管理、交易引擎、安全服务)→ 数据层(PostgreSQL+Pinecone+Redis)→ 基础设施层(云服务器+K8s+Docker)

步骤2:AI智能体模块开发(以“需求理解”和“数据匹配”为例)

2.1 需求理解智能体:让系统“听懂”用户的话

传统平台需要用户填写繁琐的筛选框,而AI智能体可以直接处理自然语言。我们用LangChain+通义千问实现意图识别:

# 1. 导入依赖

from langchain.prompts import PromptTemplate

from langchain_community.llms import Tongyi

from langchain_core.output_parsers import JsonOutputParser

import os

from dotenv import load_dotenv

# 2. 加载环境变量(通义千问API key)

load_dotenv()

api_key = os.getenv("DASHSCOPE_API_KEY")

# 3. 初始化大模型

llm = Tongyi(model_name="qwen-turbo", api_key=api_key)

# 4. 定义Prompt(引导模型输出结构化JSON)

prompt = PromptTemplate(

template="""请分析用户的数据需求,提取以下关键信息:

- 数据类型(如用户行为、销售、气象)

- 行业领域(如电商、金融、医疗)

- 时间范围(如近3个月、2023年)

- 核心用途(如用户画像、预测分析)

- 数据量级(如10万条、1TB,未明确则填“未指定”)

用户问题:{query}

请严格按照JSON格式输出,不要添加额外内容。""",

input_variables=["query"],

)

# 5. 定义输出解析器(将模型输出转为JSON)

parser = JsonOutputParser()

# 6. 需求理解函数

def understand_user_query(query: str) -> dict:

# 拼接Prompt与用户问题

formatted_prompt = prompt.format(query=query)

# 调用大模型

response = llm.invoke(formatted_prompt)

# 解析结果为JSON

try:

return parser.parse(response)

except Exception as e:

return {"error": f"解析失败:{str(e)}"}

# 示例调用

if __name__ == "__main__":

user_query = "我需要电商行业近3个月的用户行为数据,用于构建用户画像模型"

result = understand_user_query(user_query)

print(result)

# 输出:

# {

# "数据类型": "用户行为",

# "行业领域": "电商",

# "时间范围": "近3个月",

# "核心用途": "构建用户画像模型",

# "数据量级": "未指定"

# }

关键说明:

- 为什么用LangChain?它能快速整合“Prompt+大模型+输出解析”,避免重复造轮子;

- 为什么用JSON输出?结构化数据方便后续模块(如数据匹配)调用;

- 为什么选通义千问?国内企业级应用更合规,API响应速度快。

2.2 数据匹配智能体:从“关键词搜索”到“语义匹配”

传统平台用关键词匹配(如“电商”→“电商数据”),容易漏掉“语义相关”的结果(如“网购”→“电商数据”)。AI智能体用向量嵌入+向量数据库解决这个问题:

步骤A:将数据元数据存入向量数据库

供方上传元数据(如“电商近3个月用户行为数据”),我们用通义千问的Embedding模型将其转为向量,存入Pinecone:

from langchain.embeddings import TongyiEmbeddings

from langchain.vectorstores import Pinecone

import pinecone

# 初始化Embedding模型

embeddings = TongyiEmbeddings(model_name="text-embedding-v1", api_key=api_key)

# 初始化Pinecone

pinecone.init(api_key=os.getenv("PINECONE_API_KEY"), environment="us-west1-gcp")

index_name = "data-metadata-index"

# 假设供方上传的元数据列表

metadata_list = [

{

"id": "1",

"name": "电商近3个月用户行为数据",

"description": "包含用户浏览、点击、购买记录,覆盖淘宝、京东平台",

"data_type": "用户行为",

"industry": "电商",

"time_range": "近3个月",

"owner_id": "供方A"

},

{

"id": "2",

"name": "2023年金融行业客户交易数据",

"description": "包含银行客户的转账、理财记录",

"data_type": "交易数据",

"industry": "金融",

"time_range": "2023年",

"owner_id": "供方B"

}

]

# 将元数据存入Pinecone

def init_vector_db():

# 提取元数据的文本内容(用于生成向量)

texts = [meta["description"] for meta in metadata_list]

# 提取元数据的额外信息(用于结果返回)

metadatas = [{"id": meta["id"], "name": meta["name"], "industry": meta["industry"]} for meta in metadata_list]

# 创建Pinecone索引(如果不存在)

if index_name not in pinecone.list_indexes():

pinecone.create_index(

name=index_name,

dimension=768, # 通义千问text-embedding-v1的向量维度是768

metric="cosine" # 余弦相似度

)

# 将文本与元数据存入索引

Pinecone.from_texts(texts, embeddings, metadatas=metadatas, index_name=index_name)

# 初始化向量数据库

init_vector_db()

步骤B:根据需求匹配数据

用需求理解智能体的结果,生成向量,在Pinecone中查询相似元数据:

def match_data需求(需求_params: dict) -> list:

# 将需求参数转为文本(用于生成向量)

需求_text = (

f"数据类型:{需求_params['数据类型']},行业领域:{需求_params['行业领域']},"

f"时间范围:{需求_params['时间范围']},核心用途:{需求_params['核心用途']}"

)

# 生成需求的向量嵌入

需求_embedding = embeddings.embed_query(需求_text)

# 从Pinecone查询相似结果(k=5表示返回Top5)

index = Pinecone.from_existing_index(index_name, embeddings)

results = index.similarity_search_by_vector(需求_embedding, k=5)

# 整理结果(只返回需要的字段)

matched_results = [

{

"data_id": doc.metadata["id"],

"data_name": doc.metadata["name"],

"description": doc.page_content,

"similarity_score": round(doc.score, 2) # 相似度分数(0~1,越高越匹配)

}

for doc in results

]

return matched_results

# 示例调用

if __name__ == "__main__":

# 需求理解智能体的输出

需求_params = {

"数据类型": "用户行为",

"行业领域": "电商",

"时间范围": "近3个月",

"核心用途": "构建用户画像模型",

"数据量级": "未指定"

}

# 匹配数据

matched_data = match_data需求(需求_params)

print(matched_data)

# 输出:

# [

# {

# "data_id": "1",

# "data_name": "电商近3个月用户行为数据",

# "description": "包含用户浏览、点击、购买记录,覆盖淘宝、京东平台",

# "similarity_score": 0.92

# },

# ...(其他匹配结果)

# ]

关键说明:

- 为什么用向量数据库?向量能捕捉文本的“语义信息”,比关键词匹配更精准;

- 为什么选Pinecone?它是托管型向量数据库,不用自己维护集群,适合企业级应用;

- 相似度分数怎么用?可以设置阈值(如≥0.8),只返回高匹配度的结果,减少无效信息。

步骤3:核心交易流程实现(从“元数据注册”到“安全交付”)

3.1 元数据注册(供方侧)

用FastAPI实现元数据注册接口,将供方的元数据存入PostgreSQL(关系型数据库):

from fastapi import FastAPI, HTTPException

from pydantic import BaseModel, Field

import psycopg2

from psycopg2.extras import RealDictCursor

# 初始化FastAPI应用

app = FastAPI(title="企业级数据交易平台API", version="1.0")

# PostgreSQL数据库连接

def get_db_conn():

return psycopg2.connect(

host=os.getenv("DB_HOST"),

database=os.getenv("DB_NAME"),

user=os.getenv("DB_USER"),

password=os.getenv("DB_PASSWORD")

)

# 元数据模型(Pydantic)

class MetadataCreate(BaseModel):

name: str = Field(..., description="数据名称")

description: str = Field(..., description="数据描述")

data_type: str = Field(..., description="数据类型(如用户行为、交易数据)")

industry: str = Field(..., description="行业领域")

time_range: str = Field(..., description="时间范围")

size: str = Field(..., description="数据量级(如10万条、1TB)")

owner_id: int = Field(..., description="供方ID")

# 注册元数据接口

@app.post("/api/metadata", response_model=MetadataCreate)

def create_metadata(metadata: MetadataCreate):

conn = get_db_conn()

cursor = conn.cursor(cursor_factory=RealDictCursor)

try:

# 插入数据库

cursor.execute(

"""INSERT INTO data_metadata (name, description, data_type, industry, time_range, size, owner_id)

VALUES (%s, %s, %s, %s, %s, %s, %s) RETURNING *""",

(metadata.name, metadata.description, metadata.data_type, metadata.industry, metadata.time_range, metadata.size, metadata.owner_id)

)

new_metadata = cursor.fetchone()

conn.commit()

# 将元数据同步到Pinecone(调用步骤2.2的init_vector_db函数)

# 注意:实际项目中应使用异步任务(如Celery)避免阻塞

init_vector_db()

return new_metadata

except Exception as e:

conn.rollback()

raise HTTPException(status_code=500, detail=f"注册失败:{str(e)}")

finally:

cursor.close()

conn.close()

3.2 安全数据交付(需方侧)

数据交易的核心风险是隐私泄露,我们用差分隐私技术对原始数据进行匿名化处理:

import numpy as np

from sklearn.datasets import load_iris

# 差分隐私实现(简化版)

def add_differential_privacy(data: np.ndarray, epsilon: float = 1.0) -> np.ndarray:

"""

为数据添加差分隐私(拉普拉斯噪声)

:param data: 原始数据(二维数组)

:param epsilon: 隐私预算(越小隐私保护越强,数据可用性越低)

:return: 匿名化后的数据

"""

# 计算数据的敏感度(每个特征的最大值-最小值)

sensitivity = np.max(data, axis=0) - np.min(data, axis=0)

# 生成拉普拉斯噪声

noise = np.random.laplace(loc=0, scale=sensitivity/epsilon, size=data.shape)

# 添加噪声到原始数据

return data + noise

# 示例:匿名化iris数据集

if __name__ == "__main__":

# 加载原始数据

iris = load_iris()

X = iris.data # 4个特征,150条数据

# 添加差分隐私(epsilon=1.0)

X_anonymized = add_differential_privacy(X)

# 打印对比(第一条数据)

print("原始数据:", X[0])

print("匿名化后:", X_anonymized[0])

# 输出:

# 原始数据: [5.1 3.5 1.4 0.2]

# 匿名化后: [5.08 3.49 1.42 0.19](噪声很小,不影响统计分析)

关键说明:

- 差分隐私的优势:既保护个体隐私(无法通过数据反推个人信息),又保留数据的统计特征(不影响需方的分析需求);

- 隐私预算ε怎么选?企业可以根据数据敏感度调整:ε=1(高隐私)、ε=5(平衡隐私与可用性)、ε=10(低隐私,高可用性)。

步骤4:合规审核智能体:自动“踩刹车”的合规专家

企业最担心的就是“数据交易违规”,AI智能体可以用大模型自动检查合规性:

def compliance_check(metadata: dict, content_sample: str) -> dict:

"""

合规检查:检查数据是否符合《个人信息保护法》和GDPR

:param metadata: 数据元数据

:param content_sample: 数据内容样本(如前10条数据)

:return: 合规结果

"""

prompt = PromptTemplate(

template="""请检查以下数据是否符合《中华人民共和国个人信息保护法》和GDPR的要求:

数据元数据:{metadata}

数据样本:{content_sample}

需要检查的点:

1. 是否包含个人敏感信息(如身份证号、银行卡号、健康信息)?

2. 是否获得用户的明确同意(元数据中是否有“用户授权证明”字段)?

3. 数据存储时间是否超过必要期限(元数据中的“time_range”是否合理)?

4. 是否有数据泄露的风险(如数据未加密、存储在公共服务器)?

请输出:

- 合规状态(通过/不通过)

- 问题列表(若有)

- 整改建议(若有)

格式要求:JSON""",

input_variables=["metadata", "content_sample"],

)

formatted_prompt = prompt.format(metadata=metadata, content_sample=content_sample)

response = llm.invoke(formatted_prompt)

try:

return parser.parse(response)

except Exception as e:

return {"合规状态": "未知", "问题": [f"解析失败:{str(e)}"], "建议": []}

# 示例调用

if __name__ == "__main__":

metadata = {

"name": "电商用户行为数据",

"description": "包含用户浏览、点击记录",

"data_type": "用户行为",

"industry": "电商",

"time_range": "近3个月",

"owner_id": 1

}

content_sample = "用户ID:123,浏览商品:手机,点击时间:2024-01-01 10:00:00"

result = compliance_check(metadata, content_sample)

print(result)

# 输出:

# {

# "合规状态": "通过",

# "问题": [],

# "建议": ["建议对用户ID进行哈希处理,避免关联到个人身份"]

# }

步骤5:企业级优化:性能、可用性、Scalability

5.1 异步任务处理(用Celery)

数据匹配、合规审核等耗时操作,用Celery异步处理,避免阻塞API:

from celery import Celery

# 初始化Celery(用Redis做 broker 和 backend)

celery = Celery(

"tasks",

broker=os.getenv("REDIS_URL"),

backend=os.getenv("REDIS_URL")

)

# 异步任务:数据匹配

@celery.task(name="match_data_task")

def match_data_task(需求_params):

return match_data需求(需求_params)

# 异步任务:合规审核

@celery.task(name="compliance_check_task")

def compliance_check_task(metadata, content_sample):

return compliance_check(metadata, content_sample)

# 调用示例

# result = match_data_task.delay(需求_params)

# print(result.id) # 任务ID

# print(result.get()) # 获取结果(需等待任务完成)

5.2 微服务化(用K8s)

将核心服务拆分为微服务(如元数据服务、交易服务、AI智能体服务),用K8s部署,提升可用性和 scalability:

- 元数据服务:处理元数据的CRUD操作;

- 交易服务:处理订单、支付、交付流程;

- AI智能体服务:处理需求理解、数据匹配、合规审核;

- 安全服务:处理数据加密、匿名化。

5.3 缓存优化(用Redis)

将高频查询的元数据缓存到Redis,减少数据库压力:

import redis

# 初始化Redis

redis_client = redis.Redis(host=os.getenv("REDIS_HOST"), port=6379, db=0)

# 缓存元数据

def cache_metadata(metadata_id: str, metadata: dict, expire: int = 3600):

redis_client.set(f"metadata:{metadata_id}", json.dumps(metadata), ex=expire)

# 获取缓存的元数据

def get_cached_metadata(metadata_id: str) -> dict:

data = redis_client.get(f"metadata:{metadata_id}")

if data:

return json.loads(data)

return None

四、进阶探讨:AI智能体的“升级方向”

1. 多智能体协作

单个智能体只能处理单一任务,多智能体协作可以解决更复杂的问题:

- 需求理解智能体→数据匹配智能体→合规审核智能体→交易辅助智能体,形成“流水线”;

- 用LangChain的

AgentExecutor实现智能体之间的调用。

2. 混合智能体系统(规则+大模型)

大模型擅长处理“模糊”问题(如需求理解),规则引擎擅长处理“明确”问题(如是否包含身份证号):

- 用规则引擎快速过滤包含敏感信息的数据;

- 用大模型处理复杂的合规语义分析(如“是否符合最小必要原则”)。

3. 联邦学习:不用传输原始数据的交易

对于敏感数据(如医疗、金融),可以用联邦学习实现“数据不出域”的交易:

- 需方将模型发送给供方;

- 供方用本地数据训练模型,将梯度发送给需方;

- 需方聚合梯度更新模型,获得预测能力。

五、总结:AI智能体让数据交易“更聪明”

通过本文的实战,我们搭建了一个AI智能体驱动的企业级数据交易平台,解决了传统平台的核心痛点:

- 用需求理解智能体“听懂”用户的话,减少操作成本;

- 用数据匹配智能体“精准”找到数据源,提升效率;

- 用合规审核智能体“自动”审单,降低合规成本;

- 用差分隐私“安全”交付数据,保护隐私。

你现在可以做什么?

- 克隆本文的代码,运行一个简化版的智能体;

- 扩展智能体功能(如交易辅助智能体生成合同);

- 尝试将联邦学习整合到平台中,处理敏感数据。

六、行动号召:一起聊聊AI智能体的实践

如果你在实践中遇到问题(如API调用失败、向量数据库配置错误),欢迎在评论区留言讨论;

如果你有更好的AI智能体设计方案,也欢迎分享;

后续我会写《AI智能体的多模态数据交易》《联邦学习在数据交易中的应用》等文章,敬请关注!

最后一句话:AI智能体不是“替代人”,而是“辅助人”——它能帮你处理繁琐的重复工作,让你有更多时间思考更有价值的问题。

Happy Coding!🚀

更多推荐

已为社区贡献21条内容

已为社区贡献21条内容

所有评论(0)