如何搭建私有知识库?这份入门级教程快收好

而软件以其一键部署功能脱颖而出。本地部署就是把AI模型和数据全都放在公司内部的网络里,形成一道坚固的“围墙”,从根本上解决了数据泄露的担心。所有数据处理都能在本地局域网内完成,从根本上杜绝了数据泄露的风险,为使用者提供了强大的隐私保障,确保敏感信息的安全。即使是没有任何技术背景的小白用户,也能通过直观的界面和简洁的步骤,轻松完成模型的下载、安装和配置。租用外面的AI服务,是按使用次数付费的,用得多

现在,人工智能特别火,很多公司都想用上人工智能(AI)大模型来帮忙工作。但是,一提到用这些模型,老板和工程师们就开始头疼:"数据安全怎么办?网络延迟怎么办?长期成本怎么办?"

所以,一个关键问题就出现了:怎么实现局域网大模型部署?也就是说,能不能把这么强大的AI大脑,直接“请”到我们自己的内部网络里来呢?答案当然是可以!今天,我们就来科普一下,怎么实现局域网大模型部署,以及它能为我们带来什么。

一、 为啥企业都想把大模型“请进门”?

把大模型放在自家机房,听起来很厉害,但具体有啥好处呢?主要是三点:更安全、更快、更划算。

①安全放心,关起门来用:公司最重要的就是核心数据和商业秘密。就像你不会把账本随便放在外面一样,公司的数据也一样。本地部署就是把AI模型和数据全都放在公司内部的网络里,形成一道坚固的“围墙”,从根本上解决了数据泄露的担心。

②速度飞快,沟通没延迟:用自己的网络,就像在办公室里同事之间面对面说话,又快又清楚。不用担心因为网络卡顿导致AI反应慢半拍。

③一次投入,长期省钱:租用外面的AI服务,是按使用次数付费的,用得多,费用就高。而本地部署更像是一次投资,用得越多越划算。

因此,怎么实现局域网大模型部署,对于有特定需求的组织而言,是一个值得深入探讨的战略性技术选项

二、 局域网部署大模型的核心技术环节

将这样一个大模型“请进”自家的机房,并让它稳定高效地运行起来,主要涉及以下几个技术环节:

硬件准备:大模型需要强大的计算资源,尤其是高性能的GPU,同时,也需要足够的内存和硬盘空间来存放模型和数据。

环境配置:需要在服务器上安装操作系统、显卡驱动、深度学习框架以及无数的依赖库,非常考验技术人员的耐心和经验。

模型获取与优化:原始模型通常非常庞大,直接部署对硬件要求极高。因此,采用模型量化、模型剪枝等技术,让其能在成本可控的硬件上运行。

部署与集成:将优化后的模型部署到服务器上,并启动推理服务,企业的开发团队就可以将这些API集成到现有的业务应用。

三、 实现路径:从概念到落地

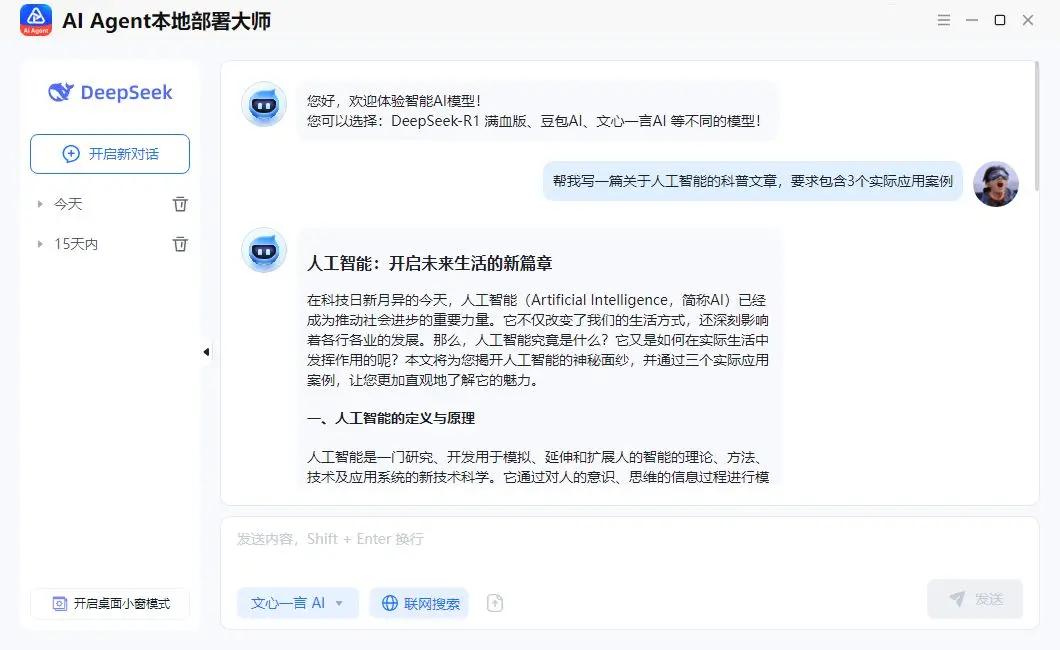

对于大多数技术力量并非顶尖的个人或组织来说,怎么实现局域网大模型部署呢?其实,目前市场上就有一些本地部署的工具,它们能够大幅简化部署流程。帮助用户轻松实现将大模型部署在本地的操作。就比如这款『AI Agent本地部署大师』,它的厉害之处体现在:

一键部署:轻松搭建本地AI环境

用传统方式部署AI模型需要专业的技术知识,而且步骤繁琐,容易出错。而软件以其一键部署功能脱颖而出。无需复杂的配置和繁琐的步骤,只需点击几下,即可完成整个部署过程。节省时间同时还降低了技术门槛,让每个人都能轻松上手。

数据安全:保障用户隐私

在使用时,大家无需将数据上传至任何云端服务器。所有数据处理都能在本地局域网内完成,从根本上杜绝了数据泄露的风险,为使用者提供了强大的隐私保障,确保敏感信息的安全。

多个模型:满足多样化需求

它内置了多种主流AI模型,包括Deepseek、文心一言、豆包等。大家可以根据自身需求,自由切换不同的模型,从而提高工作效率和使用体验。

操作简单:小白也能轻松上手

软件的界面简洁明了,操作流程简单易懂。即使是没有任何技术背景的小白用户,也能通过直观的界面和简洁的步骤,轻松完成模型的下载、安装和配置。

通过今天的介绍,相信大家已经对怎么实现局域网大模型部署有了清晰的了解。无论是企业组织,还是个人使用者,都可以通过『AI Agent本地部署大师』,轻松地在自己的局域网环境中部署强大的AI模型。感兴趣的小伙伴不妨试试,开启你的局域网AI之旅!

更多推荐

已为社区贡献5条内容

已为社区贡献5条内容

所有评论(0)