昆虫识别分类-计算机毕设-人工智能

本文介绍了一个基于深度学习的昆虫识别分类项目,该项目实现了9种常见模型(包括CNN和Transformer架构),并采用CBAM注意力机制优化模型性能。项目包含详细的数据集、代码实现、训练日志和可视化实验效果(准确率达97%以上),支持多模型对比实验和混淆矩阵分析。最终基于Django框架开发了演示系统,实现了从理论到应用的完整闭环。适合计算机毕设参考。

大家好,我是B站的UP主:我喜欢吃小熊饼干。我在CSDN会写一些文章介绍我做的项目,这些项目我都录制了详细的讲解视频(约4-6个小时的内容量),讲解基础知识,环境配置,代码使用等内容。

详细了解请移步:

详细讲解视频-我喜欢吃小熊饼干-哔哩哔哩视频![]() https://space.bilibili.com/284801305

https://space.bilibili.com/284801305

几分钟快速预览项目效果的演示视频:

【计算机毕设】基于深度学习的昆虫识别分类【CNN】【Transformer】【卷积神经网络】

详细的讲解视频合集:

- 合集第一集:主要讲对整个教程的介绍,深度学习项目的基本做法和基本概念。然后介绍具体该项目的基本做法。如何去扩张项目,增加更多的内容。(这里不会涉及到代码,纯从项目的做法的角度,以PPT讲解的方式带大家入门,建立深度学习的基本概念)

- 合集第二集:毕设选题指导,毕设服务等内容

- 合集第三集:从代码使用和演示的角度,介绍项目的内容。科普深度学习环境配置的知识,如何配置项目,如何使用项目,更换数据集训练,完成特定的课题。

- 合集第四集:讲解文档相关的内容,开题报告、开题ppt、开题答辩,论文写作,论文答辩等

第一集和第三集比较重要,可以整体看下这两个视频。

下面我用文字介绍一下项目的内容

项目的背景意义:

昆虫作为地球上物种数量最庞大、分布最广泛的生物类群,是生态系统中物质循环、能量流动与信息传递的关键纽带,既承担着授粉、分解有机物的重要生态功能,也与农业生产、人类健康及生物多样性保护息息相关。然而,传统昆虫识别与分类模式长期受限于经验依赖与效率瓶颈,难以适配现代社会对生态保护、产业安全及科研创新的精细化需求:在生态领域,人工调查难以全面掌握昆虫种群的动态变化,无法及时捕捉生态失衡的早期信号,如关键传粉昆虫数量锐减对植物繁衍的影响、入侵性昆虫扩散对本地生态系统的破坏,进而制约生态修复与生物多样性保护工作的精准推进;在农业生产中,害虫与益虫的鉴别依赖人工经验,易因形态相似性导致误判,不仅可能误杀天敌昆虫破坏田间生态平衡,还可能错过害虫防治的最佳时机,加剧农作物损失,同时盲目用药也会造成农业面源污染,违背绿色农业发展理念;在公共卫生领域,部分昆虫是疾病传播的媒介,人工识别效率低、准确率不稳定,难以快速响应媒介昆虫引发的公共卫生风险,影响防控措施的及时落地。

随着生态保护战略的深入推进与农业现代化的加速发展,社会对昆虫识别分类的精准性、时效性与规模化提出了更高要求。一方面,生态监测需要更高效的技术手段,实现对不同生境中昆虫群落的动态追踪,为生态系统健康评估提供科学依据;另一方面,农业生产亟需突破传统鉴别局限,构建 “精准识别 - 科学防控” 的管理模式,在保障作物安全的同时减少化学药剂使用;此外,昆虫学研究的深化也需要更系统的分类数据支撑,推动物种演化、生物地理分布等领域的科研创新,为珍稀昆虫资源保护与利用提供理论基础。

昆虫识别分类项目依托计算机视觉与深度学习技术,突破人工识别的经验壁垒与效率瓶颈,能够精准捕捉昆虫的形态特征、纹理细节与行为轨迹,实现对不同类群昆虫的高效分类与属性判断。这一技术突破的价值不仅体现在解决当下痛点,更在于为多领域发展提供底层支撑:在生态保护层面,它能助力构建更全面的昆虫种群监测网络,及时预警生态风险,为生物多样性保护策略的制定提供数据支撑,维护生态系统的稳定与平衡;在农业领域,它可推动病虫害防控从 “广谱防治” 向 “精准靶向” 转型,减少资源浪费与环境污染,助力绿色农业与可持续农业发展;在科研领域,它能加速昆虫物种资源的数字化整理与研究,为昆虫学及相关交叉学科的创新提供技术赋能,推动科学认知的深化;在公共卫生领域,它可提升媒介昆虫识别与监测的效率,为疾病防控争取宝贵时间,守护人类健康安全。

从长远来看,昆虫识别分类技术不仅是单一领域的技术革新,更是推动生态保护、农业发展、科研创新与公共卫生协同进步的重要纽带,其价值贯穿于生态安全、粮食安全与人类健康等多个维度,对构建人与自然和谐共生的可持续发展格局具有深远的意义。

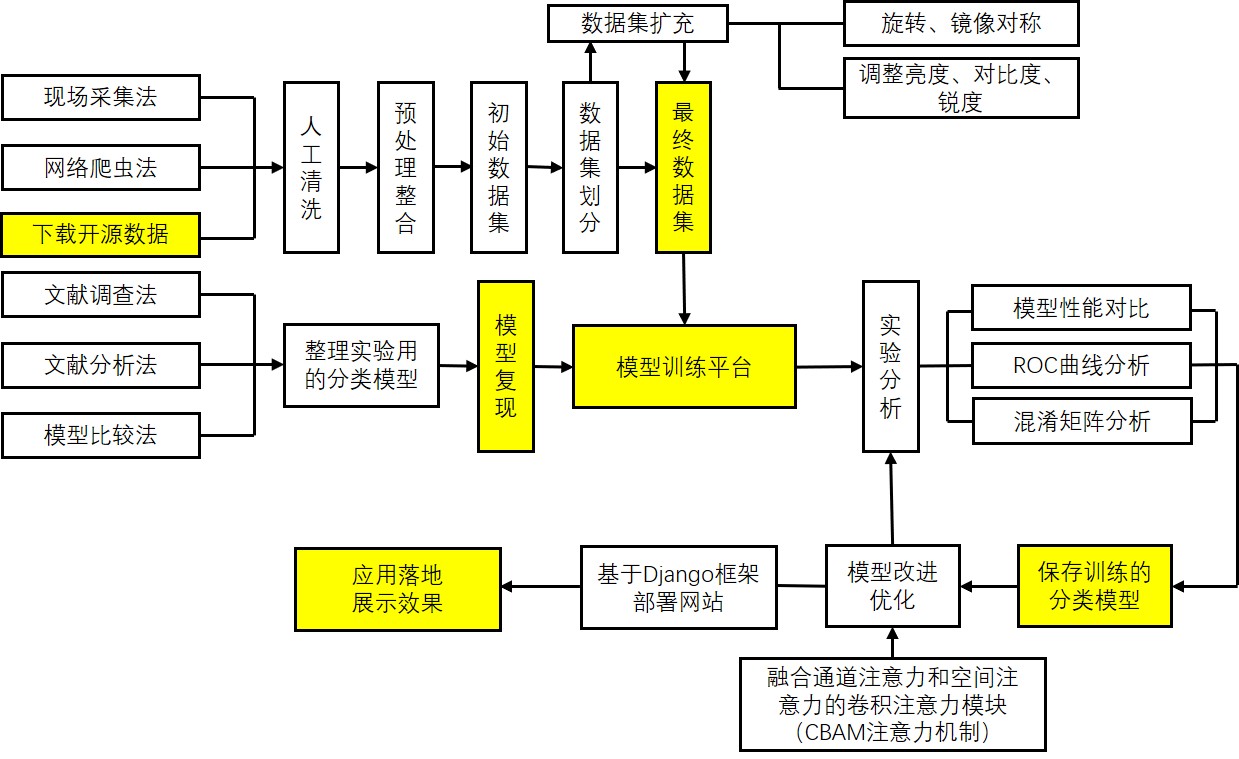

项目的技术路线图

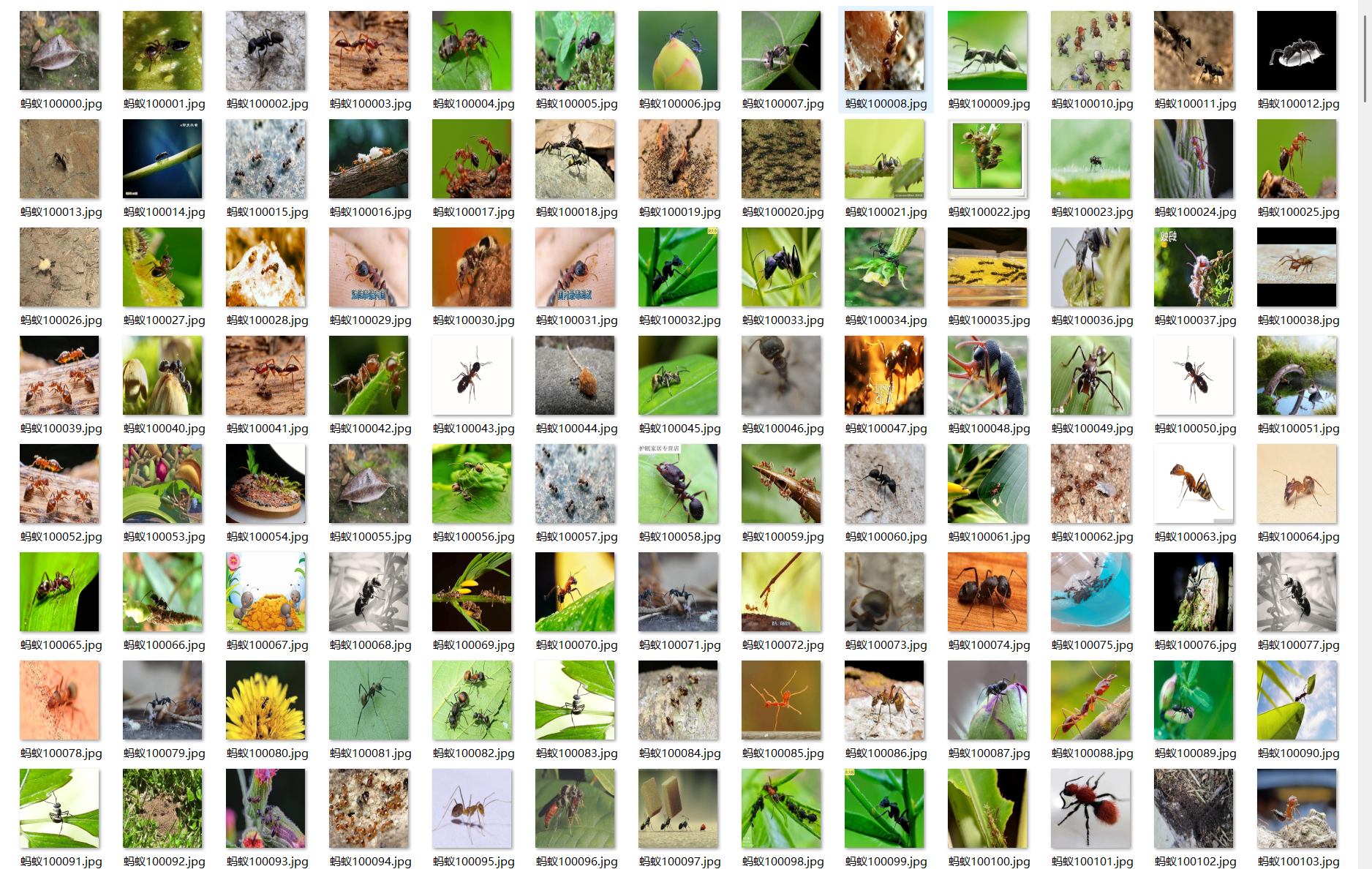

项目的数据集信息如下:

项目里实现了9种常见的模型,包括:

CNN架构的模型:

1.AlexNet

2.VGG

3.ResNet

4.MobileNet

5.DenseNet

6.ConvNeXt

7.ShuffleNet

Transformer架构的模型:

8. Swin_Transformer

9. VIT

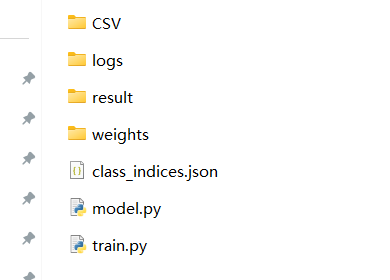

在我的设计的项目里,一般结构如下:

model.py: 定义模型结构

train.py:训练模型

csv文件夹里是每次训练模型生成的日志文件

logs文件夹里是TensorBoard的日志文件

weights文件夹里存储最终训练得到的模型。

举例子,ResNet模型的核心代码如下(其他模型类似,不在赘述):

class BasicBlock(nn.Module):

expansion = 1

def __init__(self, in_channel, out_channel, stride=1, downsample=None, **kwargs):

super(BasicBlock, self).__init__()

self.conv1 = nn.Conv2d(in_channels=in_channel, out_channels=out_channel,

kernel_size=3, stride=stride, padding=1, bias=False)

self.bn1 = nn.BatchNorm2d(out_channel)

self.relu = nn.ReLU()

self.conv2 = nn.Conv2d(in_channels=out_channel, out_channels=out_channel,

kernel_size=3, stride=1, padding=1, bias=False)

self.bn2 = nn.BatchNorm2d(out_channel)

self.downsample = downsample

def forward(self, x):

identity = x

if self.downsample is not None:

identity = self.downsample(x)

out = self.conv1(x)

out = self.bn1(out)

out = self.relu(out)

out = self.conv2(out)

out = self.bn2(out)

out += identity

out = self.relu(out)

return out

class Bottleneck(nn.Module):

expansion = 4

def __init__(self, in_channel, out_channel, stride=1, downsample=None,

groups=1, width_per_group=64):

super(Bottleneck, self).__init__()

width = int(out_channel * (width_per_group / 64.)) * groups

self.conv1 = nn.Conv2d(in_channels=in_channel, out_channels=width,

kernel_size=1, stride=1, bias=False) # squeeze channels

self.bn1 = nn.BatchNorm2d(width)

# -----------------------------------------

self.conv2 = nn.Conv2d(in_channels=width, out_channels=width, groups=groups,

kernel_size=3, stride=stride, bias=False, padding=1)

self.bn2 = nn.BatchNorm2d(width)

# -----------------------------------------

self.conv3 = nn.Conv2d(in_channels=width, out_channels=out_channel*self.expansion,

kernel_size=1, stride=1, bias=False) # unsqueeze channels

self.bn3 = nn.BatchNorm2d(out_channel*self.expansion)

self.relu = nn.ReLU(inplace=True)

self.downsample = downsample

def forward(self, x):

identity = x

if self.downsample is not None:

identity = self.downsample(x)

out = self.conv1(x)

out = self.bn1(out)

out = self.relu(out)

out = self.conv2(out)

out = self.bn2(out)

out = self.relu(out)

out = self.conv3(out)

out = self.bn3(out)

out += identity

out = self.relu(out)

return out

class ResNet(nn.Module):

def __init__(self,

block,

blocks_num,

num_classes=1000,

include_top=True,

groups=1,

width_per_group=64):

super(ResNet, self).__init__()

self.include_top = include_top

self.in_channel = 64

self.groups = groups

self.width_per_group = width_per_group

self.conv1 = nn.Conv2d(3, self.in_channel, kernel_size=7, stride=2,

padding=3, bias=False)

self.bn1 = nn.BatchNorm2d(self.in_channel)

self.relu = nn.ReLU(inplace=True)

self.maxpool = nn.MaxPool2d(kernel_size=3, stride=2, padding=1)

self.layer1 = self._make_layer(block, 64, blocks_num[0])

self.layer2 = self._make_layer(block, 128, blocks_num[1], stride=2)

self.layer3 = self._make_layer(block, 256, blocks_num[2], stride=2)

self.layer4 = self._make_layer(block, 512, blocks_num[3], stride=2)

if self.include_top:

self.avgpool = nn.AdaptiveAvgPool2d((1, 1)) # output size = (1, 1)

self.fc = nn.Linear(512 * block.expansion, num_classes)

for m in self.modules():

if isinstance(m, nn.Conv2d):

nn.init.kaiming_normal_(m.weight, mode='fan_out', nonlinearity='relu')

def _make_layer(self, block, channel, block_num, stride=1):

downsample = None

if stride != 1 or self.in_channel != channel * block.expansion:

downsample = nn.Sequential(

nn.Conv2d(self.in_channel, channel * block.expansion, kernel_size=1, stride=stride, bias=False),

nn.BatchNorm2d(channel * block.expansion))

layers = []

layers.append(block(self.in_channel,

channel,

downsample=downsample,

stride=stride,

groups=self.groups,

width_per_group=self.width_per_group))

self.in_channel = channel * block.expansion

for _ in range(1, block_num):

layers.append(block(self.in_channel,

channel,

groups=self.groups,

width_per_group=self.width_per_group))

return nn.Sequential(*layers)

def forward(self, x):

x = self.conv1(x)

x = self.bn1(x)

x = self.relu(x)

x = self.maxpool(x)

x = self.layer1(x)

x = self.layer2(x)

x = self.layer3(x)

x = self.layer4(x)

if self.include_top:

x = self.avgpool(x)

x = torch.flatten(x, 1)

x = self.fc(x)

return x并且项目对模型进行了优化改进,改进的内容是增加CBAM注意力机制,项目里可以实现对以上任意一种模型增加CBAM注意力机制。

常见的做法是先选择2-4种候选模型(9种模型都用有点多,推荐选部分你喜欢的模型)做对比实验,选出性能最好的模型,在最优的模型的基础上,进一步增加cbam注意力机制,进行优化改进。如果老师要求高,可以在进一步做消融实验(即模型改进优化前后的对比实验)。

CBAM机制的核心代码如下:

# CBAM 注意力模块实现 (可复用)

class CBAM(nn.Module):

def __init__(self, channels: int, reduction_ratio: int = 16, kernel_size: int = 7):

super(CBAM, self).__init__()

# 通道注意力

self.channel_att = nn.Sequential(

nn.AdaptiveAvgPool2d(1),

nn.Conv2d(channels, channels // reduction_ratio, kernel_size=1, bias=False),

nn.ReLU(inplace=True),

nn.Conv2d(channels // reduction_ratio, channels, kernel_size=1, bias=False),

nn.Sigmoid()

)

# 空间注意力

self.spatial_att = nn.Sequential(

nn.Conv2d(2, 1, kernel_size=kernel_size, padding=kernel_size // 2, bias=False),

nn.Sigmoid()

)

def forward(self, x: torch.Tensor) -> torch.Tensor:

# 通道注意力

channel_att = self.channel_att(x)

x_channel = x * channel_att

# 空间注意力

max_pool = torch.max(x_channel, dim=1, keepdim=True)[0]

avg_pool = torch.mean(x_channel, dim=1, keepdim=True)

spatial_att = self.spatial_att(torch.cat([max_pool, avg_pool], dim=1))

x_out = x_channel * spatial_att

return x_out

CBAM结构的示意图如下:

CBAM注意力机制是一种用于前馈卷积神经网络的简单而有效的注意力模块。 给定一个中间特征图,CBAM模块会沿着两个独立的维度(通道和空间)依次推断注意力图,然后将注意力图与输入特征图相乘以进行自适应特征优化。 由于CBAM是轻量级的通用模块,因此可以忽略的该模块的开销而将其无缝集成到任何CNN架构中,并且可以与基础CNN一起进行端到端训练。

首先,输入是一个中间特征图,将特征图输入至Channel Attention Module 获取通道注意力,然后将注意力权重作用于中间特征图。

然后,将施加通道注意力的特征图输入至Spatial Attention Module 获取空间注意力,然后将注意力权重作用到特征图上。

最终,经过这两个注意力模块的串行操作,最初的特征图就经过了通道和空间两个注意力机制的处理,自适应细化特征。

训练完模型可以做对比实验,通过写代码可以制作对比曲线图和柱状图,项目的最终实验效果如下:

模型最终能达到97%以上

除了对比实验之外,还可以进一步分析模型的性能,其中

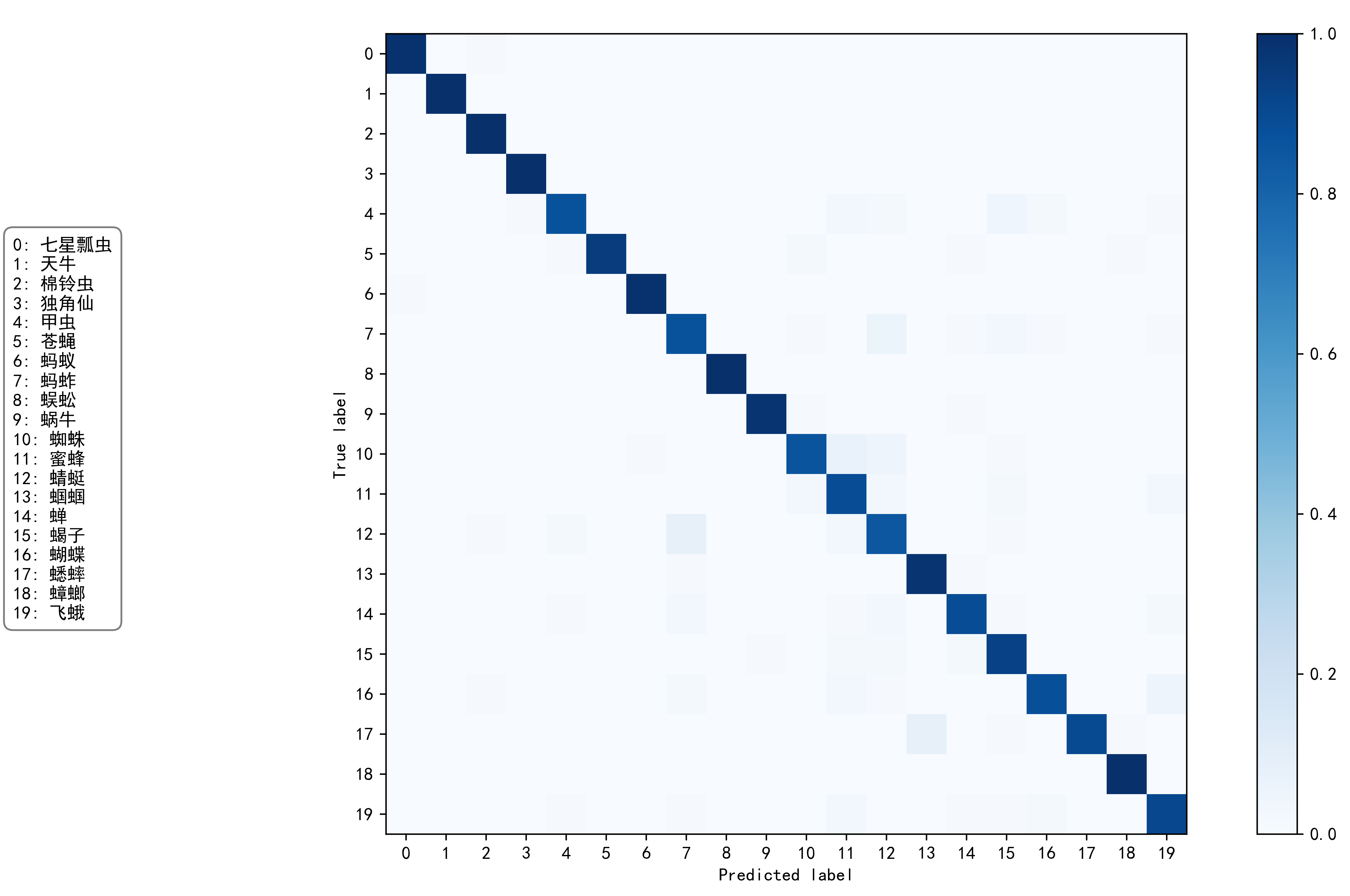

混淆矩阵实验图如下:

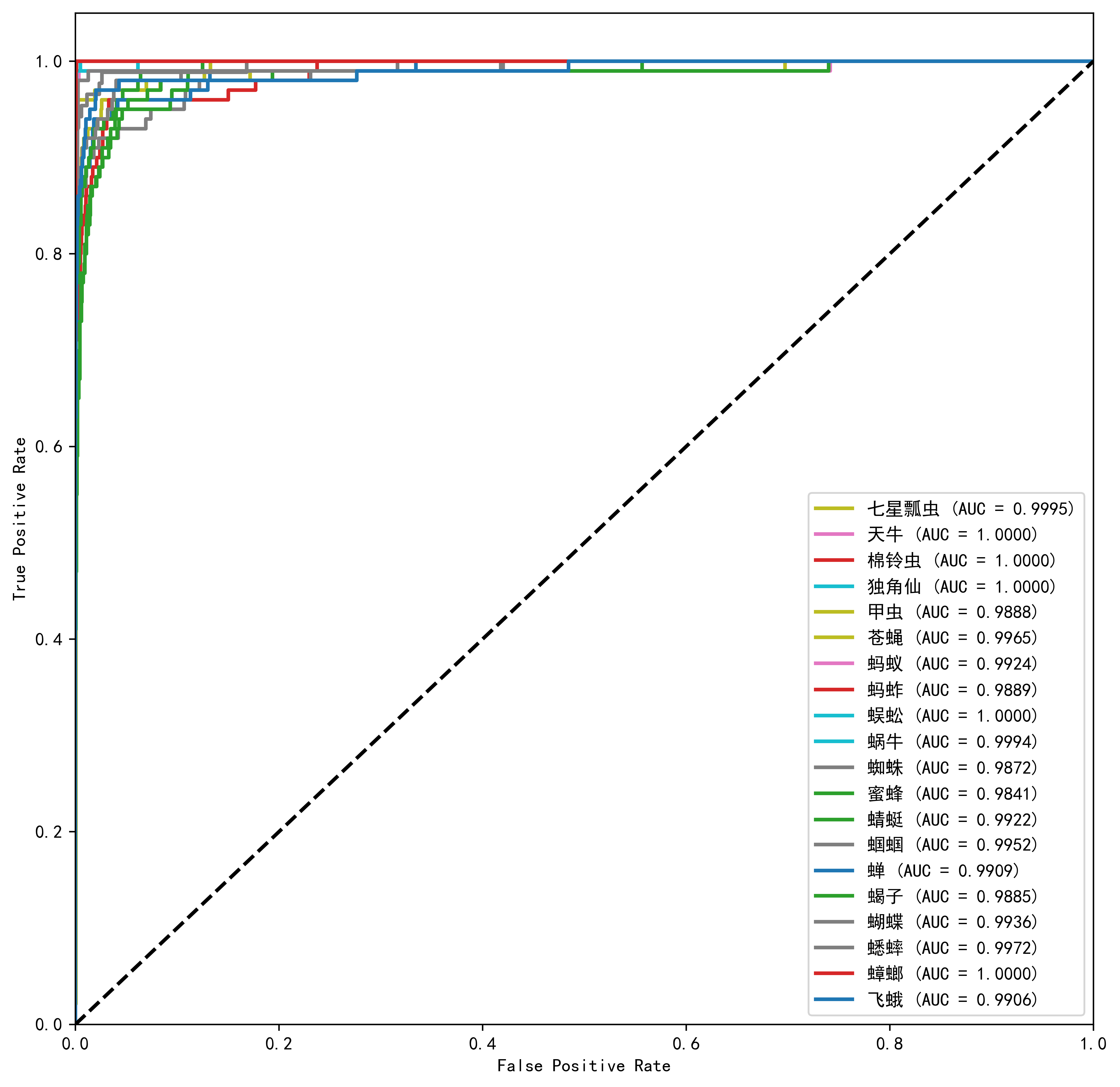

ROC曲线实验图如下:

以上是实验的内容。

最后基于Python的Django框架,制作最终的演示系统,最终结果预览如下:

本项目包含:

1.多模型的对比实验和图表,丰富了项目的内容。

2. 模型的优化改进,实现项目的重新。

3. 混淆矩阵和ROC等实验分析,拓展的项目的深度和内容量

4.实现了最终的演示系统,实现了项目的落地和应用。

更多推荐

已为社区贡献2条内容

已为社区贡献2条内容

所有评论(0)