计算机组成原理:计算机的发展史

技术迭代的核心逻辑:从电子管到人工智能芯片,从磁芯存储器到3D NAND,从单核CPU到异构计算,每一次突破都围绕“提升算力、降低成本、缩小体积、减少功耗”四大目标,而摩尔定律的持续推动(尽管放缓)是算力指数级增长的核心动力。硬件与软件的协同进化:硬件的进步为软件创新提供基础(如多核CPU推动多任务操作系统发展,GPU催生AI深度学习框架),软件的需求又反过来驱动硬件升级(如4K视频推动显卡带宽提

📌目录

- 🕰️ 计算机的发展史:从机械齿轮到智能芯片的百年演进

- 一,计算机的五代变化:以核心元器件为标志的技术跃迁

- 二,半导体存储器的发展:从“磁芯”到“3D NAND”的存储革命

- 三,微处理器的发展:CPU的“摩尔定律”之路

- 四,计算机的性能指标:衡量“算力”的核心维度

- 📝 总结:计算机发展的核心逻辑与未来展望

🕰️ 计算机的发展史:从机械齿轮到智能芯片的百年演进

计算机的诞生与发展,是人类探索“自动化计算”的伟大历程。从19世纪的机械计算器,到如今支撑人工智能、云计算的智能终端,计算机不仅改变了信息处理的方式,更重塑了社会生产与生活的方方面面。本文将以“技术革新”为主线,系统梳理计算机的五代演进脉络、核心硬件(半导体存储器、微处理器)的发展历程,并解析衡量计算机能力的关键性能指标,带您看懂计算机如何从“笨重的计算工具”进化为“智能时代的核心引擎”。

一,计算机的五代变化:以核心元器件为标志的技术跃迁

计算机的发展通常以“核心电子元器件”的迭代为划分依据,每一代的突破都带来算力、体积、功耗的革命性变化,形成了从“电子管”到“人工智能芯片”的五代演进路径。

(一)第一代计算机:电子管时代(1946-1957)—— 笨重的“计算巨人”

第一代计算机以“电子管”为核心元器件,标志着人类从“机械计算”迈入“电子计算”时代,但其体积庞大、功耗惊人,仅能满足基础科学计算需求。

1. 核心特征

- 元器件:采用真空电子管(如ENIAC使用了18000多个电子管),电子管体积如灯泡般大小,需大量散热装置;

- 存储设备:使用汞延迟线存储器(利用汞柱中声波传递存储数据)或磁鼓存储器,存储容量极小(ENIAC仅能存储20个10位十进制数);

- 软件系统:无操作系统,程序需通过插拔电线(ENIAC)或打孔纸带输入,编程语言为机器语言(二进制指令);

- 体积与功耗:占地面积达几十平方米(ENIAC占地170平方米),重量数十吨,功耗高达上百千瓦(ENIAC每小时耗电150度)。

2. 代表机型与应用

- ENIAC(埃尼阿克):1946年诞生于美国宾夕法尼亚大学,世界第一台电子数字计算机,最初用于计算炮弹弹道轨迹;

- UNIVAC-I(尤尼瓦克):1951年投入商用,首次用于美国人口普查,开创了计算机“商业应用”的先河。

3. 时代局限

- 可靠性差:电子管寿命短(平均几百小时),频繁烧毁导致停机;

- 效率低下:编程耗时数天,单次计算需人工干预,无法实现连续自动运行。

(二)第二代计算机:晶体管时代(1958-1964)—— 小型化与商业化的开端

1947年晶体管的发明(贝尔实验室),彻底替代了笨重的电子管,使计算机进入“小型化、低功耗”时代,同时操作系统和高级语言的出现,大幅降低了编程门槛。

1. 核心特征

- 元器件:采用半导体晶体管(体积仅电子管的1/100,功耗仅1/10),无需庞大散热装置,计算机体积缩小至几立方米;

- 存储设备:磁芯存储器成为主流(利用磁性材料的磁化方向存储数据),存储容量提升至数十KB(如IBM 7090存储容量达128KB);

- 软件系统:出现批处理操作系统(如IBM OS/360雏形),支持多任务批量处理;诞生FORTRAN、COBOL等高级语言,程序员无需直接编写二进制指令。

2. 代表机型与应用

- IBM 7090:1959年推出,广泛用于科学计算(如航天轨道计算)和企业数据处理;

- CDC 6600:1964年诞生,世界首台“超级计算机”,运算速度达1MIPS(百万条指令/秒),用于核物理研究。

3. 时代突破

- 可靠性显著提升:晶体管寿命达数千小时,停机时间大幅减少;

- 应用场景扩展:从军事、科研走向企业(如银行账目管理、企业生产调度),计算机开始成为“商业工具”。

(三)第三代计算机:集成电路时代(1965-1970)—— 规模化与标准化的飞跃

1958年集成电路(IC)的发明(德州仪器),将多个晶体管集成到一块硅片上,使计算机进入“规模化生产”时代,同时分时操作系统的出现,实现了“多人共享一台计算机”。

1. 核心特征

- 元器件:采用中、小规模集成电路(MSI/SSI,一块芯片集成数十至数百个晶体管),计算机体积缩小至桌面大小(如PDP-8小型机);

- 存储设备:磁芯存储器容量提升至数百KB,同时出现磁盘存储器(如IBM 3330硬盘,存储容量达100MB),数据读写速度大幅提升;

- 软件系统:分时操作系统(如UNIX雏形)支持多个用户通过终端同时操作一台计算机,资源利用率提升10倍以上;数据库管理系统(DBMS)诞生,实现海量数据的结构化存储。

2. 代表机型与应用

- IBM System/360:1964年推出,首款“兼容机系列”(不同型号可兼容软件),占据全球大型机市场70%份额,奠定IBM的行业霸主地位;

- DEC PDP-8:1965年推出,首款“小型计算机”,价格仅1.8万美元(大型机需数百万美元),广泛用于高校实验室和中小型企业。

3. 时代意义

- 标准化体系形成:硬件兼容、软件可移植,计算机从“定制化设备”变为“标准化产品”;

- 成本大幅降低:集成电路量产使单价下降,计算机开始从“少数机构专属”走向“更多企业普及”。

(四)第四代计算机:大规模集成电路时代(1971-至今)—— 个人计算机与互联网的崛起

1971年微处理器(CPU)的发明(英特尔4004),将计算机的核心部件集成到一块芯片上,催生了“个人计算机(PC)”,同时互联网的普及,使计算机从“单机计算”走向“互联互通”。

1. 核心特征

- 元器件:采用大规模/超大规模集成电路(LSI/VLSI,一块芯片集成数万至数千万个晶体管),计算机体积缩小至笔记本大小;

- 存储设备:半导体存储器(DRAM)替代磁芯存储器,内存容量从MB级(1980年代)提升至GB级(2000年代);固态硬盘(SSD)逐步替代机械硬盘,读写速度提升100倍以上;

- 软件系统:图形化操作系统(Windows、macOS)普及,鼠标、图形界面让普通人无需专业知识即可操作计算机;互联网协议(TCP/IP)标准化,计算机实现全球互联。

2. 关键里程碑

- 1971年:英特尔推出4004微处理器,首次将CPU集成到单芯片,为PC诞生奠定基础;

- 1981年:IBM推出IBM 5150(首款IBM PC),采用英特尔8088处理器和MS-DOS系统,确立PC硬件标准;

- 1984年:苹果推出Macintosh,首款普及的图形界面PC,彻底改变人机交互方式;

- 1991年:万维网(WWW)诞生,计算机从“数据处理工具”变为“信息获取与交流平台”。

3. 时代变革

- 个人计算机普及:1990年代后PC价格降至千元级别,进入家庭和个人生活,催生了软件产业(如办公软件、游戏、互联网应用);

- 移动计算崛起:2007年苹果iPhone发布,智能手机成为“口袋里的计算机”,移动互联网时代来临。

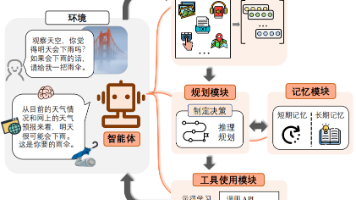

(五)第五代计算机:人工智能时代(1980年代至今,持续演进)—— 从“计算”到“智能”的跨越

第五代计算机并非以单一元器件为标志,而是以“智能计算”为核心目标,通过专用芯片、大数据和算法融合,实现“自主学习、推理和决策”,目前仍处于快速发展阶段。

1. 核心特征

- 硬件架构:从通用CPU转向“CPU+专用加速器”混合架构,如GPU(图形处理器)、TPU(张量处理器)、NPU(神经网络处理器),专门优化人工智能任务(如深度学习模型训练与推理);

- 软件核心:人工智能算法(机器学习、深度学习)成为核心,计算机从“按指令执行”变为“从数据中学习规律”;

- 能力突破:具备语音识别、图像识别、自然语言处理等感知能力,可自主完成复杂任务(如自动驾驶、智能推荐、医疗诊断)。

2. 代表成果

- 1997年:IBM“深蓝”超级计算机击败国际象棋世界冠军卡斯帕罗夫,标志计算机在特定领域超越人类;

- 2016年:谷歌DeepMind“阿尔法狗”击败围棋世界冠军李世石,证明计算机在复杂策略性任务中的优势;

- 2020年至今:ChatGPT等大语言模型爆发,计算机具备接近人类的自然语言理解与生成能力,推动“通用人工智能”研究。

3. 时代方向

- 算力持续升级:量子计算机、光子计算机等新型计算技术探索突破经典算力极限;

- 场景深度融合:计算机与物联网、机器人、自动驾驶等结合,从“工具”变为“智能体”,融入社会生产生活的每个角落。

二,半导体存储器的发展:从“磁芯”到“3D NAND”的存储革命

存储器是计算机的“记忆中枢”,负责存储程序和数据,其发展直接决定计算机的运行效率和数据处理能力。从早期的磁芯存储器到如今的3D NAND闪存,半导体存储器的演进核心是“高密度、高速度、低功耗”。

(一)早期存储技术:机械与磁性的探索(1940s-1960s)

在半导体存储器出现前,计算机依赖机械或磁性存储设备,体积大、速度慢,成为算力提升的瓶颈。

- 汞延迟线存储器(1940s):利用声波在汞柱中的传播延迟存储数据,ENIAC采用此技术,存储周期达毫秒级,容量仅几十字节;

- 磁鼓存储器(1950s):圆柱形金属鼓表面涂覆磁性材料,通过磁头读写数据,容量达KB级,但体积如洗衣机大小;

- 磁芯存储器(1950s-1960s):用微小磁环(直径0.1mm)的磁化方向表示0/1,是首个普及的“随机访问存储器”(可直接访问任意地址数据),容量达数百KB,成为第三代计算机的主流存储,但需手工编织磁芯阵列,成本高昂。

(二)半导体存储器的崛起:DRAM与SRAM的分工(1970s-1980s)

1968年英特尔成立后,率先推动半导体存储器替代磁芯,按“是否需要刷新”分为DRAM和SRAM,形成“内存分层”体系。

1. DRAM(动态随机存取存储器)

- 原理:利用电容器存储电荷表示数据,需每隔几毫秒“刷新”一次(电荷会泄漏),否则数据丢失;

- 特点:集成度高(电容器体积小)、成本低、功耗中等,适合作为计算机“主内存”(内存);

- 里程碑:1970年英特尔推出1103 DRAM(1KB容量),1980年代容量提升至1MB,逐步替代磁芯存储器,成为PC内存的标准。

2. SRAM(静态随机存取存储器)

- 原理:利用晶体管组成的锁存器存储数据,无需刷新,通电时数据持续保留;

- 特点:速度快(访问时间达纳秒级,比DRAM快10倍以上)、功耗高、集成度低(锁存器占空间大),适合作为CPU“高速缓存(Cache)”;

- 应用:1980年代后,CPU开始集成L1、L2 Cache(SRAM),解决“CPU速度快、内存速度慢”的瓶颈。

(三)闪存技术:非易失性存储的突破(1980s-至今)

DRAM和SRAM均为“易失性存储器”(断电数据丢失),1984年闪存(Flash Memory)的发明,实现了“断电不丢失数据”的半导体存储,彻底改变了外部存储格局。

1. 核心优势

- 非易失性:无需通电即可保存数据,替代传统机械硬盘(HDD)的磁性存储;

- 无机械结构:抗震性强、读写速度快(比HDD快100倍)、功耗低,适合移动设备(手机、笔记本)。

2. 技术演进

- NOR闪存(1988年):支持随机访问,速度快,适合存储程序(如手机ROM),但容量小、成本高;

- NAND闪存(1989年):采用串行访问,容量大、成本低,适合存储数据(如U盘、固态硬盘),逐步成为主流;

- 3D NAND闪存(2013年):传统NAND为平面结构(2D),3D NAND通过“堆叠多层存储单元”提升容量(如三星128层3D NAND,单芯片容量达1TB),同时降低功耗和成本,目前已全面替代2D NAND。

3. 应用革命

- 2000年代:U盘、SD卡普及,替代软盘、光盘成为移动存储介质;

- 2010年代:固态硬盘(SSD)价格下降,逐步替代机械硬盘(HDD)成为PC和服务器的主流存储;

- 2020年代:手机、平板等移动设备全面采用闪存,实现“无机械噪音、秒速开机”的用户体验。

(四)未来方向:更高密度与新型存储

- 3D XPoint:英特尔与美光联合推出的新型存储,速度接近DRAM,容量接近NAND,兼具易失性与非易失性优势,用于高端服务器缓存;

- 存储级内存(SCM):模糊“内存”与“硬盘”的界限,实现“内存速度、硬盘容量”,进一步提升计算机数据处理效率;

- DNA存储:利用DNA分子的碱基序列存储数据,密度达1立方厘米存储1EB(10亿GB),适合长期归档(如数据中心备份),目前处于实验室阶段。

三,微处理器的发展:CPU的“摩尔定律”之路

微处理器(CPU)是计算机的“大脑”,负责执行指令和处理数据,其发展遵循“摩尔定律”(1965年英特尔创始人戈登·摩尔提出:集成电路上的晶体管数量每18-24个月翻一番),从4位芯片发展到64位多核处理器,算力呈指数级增长。

(一)早期微处理器:从“4位”到“8位”的萌芽(1971-1977)

微处理器的诞生源于“将CPU集成到单芯片”的构想,早期产品功能简单,主要用于计算器和小型设备。

- Intel 4004(1971年):世界首款微处理器,4位架构,集成2300个晶体管,时钟频率108kHz,仅能执行简单算术运算,用于计算器和交通信号灯控制;

- Intel 8008(1972年):8位架构,集成3500个晶体管,首次支持字符显示,用于早期终端设备;

- Intel 8080(1974年):8位架构,集成6000个晶体管,时钟频率2MHz,成为首款“通用微处理器”,用于世界首台个人计算机Altair 8800(1975年)。

(二)x86架构的崛起:PC时代的“统治级”CPU(1978-1990s)

1978年英特尔8086处理器的推出,确立了x86架构(32位),此后x86成为PC和服务器的主流架构,至今仍占据主导地位。

- Intel 8086(1978年):16位架构,集成2.9万个晶体管,时钟频率5-10MHz,支持1MB内存,为IBM PC(1981年)的诞生奠定基础;

- Intel 80386(1985年):32位架构,集成27.5万个晶体管,时钟频率16-33MHz,首次支持多任务和虚拟内存,推动Windows操作系统普及;

- Intel Pentium(奔腾)(1993年):32位架构,集成310万个晶体管,时钟频率60-200MHz,性能大幅提升,成为1990年代PC的标配CPU,同时AMD推出兼容x86的AM386、K5等处理器,形成“英特尔-AMD”双雄格局。

(三)多核与64位时代:突破频率极限的创新(2000s-2010s)

2000年后,CPU时钟频率接近物理极限(高频导致功耗和散热问题),厂商转而通过“多核架构”和“64位扩展”提升性能。

-

64位架构:2003年AMD推出Athlon 64,首次实现x86架构的64位扩展(x86-64),支持更大内存地址空间(从32位的4GB提升至64位的16EB),满足高清视频处理、大型游戏等对内存需求极高的场景;英特尔随后推出兼容x86-64的处理器,64位架构逐步成为行业标准。

-

多核处理器:2005年英特尔推出Core 2 Duo(双核),2006年AMD推出Phenom(四核),通过在单芯片上集成多个CPU核心(如双核、四核、八核),实现“并行处理”——多个核心同时执行不同任务(如一个核心处理浏览器,一个核心运行音乐软件),突破了单核CPU的频率极限(当时单核频率已接近4GHz,继续提升会导致功耗飙升)。

-

性能优化技术:同步引入超线程(Hyper-Threading)、缓存分级(L1/L2/L3 Cache)等技术。例如,超线程让单个核心可模拟两个逻辑线程,四核CPU可同时处理八个任务;L3 Cache(共享缓存)减少核心间数据交换的延迟,进一步提升多核协作效率。

(四)移动与异构计算:CPU的“多元化”发展(2010s-至今)

随着智能手机、物联网设备的爆发,CPU从“追求极致性能”转向“平衡性能与功耗”,同时“异构计算”(CPU+GPU+专用加速器)成为主流,满足不同场景的算力需求。

1. 移动CPU:ARM架构的崛起

- 核心特点:采用ARM架构(精简指令集,RISC),相比x86架构(复杂指令集,CISC),ARM CPU体积小、功耗低(毫瓦级),适合电池供电的移动设备。

- 代表产品:

- 高通骁龙系列(如骁龙8 Gen3):集成CPU、GPU、NPU(神经网络处理器),支持5G、AI计算,是安卓旗舰手机的核心芯片;

- 苹果A系列(如A18 Pro):采用自研ARM架构核心,性能接近桌面级CPU,同时功耗控制极佳,支撑iPhone、iPad的流畅体验;

- 华为麒麟系列:集成自研NPU,在AI图像处理、语音识别等场景表现突出。

2. 桌面与服务器CPU:性能与能效的平衡

- 桌面CPU:英特尔Core i系列(如i9-14900K)、AMD Ryzen系列(如Ryzen 9 7950X),核心数提升至16核、32核,支持超频、PCIe 5.0等技术,满足游戏、视频剪辑等高性能需求;

- 服务器CPU:英特尔至强(Xeon)、AMD霄龙(EPYC),核心数达64核、128核,支持多通道内存、硬件级虚拟化,用于数据中心、云计算服务器,承载高并发业务(如电商平台、云游戏)。

3. 异构计算:专用加速器的融合

现代CPU不再是“单打独斗”,而是与GPU、NPU、TPU等专用加速器组成“计算集群”:

- CPU:负责逻辑控制、串行任务(如系统调度、代码执行);

- GPU:擅长并行计算(如图形渲染、AI模型训练),集成数千个小核心,处理大规模数据并行任务;

- NPU/TPU:针对AI任务优化(如图像识别、语音助手),能效比是CPU的10-100倍,广泛用于手机、自动驾驶芯片。

(五)摩尔定律的挑战与未来方向

- 挑战:随着晶体管尺寸接近原子级别(3nm、2nm工艺),物理极限(量子隧穿效应)导致摩尔定律逐步放缓,晶体管数量翻倍周期从18个月延长至3-4年;

- 未来技术:

- 先进工艺:探索3D晶体管(如英特尔3D Foveros)、GAA(全环绕栅极)技术,在有限空间内集成更多晶体管;

- 新材料:采用石墨烯、碳纳米管等替代硅基材料,提升芯片性能和散热效率;

- 存算一体:将存储器与计算单元集成,减少数据在内存与CPU间的传输延迟,提升AI计算效率。

四,计算机的性能指标:衡量“算力”的核心维度

计算机的性能并非单一指标能概括,需从“运算速度”“存储能力”“I/O效率”“稳定性”等多维度综合评估,不同应用场景(如游戏、服务器、移动设备)对性能指标的侧重也不同。

(一)运算速度指标:核心算力的直接体现

运算速度衡量计算机处理数据的快慢,核心指标包括时钟频率、指令执行速度、浮点运算速度等。

1. 时钟频率(主频)

- 定义:CPU每秒发出的时钟脉冲次数(单位:GHz,1GHz=10⁹次/秒),决定CPU执行指令的“基础节奏”,时钟频率越高,单位时间内处理的指令越多;

- 示例:i9-14900K主频3.2GHz(基础)、5.8GHz(加速),表示其基础状态下每秒可执行32亿次时钟周期,加速状态下可达58亿次;

- 注意:主频不能直接等同于性能,需结合核心数、指令集等。例如,一个4核3GHz CPU的综合性能可能优于单核5GHz CPU(可并行处理更多任务)。

2. 指令执行速度(IPS/CPI)

- IPS(Instructions Per Second):每秒执行的指令数(单位:MIPS,百万条指令/秒;GIPS,十亿条指令/秒),反映CPU处理指令的效率;

- CPI(Cycles Per Instruction):执行一条指令所需的时钟周期数,CPI越小,指令执行效率越高。例如,精简指令集(ARM)CPU的CPI通常为1-2,复杂指令集(x86)CPU的CPI可能为3-5(因指令更复杂)。

3. 浮点运算速度(FLOPS)

- 定义:每秒执行的浮点运算次数(单位:GFLOPS,十亿次/秒;PFLOPS,千万亿次/秒;EFLOPS,百亿亿次/秒),是衡量科学计算、AI训练等场景性能的核心指标(这类任务涉及大量小数运算,如气象模拟、神经网络训练);

- 示例:消费级GPU(如RTX 4090)的浮点运算速度约100 TFLOPS,超级计算机(如中国“天河三号”)的速度达E级(百亿亿次/秒),可支撑尖端科学研究。

(二)存储性能指标:数据存取的效率

存储性能直接影响计算机的响应速度,核心指标包括容量、带宽、延迟。

1. 容量(Capacity)

- 定义:存储设备可容纳的数据量(单位:GB,千兆字节;TB,万亿字节;PB,千万亿字节);

- 分类:

- 内存容量:个人PC通常为8GB-64GB,服务器可达1TB以上,影响多任务处理能力(如同时打开多个浏览器标签、大型软件);

- 硬盘容量:机械硬盘(HDD)通常为1TB-8TB,固态硬盘(SSD)为512GB-4TB,影响文件、软件的存储能力。

2. 带宽(Bandwidth)

- 定义:单位时间内可传输的数据量(单位:GB/s,千兆字节/秒),反映存储设备的“数据传输速率”;

- 示例:DDR5内存带宽约6400MT/s(约50GB/s),NVMe SSD带宽约7GB/s,机械硬盘仅150MB/s左右;带宽越高,大型文件(如4K视频、游戏安装包)的加载速度越快。

3. 延迟(Latency)

- 定义:从发出存取请求到数据返回的时间(单位:ns,纳秒;ms,毫秒),反映存储设备的“响应速度”;

- 示例:CPU L1 Cache延迟约1ns,内存延迟约100ns,SSD延迟约0.1ms,机械硬盘延迟约5ms;延迟越低,计算机操作的“跟手性”越好(如打开软件、切换任务时无卡顿)。

(三)I/O与网络性能:内外交互的效率

计算机需通过I/O设备(键盘、鼠标、显示器)和网络与外部交互,其性能影响用户体验和数据传输效率。

1. I/O接口速率

- 定义:I/O接口(如USB、PCIe、HDMI)的数据传输速率,决定外设与计算机的交互速度;

- 示例:USB 3.2 Gen2速率达10Gbps(约1.2GB/s),可快速传输照片、视频;PCIe 5.0速率达32GB/s,支持高端显卡、SSD的高速数据交换;HDMI 2.1速率达48Gbps,可传输8K超高清视频。

2. 网络带宽与延迟

- 网络带宽:单位时间内网络传输的数据量(单位:Mbps,兆比特/秒;Gbps,千兆比特/秒),影响下载、在线视频、云游戏等体验(如1000Mbps宽带下载1GB文件约8秒);

- 网络延迟:数据从本地到目标服务器的往返时间(单位:ms),影响实时应用(如在线游戏延迟需低于50ms,否则出现“卡顿”;视频会议延迟需低于200ms,否则出现“音画不同步”)。

(四)能效比与稳定性:长期运行的关键

对于移动设备、服务器等场景,能效比(性能与功耗的比值)和稳定性比单纯的性能更重要。

1. 能效比(Performance per Watt)

- 定义:每瓦功耗能提供的性能(如每瓦GFLOPS),核心指标为“TDP(热设计功耗)”(单位:W),表示CPU/GPU的最大散热需求;

- 示例:手机CPU(如骁龙8 Gen3)TDP约10W,却能提供接近桌面级的性能,能效比极高;服务器CPU(如至强白金系列)TDP约200W,但需24小时运行,需通过高效散热设计确保稳定。

2. 稳定性指标

- 平均无故障时间(MTBF):衡量设备连续稳定运行的能力(单位:小时),服务器、工业计算机的MTBF通常达10万小时以上(约11年),确保业务不中断;

- 容错能力:服务器通过冗余设计(双电源、RAID磁盘阵列、ECC内存)提升稳定性,即使某部件故障,系统仍能继续运行(如RAID5磁盘阵列允许一块硬盘损坏,数据不丢失)。

📝 总结:计算机发展的核心逻辑与未来展望

计算机的百年发展史,本质是“算力突破”与“场景适配”相互驱动的历史:

-

技术迭代的核心逻辑:从电子管到人工智能芯片,从磁芯存储器到3D NAND,从单核CPU到异构计算,每一次突破都围绕“提升算力、降低成本、缩小体积、减少功耗”四大目标,而摩尔定律的持续推动(尽管放缓)是算力指数级增长的核心动力。

-

硬件与软件的协同进化:硬件的进步为软件创新提供基础(如多核CPU推动多任务操作系统发展,GPU催生AI深度学习框架),软件的需求又反过来驱动硬件升级(如4K视频推动显卡带宽提升,AI大模型推动NPU专用芯片发展),二者形成“螺旋上升”的良性循环。

-

未来发展的三大方向:

- 算力极致化:通过量子计算、光子计算突破经典算力极限,解决当前无法处理的复杂问题(如药物研发、气候模拟);

- 形态多元化:计算机从“固定设备”(PC、服务器)向“泛在设备”(可穿戴设备、智能家居、自动驾驶汽车)延伸,融入生活的每个场景;

- 智能深度化:从“被动执行指令”向“主动理解需求”进化,计算机将成为具备自主学习、推理、决策能力的“智能伙伴”,重塑医疗、教育、交通等行业的运作模式。

从帕斯卡的机械计算器到ChatGPT背后的超算集群,计算机的发展不仅是技术的胜利,更是人类对“解放脑力、拓展能力”的不懈追求。未来,随着技术的持续突破,计算机将不再仅是“工具”,更会成为推动人类社会进步的“核心引擎”。

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)