猫头虎 Gemma和Gemini模型的区别是什么?

Gemini是一组高级AI模型,设计用于高性能任务,广泛应用于Google的旗舰AI服务中。这些模型通常非常庞大,具有高达1.56万亿的参数,需要强大的计算资源支持。无论你是初学者还是资深开发者,通过了解Gemma和Gemini模型的区别,你都能更好地选择适合自己项目的AI模型。未来,我们期待Google在这两个模型系列上带来更多创新和突破,为AI技术的发展注入新的活力。

猫头虎 🐯 Gemma和Gemini模型的区别是什么?

摘要📘

在这篇文章中,我们将深入探讨Gemma和Gemini这两个由Google开发的AI模型。我们会对比它们的参数规模、计算资源需求和集成难度,帮助大家了解这两者之间的主要区别。无论你是AI初学者还是技术大佬,这篇文章都能带给你全面且易懂的知识点。关键词:Gemma、Gemini、AI模型、Google、参数、计算资源、集成难度。

猫头虎是谁?

大家好,我是 猫头虎,别名猫头虎博主,擅长的技术领域包括云原生、前端、后端、运维和AI。我的博客主要分享技术教程、bug解决思路、开发工具教程、前沿科技资讯、产品评测图文、产品使用体验图文、产品优点推广文稿、产品横测对比文稿,以及线下技术沙龙活动参会体验文稿。内容涵盖云服务产品评测、AI产品横测对比、开发板性能测试和技术报告评测等。

目前,我活跃在CSDN、51CTO、腾讯云开发者社区、阿里云开发者社区、知乎、微信公众号、视频号、抖音、B站和小红书等平台,全网拥有超过30万的粉丝,统一IP名称为 猫头虎 或者 猫头虎博主。希望通过我的分享,帮助大家更好地了解和使用各类技术产品。

原创作者 ✍️

- 博主:猫头虎

- 全网搜索关键词:猫头虎

- 作者微信号:Libin9iOak

- 作者公众号:猫头虎技术团队

- 更新日期:2024年6月16日

- 🌟 欢迎来到猫头虎的博客 — 探索技术的无限可能!

专栏链接 🔗

- 精选专栏:

- 《面试题大全》 — 面试准备的宝典!

- 《IDEA开发秘籍》 — 提升你的IDEA技能!

- 《100天精通鸿蒙》 — 从Web/安卓到鸿蒙大师!

- 《100天精通Golang(基础入门篇)》 — 踏入Go语言世界的第一步!

- 《100天精通Go语言(精品VIP版)》 — 踏入Go语言世界的第二步!

领域矩阵 🌐

加入猫头虎的技术圈,一起探索编程世界的无限可能! 🚀

文章目录

引言

近年来,人工智能技术飞速发展,各种AI模型层出不穷。Google作为行业领导者,推出了多款备受瞩目的AI模型,其中最具代表性的就是Gemini和Gemma模型。本文将以详细的对比分析,带领大家了解这两款模型的独特之处及应用场景。

正文

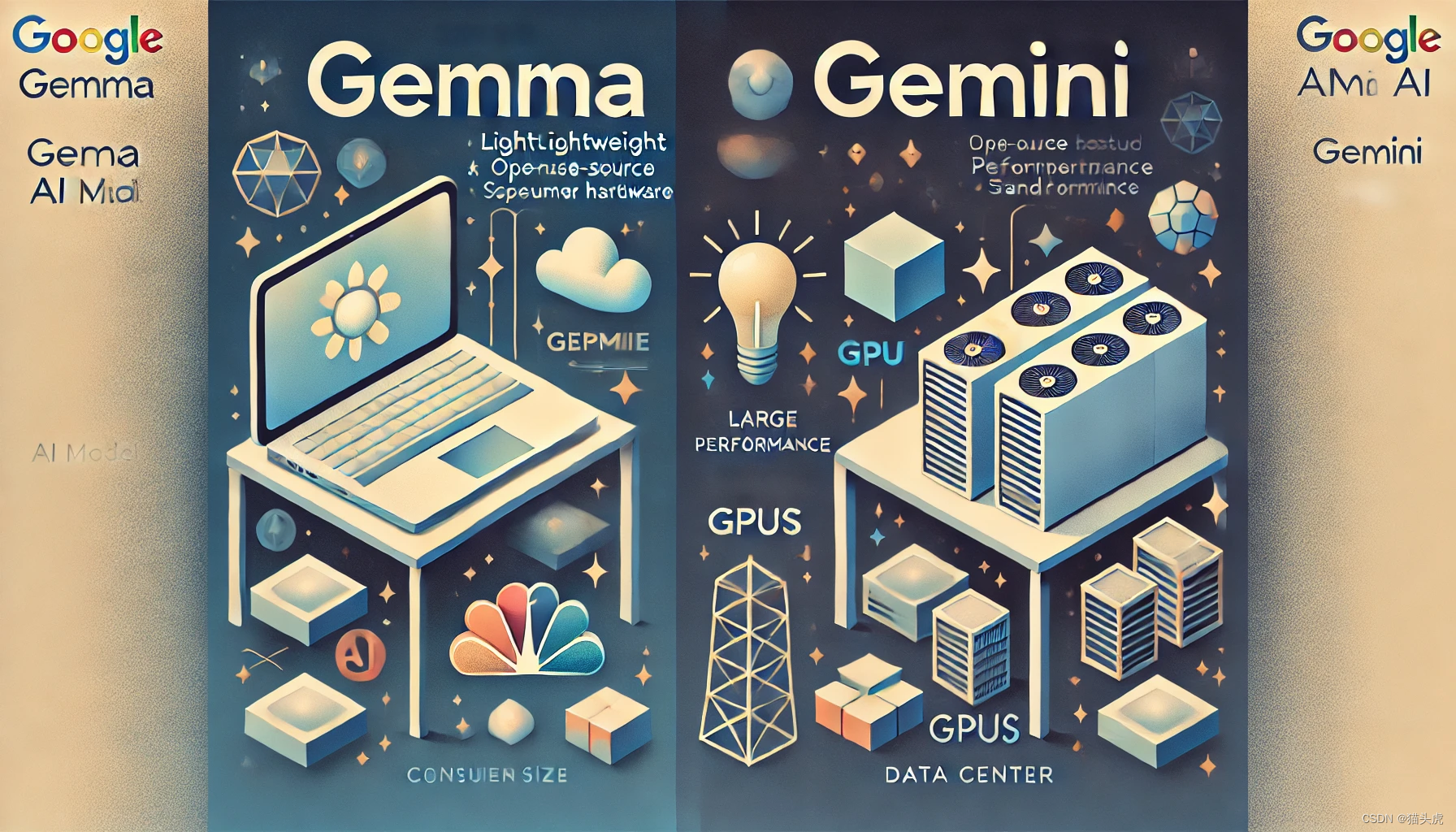

1. 模型概述

🌟 Gemini模型

Gemini是一组高级AI模型,设计用于高性能任务,广泛应用于Google的旗舰AI服务中。这些模型通常非常庞大,具有高达1.56万亿的参数,需要强大的计算资源支持。

🌟 Gemma模型

相比之下,Gemma是一组轻量级的开源AI模型,专为开发者设计。Gemma模型参数较小,主要有2B和7B两个版本,适合在消费级硬件上运行。

2. 参数规模对比

Gemini模型参数规模:最新的Gemini Ultra模型具有1.56万亿参数,而Gemini 1.5 Pro模型在一些测试中支持高达一百万个令牌的上下文窗口【24†source】。

Gemma模型参数规模:Gemma模型较小,主要有2B和7B两个版本,适合在较低资源环境中运行【21†source】【22†source】。

3. 计算资源需求

💻 Gemini模型

由于其庞大的规模和复杂的架构,Gemini模型通常需要专用的数据中心硬件,例如大型GPU集群或TPU【24†source】。

💻 Gemma模型

Gemma模型设计为在消费级硬件上高效运行,例如笔记本电脑或标准工作站,无需大型数据中心的硬件支持【21†source】【22†source】。

4. 集成难度

🚀 Gemini模型

集成相对复杂,主要通过Google Cloud的Vertex AI和专门的API进行访问,需要较高的技术门槛和资源投入【21†source】【24†source】。

🚀 Gemma模型

Gemma模型是开源的,开发者可以通过多种平台(如Hugging Face、Kaggle、NVIDIA NeMo等)轻松访问和使用。集成相对简单,并且支持多种AI框架如PyTorch、TensorFlow和JAX,使得开发者能够在各种环境中进行快速部署和定制【22†source】【23†source】【25†source】。

5. 代码示例

# 示例:使用Hugging Face的transformers库加载Gemma模型

from transformers import pipeline

import torch

pipe = pipeline(

"text-generation",

model="google/gemma-7b-it",

model_kwargs={"torch_dtype": torch.bfloat16},

device="cuda",

)

messages = [

{"role": "user", "content": "What are the main differences between Gemma and Gemini models?"},

]

outputs = pipe(

messages,

max_new_tokens=256,

do_sample=True,

temperature=0.7,

top_k=50,

top_p=0.95

)

print(outputs[0]["generated_text"])

6. 常见问题

Q1: Gemma模型适合哪些应用场景?

A1: Gemma模型由于其轻量级设计,非常适合开发者在消费级硬件上进行快速开发和部署,适用于各种语言处理任务,如问答、摘要和推理等。

Q2: 如何在我的项目中集成Gemma模型?

A2: 你可以使用Hugging Face、Kaggle、NVIDIA NeMo等平台,结合PyTorch、TensorFlow或JAX框架,轻松集成Gemma模型到你的项目中。

小结

通过本文的对比分析,我们了解了Gemma和Gemini模型在参数规模、计算资源需求和集成难度方面的主要区别。Gemma模型作为轻量级的开源选项,为开发者提供了更便捷的使用体验,而Gemini模型则适用于需要高性能计算资源的大规模任务。

参考资料

总结

无论你是初学者还是资深开发者,通过了解Gemma和Gemini模型的区别,你都能更好地选择适合自己项目的AI模型。未来,我们期待Google在这两个模型系列上带来更多创新和突破,为AI技术的发展注入新的活力。

未来展望

随着AI技术的不断进步,我们可以期待更多高效、易用的AI模型问世。希望大家继续关注我们的博客,了解最新的技术动态和应用实例。

温馨提示

如果对本文有任何疑问,欢迎点击下方名片,了解更多详细信息!

这是高亮加粗大一号斜体的道奇蓝色courier New字体

👉 更多信息:有任何疑问或者需要进一步探讨的内容,欢迎点击下方文末名片获取更多信息。我是猫头虎博主,期待与您的交流! 🦉💬

联系与版权声明 📩

- 联系方式:

- 微信: Libin9iOak

- 公众号: 猫头虎技术团队

- 版权声明:

本文为原创文章,版权归作者所有。未经许可,禁止转载。更多内容请访问猫头虎的博客首页。

点击✨⬇️下方名片⬇️✨,加入猫头虎领域社群矩阵。一起探索科技的未来,共同成长。🚀

更多推荐

已为社区贡献89条内容

已为社区贡献89条内容

所有评论(0)