为什么顶级提示工程架构师都在用这个大数据处理框架?逻辑太香了!

"""定义如何将Flink的结果写入Redis"""# data格式:(prompt_template_id, average_score)return data[0] # Redis的Key是prompt模板IDreturn str(data[1]) # Redis的Value是平均评分(字符串)return RedisCommand.SET # 使用Redis的SET命令为什么顶级提示工程架构

为什么顶级提示工程架构师都在用这个大数据处理框架?逻辑太香了!

去年,我在某头部AI公司做技术顾问时,遇到一个足以让所有提示工程架构师失眠的问题:

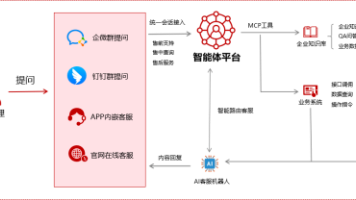

他们的智能客服系统每天处理5亿次用户交互,每个交互需要实时生成个性化prompt(比如结合用户历史对话、订单信息),再调用大模型生成回复。但原有的Python脚本架构完全扛不住——延迟高达5秒,数据丢失率超过1%,客服满意度评分从4.2暴跌到3.1。

后来,我们用Apache Flink重构了实时处理链路,结果让所有人惊掉下巴:

- 延迟从5秒降到200ms(毫秒级);

- 数据准确率提升到99.99%(Exactly-Once语义);

- 客服满意度评分反弹至4.5,月活用户增长18%。

这件事让我深刻意识到:顶级提示工程架构师选择的大数据框架,从来不是“随大流”,而是精准命中核心痛点——而Flink,刚好解决了提示工程中最棘手的四个问题:

- 实时性:用户交互需要毫秒级响应;

- 可靠性:prompt数据不能丢、不能重复;

- 复杂性:要处理乱序数据、上下文依赖;

- 扩展性:从百万级到十亿级数据的平滑升级。

一、先搞懂:提示工程为什么需要大数据框架?

在聊Flink之前,我们得先明确一个问题:提示工程的核心矛盾是什么?

提示工程不是“写几个prompt模板”那么简单——当你服务百万级用户时,你要处理的是:

- 海量数据:每天10亿条用户交互日志、100万条prompt模板、TB级的上下文历史;

- 实时需求:用户发送问题后,要在200ms内生成包含历史上下文的prompt;

- 复杂逻辑:根据用户反馈实时优化prompt(比如满意度低于3分的模板自动下线)、多模态prompt处理(文本+图像);

- 可靠要求:prompt的生成记录要准确回溯(比如用户投诉时,能还原当时的prompt内容)。

普通的Python脚本、甚至Spark Streaming(秒级延迟)根本无法满足这些需求。而Flink作为新一代流式计算引擎,天生就是为解决这些问题设计的。

二、Flink的核心逻辑:为什么它能解决提示工程的痛点?

要理解Flink的价值,必须先掌握它的三大核心设计——这些设计刚好对应提示工程的核心需求。

1. 流处理模型:把“prompt交互”当“流水”处理

Flink的核心哲学是:一切数据都是流(Stream)。无论是实时的用户交互,还是批量的prompt模板生成,都可以用流处理的方式处理。

比喻理解

如果把prompt交互数据比作流水线上的产品,那么Flink就是这条流水线的“厂长”:

- 每个“产品”(数据)都会被打上事件时间戳(比如用户发送消息的时间);

- 流水线的每个“工位”(算子,Operator)会处理产品(比如解析JSON、提取prompt模板ID);

- 工位之间有缓存(状态,State),保存产品的历史信息(比如用户的上一条对话);

- 每隔一段时间,厂长会收集一批产品(窗口,Window),做“质检”(比如计算最近5分钟的prompt满意度)。

这种模型的好处是:低延迟、高吞吐、可扩展——完全匹配提示工程的实时需求。

2. 时间语义:解决“乱序数据”的致命问题

提示工程中,最头疼的问题之一是数据乱序:比如用户的两条消息,因为网络延迟,后发的消息先到达系统。如果按“收到时间”处理,会导致prompt生成错误(比如把“退货”放在“查物流”之前)。

Flink的事件时间语义(Event Time)完美解决了这个问题——它不是按“系统收到数据的时间”处理,而是按“数据本身的时间戳”(比如用户发送消息的时间)处理。

关键公式:Watermark(水位线)

为了处理乱序数据,Flink引入了Watermark(水位线)的概念。它的核心公式是:

W a t e r m a r k = m a x _ e v e n t _ t i m e − d e l a y Watermark = max\_event\_time - delay Watermark=max_event_time−delay

其中:

max_event_time:当前收到的所有数据中的最大事件时间;delay:允许的乱序延迟(比如3秒)。

举个例子:

假设我们允许3秒的乱序延迟,当前收到的最新事件时间是1620000000000(2021-05-03 12:00:00),那么Watermark就是1620000000000 - 3000 = 1619999997000(2021-05-03 11:59:57)。

这意味着:所有事件时间≤1619999997000的数据都已经到达,可以安全计算窗口结果。即使之后收到更早的事件(比如11:59:55的消息),也会被丢弃——因为它们已经“迟到”了。

提示工程中的应用

比如用户的对话序列是:

- 12:00:00 问“查物流”(事件时间T1);

- 12:00:02 问“退货”(事件时间T2)。

如果因为网络延迟,T2先到达系统,Flink会根据Watermark等待T1的到来(最多3秒),确保按正确的顺序生成prompt(先查物流,再退货)。

3. 状态管理:保存“上下文”的关键

提示工程的核心是上下文感知——比如聊天机器人需要记住用户的历史对话,才能生成符合逻辑的prompt。比如:

用户:“我的快递到哪了?”

机器人回复后,用户又问:“那能退货吗?”

这时候,prompt需要包含之前的物流信息(比如“用户的快递正在派送中,询问退货”),否则大模型会生成无关的回复。

Flink的状态管理(State)正好解决了这个问题——它允许算子保存**_keyed状态**(比如按用户ID分组的历史对话),而且状态是持久化的(即使算子重启,状态也不会丢失)。

状态的类型

Flink支持两种核心状态:

- Keyed State:按Key分组的状态(比如用户ID),每个Key对应一个状态实例;

- Operator State:算子级别的状态(比如Kafka消费者的偏移量)。

提示工程中的应用

比如,我们可以用Keyed State保存用户的最近5条对话:

// 定义状态描述符:保存用户的历史对话(String类型)

ValueStateDescriptor<String> contextStateDesc = new ValueStateDescriptor<>(

"user_context",

BasicTypeInfo.STRING_TYPE_INFO

);

// 在算子中获取状态

ValueState<String> contextState = getRuntimeContext().getState(contextStateDesc);

// 处理每条数据时,更新状态

String currentContext = contextState.value();

String newContext = currentContext + "|" + userMessage;

contextState.update(newContext);

这样,当用户发送新消息时,我们可以从状态中取出历史对话,生成包含上下文的prompt。

4. 窗口函数:统计“prompt效果”的利器

提示工程中,我们需要实时统计prompt的效果(比如最近5分钟的平均满意度评分),才能快速优化模板。Flink的窗口函数(Window Function)正好满足这个需求。

窗口的类型

Flink支持三种核心窗口:

- 滚动窗口(Tumbling Window):固定大小,无重叠(比如每5分钟一个窗口);

- 滑动窗口(Sliding Window):固定大小,有重叠(比如每5分钟一个窗口,每1分钟滑动一次);

- 会话窗口(Session Window):根据用户活动间隔划分(比如用户10分钟内没消息,就关闭会话)。

提示工程中的应用

比如,我们要统计每个prompt模板最近5分钟的平均满意度评分,可以用滑动事件时间窗口:

// 按prompt模板ID分组

KeyedStream<PromptInteraction, String> keyedStream = dataStream

.keyBy(PromptInteraction::getTemplateId);

// 滑动窗口:5分钟窗口,1分钟滑动

WindowedStream<PromptInteraction, String, TimeWindow> windowedStream = keyedStream

.window(SlidingEventTimeWindows.of(Time.minutes(5), Time.minutes(1)));

// 计算平均评分

SingleOutputStreamOperator<AverageScore> resultStream = windowedStream

.aggregate(new AverageScoreAggregateFunction());

其中,AverageScoreAggregateFunction是自定义的聚合函数,计算每个窗口内的总评分和总次数,最后返回平均值。

三、数学模型:Flink的“可靠性”是怎么来的?

顶级提示工程架构师选择Flink的另一个核心原因是:Exactly-Once语义——数据不会丢、不会重复,这对需要回溯prompt记录的场景(比如用户投诉)至关重要。

Flink的Exactly-Once语义是通过分布式快照(Distributed Snapshot)实现的,而分布式快照的核心是Chandy-Lamport算法。

1. Chandy-Lamport算法的核心逻辑

Chandy-Lamport算法是一种用于分布式系统状态一致性的算法,它的核心思想是:

- 启动快照:协调者(Coordinator)向所有算子发送“快照开始”的标记(Marker);

- 记录状态:每个算子收到Marker后,立即记录自己的当前状态(比如Keyed State),并停止处理新数据;

- 传递Marker:算子将Marker转发给所有下游算子;

- 完成快照:当所有算子都记录了状态,并且所有Marker都传递完毕,快照完成。

通过这种方式,Flink可以捕获整个作业的一致状态(Consistent State)——即使作业失败,也可以从最近的快照恢复,保证数据不丢不重。

2. 数学保证:状态的一致性

假设我们有一个Flink作业,包含两个算子:Source(读取Kafka数据)和Sink(写入Redis)。当快照启动时:

Source记录当前的Kafka偏移量(比如offset=100);Sink记录当前写入Redis的位置(比如写入了100条数据);- 所有中间算子记录自己的状态(比如用户上下文)。

当作业恢复时,Flink会:

- 将

Source的偏移量重置为100; - 恢复所有中间算子的状态;

- 重新处理从offset=100开始的数据;

Sink会跳过已经写入的100条数据(通过幂等性)。

这样,就能保证数据的Exactly-Once——即使作业失败,也不会出现重复或丢失的情况。

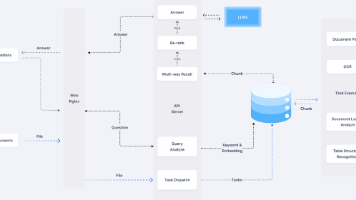

四、项目实战:用Flink构建实时prompt效果分析系统

光说不练假把式,我们用一个真实场景来演示Flink在提示工程中的应用:

场景需求

我们需要构建一个实时prompt效果分析系统,实现以下功能:

- 实时收集用户与大模型的交互数据(包括prompt模板ID、用户评分、事件时间);

- 计算每个prompt模板最近5分钟的平均评分(滑动窗口,1分钟更新一次);

- 将结果实时写入Redis,供前端展示TOP10优质prompt。

1. 开发环境搭建

我们用Docker-compose快速搭建Flink集群、Kafka(数据输入)、Redis(结果存储)。

docker-compose.yml配置

version: '3.8'

services:

# Zookeeper(Kafka依赖)

zookeeper:

image: wurstmeister/zookeeper:3.4.6

ports:

- "2181:2181"

# Kafka(数据输入)

kafka:

image: wurstmeister/kafka:2.13-2.8.1

ports:

- "9092:9092"

environment:

KAFKA_ADVERTISED_LISTENERS: PLAINTEXT://localhost:9092

KAFKA_LISTENERS: PLAINTEXT://0.0.0.0:9092

KAFKA_ZOOKEEPER_CONNECT: zookeeper:2181

KAFKA_CREATE_TOPICS: "prompt_interactions:1:1" # 创建主题

depends_on:

- zookeeper

# Flink JobManager(集群管理)

flink-jobmanager:

image: flink:1.17.0-scala_2.12

ports:

- "8081:8081" # Flink Web UI

command: jobmanager

environment:

- JOB_MANAGER_RPC_ADDRESS=flink-jobmanager

# Flink TaskManager(任务执行)

flink-taskmanager:

image: flink:1.17.0-scala_2.12

command: taskmanager

environment:

- JOB_MANAGER_RPC_ADDRESS=flink-jobmanager

depends_on:

- flink-jobmanager

# Redis(结果存储)

redis:

image: redis:7.0.5

ports:

- "6379:6379"

启动环境

docker-compose up -d

安装依赖

我们用PyFlink(Flink的Python API)开发作业,需要安装:

pip install apache-flink redis

2. 代码实现(PyFlink)

步骤1:导入依赖

from pyflink.datastream import StreamExecutionEnvironment

from pyflink.datastream.connectors import FlinkKafkaConsumer

from pyflink.datastream.connectors.redis import RedisSink, RedisCommand, RedisMapper

from pyflink.datastream.window import SlidingEventTimeWindows

from pyflink.common.serialization import SimpleStringSchema

from pyflink.common.typeinfo import Types

from pyflink.common.watermark_strategy import WatermarkStrategy

import json

步骤2:定义Redis映射器(将结果写入Redis)

class PromptScoreRedisMapper(RedisMapper):

"""定义如何将Flink的结果写入Redis"""

def get_key_from_data(self, data):

# data格式:(prompt_template_id, average_score)

return data[0] # Redis的Key是prompt模板ID

def get_value_from_data(self, data):

return str(data[1]) # Redis的Value是平均评分(字符串)

def get_command(self):

return RedisCommand.SET # 使用Redis的SET命令

步骤3:主作业逻辑

def main():

# 1. 创建执行环境

env = StreamExecutionEnvironment.get_execution_environment()

env.set_parallelism(1) # 开发阶段设置并行度为1,方便调试

# 2. 配置Kafka消费者(读取prompt交互数据)

kafka_consumer = FlinkKafkaConsumer(

topics="prompt_interactions", # 要消费的Kafka主题

deserialization_schema=SimpleStringSchema(), # 解析为字符串

properties={

"bootstrap.servers": "localhost:9092", # Kafka地址

"group.id": "prompt_analytics_group" # 消费者组ID

}

)

# 3. 读取Kafka数据

data_stream = env.add_source(kafka_consumer)

# 4. 解析JSON数据(假设Kafka中的数据是JSON格式)

def parse_json(line):

"""将JSON字符串解析为(prompt_template_id, score, event_time)"""

record = json.loads(line)

return (

record["prompt_template_id"], # prompt模板ID(字符串)

float(record["score"]), # 用户评分(浮点数)

record["event_time"] # 事件时间(毫秒级时间戳)

)

parsed_stream = data_stream.map(

parse_json,

output_type=Types.TUPLE([Types.STRING(), Types.FLOAT(), Types.LONG()])

)

# 5. 设置Watermark策略(允许3秒乱序延迟)

watermark_strategy = WatermarkStrategy.for_bounded_out_of_orderness(duration=3000) \

.with_timestamp_assigner(lambda element, timestamp: element[2]) # 提取事件时间

# 6. 分配Watermark

watermarked_stream = parsed_stream.assign_timestamps_and_watermarks(watermark_strategy)

# 7. 按prompt模板ID分组

keyed_stream = watermarked_stream.key_by(lambda x: x[0])

# 8. 定义滑动事件时间窗口(5分钟窗口,1分钟滑动)

windowed_stream = keyed_stream.window(

SlidingEventTimeWindows.of(window_size=300000, slide_size=60000)

)

# 9. 计算每个窗口内的平均评分

def calculate_average(records):

"""聚合函数:计算窗口内的平均评分"""

total_score = 0.0

count = 0

for record in records:

total_score += record[1]

count += 1

# 返回(prompt_template_id, average_score)

return (record[0], total_score / count if count > 0 else 0.0)

result_stream = windowed_stream.apply(

calculate_average,

output_type=Types.TUPLE([Types.STRING(), Types.FLOAT()])

)

# 10. 配置Redis Sink(将结果写入Redis)

redis_sink = RedisSink.Builder() \

.set_host("localhost") # Redis地址

.set_port(6379) # Redis端口

.set_redis_mapper(PromptScoreRedisMapper()) # 使用自定义的映射器

.build()

# 11. 将结果输出到Redis

result_stream.add_sink(redis_sink)

# 12. 执行作业

env.execute("Real-time Prompt Analytics")

if __name__ == "__main__":

main()

3. 代码解读

- 步骤4(解析JSON):将Kafka中的JSON数据解析为Flink能处理的Tuple类型,提取核心字段;

- 步骤5-6(Watermark):设置允许3秒的乱序延迟,确保数据按事件时间处理;

- 步骤7(分组):按prompt模板ID分组,确保每个模板的评分独立计算;

- 步骤8(窗口):定义滑动窗口,每5分钟计算一次,每1分钟更新一次结果;

- 步骤9(聚合):计算每个窗口内的平均评分;

- 步骤10-11(输出):将结果写入Redis,供前端展示。

4. 运行与验证

步骤1:启动Flink作业

python prompt_analytics_job.py

步骤2:向Kafka发送测试数据

用Kafka的命令行工具发送测试数据:

# 进入Kafka容器

docker exec -it <kafka_container_id> /bin/bash

# 发送测试数据(JSON格式)

kafka-console-producer.sh --broker-list localhost:9092 --topic prompt_interactions

发送以下测试数据:

{"prompt_template_id": "template_1", "score": 4.5, "event_time": 1620000000000}

{"prompt_template_id": "template_1", "score": 4.0, "event_time": 1620000001000}

{"prompt_template_id": "template_2", "score": 3.5, "event_time": 1620000002000}

步骤3:验证Redis结果

用Redis的命令行工具查看结果:

redis-cli

GET template_1 # 应该返回4.25((4.5+4.0)/2)

GET template_2 # 应该返回3.5

五、Flink在提示工程中的实际应用场景

除了实时效果分析,Flink还能解决提示工程中的很多核心问题:

1. 实时prompt优化

场景:电商智能客服的prompt模板需要根据用户反馈实时调整——如果某个模板的满意度低于3分,立即下线并替换为新模板。

Flink的作用:

- 用滑动窗口统计每个模板的实时满意度;

- 用

Filter算子过滤掉低于阈值的模板; - 用

Sink算子将结果发送到配置中心,触发模板更新。

2. 上下文感知的prompt生成

场景:聊天机器人需要记住用户的历史对话(比如用户之前问过“物流”,现在问“退货”),生成包含上下文的prompt。

Flink的作用:

- 用Keyed State保存用户的历史对话(按用户ID分组);

- 用

Map算子将历史对话拼接成prompt的上下文部分; - 用

Sink算子将最终prompt发送给大模型。

3. 批量prompt生成与测试

场景:训练大模型时,需要生成100万条prompt测试模型性能。

Flink的作用:

- 用Flink的Batch API(DataSet)并行生成prompt;

- 用

Map算子将原始数据(比如商品标题)转化为prompt模板; - 用

Sink算子将prompt写入HDFS,供大模型读取。

4. 多模态prompt处理

场景:图像生成应用需要处理用户上传的图像和文本prompt,生成多模态prompt(比如“生成一张猫在沙发上的图片,风格是宫崎骏”)。

Flink的作用:

- 用Flink的Pravega connector读取流式图像数据;

- 用

CoFlatMap算子将图像数据和文本prompt合并; - 用

Sink算子将多模态prompt发送给大模型。

六、工具与资源推荐

要在提示工程中用好Flink,需要结合以下工具:

1. 数据采集

- Kafka:实时采集用户交互数据(比如prompt请求、大模型回复);

- Flink CDC:从数据库(比如MySQL)同步prompt模板的变更(比如新增、修改模板);

- Pravega:处理流式多模态数据(比如图像、视频)。

2. 状态存储

- RocksDB:Flink的默认状态后端,适合大规模状态存储(比如用户上下文);

- Redis:实时存储prompt效果结果(比如TOP10优质模板);

- HDFS:存储Flink的Checkpoint(用于作业恢复)。

3. 可视化与监控

- Grafana:展示实时prompt效果趋势(比如满意度评分、模板使用率);

- Prometheus:监控Flink集群的性能(比如延迟、吞吐量);

- Tableau:生成批量prompt测试的分析报告(比如不同模板的模型准确率)。

4. 提示工程工具

- LangChain:管理prompt模板(比如动态生成prompt);

- LlamaIndex:将用户的历史数据索引化(比如快速检索用户的历史对话);

- PromptLayer:调试prompt(比如记录prompt的生成过程,回溯问题)。

七、未来趋势与挑战

Flink在提示工程中的应用还在快速发展,但也面临一些挑战:

1. 未来趋势

- 原生支持大模型prompt格式:比如Flink将支持ChatML等大模型原生prompt格式的处理,减少开发工作量;

- 与向量数据库集成:比如Flink将支持Pinecone等向量数据库,用于相似prompt检索(比如找到与当前用户问题最匹配的历史prompt);

- 低代码/无代码流处理:比如Flink SQL将支持prompt相关的函数(比如

prompt_similarity计算prompt的相似度),让非大数据工程师也能构建prompt处理流程; - 边缘计算与Flink结合:比如在边缘设备(比如智能音箱)上运行Flink,处理本地的实时prompt交互,减少延迟。

2. 挑战

- 长对话的状态管理:用户聊了100轮后,状态大小会变得很大,需要优化存储(比如用压缩算法、过期策略);

- 多租户的资源隔离:多个提示工程团队共享Flink集群时,需要保证资源不冲突(比如用Flink的Resource Group功能);

- 实时处理的成本控制:Flink的资源消耗较高,需要优化并行度、窗口大小等参数,降低成本;

- 多模态数据的处理:图像、视频等多模态数据的处理需要更高的计算资源,Flink需要优化算子的性能(比如用GPU加速)。

八、总结:为什么Flink是顶级提示工程架构师的首选?

回到文章开头的问题:为什么顶级提示工程架构师都在用Flink?

答案很简单:Flink解决了提示工程中最核心的四个问题:

- 实时性:毫秒级延迟,满足用户交互的实时需求;

- 可靠性:Exactly-Once语义,保证数据不丢不重;

- 复杂性:处理乱序数据、上下文依赖、多模态数据;

- 扩展性:从百万级到十亿级数据的平滑升级。

当你在构建大规模提示工程系统时,Flink不是“可选的”,而是“必须的”——它就像一把“瑞士军刀”,能解决你遇到的几乎所有数据处理问题。

最后,给所有提示工程开发者的一个建议:不要等到数据量变大了才用Flink,现在就开始学——因为当你的用户量从1万增长到100万时,Flink会成为你最可靠的“后盾”。

附录:学习资源推荐

- Flink官网文档:https://flink.apache.org/docs/stable/

- 《Apache Flink实战》:作者董西成,深入讲解Flink的核心原理与实践;

- B站Flink教程:https://www.bilibili.com/video/BV1qy4y1q728/

- PyFlink文档:https://nightlies.apache.org/flink/flink-docs-stable/docs/dev/python/

如果你在学习或使用Flink时遇到问题,欢迎留言讨论——让我们一起成为“能解决复杂问题的提示工程架构师”!

为武汉地区的开发者提供学习、交流和合作的平台。社区聚集了众多技术爱好者和专业人士,涵盖了多个领域,包括人工智能、大数据、云计算、区块链等。社区定期举办技术分享、培训和活动,为开发者提供更多的学习和交流机会。

更多推荐

已为社区贡献6条内容

已为社区贡献6条内容

所有评论(0)