数据分析系统的流程图及架构图

1、大数据平台网站日志分析系统,项目技术架构图:2、大数据平台网站日志分析系统,流程图解析,整体流程如下:ETL即Hive查询的sql;但是,由于本案例的前提是处理海量数据,因而,流程中各环节所使用的技术则跟传统BI完全不同:1)数据采集:定制开发采集程序,或使用开源框架Flume2)数据预处理:定制开发mapreduce程序运行于hadoop集群3)数据仓库技术:基于hadoop...

一键AI生成摘要,助你高效阅读

问答

·

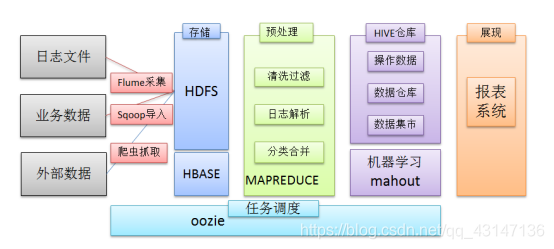

1、大数据平台网站日志分析系统,项目技术架构图:

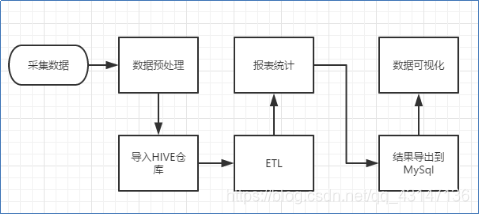

2、大数据平台网站日志分析系统,流程图解析,整体流程如下:

ETL即Hive查询的sql;

但是,由于本案例的前提是处理海量数据,因而,流程中各环节所使用的技术则跟传统BI完全不同:

1)数据采集:定制开发采集程序,或使用开源框架Flume

2)数据预处理:定制开发mapreduce程序运行于hadoop集群

3)数据仓库技术:基于hadoop之上的Hive

4)数据导出:基于hadoop的sqoop数据导入导出工具

5)数据可视化:定制开发web程序或使用kettle等产品

6)整个过程的流程调度:hadoop生态圈中的oozie工具或其他类似开源产品

3、在一个完整的大数据处理系统中,除了HDFS+MapReduce+Hive组成分析系统的核心之外,还需要数据采集、结果数据导出、任务调度等不可缺少的辅助系统,而这些辅助工具在Hadoop生态体系中都有便捷的开源框架,如图所示:

4、采集网站的点击流数据分析项目流程图分析

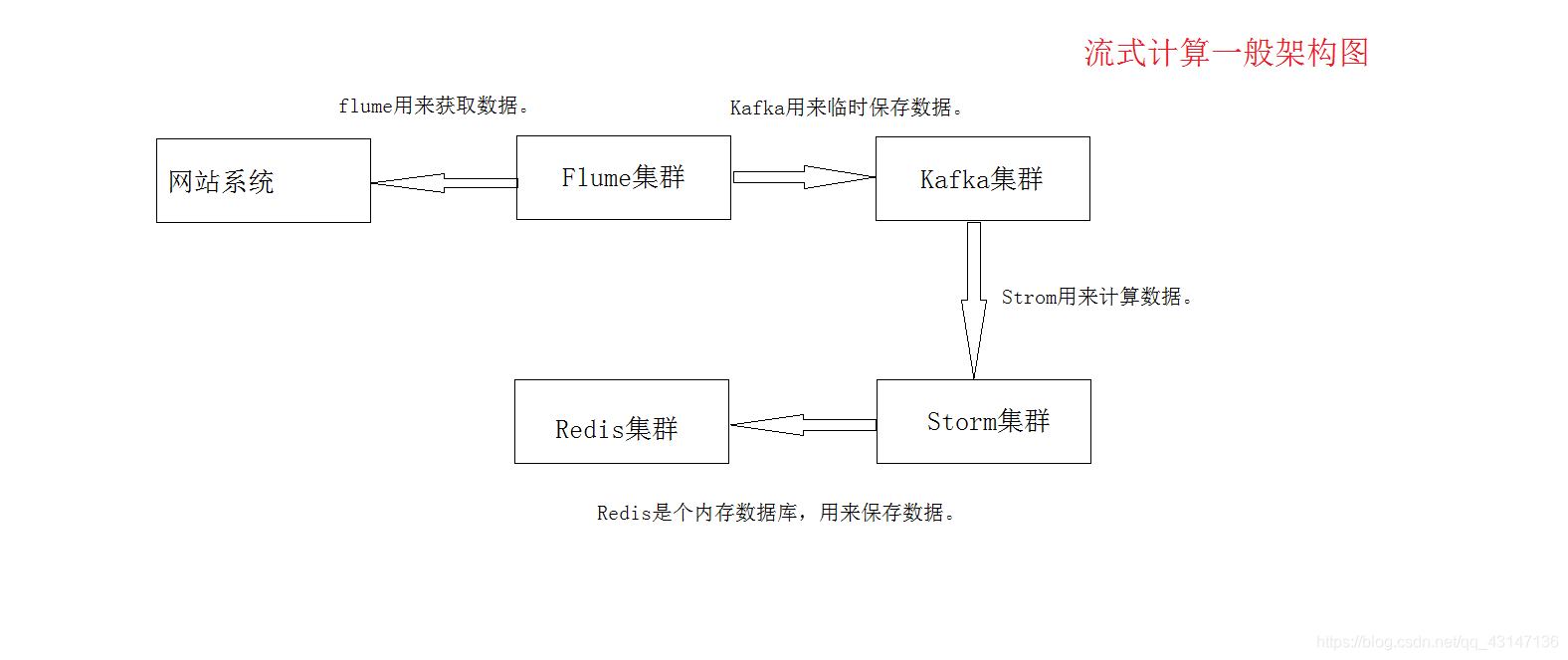

5、流式计算一般架构图

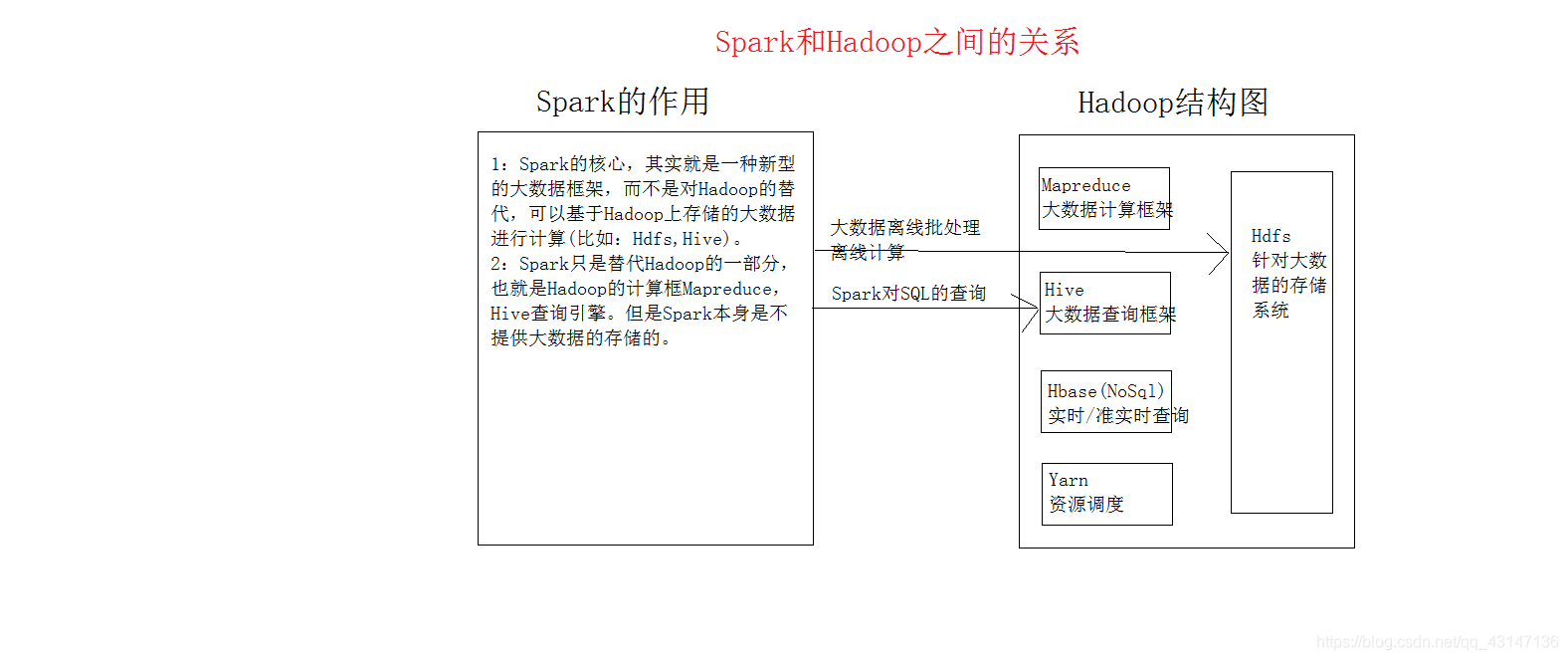

6、Spark和Hadoop之间的关系

更多推荐

已为社区贡献2条内容

已为社区贡献2条内容

所有评论(0)