一文记住什么是TP/TN/FP/FN?

这些工具和指标提供了评估和比较不同模型性能的方法,帮助研究者和工程师确定哪个模型在特定任务上的性能最好。而在实践中,根据应用的具体需求,可能需要关注某些指标多于其他指标。例如,医学测试中的 FN 可能比 FP 更为关键,因为遗漏一个病例的后果可能比误诊更严重。

性能评估指标

1. TP/TN/FP/FN

这些是分类结果的“混淆矩阵”(Confusion Matrix)中的四个基本元素。

TP (True Positive):实际为正,预测也为正。

TN (True Negative):实际为负,预测也为负。

FP (False Positive):实际为负,但预测为正。也被称为 I 类错误或“假阳性”。

FN (False Negative):实际为正,但预测为负。也被称为 II 类错误或“假阴性”。

作者总结:T表示预测正确,F表示预测错误;P表示正,N表示负,FP就是错误的正(即实际为负),FN就是错误的负(就是实际为正)

2. ROC (Receiver Operating Characteristic)

ROC 是一个图形工具,用于展示二元分类器在所有分类阈值下的性能。其主要是一个绘制真阳性率 (TPR) 与假阳性率 (FPR) 的曲线。理想的分类器的 ROC 曲线会尽量靠近左上角。

3. AUC (Area Under the ROC Curve)

AUC 是 ROC 曲线下的面积,用于量化整体模型的性能。AUC 的值在 0 到 1 之间,其中:

AUC = 1:完美的模型。

AUC = 0.5:与随机猜测一样好的模型。

AUC < 0.5:比随机猜测还差的模型(但在实践中,你可以简单地反转预测,使 AUC > 0.5)。

值得注意的是:AUC 被认为是一个很好的指标,特别是当你的类是不平衡的或当你更关心排序而不是绝对的预测时。

总结

这些工具和指标提供了评估和比较不同模型性能的方法,帮助研究者和工程师确定哪个模型在特定任务上的性能最好。而在实践中,根据应用的具体需求,可能需要关注某些指标多于其他指标。例如,医学测试中的 FN 可能比 FP 更为关键,因为遗漏一个病例的后果可能比误诊更严重。

例题与记忆点

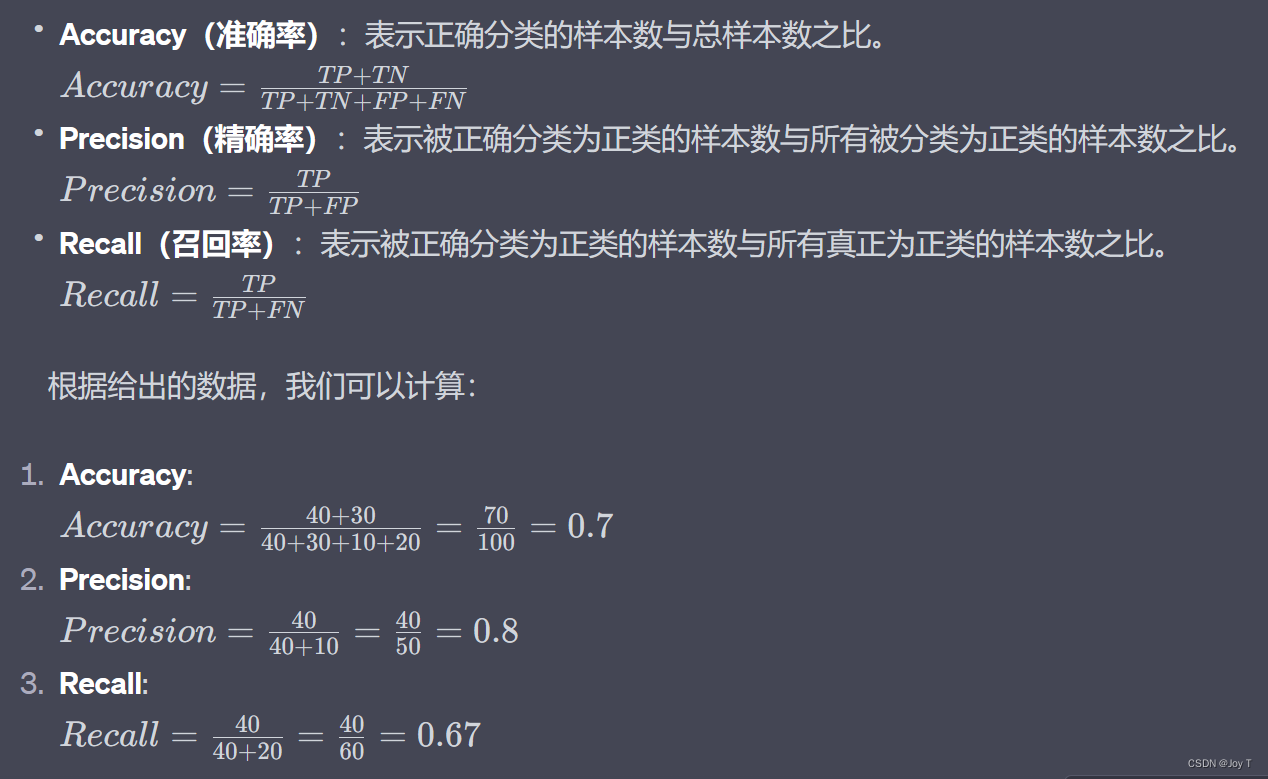

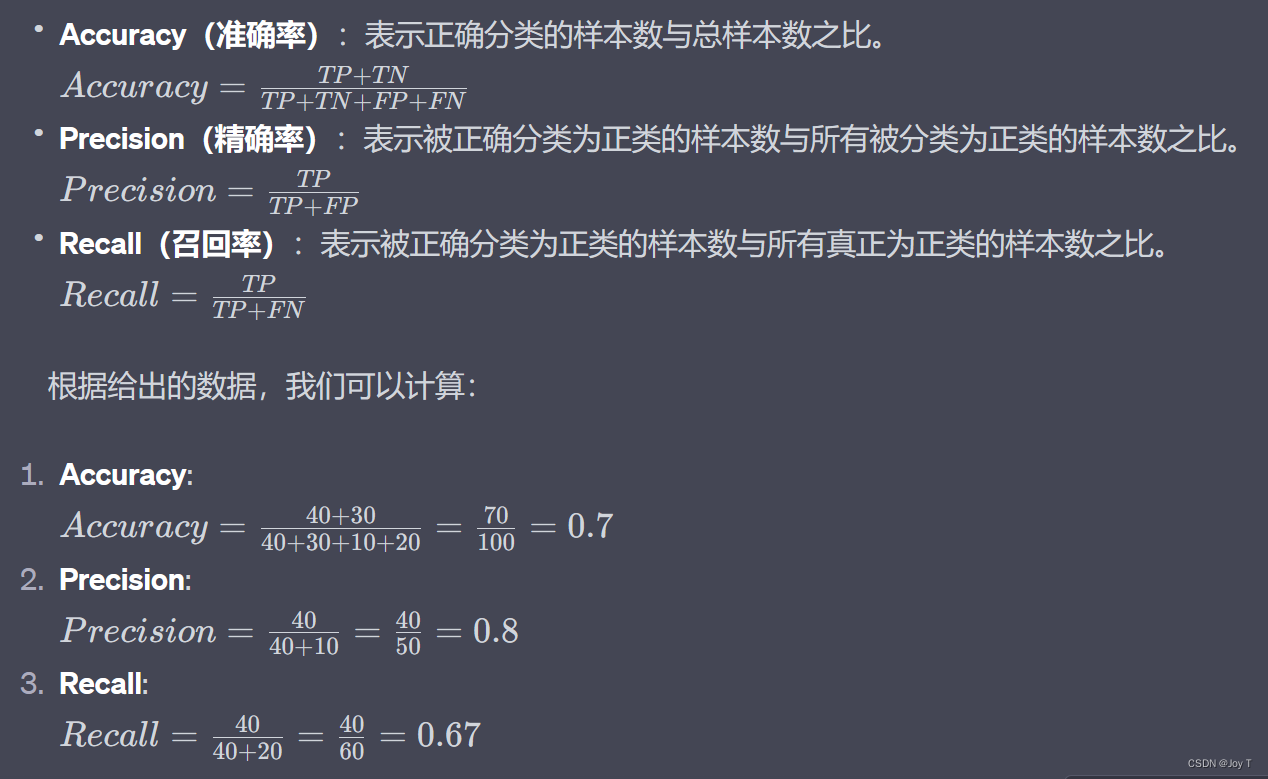

假设有 100 张照片,其中,猫的照片有 60 张,狗的照片是 40 张。识别结果:TP=40,FN=20,FP=10,TN=30,则可以得到:

A. Accuracy=0.8 B. Precision=0.8 C. Recall=0.8

理解和记忆这三个指标的关键在于弄清楚每个指标的背后的核心意义。这里有一些方法和记忆技巧:

-

Accuracy(准确率):预测对的占所有类的比例

- 想象一个目标,你的目标是正确地分类所有样本。所以,准确率就像你打中目标的次数占总射击次数的比例。它是一个全局的度量,考虑了正类和负类。

- 记忆技巧:准确率中的"准"字,想象它是"准确地命中目标"的意思。

-

Precision(精确率):预测对的正类占预测的全部正类

- 想象你是一个金矿工,你正在寻找金块(正类)。每次你认为你找到了金块,这就是你的预测。但并不是所有你找到的都是真金。精确率就像你找到的真金块占你认为是金块的那些东西的比例。

- 记忆技巧:精确率中的"精"字,想象它是"精确地挑选出真金"的意思。

-

Recall(召回率):预测对的正类占真正的全部正类

- 继续上面的金矿工的比喻。在这片土地上有一定数量的真金(真正的正类)。召回率是你找到的真金块占所有真金的比例。这告诉了你可能遗漏了多少真金。

- 记忆技巧:召回率的"召"字,想象它是"召唤"或"找回"所有的真金的意思。

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)