自然语言处理复习

NLP的应用场景:问答系统(智能客服)、情感分析、机器翻译、文本自动摘要、聊天机器人、信息抽取、NLP的主要任务:文本分类:新闻分类、垃圾邮件识别、情感分析、意图识别文本匹配:query-doc搜索、商品检索、QA系统、个性化推荐、智能客服、声纹识别序列标注:分词、词性标注、命名实体识别、关系抽取、事件抽取、句法分析、句子边界检测、语音识别文本生成:文本到文本的生成:机器翻译、文本摘要、古诗生成、

·

一、NLP的应用场景:

问答系统(智能客服)、情感分析、机器翻译、文本自动摘要、聊天机器人、信息抽取

二、NLP的主要任务:

- 文本分类:新闻分类、垃圾邮件识别、情感分析、意图识别

- 文本匹配:query-doc搜索、商品检索、QA系统、个性化推荐、智能客服、声纹识别

- 序列标注:分词、词性标注、命名实体识别、关系抽取、事件抽取、句法分析、句子边界检测、语音识别

- 文本生成:

文本到文本的生成:机器翻译、文本摘要、古诗生成、智能对话

数据到文本的生成:自动撰写

图像到文本的生成:基于图像问答、看图说话

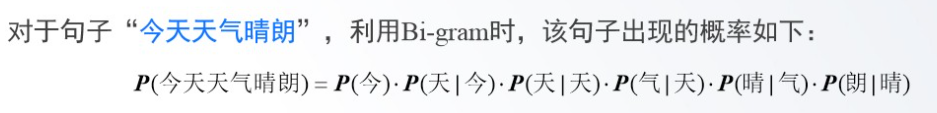

三、N元语法模型:

N-Gram模型,又称N元语法模型,是一种基于统计语言模型的算法。

利用N元语法模型计算句子出现的概率

二元语法模型

四、区分分词、词性标注、命名实体识别和依存句法分析的概念:

分词:将输入的汉字串切成词串

词性标注:确定每个词的词性标并加以标注

命名实体识别:确定文本中具有特定意义或者指代性强的实体

依存句法分析:依存句法通过分析语言单位内成分之前的依存关系解释其句法结构,主张句子中核心动词是支配其他成分的中心成分。而它本身却不受其他任何成分的支配,所有受支配成分都以某种关系从属于支配者。

五、one-hot编码的定义及优缺点

- 定义:one-hot即独立热词,词语被表示成一个维度为词表大小的向量,这个向量中只有一个维度是1其他位置都是0。

- 优点:能够处理机器学习算法不好处理的离散特征值;在一定程度上增加了特征的维度;将离散型特征使用one-hot编码,可以会让特征之间的距离计算更加合理

- 缺点:one-hot编码假设单词与单词之间是独立的,无法体现单词与单词的关系远近程度,因此会丢失相关语义信息;每个单词的one-hot编码维度是整个词汇表的大小,维度非常巨大,编码稀疏,会使得计算代价变大;如果原本的标签编码是有序的,那么one-hot编码就会丢失顺序信息

六、机器学习的文本预处理:

- 分词:中文任务分词必不可少,一般使用jieba分词,工业界的翘楚

去停用词:将一些词频较低或者常用的词去掉,减小词典,防止过拟合 - 词性标注:在分词后判断词性(动词、名词、形容词、副词…),词性也是一个特征

- WORD_EMBEDDING:就是word2vec或者glove等。word-embedding作为传统机器学习算法的特征,同时也是深度学习方法必不可少的步骤(深度学习中单字和词的embedding都需要)。

- TFIDF:提取tfidf文本特征

七、基于深度学习的文本预处理:

分词;

去停用词;

创建词典(加入和);

Padding填充:因为深度学习模型要求输入的文本长度一致;WORD_EMBEDDING(也可以作为模型部分进行);

八、数据预处理有哪些操作:

数据清洗( 排除非关键信息)、分词处理( Stanford NLP分词、jieba分词、中科院NLPIR汉语分词等)、特征构造(词袋模型、N-gram模型)、特征降维( L1惩罚项的模型、主成分分析法(PCA)、线性判别分析(LDA))与选择(Filter过滤法、Wrapper(包装法)、Embedded(嵌入法)、深度学习方法)

九、word2vec编码的定义及优缺点(对比one-hot) :

定义:

优点:通用性很强,可以用在各种NLP任务中

缺点:

由于词和向量是—对—的关系,所以多义词的问题无法解决。

Word2vec是一种静态的方式,虽然通用性强,但是无法针对特定任务做动态优化

十、文本分类任务的功能及应用场景

通常来讲,文本分类任务是指在给定的分类体系中,将文本指定分到某个或某几个类别中。

应用场景:

垃圾邮件的判定:是否为垃圾邮件

根据标题为图文视频打标签:政治、体育、娱乐等

根据用户阅读内容建立画像标签:教育、医疗等

电商商品评论分析等等类似的应用:消极、积极

自动问答系统中的问句分类

十一、TF-IDF的定义及计算TF-IDF值:

TF(term frequency)︰词频,某个词在文档中出现的次数,TF越大一般来说越重要

DF (document frequency)︰文档频率,某个词在所有文档中出现的文档数,DF越大表示这词越有可能是常用词,自然也越不重要

IDF (inverse document frequency):逆文档频率,它是DF 的倒数,IDF越大表示该词越少见,也越重要

TF-IDF : TF * IDF,综合了TF和IDF两个因素来平衡词的重要性

计算:

十二、机器翻译的概念:

机器翻译就是把一种语言翻译成另外一种语言

十三、基于机器学习的文本分类模型

机器学习只能对词向量进行简单的平均或者加权平均

模型主要有:逻辑回归、朴素贝叶斯、KNN方法、决策树、支持向量机、GBDT/XGBOOST

十四、未登录词

一种是指已有的词表中没有收录的词,另一种是指训练语料中未曾出现过的词

十五、Seq2Seq模型

Seq2Seq是一种重要的RNN模型,也称为Encoder-Decoder模型,可以理解为一种N×M的模型,模型包含两个部分

Encoder用于编码序列的信息,将任意长度的序列信息编码到一个向量c里

Decoder是解码器,解码器得到上下文信息向量c之后可以将信息解码,并输出为序列

十六、编码器、解码器的功能

编码器:

Encoder的RNN接受输入x,最终输出一个编码所有信息的上下文向量c,中间的神经元没有输出

解码器:

主要作用:Decoder主要传入的是上下文向量c,然后解码出需要的信息

十七、信息抽取的定义

从自然语言文本中,抽取出特定的事件或实时信息,帮助我们将海量内容自动分类、提取和重构。这些信息通常包括实体(entity)、关系(relation)、事件(event)

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)