简介

该用户还未填写简介

擅长的技术栈

未填写擅长的技术栈

可提供的服务

暂无可提供的服务

论文学习-BERT: Pre-training of Deep Bidirectional Transformers for Language Understanding

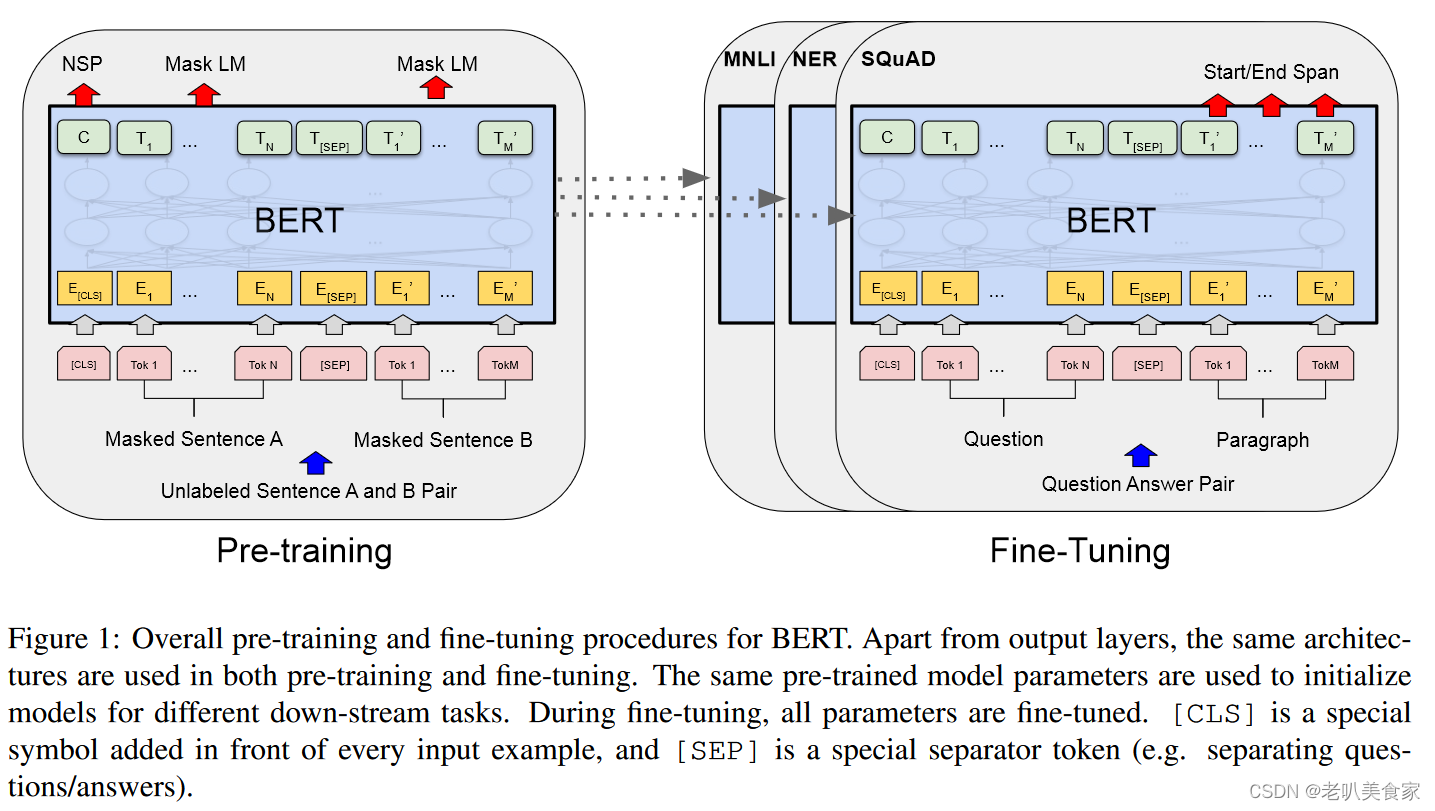

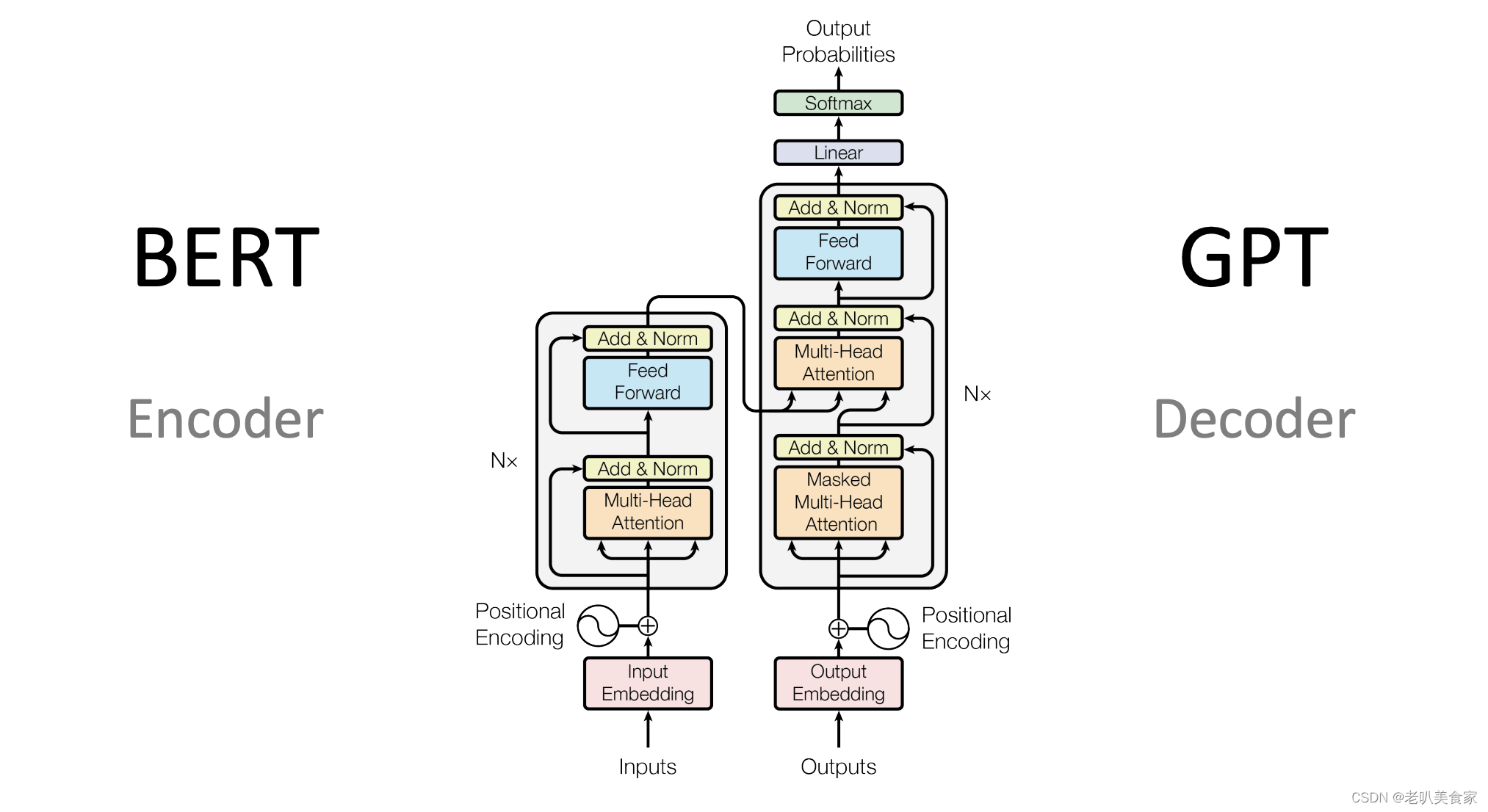

BERT:ncoder作者觉得现有的方法限制了预训练模型表征特征的能力,因为现有的方法是无向的(OpenAI GPT 使用的是从左到右的结构,Attention层中的每个Token只能关注到之前的Token)。在某些句子层级的任务上,这种限制是次优的,甚至在问答任务上,这种限制是有害的,因为需要从两个方向对句子的语义进行处理。

论文学习-Bert 和GPT 有什么区别?

总结一下:Bert 是学习向量表征,让句子中某个词的Embedding关联到句子中其他重要词。最终学习下来,就是词向量的表征。这也是为什么Bert很容易用到下游任务,在做下游任务的时候,需要增加一些MLP对这些特征进行分类啥的,也就是所谓的微调fine-tune。GPT在做生成,结果是下一个特定词被选中的概率。给一个句子,去生成下一个字,然后再把这个字包含到句子中,重新送入模型,再生成下一个字。周

到底了