人工智能的基石之三:硬件

高性能硬件是人工智能的基石,尤其是在机器学习和深度学习领域,海量数据是常态。从充当计算机大脑的中央处理器 (CPU) 到加速计算的图形处理器 (GPU),硬件的作用是提供处理和运行复杂数据算法所需的原始能力。

高性能硬件是人工智能的基石,尤其是在机器学习和深度学习领域,海量数据是常态。从充当计算机大脑的中央处理器 (CPU) 到加速计算的图形处理器 (GPU),硬件的作用是提供处理和运行复杂数据算法所需的原始能力。

文章目录

一、通用芯片的并行革命:CPU 与 GPU

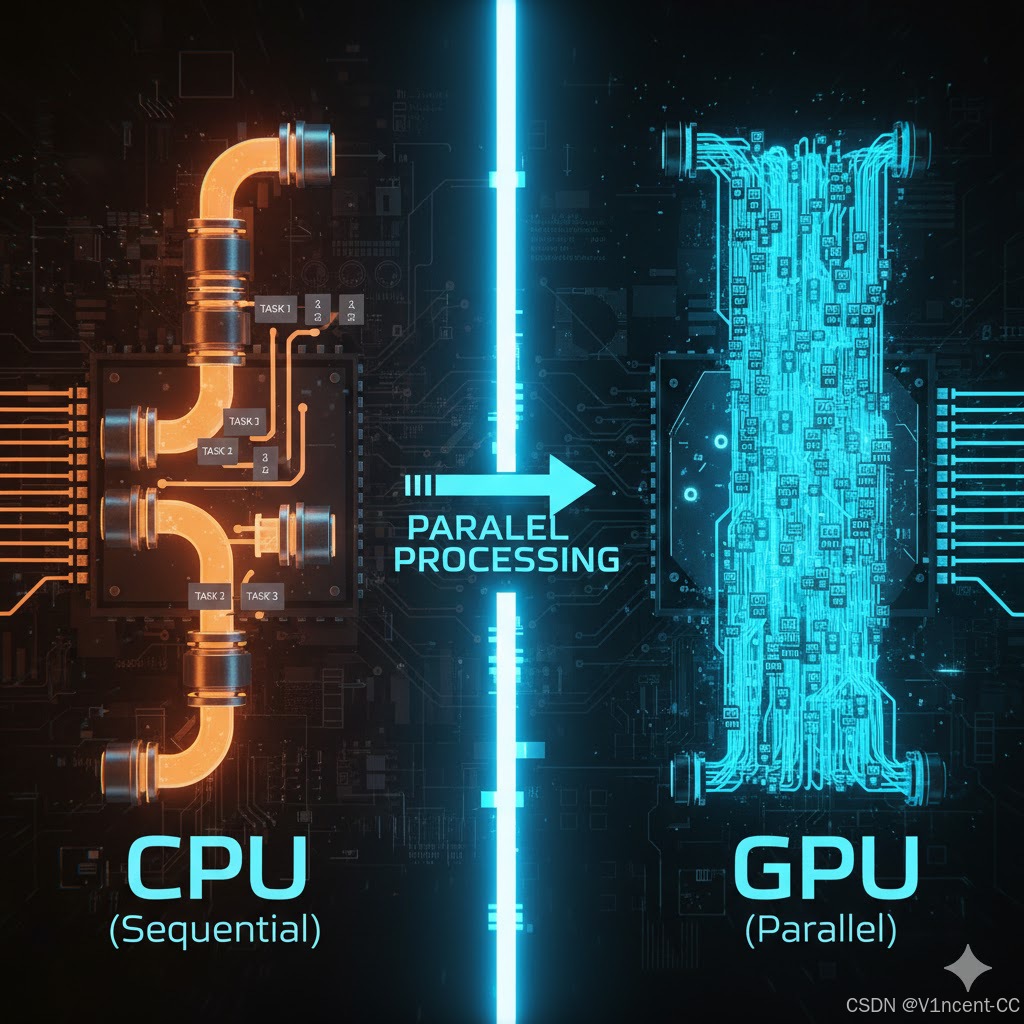

在人工智能发展的早期阶段,计算主要通过 中央处理器 (CPU) 执行。CPU 以功能强大、能够执行各种通用任务而闻名,但其架构专注于顺序处理,即指令逐条执行。虽然 CPU 高效完成一般计算任务,但高级 AI(尤其是深度学习)需要对海量数据集进行复杂的数学运算,这要求并行处理而非顺序处理。

这时人们将注意力转向了 图形处理器(GPU)。尽管 GPU 最初的设计目的是处理游戏中像素丰富的图像渲染,但它天生专为并行处理而设计,能够同时执行数千个计算。

1.1 核心加速器:NVIDIA CUDA

GPU 成功转型的关键在于 NVIDIA CUDA (Compute Unified Device Architecture,统一计算设备架构)允许软件开发人员和科学家使用 GPU 来进行通用计算(而不只是图形渲染),这极大地降低了并行计算的门槛。

正是 CUDA 的成熟,使得 PyTorch 和 TensorFlow 等主流深度学习框架能够轻松地利用 NVIDIA GPU 的计算能力,从而确立了 NVIDIA 在 AI 硬件领域的强大软件生态壁垒。

GPU 在 AI 中的广泛应用,使其生产和价格受到企业和政府的严格监控,这也导致芯片成为贸易战制裁的对象。

例如,2022 年 9 月,美国商务部将七家中国超级计算实体列入“实体名单”,限制向这些实体出口某些商品和技术。这项禁令旨在阻止中国将芯片用于军事用途,但对人工智能行业的影响却深远。该禁令影响了两大芯片制造商——英伟达(Nvidia)和超微半导体(AMD)对中国的芯片出口,使得中国企业更难以获得构建人工智能应用程序所需的GPU。

但贸易战也促使中国增加对本国芯片制造的投资,这可能会促进新的芯片创新、供应链和制造工艺的发展。

二、专用芯片的能效飞跃:TPU

AI 硬件领域正在向更定制化、更高效的方向发展,随着人工智能领域的发展,对更专业硬件的需求也随之而来,这促使了由谷歌开发的 TPU(Tensor Processing Unit,张量处理单元) 的出现。

TPU 是一种专用集成电路 (ASIC),专为加速机器学习工作负载而开发,以张量(多维数组,深度学习中的核心数据结构)命名,该结构指的是具有多个变量的多维数组。第一代 TPU 于 2016 年在谷歌内部使用,以提高其机器学习系统(如谷歌搜索和谷歌翻译)的效率。

TPU 和传统 GPU 之间的显著区别在于它们的架构:

- GPU 旨在处理大量相对较小的计算核心进行并行处理,这非常适合图形渲染,并且对某些类型的机器学习任务有益。

- TPU 专注于大型矩阵乘法单元设计,移除了通用计算所需的冗余组件,将晶体管主要用于矩阵乘法单元(Matrix Multiplication Units, MXU),从而实现了在训练和推理特定 Google 模型(如 BERT、Transformer)时无与伦比的效率。

虽然TPU相比GPU有较低的计算精度(这通常是神经网络工作负载可以接受的),但它可以显著提升性能,这使得 TPU 能够高效执行深度学习算法中常见的大规模矩阵运算,运行机器学习应用程序等方面比 GPU 快得多,而且更节能。

2.1 GPU 与 TPU 对比

| 特征 | GPU(图形处理器) | TPU(张量处理器) |

|---|---|---|

| 核心 | 大量相对较小的计算核心 | 大型矩阵乘法单元 (MXU) |

| 模式 | 通用并行计算(图形渲染和机器学习) | 专用于大规模矩阵运算(深度学习) |

| 精度 | 具有更高的通用精度选项 | 较低的计算精度,但足以满足神经网络需求 |

| 优势 | 灵活性高,适用于广泛的并行任务。 | 在运行机器学习应用方面速度更快、更节能。 |

三、AI 硬件的前沿趋势:专业化与异构计算

随着 AI 模型的不断发展,硬件的未来趋势是细分和整合,随着物联网和实时处理需求的增加,AI 推理任务正从云端迁移到本地设备(如智能手机、自动驾驶汽车、传感器)。这催生了 NPU (Neural Processing Unit,神经处理单元)。

NPU 是专用于 推理任务的低功耗 ASIC,通常集成在 CPU 芯片内部,以实现本地、快速、节能的图像识别和语音处理功能。

3.1 AI 硬件对比

| 硬件类型 | 核心设计理念 | 主要职能与应用 |

|---|---|---|

| CPU (中央处理器) | 通用计算,少数复杂核心 | 逻辑控制、顺序处理、通用计算任务。 |

| GPU (图形处理器) | 大规模并行计算,大量简单核心 | 深度学习训练、通用计算加速、图形渲染。 |

| TPU (张量处理器) | 专用集成电路 (ASIC),MXU 核心 | 大规模训练和推理,高能效比。 |

| NPU (神经处理单元) | 低功耗 ASIC | 边缘设备推理,本地化、实时 AI 任务。 |

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)