革命性AI工具Open Interpreter:本地代码执行新范式

你是否曾因ChatGPT代码解释器的文件大小限制而中断数据分析工作?是否因云端环境缺乏必要依赖库而无法运行复杂模型?Open Interpreter的出现彻底改变了这一现状。作为一款开源本地代码执行框架,它将大语言模型(LLM)的代码理解能力与本地开发环境的自由度完美结合,开创了AI辅助编程的全新范式。**读完本文你将掌握:**- Open Interpreter与传统云端代码解释器的核心差...

革命性AI工具Open Interpreter:本地代码执行新范式

【免费下载链接】open-interpreter

引言:AI代码执行的痛点与突破

你是否曾因ChatGPT代码解释器的文件大小限制而中断数据分析工作?是否因云端环境缺乏必要依赖库而无法运行复杂模型?Open Interpreter的出现彻底改变了这一现状。作为一款开源本地代码执行框架,它将大语言模型(LLM)的代码理解能力与本地开发环境的自由度完美结合,开创了AI辅助编程的全新范式。

读完本文你将掌握:

- Open Interpreter与传统云端代码解释器的核心差异

- 本地全环境部署与多语言执行的实现方法

- 安全模式与容器化执行的风险控制策略

- 高级特性OS模式与视觉交互的应用场景

- 企业级应用的性能优化与定制开发指南

技术架构:重新定义AI与本地环境的交互方式

Open Interpreter的革命性在于其独创的"计算机API"架构,通过分层设计实现了LLM与本地系统的安全高效交互。

核心组件架构

核心创新点:

- 模块化设计:将系统功能拆分为独立模块(文件操作/终端控制/视觉识别),LLM可通过统一API调用

- 多语言执行引擎:内置对Python/Shell/JavaScript等12种语言的原生支持,通过

Terminal类实现统一调度 - 流式输出机制:采用生成器模式实时返回代码执行结果,解决大输出场景的内存占用问题

与传统工具的技术对比

| 特性 | Open Interpreter | ChatGPT代码解释器 | Colab |

|---|---|---|---|

| 执行环境 | 本地完全控制 | 云端沙箱 | 云端虚拟机 |

| 依赖管理 | 支持任意库安装 | 仅预安装基础库 | 需手动安装 |

| 文件系统 | 完整访问权限 | 临时存储(120分钟) | 会话级存储 |

| 网络访问 | 无限制 | 完全禁止 | 受限访问 |

| 最大文件尺寸 | 无限制 | 100MB | 取决于存储配额 |

| 安全模型 | 用户确认+沙箱选项 | 完全隔离 | 项目级隔离 |

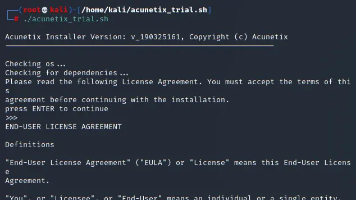

快速部署:5分钟搭建本地AI开发环境

系统要求与环境准备

Open Interpreter支持跨平台部署,最低配置要求:

- Python 3.10+环境

- 8GB RAM(本地LLM运行需16GB+)

- 网络连接(首次安装与模型下载)

基础安装命令:

# 基础版安装

pip install open-interpreter

# 完整功能安装(含安全工具与视觉支持)

pip install open-interpreter[safe,os,local]

本地LLM配置指南

对于隐私敏感场景,可配置本地大语言模型(以Ollama为例):

from interpreter import interpreter

# 配置本地模型

interpreter.offline = True

interpreter.llm.model = "ollama_chat/llama3"

interpreter.llm.api_base = "http://localhost:11434"

# 启动交互会话

interpreter.chat("分析当前目录下所有CSV文件并生成可视化报告")

支持的本地模型:

- Ollama生态(Llama 3/Mistral/Phi-3)

- LM Studio

- Jan.ai

- Llama.cpp兼容模型

核心功能详解:解锁本地环境的全部潜能

多语言代码执行引擎

Open Interpreter的终端模块支持12种编程语言的无缝切换,通过统一接口实现代码执行:

# 执行Python代码

interpreter.computer.run("python", """

import pandas as pd

df = pd.read_csv('sales_data.csv')

print(df.groupby('region')['revenue'].sum())

""")

# 执行Shell命令

interpreter.computer.run("shell", "ls -la | grep .py | wc -l")

# 执行JavaScript

interpreter.computer.run("javascript", """

const fs = require('fs');

const files = fs.readdirSync('.').filter(f => f.endsWith('.json'));

console.log(files);

""")

语言扩展机制:通过继承BaseLanguage类可自定义新语言支持:

from interpreter.computer.terminal.base_language import BaseLanguage

class Rust(BaseLanguage):

name = "rust"

aliases = ["rs"]

def run(self, code):

# 实现Rust代码执行逻辑

pass

# 注册新语言

interpreter.computer.languages.append(Rust)

安全模式与风险控制

针对企业级应用的安全需求,Open Interpreter提供多层次防护机制:

安全模式部署:

# 安装安全依赖

pip install open-interpreter[safe]

# 启动安全模式

interpreter --safe auto

安全模式核心功能:

- 代码扫描:集成Semgrep进行漏洞检测

- 执行确认:代码运行前强制用户确认

- 权限控制:基于文件路径的访问白名单

容器化执行方案:

# docker-compose.yml

version: '3'

services:

interpreter:

image: python:3.11-slim

volumes:

- ./workspace:/workspace

command: interpreter --safe auto

security_opt:

- no-new-privileges:true

高级应用场景:从自动化办公到AI视觉交互

OS模式:AI驱动的操作系统自动化

Open Interpreter的OS模式突破了传统CLI交互的限制,使AI能够通过视觉识别和键鼠控制与图形界面交互:

# 启动OS模式(需授予屏幕录制权限)

interpreter --os

典型应用流程:

- 屏幕捕获:定期获取活动窗口画面

- 视觉分析:使用Moondream2模型解析界面元素

- 动作规划:生成键鼠操作序列

- 执行反馈:验证操作结果并迭代

企业级数据处理案例

某金融科技公司利用Open Interpreter构建的自动化报表系统:

# 数据处理自动化脚本

from interpreter import interpreter

# 配置企业级参数

interpreter.auto_run = True

interpreter.llm.model = "gpt-4"

interpreter.max_output = 10000

# 执行复杂数据分析

interpreter.chat("""

1. 读取/data/2024Q1_transactions.csv

2. 按地区统计交易额并生成饼图

3. 检测异常交易(金额>100000且夜间交易)

4. 将结果保存为Excel报表并发送邮件至finance@company.com

""")

性能优化策略:

- 设置

context_window=8192适配长代码上下文 - 启用

stream=True实现增量结果输出 - 使用

%reset命令定期清理内存

未来演进:AI与本地环境交互的下一代形态

Open Interpreter roadmap揭示了三个关键发展方向:

1. 增强型安全沙箱

- 基于Cosmopolitan LibC的跨平台安全执行环境

- 实时代码行为监控与异常终止机制

- 细粒度权限控制(文件/网络/系统调用)

2. 多模态交互进化

3. 分布式计算支持

- 集群模式下的任务自动分片

- 基于WebRTC的P2P模型协同推理

- 边缘设备与云端资源的动态调度

结语:重新定义人机协作的边界

Open Interpreter的革命性不仅在于技术实现,更在于它重新定义了AI与人类协作的方式。通过将LLM的认知能力与本地环境的无限可能相结合,它打破了传统IDE的交互范式,创造出一种"自然语言编程"的全新体验。

立即行动:

# 源码安装体验最新特性

git clone https://gitcode.com/GitHub_Trending/ope/open-interpreter

cd open-interpreter

pip install -e .[all]

interpreter --verbose

随着本地LLM性能的持续提升和安全机制的完善,Open Interpreter有望成为连接AI与现实世界的关键基础设施,推动编程从"指令式"向"目标式"的范式转变。

注意:开源项目处于快速迭代中,生产环境部署前请查阅最新安全指南。企业用户建议通过Docker容器化部署并启用安全模式。

附录:快速参考指南

常用命令速查表

| 命令 | 功能 |

|---|---|

interpreter --safe auto |

启用自动代码扫描 |

interpreter --local |

使用本地LLM模式 |

interpreter --os |

启动视觉交互OS模式 |

%verbose true |

显示详细执行日志 |

%reset |

重置对话历史 |

配置文件示例

# ~/.interpreter/default.yaml

model: gpt-4

temperature: 0.1

auto_run: false

safe_mode: ask

context_window: 4096

max_tokens: 1000

支持的编程语言

- 主流语言:Python/JavaScript/Shell/Ruby

- 数据科学:R/Julia

- 系统脚本:PowerShell/AppleScript

- 前端开发:HTML/React

【免费下载链接】open-interpreter

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)