【极客技术】英特尔的“Gaudi 3”人工智能加速芯片可能会让英伟达H100面临挑战

英特尔声称,在运行人工智能语言模型时,其速度比市场领先者快50%。 4月9日,英特尔在凤凰城举办的Vision 2024活动上发布了一款名为“Gaudi 3”的新型人工智能加速芯片。由于在运行大型语言模型(如ChatGPT所依赖的模型)时表现出强大的性能,英特尔将Gaudi 3定位为Nvidia H100的替代品。H100是一款颇受欢迎的数据中心GPU,虽然一度供不应求,但情况似乎正在逐渐缓解。

英特尔声称,在运行人工智能语言模型时,其速度比市场领先者快50%。

4月9日,英特尔在凤凰城举办的Vision 2024活动上发布了一款名为“Gaudi 3”的新型人工智能加速芯片。由于在运行大型语言模型(如ChatGPT所依赖的模型)时表现出强大的性能,英特尔将Gaudi 3定位为Nvidia H100的替代品。H100是一款颇受欢迎的数据中心GPU,虽然一度供不应求,但情况似乎正在逐渐缓解。

与Nvidia的H100芯片相比,英特尔预计,无论是OpenAI的GPT-3 175B大型语言模型,还是Meta的Llama 2的70亿参数版本,在Gaudi 3上的训练时间都将快50%。在推理(运行已训练模型以获取输出)方面,英特尔声称其新型AI芯片在Llama 2和Falcon 180B这两个开源模型上的性能比H100快50%。

英特尔之所以瞄准H100,是因为其市场占有率高,但这款芯片并非英伟达即将推出的最强大的AI加速芯片。虽然英伟达已宣布H200和Blackwell B200两款芯片,且在纸面性能上已经超越了H100,但这两款芯片都尚未上市(H200预计将于2024年第二季度上市——也就是近期内)。

与此同时,上述H100的供应问题一直是科技公司和AI研究人员的一大困扰,他们不得不争夺任何能够训练AI模型的芯片。这导致微软、Meta和OpenAI(据传)等多家科技公司寻求自己设计AI加速芯片,尽管这些定制芯片通常由英特尔或台积电制造。谷歌自2015年以来一直在内部使用自己的张量处理单元(TPU)系列。

鉴于上述问题,如果英特尔能够以理想的价格(英特尔尚未提供,但据报道H100的价格约为3万至4万美元)推出Gaudi 3,并维持充足的生产,那么它可能会成为H100的一个有吸引力的替代品。AMD也生产了一系列具有竞争力的AI芯片,如AMD Instinct MI300系列,售价约为1万至1.5万美元。

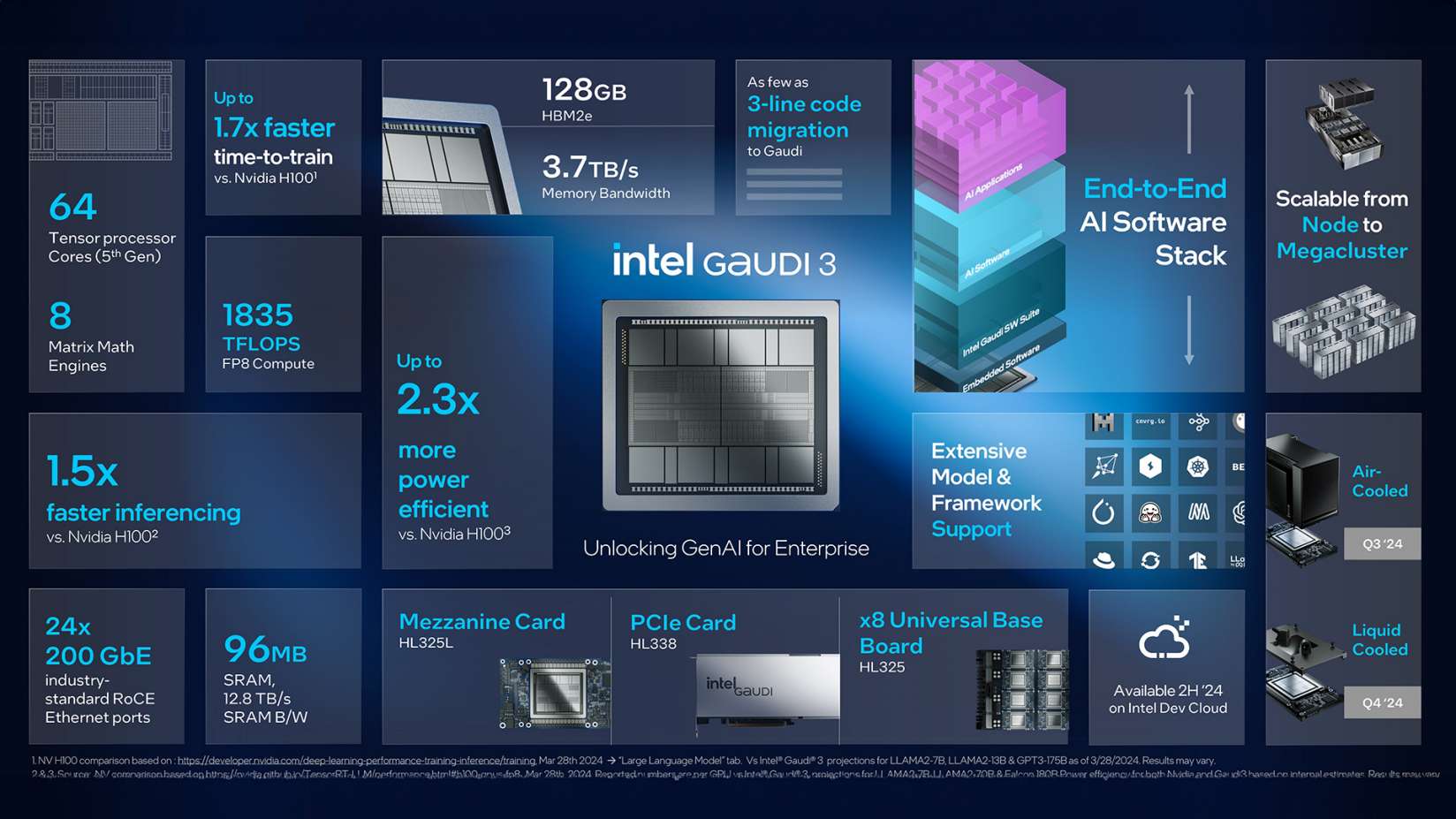

“Gaudi 3”的性能

英特尔表示,这款新芯片在其前身Gaudi 2架构的基础上进行了升级,采用了两个通过高带宽连接相连的相同硅晶片。每个晶片包含一个48兆字节的中央缓存存储器,周围有四个矩阵乘法引擎和32个可编程张量处理器内核,总计64个内核。

这家芯片制造巨头声称,Gaudi 3使用8位浮点基础设施的AI计算能力达到Gaudi 2的两倍,这在训练Transformer模型方面至关重要。同时,该芯片使用BFloat 16位数值格式进行计算的性能也提升了四倍。此外,Gaudi 3还配备了128GB价格相对实惠的HBM2e内存容量(这可能有助于其价格上的竞争力),并具备3.7TB的内存带宽。

鉴于数据中心以高耗电量著称,英特尔强调Gaudi 3的能效,声称与英伟达的H100相比,在处理Llama 7B和70B参数以及Falcon 180B参数模型时,其推理能效提高了40%。英特尔Habana Labs的首席运营官伊坦·梅迪纳(Eitan Medina)将此优势归功于Gaudi的大型矩阵数学引擎,他声称与其他架构相比,这些引擎所需的内存带宽显著减少。

Gaudi vs. Blackwell

上个月,我们报道了英伟达声势浩大的Blackwell架构发布,其中包括B200 GPU,英伟达声称这将是世界上最强大的AI芯片。因此,将英伟达性能最高的AI芯片与英特尔目前能生产出的最佳产品进行比较,似乎顺理成章。

据IEEE Spectrum报道,Gaudi 3采用了台积电(TSMC)的N5制程技术,从而缩小了英特尔与英伟达在半导体制造技术方面的差距。即将推出的英伟达Blackwell芯片将使用定制的N4P制程,据报道,该制程在性能和效率方面相比N5有所改进。

与竞品芯片中使用的更昂贵的HBM3或HBM3e相比,Gaudi 3使用的HBM2e内存(如我们之前提到的)在性能和成本效益之间取得了平衡。这一选择似乎强调了英特尔不仅在性能上竞争,而且在价格上也进行竞争的策略。

至于Gaudi 3和B200在原始性能上的比较,只有在芯片发布并由第三方进行基准测试后,我们才能得知。

随着科技行业对AI计算能力需求激增的竞赛持续升温,IEEE Spectrum指出,英特尔Gaudi芯片的下一代产品,代号为Falcon Shores的芯片仍备受关注。英特尔是否会继续依赖台积电的技术,还是利用自家的代工业务以及即将推出的纳米片晶体管技术,在AI加速器市场上获得竞争优势,目前尚不得而知。

更多推荐

已为社区贡献7条内容

已为社区贡献7条内容

所有评论(0)