Ring-1T-preview – 蚂蚁百灵开源的万亿参数推理大模型

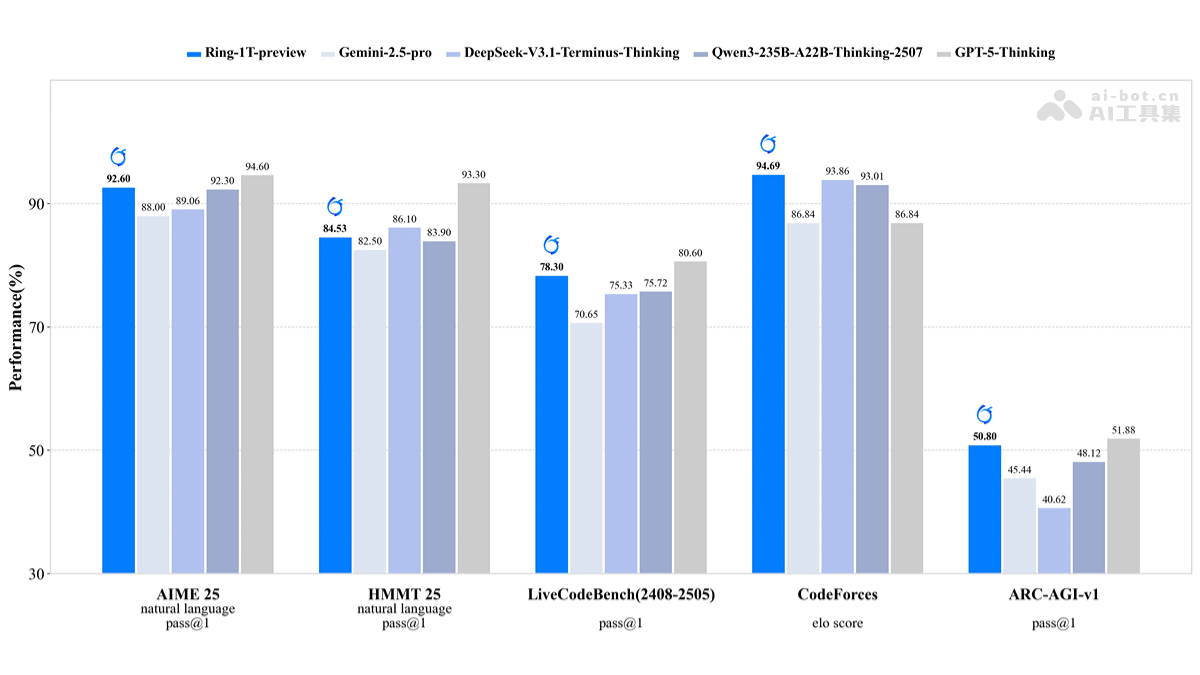

蚂蚁集团开源万亿参数大模型Ring-1T-preview,基于Ling 2.0 MoE架构,在20T语料上预训练并通过ASystem强化学习系统训练。该模型在多项测试中表现优异:AIME 2025获92.6分接近GPT-5,IMO 2025成功解答难题,并在代码生成等任务超越GPT-5。采用MoE架构实现高效计算,支持多智能体框架应用,完全开源以促进协作创新。适用于自然语言推理、代码生成、学术研究

·

Ring-1T-preview是什么

Ring-1T-preview 是蚂蚁集团开源的万亿参数大模型预览版,基于 Ling 2.0 MoE 架构,在 20T 语料上预训练,通过自研强化学习系统 ASystem 进行推理能力训练。在自然语言推理方面表现出色,AIME 2025 测试中得分 92.6,接近 GPT-5。在 IMO 2025 测试中,一次性解出第 3 题,在其他题目给出部分正确答案,展现出高阶推理能力。

Ring-1T-preview的主要功能

- 强大的自然语言推理能力:在 AIME 2025 测试中取得 92.6 分,接近 GPT-5 的 94.6 分,展现出强大的数学推理能力。

- 高效的问题解决能力:在 IMO 2025 测试中,一次性解出第 3 题,并在其他题目上给出部分正确答案,具备高阶推理能力。

- 多领域竞争力:在 HMMT 2025、LiveCodeBench v6、CodeForces 和 ARC-AGI-1 等任务中表现突出,展现出广泛的适用性。

- 开源协作:代码与权重完全开源,发布在 Hugging Face 平台,便于社区探索与反馈,加速模型迭代完善。

Ring-1T-preview的技术原理

- 架构设计:采用 Ling 2.0 MoE 架构,结合万亿参数规模,为模型提供了强大的表达能力和高效的计算效率。

- 预训练语料:在 20T 高质量语料上完成预训练,确保模型能够学习到丰富的语言知识和模式。

- 强化学习训练:通过自研的高效强化学习系统 ASystem 进行针对推理能力的 RLVR 训练,提升模型的推理和决策能力。

- 持续迭代:模型仍在持续训练中,不断优化性能,解决当前存在的问题,如语种混杂、推理重复等。

Ring-1T-preview的项目地址

Hugging Face模型库:https://huggingface.co/inclusionAI/Ring-1T-preview

Ring-1T-preview的应用场景

- 自然语言推理任务:在 AIME 25 测试中获得 92.6 分,接近 GPT-5 的 94.6 分,展现出强大的数学推理能力。

- 代码生成与优化:在 CodeForces 测试中以 94.69 分的成绩超过 GPT-5,证明了其出色的代码生成能力。

- 多智能体框架应用:接入多智能体框架 AWorld,可用于测试和探索复杂的推理任务。

- 学术研究与开发:作为全球首个开源的万亿参数推理大模型,为研究者和开发者提供高性能、可复现的推理基座,推动大模型生态的透明化与协作创新。

更多推荐

已为社区贡献5条内容

已为社区贡献5条内容

所有评论(0)