【大模型理论篇】AI原生应用的关键要素之架构

AI原生架构、大模型、智能体、Agents、智能体架构、Agents架构、React、Plan-Execute、Cot、Self-Ask、ToT、Reflextion、Role-Playing

最近在看阿里发布的《AI原生应用架构白皮书》,写的还挺好的。这里讨论了关于架构相关的内容,一起学习。

1. 为什么 AI Agent 和传统微服务不一样

- 传统微服务(Spring/Dubbo):组件清晰、流程稳定,服务发现、RPC、分布式事务、配置管理都有成熟方案,整体设计易收敛。

- AI Agent:LLM 带来不确定性;没有“一招通吃”的模式,需按场景组合与迭代。常见框架如 LangChain、LlamaIndex、Dify 等,各有侧重,更多是“混合编排”。

五种常见 Agent 设计模式

- Chain of Thought(思维链):引导模型“写出步骤”,把推理过程摊开,答案更稳。

- Self-Ask(自问自答):把大问题拆成小问题,先自问再检索,最后组合结论。

- ReAct(推理 + 行动):在“推理”与“外部动作”(搜索/调用 API)间交替,既能思考也能与世界交互。

- Plan-and-Execute(计划与执行):先做计划,再分步执行,适合复杂、多阶段任务。

- Tree of Thoughts(树状思维):生成多条思路分支,评估/筛选出更优路径,提升复杂问题的解题质量。

2. Agent 设计模式具体展开

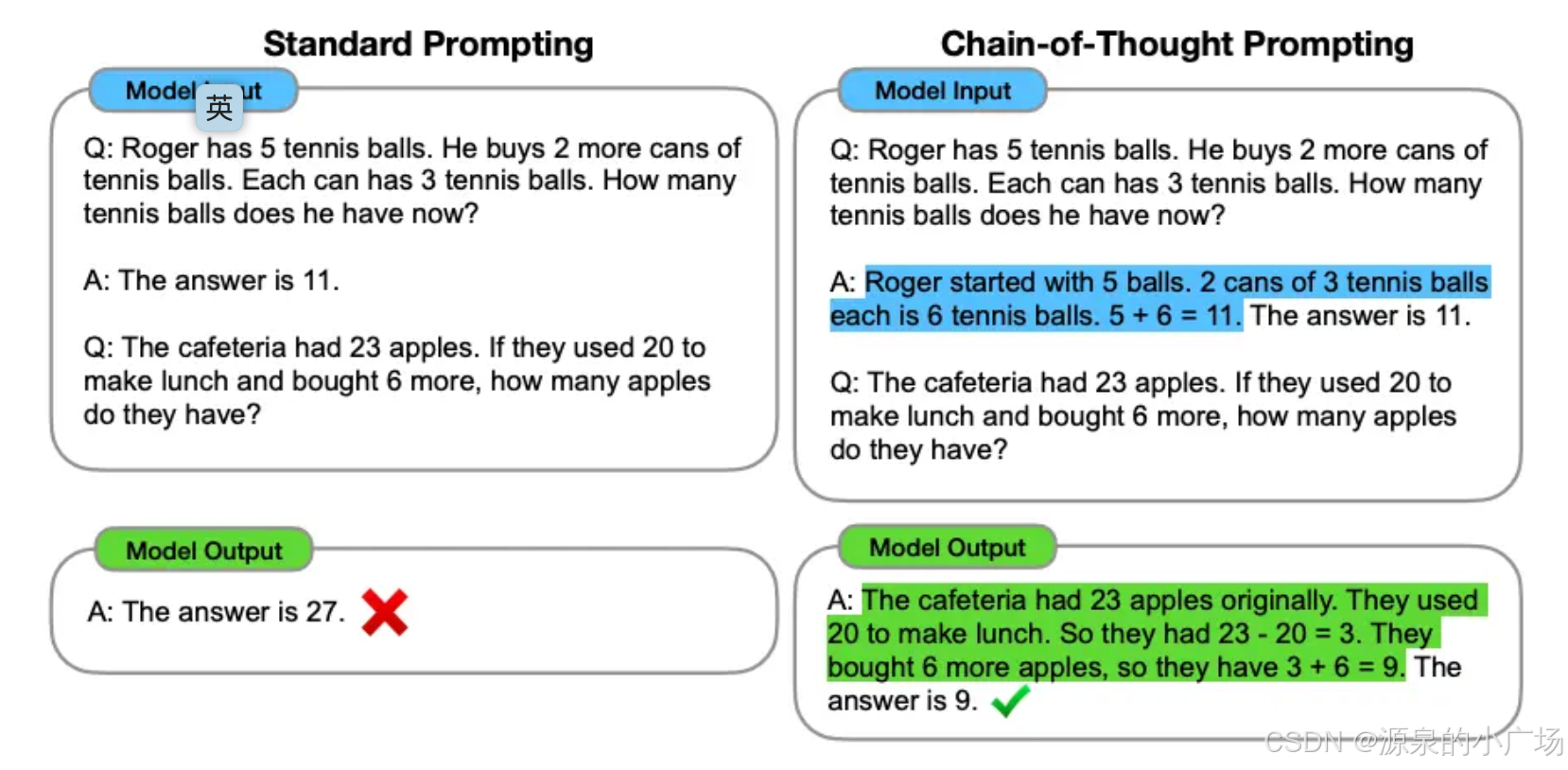

2.1 Chain of Thought(思维链)

提出背景:Google Research 2022 年论文 “Chain-of-Thought Prompting Elicits Reasoning in Large Language Models”。

核心思想:让模型显式“逐步写出步骤”,不是一句话给答案,而是把推理过程展开。

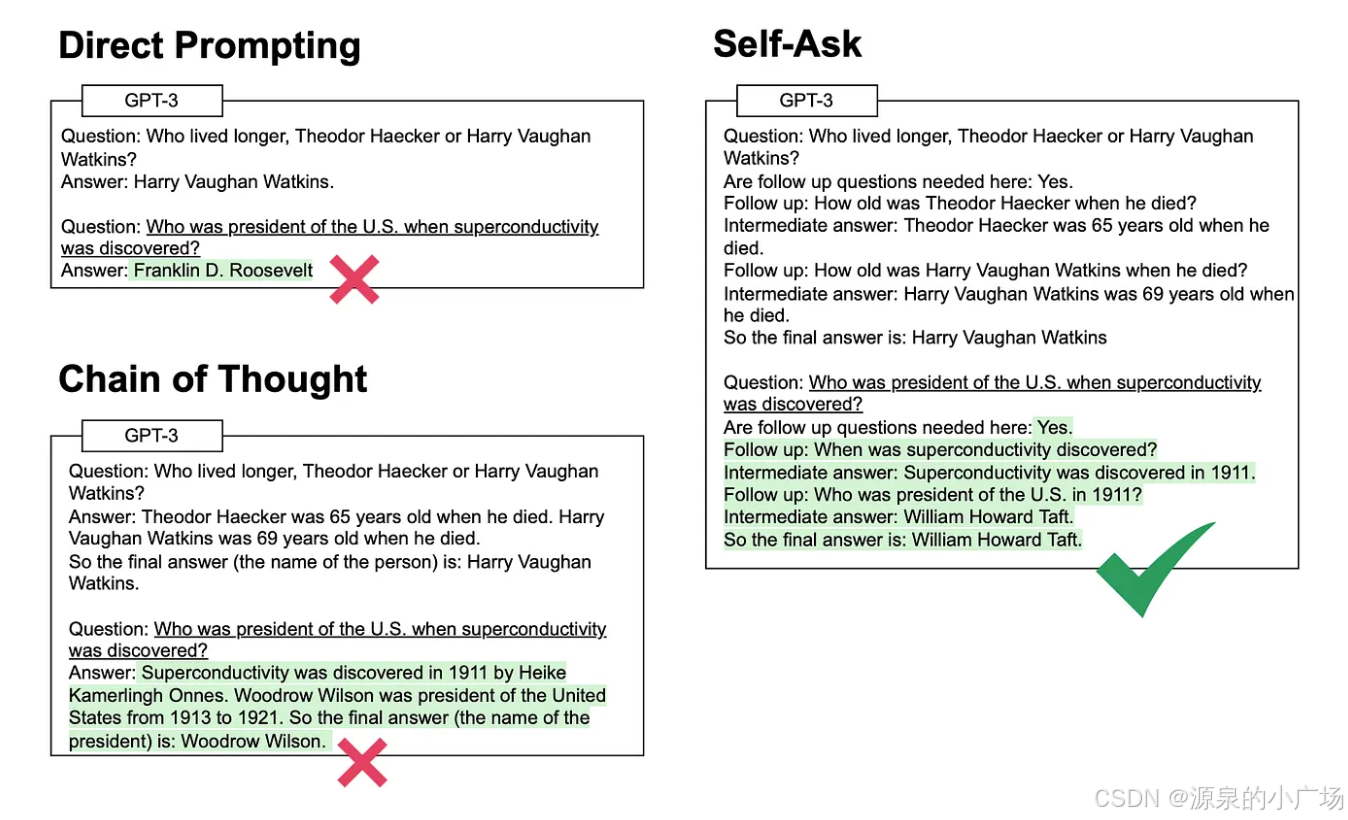

2.2 Self-Ask(自问自答)

提出背景:Microsoft Research 2022 年 “Self-Ask with Search”。

核心思想:模型在回答时“自问子问题”,把大问题拆分为小问题,再检索/回答。

场景示例:2016 年美国总统候选人排序题,模型自问并检索子问题再组合最终答案。

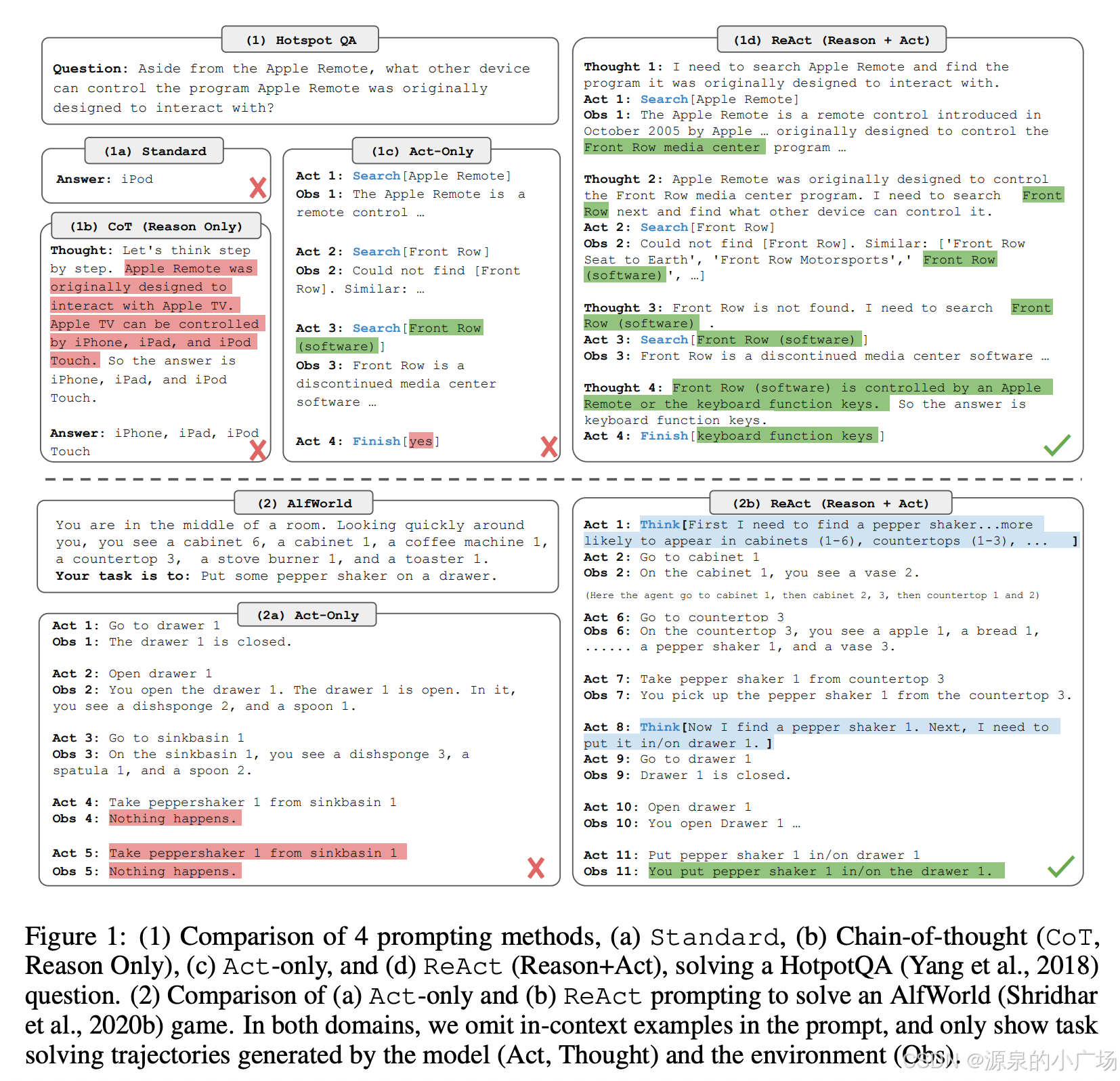

2.3 ReAct(推理+行动)

提出背景:Princeton 与 Google Research 2022 年论文 “ReAct: Synergizing Reasoning and Acting in Language Models”。

核心思想:在推理(Reasoning)和外部行动(Acting,如调用搜索或 API)之间交替;不仅推理也与外部世界交互。

场景示例:如问“杭州昨天的天气”,Agent 会先检索 API,再推理并回答;既有思维链又能动作。

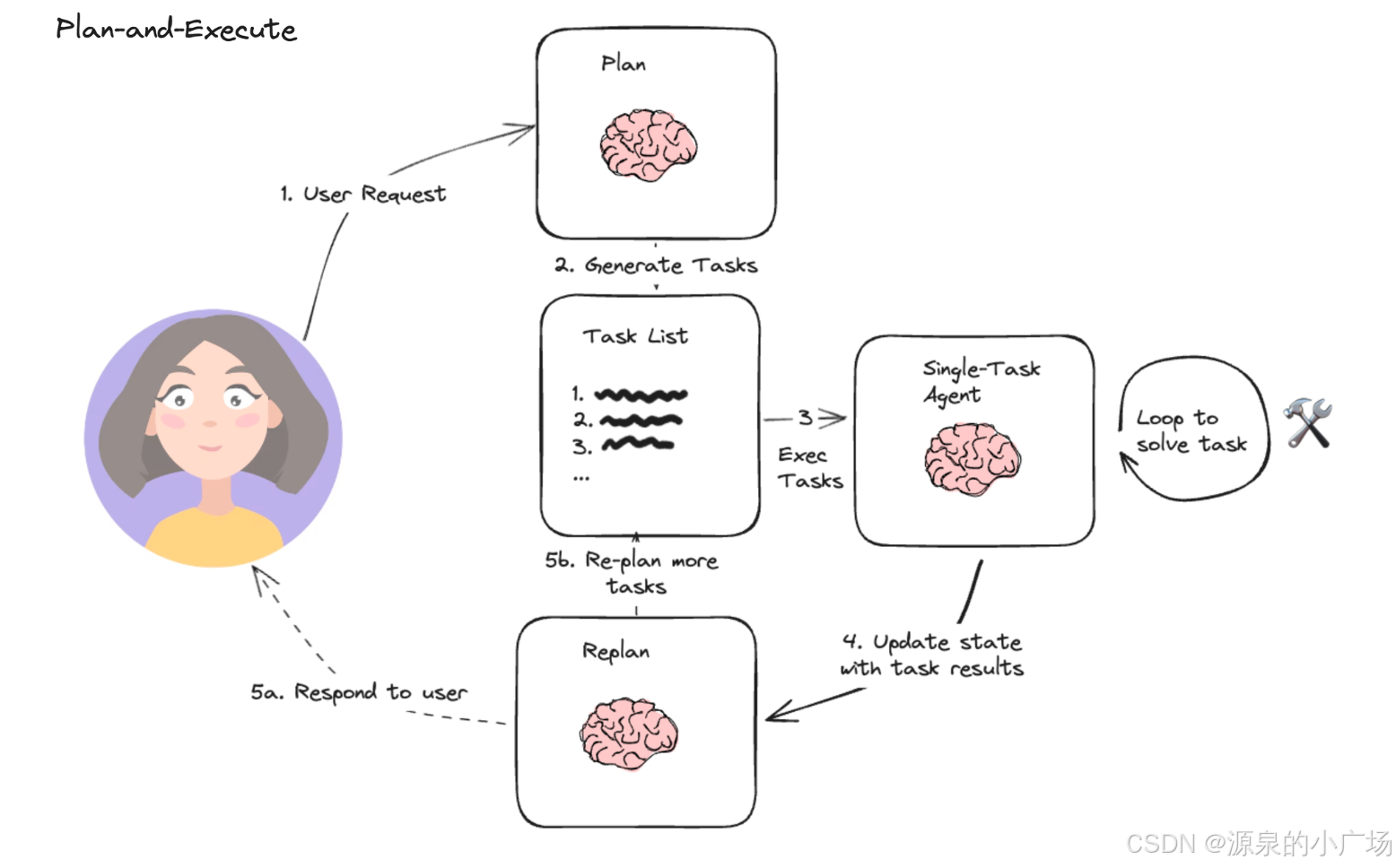

2.4 Plan-and-Execute(计划与执行)

提出背景:出现在 2023 年前后的 Agent 应用开发框架实践(如 LangChain 社区)。

核心思想:把任务拆成两个阶段:先生成计划(Planning),再逐步执行(Execution)。

场景示例:复杂任务先收集需求、分析解决路径、总结构建步骤,逐步执行并根据结果调整。

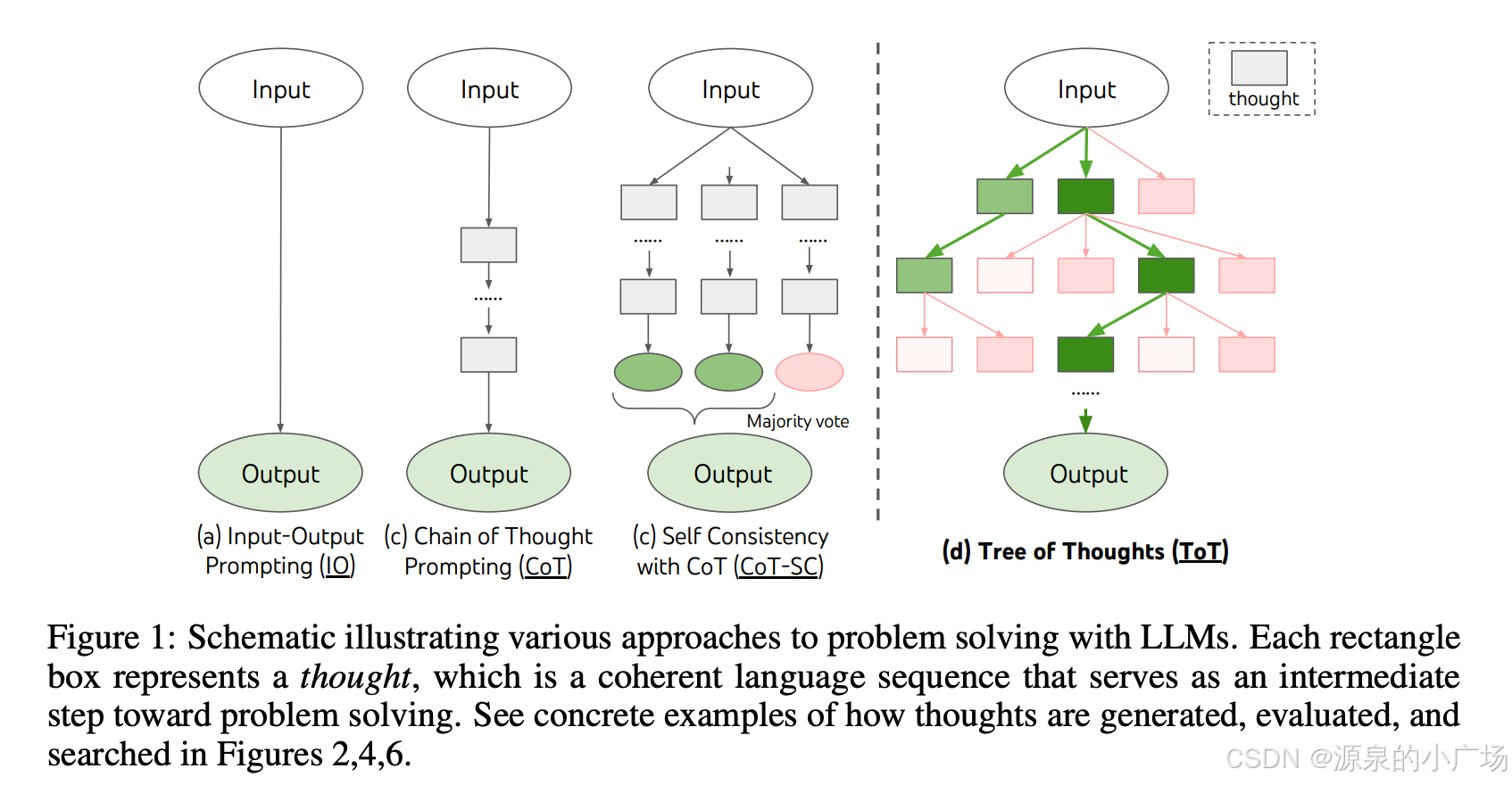

2.5 Tree of Thoughts(ToT,树状思维)

提出背景:Princeton 和 DeepMind 2023 年论文 “Tree of Thoughts: Deliberate Problem Solving with Large Language Models”。

核心思想:不是单线思维链,而是生成多条思路分支,像树一样展开,再通过评估机制选出更佳方案。

场景示例:复杂推理时生成多个候选路径(分支 A、B、C),逐步排除低分支,保留高分支以得到更优解。

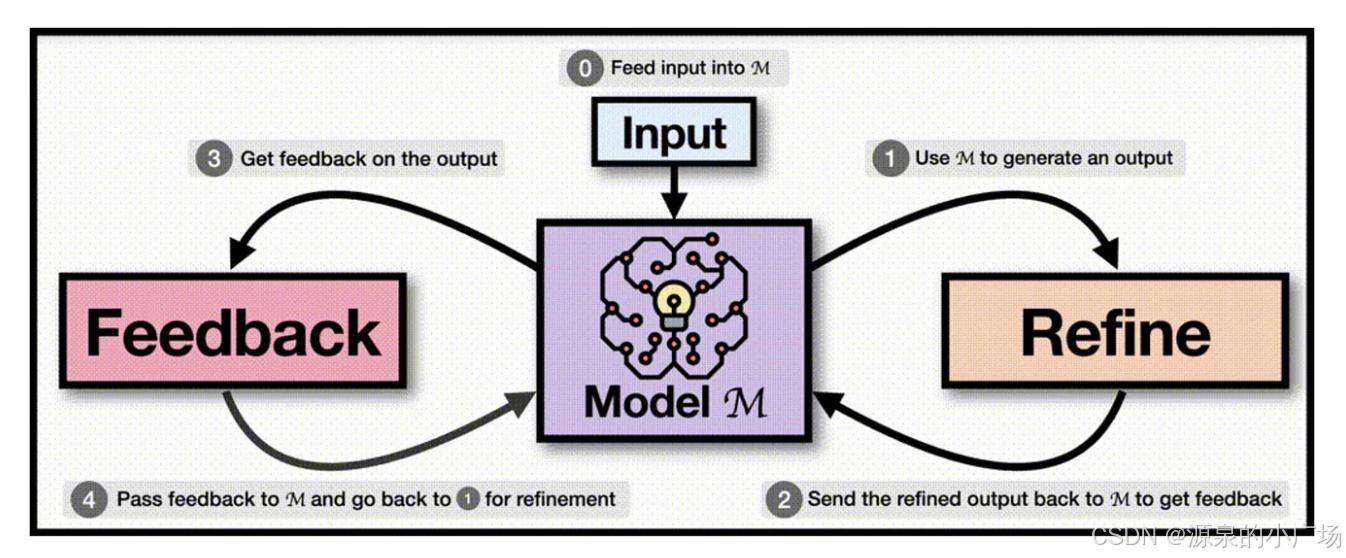

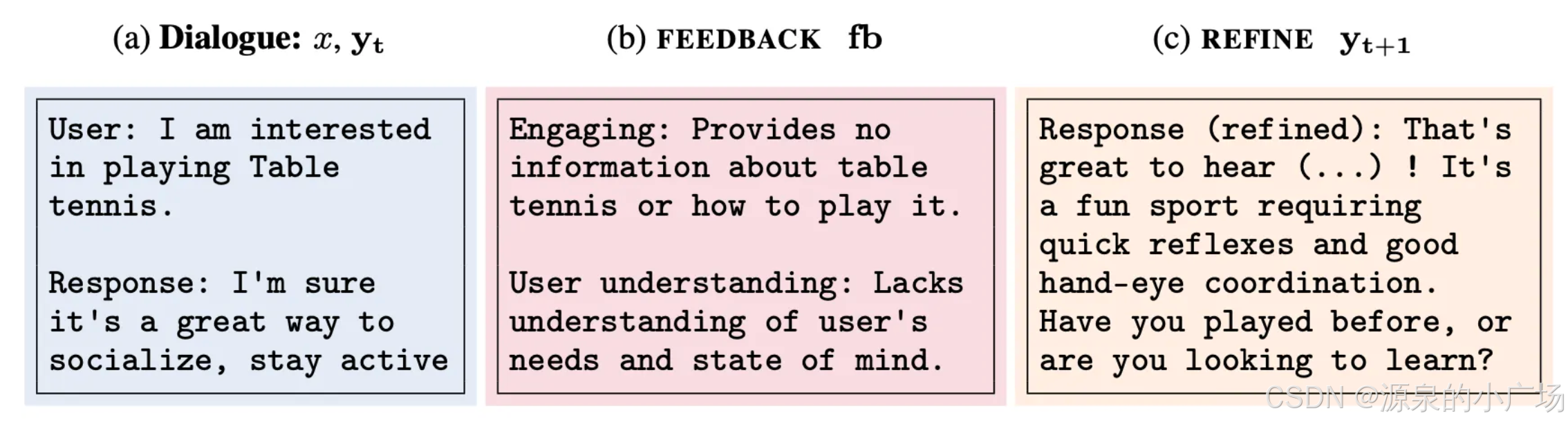

2.6 Reflexion / Iterative Refinement(反思与迭代优化)

提出背景:2023 论文 “Reflexion: Language Agents with Verbal Reinforcement Learning”。

核心思想:Agent 具备自我纠错与反思能力;出错后总结原因,再带着反思重试,逐步优化。

场景示例:让 Agent 生成一段 Python 代码,首次运行报错后读取报错信息,反思如“参数写错”,自动修正并重试。适合代码生成、流程执行类任务。

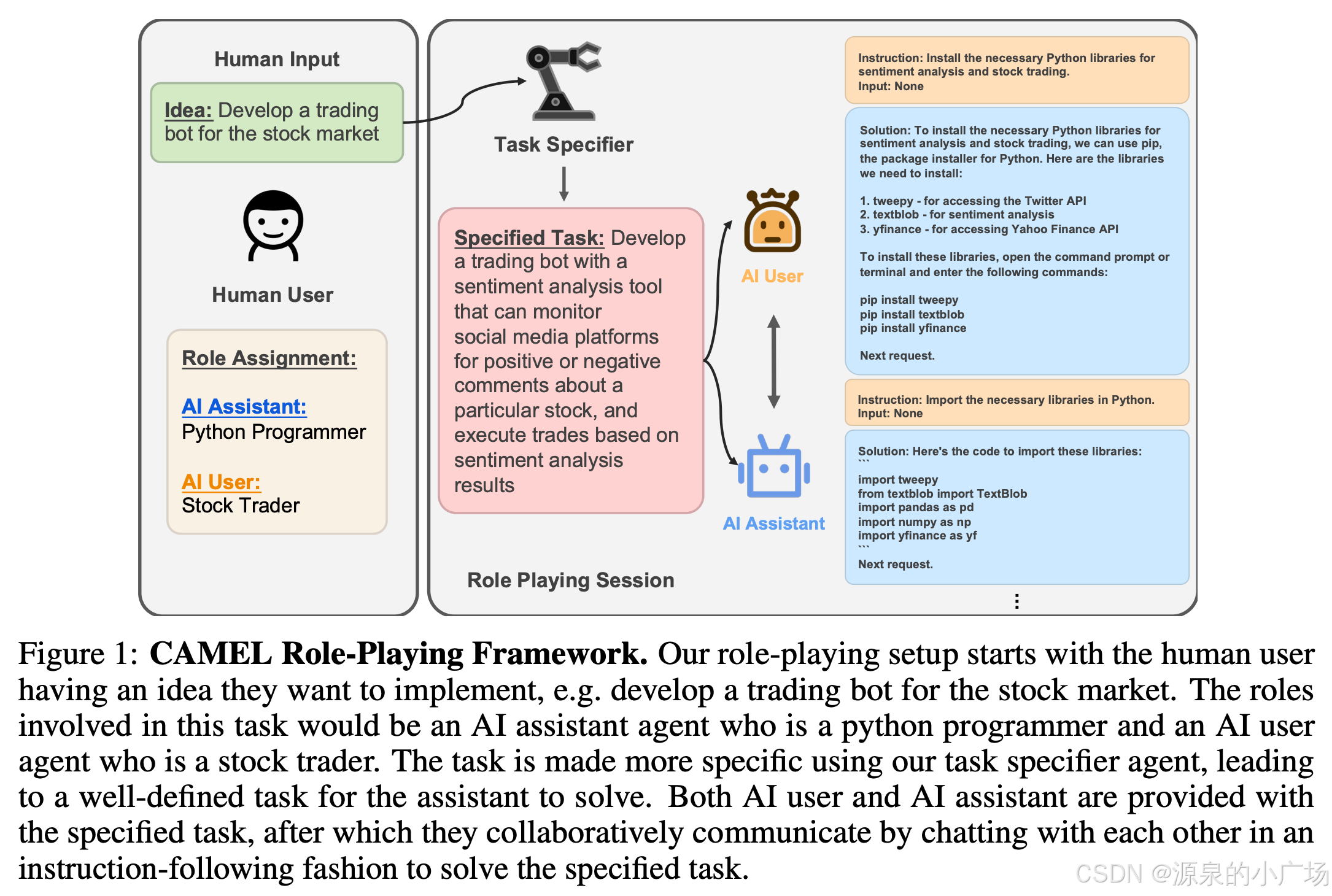

2.7 Role-playing Agents(角色扮演/多智能体协作)

提出背景:源自 AutoGPT、ChatDev、CAMEL 等社区项目。

核心思想:将任务拆给不同“角色”的 Agent,每个 Agent 负责特定职责,通过对话协作完成复杂任务。

场景示例:软件开发中由 产品经理 Agent 写需求、程序员 Agent 写代码、测试 Agent 写用例,像团队协作一样推进。适合复杂系统开发或跨职能协同。

综上所述:

主流 Agent 思维模式概览:

CoT(Chain of Thought):逐步推理,写出完整思考过程

Self-Ask:将复杂问题拆解为多个子问题,逐一求解

ReAct:结合推理与行动,在思考中与环境交互

Plan-Execute:先制定完整计划,再按步骤执行

ToT(Tree of Thoughts):以树状结构探索多条推理路径

Reflexion:通过自我反思进行迭代优化

Role-playing:模拟多角色协作,分工完成任务

总结:

上述思维模式并非互斥,实际应用中常可组合使用,灵活搭配。深入理解这些模式,有助于在 Agent 应用开发中选择合适的架构思路,推动技术落地。目前,部分模式(如 ReAct 等)已被 LangChain、LlamaIndex、Dify 等主流 Agent 框架所集成,成为其基础能力之一,有效提升了模型调用的准确性与可控性。

3. 参考

【1】Chain-of-Thought Prompting Elicits Reasoning in Large Language Models

【3】REACT: SYNERGIZING REASONING AND ACTING IN LANGUAGE MODELS

【4】https://blog.langchain.com/planning-agents/

【5】Tree of Thoughts: Deliberate Problem Solving with Large Language Models

【6】Self-Refine: Iterative Refinement with Self-Feedback

【7】CAMEL Role-Playing Autonomous Cooperative Agents

【8】CAMEL: Communicative Agents for "Mind" Exploration of Large Language Model Society

更多推荐

已为社区贡献3条内容

已为社区贡献3条内容

所有评论(0)