大模型剪枝系列——浅析蒸馏与剪枝

这两种技术的目标一致——让庞大、昂贵的大模型变得更小、更快、更便宜,从而能够实际部署到手机、汽车乃至物联网设备等各种场景中。,是大模型从“云端”走向“大众”的左膀右臂。蒸馏传递的是“智慧的灵魂”,而剪枝剔除的是“冗余的肉体”。先通过剪枝移除大量参数,再通过蒸馏让模型在更小的尺寸下恢复智能,最后通过量化将权重用更低的精度表示,从而实现极致的压缩。这个过程不仅仅是让学生模型学习教师模型的最终答案,更关

众所周知,大模型领域至少有两个“瘦身”技术:蒸馏 (Distillation) 和 剪枝 (Pruning)。

这两种技术的目标一致——让庞大、昂贵的大模型变得更小、更快、更便宜,从而能够实际部署到手机、汽车乃至物联网设备等各种场景中。但它们实现这一目标的哲学思想和技术路径截然不同。蒸馏如同“传授武功”,而剪枝则像是“精简招式”。

1. 定义

蒸馏 (Knowledge Distillation)

蒸馏是一种模型压缩技术,其核心思想是将一个大型、复杂、能力强大的“教师模型”(Teacher Model)所学到的“知识”,迁移到一个更小、更轻量级的“学生模型”(Student Model)中。这个过程不仅仅是让学生模型学习教师模型的最终答案,更关键的是学习教师模型“思考的过程”。

- 知识的形态:

- 软标签 (Soft Labels): 教师模型对一个输入所输出的完整概率分布(Logits)。这比最终的“硬标签”(即概率最高的那个答案)包含了更丰富的信息,例如,教师模型认为一张“猫”的图片有90%像猫,但也有5%像“老虎”,3%像“狗”,这种类别间的相似性信息就是宝贵的“暗知识”。

- 中间表示 (Intermediate Representations): 教师模型内部隐藏层的激活值,这代表了模型在不同层次上对信息的抽象和理解。

剪枝 (Network Pruning)

剪枝是一种模型压缩技术,其核心思想是识别并移除单个大模型中“不重要”或“冗余”的参数(权重)或结构单元(如神经元、注意力头),以在尽可能不损伤模型性能的前提下,减小模型尺寸和计算量。

- 操作对象: 剪枝直接作用于一个已经训练好(或正在训练)的单一模型。它不对模型进行替换,而是在其现有基础上进行“删减”。

- 冗余的形态:

- 权重冗余: 许多权重的值接近于零,对模型输出影响甚微。

- 结构冗余: 某些神经元、注意力头或整个网络层可能功能重叠,或对最终任务贡献不大。

2. 区别

为了让您更清晰地理解,我将从多个维度进行对比:

|

维度 |

蒸馏 (Distillation) |

剪枝 (Pruning) |

类比 |

|

操作对象 |

两个模型:一个教师,一个学生 |

单个模型 |

师徒传功 vs. 个人瘦身 |

|

输出结果 |

一个全新的、架构不同的学生模型 |

原模型的稀疏化或精简版 |

产生一个新的人 vs. 留下一个更精干的自己 |

|

核心动作 |

知识迁移 (通过对齐概率分布或中间表示) |

参数移除 (通过重要性评估) |

学习模仿 vs. 切除赘肉 |

|

适用阶段 |

通常在训练阶段(需要重新训练学生模型) |

可在训练后进行,然后通常需要微调恢复精度 |

从零开始培养 vs. 训练有成后再去精炼 |

|

优势场景 |

迁移复杂模型的泛化能力,适用于异构架构 |

直接减少计算量(FLOPs),尤其结构化剪枝利于硬件加速 |

学习大师的思维方式 vs. 让身体动作更快 |

|

常用工具 |

KL散度损失、Softmax温度系数、MSE损失 |

权重幅值、梯度信息、L1/L2正则化 |

模仿的评分标准 vs. 判断哪块肉该割的衡量标准 |

注: 蒸馏和剪枝经常联合使用。一个常见的强大流程是:先对一个大模型进行剪枝,得到一个更高效的版本,然后将这个剪枝后的模型作为教师,去蒸馏一个架构更小的学生模型。

3. 技术要素与技术路径

蒸馏的技术路径

- 选择教师模型: 通常是一个预训练好的、性能强大的大模型(如 Llama 3 70B, GPT-4)。

- 设计学生模型:

- 架构更小: 层数更少(如BERT的12层 vs DistilBERT的6层)、隐藏层维度更窄。

- 异构设计: 学生甚至可以采用与教师完全不同的架构(如用RNN学生学习Transformer教师)。

- 定义蒸馏损失函数 (Loss Function): 这是蒸馏的灵魂。

- 软目标损失 (核心): 使用KL散度 (Kullback-Leibler Divergence) 来衡量学生模型和教师模型的输出概率分布(经过Softmax温度T平滑后)的差异。较高的温度T可以“软化”概率分布,让类别间的暗知识更突出。

- 硬目标损失: 学生模型的输出与真实标签之间的交叉熵损失(Cross-Entropy Loss),这确保学生不会偏离真实任务。

- 中间层对齐损失: 强迫学生的某些中间层激活值去逼近教师的对应层(如使用MSE损失),让学生模仿教师的“思考过程”。

- 训练学生模型: 将上述几种损失函数加权求和,共同指导学生模型的训练。这个过程需要大量的无标签数据(用于学习教师的软标签)和少量有标签数据(用于学习硬标签)。

剪枝的技术路径

这是一个迭代的过程,如同“精雕细琢”。

- 重要性评估 (Importance Scoring): 如何判断哪些参数“不重要”?

- 非结构化剪枝:

- 权重幅值 (Magnitude Pruning): 最简单、最常用。认为绝对值越小的权重越不重要。

- 结构化剪枝:

- L1正则化: 在训练时加入L1正则化,可以天然地驱使某些权重或整个通道/头的权重变为零。

- 梯度信息: 分析移除某个结构(如注意力头)对损失函数梯度的影响。

- 非结构化剪枝:

- 执行剪枝 (Pruning):

- 根据重要性分数,设定一个阈值或比例(如剪掉30%的权重),将低于该分数的参数或结构**“置零”或直接移除**。

- 全局剪枝(在整个模型中统一排序)通常优于逐层剪枝。

- 微调 (Fine-tuning):

- 剪枝会不可避免地损伤模型精度。因此,需要在剪枝后的稀疏模型上,继续使用原始训练数据进行短时间的微调,以恢复损失的性能。

- 迭代剪枝 (Iterative Pruning - 推荐):

- 这是一个“剪一点 -> 微调一下 -> 再剪一点 -> 再微调一下”的循环过程。例如,每次剪掉5%的权重,然后微调,重复多次。这种渐进式的方法可以达到很高的压缩率,同时最大限度地保留模型精度。这被证明是极其有效的方法,如著名的**“彩票假设”(Lottery Ticket Hypothesis)**研究所揭示。

4. 应用场景

蒸馏

- 移动端与边缘设备部署: 将庞大的云端模型蒸馏成能跑在手机、汽车上的轻量级模型。例如,DistilBERT就是BERT的蒸馏版,尺寸小了40%,速度快了60%,但保留了97%的性能。

- 模型服务降本增效: 在API服务中,用一个高质量的蒸馏小模型替代昂贵的大模型,可以大幅降低推理延迟和服务器成本。

- 跨模态知识迁移: 用一个强大的图文多模态模型作为教师,去教一个纯文本模型理解与图像相关的概念。

剪枝

- 硬件加速: 结构化剪枝(如移除整个注意力头或FFN列)可以完美适配现代GPU/CPU的并行计算,直接带来推理速度的提升。

- 专用芯片(NPU/ASIC)部署: 非结构化剪枝产生的稀疏权重矩阵,可以在支持稀疏计算的专用硬件(如华为昇腾、NVIDIA Ampere架构的稀疏张量核心)上实现巨大的能效和性能提升。

- 联邦学习: 在边缘设备上训练模型时,可以发送剪枝后的稀疏更新梯度,从而大幅减少与中心服务器的通信开销。

5. 技术挑战

蒸馏的挑战

- 容量差距瓶颈 (Capacity Gap): 如果学生模型和教师模型的尺寸差距过大,学生可能无法有效学习教师的全部知识,导致性能显著下降。

- 教师偏见传递: 教师模型中存在的社会偏见(如性别、种族歧视)可能会在蒸馏过程中被“遗传”甚至放大给学生模型。

- 多任务/多模态泛化难: 教师模型强大的多任务和跨模态能力,很难通过简单的蒸馏完全传递给一个小的学生模型。

剪枝的挑战

- 精度悬崖: 在高压缩率下(如剪掉90%以上的权重),模型性能很容易突然“崩塌”,难以恢复。

- 非结构化剪枝的部署难题: 产生的稀疏矩阵在通用CPU/GPU上可能因为不规则的内存访问而无法实现有效加速,需要专门的稀疏计算库或硬件支持。

- 自动化与调参成本: 最佳的剪枝比例、调度策略和微调方案往往需要大量的人工实验和调整,成本高昂。

6. 未来趋势与最新研究

蒸馏前沿方向

- 自蒸馏 (Self-Distillation): 无需外部教师,模型在训练过程中让深层网络去教浅层网络,或用过去的自己教现在的自己。

- 多教师蒸馏 (Multi-Teacher Distillation): 融合多个不同教师的知识,让学生“取众家之长”。

- 提示级蒸馏 (Prompt-based Distillation): 不仅对齐概率,还对齐模型对自然语言提示(Prompt)的理解和响应逻辑。

剪枝前沿方向

- 动态稀疏训练: 在训练过程中自动学习和调整稀疏模式,而不是在训练后进行。代表性工作如 RigL (Rigged Lottery)。

- 训练前剪枝 (Pruning at Initialization): 在训练开始之前,根据特定的度量(如梯度流)就识别出最终会变得重要的子网络,只训练这个子网络。**“彩票假设”**是这一领域的奠基性工作。

- 神经架构搜索 (NAS) + 剪枝: 自动化地搜索最优的稀疏子结构,而不是依赖人工规则。

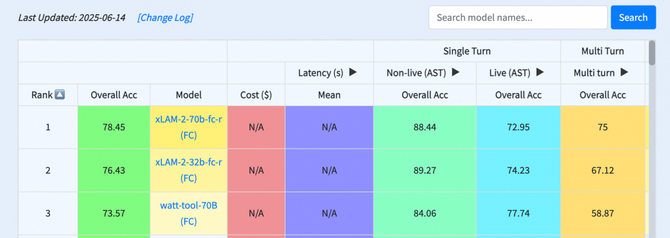

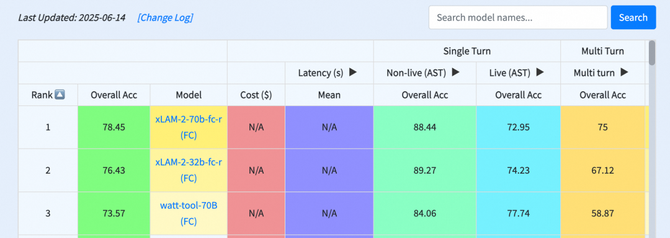

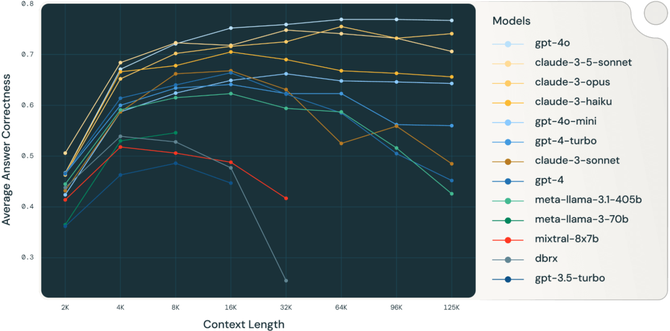

最新研究进展:

猫哥说

蒸馏和剪枝,是大模型从“云端”走向“大众”的左膀右臂。蒸馏传递的是“智慧的灵魂”,而剪枝剔除的是“冗余的肉体”。它们很少被孤立使用,更多的是在一个复杂的优化流程中协同工作。

在实际工业应用中,最常见的“三驾马车”是剪枝 + 蒸馏 + 量化 (Quantization)。先通过剪枝移除大量参数,再通过蒸馏让模型在更小的尺寸下恢复智能,最后通过量化将权重用更低的精度表示,从而实现极致的压缩。

未来的趋势是让这些压缩过程变得更加自动化、动态化和硬件感知,最终目标是让在个人设备上运行媲美云端大模型的强大AI,成为现实。

更多推荐

已为社区贡献5条内容

已为社区贡献5条内容

所有评论(0)