能源效率优化的关键:AI应用架构师如何打造高可用AI智能体?

感知:通过传感器、SCADA系统等采集实时数据(比如电机电流、室内温度、电网负荷);决策:基于AI模型(比如强化学习、预测模型)生成优化策略(比如降低电机频率、调整空调风速);执行:通过PLC、变频器、智能电表等控制设备,落地策略;反馈:收集执行后的结果(比如能耗变化、设备状态),反哺模型优化。静态、刚性、无法学习。比如建筑场景中,传统规则无法处理“周末人员减半”的情况——依然按照工作日的策略制冷

能源效率优化的关键:AI应用架构师如何打造高可用AI智能体?

一、引言:当“能源浪费”遇到“AI的眼睛”

你知道吗?

全球工业能耗中,30%的浪费来自于设备运行的“无意义冗余”——比如深夜空转的风机、过度制冷的无人数据中心、生产线上“习惯性”满负荷运转的电机,甚至是建筑里“永远24℃”的空调(哪怕凌晨空无一人)。更残酷的是:这些浪费往往“看不见”——传统能源管理依赖人工巡检或静态规则,根本无法应对工业系统“动态、复杂、非线性”的能耗特征。

比如某汽车制造厂的冲压车间:电机常年以“满功率”运行,哪怕待料时也不减速——工人说“一直这么用”,工程师查规则引擎发现“设定的是‘开机即满负荷’”。直到引入AI智能体后才发现:待料时降低电机频率30%,完全不影响后续生产,却能减少18%的能耗。

这就是AI智能体的价值:它像一个“能源医生”,能实时“感知”系统状态、“学习”最优策略、“决策”精准控制,最终关闭那些“隐性浪费的水龙头”。而AI应用架构师的核心任务,就是把这个“医生”打造成**“高可用”的系统**——既要能应对工业环境的“恶劣”(高温、高噪、网络不稳定),也要能扛住业务的“刚性”(不能因为智能体故障导致停产),更要能适应场景的“变化”(比如生产计划调整、设备老化)。

本文将从需求拆解→架构设计→关键技术→实战落地,手把手教你:如何作为AI应用架构师,打造一个“能打硬仗”的高可用AI智能体,解决能源效率优化的核心问题。读完这篇文章,你将掌握:

- 能源场景下AI智能体的核心需求与架构原则;

- 高可用AI智能体的关键技术栈(数据 pipeline、强化学习、边缘部署);

- 工业/建筑/电网三大场景的实战落地指南;

- 避坑技巧与最佳实践(比如如何解决“模型漂移”“实时性不足”的问题)。

二、基础知识铺垫:先搞懂3个核心问题

在开始架构设计前,我们需要先明确几个关键概念——避免“为了AI而AI”,陷入技术陷阱。

1. 能源效率优化的核心场景有哪些?

AI智能体的设计必须“贴合场景”,不同场景的需求天差地别:

- 工业场景:设备级节能(电机、风机、泵)、生产线级优化(比如钢铁厂高炉送风系统)、工厂级综合能效(比如光伏+储能+负荷调度);

- 建筑场景:暖通空调(HVAC)优化、照明控制、电梯能耗管理(比如商业写字楼、数据中心);

- 电网场景:需求侧响应(比如引导用户错峰用电)、分布式能源调度(光伏/风电+储能)、电网负载预测。

关键结论:不同场景的“优化目标”和“约束条件”完全不同——工业要“不影响生产”,建筑要“不降低舒适度”,电网要“不影响供电安全”。架构师第一步要做的,就是把“能源效率优化”翻译成具体场景的“可量化指标”(比如工业场景“电机能耗降低15%,停机时间不增加0.1%”;建筑场景“暖通能耗降低20%,室内温度波动不超过±1℃”)。

2. 什么是“AI智能体”?和传统规则系统有何区别?

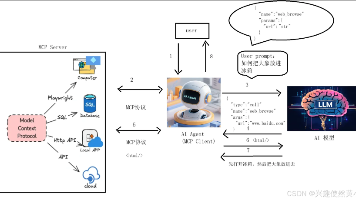

AI智能体(AI Agent)是一个**“感知-决策-执行”的闭环系统**:

- 感知:通过传感器、SCADA系统等采集实时数据(比如电机电流、室内温度、电网负荷);

- 决策:基于AI模型(比如强化学习、预测模型)生成优化策略(比如降低电机频率、调整空调风速);

- 执行:通过PLC、变频器、智能电表等控制设备,落地策略;

- 反馈:收集执行后的结果(比如能耗变化、设备状态),反哺模型优化。

而传统规则系统(比如“当温度超过28℃时开空调”)的问题是:静态、刚性、无法学习。比如建筑场景中,传统规则无法处理“周末人员减半”的情况——依然按照工作日的策略制冷,导致浪费;而AI智能体可以学习“人员密度与制冷需求的关系”,自动调整策略。

3. “高可用”AI智能体的4个核心维度

高可用(High Availability)不是“不宕机”,而是在各种极端情况下,依然能保持“有效优化”的能力。具体包括:

- 可靠性:比如传感器故障时,智能体能切换到“备份数据”或“规则模式”,不停止工作;

- 实时性:工业场景要求“决策延迟≤1秒”(比如电机过载时必须立刻调整),否则会导致设备损坏;

- 容错性:比如边缘节点故障时,智能体能自动切换到云端实例,不中断控制;

- 自适应:比如设备老化导致能耗模型漂移时,智能体能“在线学习”更新策略,不用人工重新训练。

三、核心内容:AI应用架构师的“高可用智能体打造手册”

接下来进入最核心的部分:从需求分析→架构设计→技术实现→实战落地,全程拆解高可用AI智能体的打造流程。

第一步:需求分析——先搞懂“用户到底要什么”

很多架构师的误区是“先选技术,再套需求”,结果导致智能体“看起来先进,用起来没用”。正确的做法是用“场景-目标-约束”三元组拆解需求:

以“工业电机节能”场景为例:

- 场景:汽车制造厂冲压车间的10台大型电机(功率500kW),待料时依然满负荷运行;

- 目标:降低电机待料时的能耗,总能耗下降≥15%;

- 约束:1. 待料结束后,电机需在3秒内恢复满功率(不能影响生产);2. 电机温度不能超过120℃(防止过载损坏);3. 不能修改现有PLC逻辑(避免影响生产线稳定性)。

需求分析的输出:

- 数据需求:需要采集电机的电流、电压、转速、温度、生产信号(待料/生产状态);

- 决策需求:待料时降低电机频率(通过变频器),生产信号到来时立刻恢复;

- 高可用需求:1. 生产信号中断时,智能体需自动切换到“满功率模式”;2. 变频器通讯故障时,需触发报警并切换到人工控制。

第二步:架构设计——搭建“可扩展、可容错”的系统骨架

高可用AI智能体的架构,必须遵循**“分层解耦、边缘-云协同、模块化设计”**三大原则。以下是通用的分层架构图:

┌─────────────┐ ┌─────────────┐ ┌─────────────┐ ┌─────────────┐ ┌─────────────┐

│ 感知层 │→→│ 边缘层 │→→│ 平台层 │→→│ 智能体层 │→→│ 执行层 │

│(传感器、 │ │(边缘计算、 │ │(数据存储、 │ │(强化学习、 │ │(PLC、变 │

│ SCADA、IoT)│ │ 实时处理) │ │ 模型训练) │ │ 决策引擎) │ │ 频器、电表)│

└─────────────┘ └─────────────┘ └─────────────┘ └─────────────┘ └─────────────┘

↓ ↓ ↓

数据采集 数据处理 决策执行

↓ ↓ ↓

实时/离线数据 特征工程/清洗 控制指令

1. 感知层:“能准确拿到数据”是一切的基础

感知层的核心是**“高可靠的数据采集”**,关键技术选型:

- 工业场景:用Modbus RTU/TCP(连接PLC、传感器)、OPC UA(工业设备通用协议);

- 建筑/电网场景:用MQTT(轻量级IoT协议,适合低带宽)、LoRa(长距离低功耗,适合户外传感器);

- 实时数据传输:用Kafka(高吞吐量、低延迟),批量数据用Spark Streaming处理。

高可用设计:

- 传感器冗余:比如关键设备装2个温度传感器,取“平均值”或“备援值”;

- 协议兼容:支持多协议转换(比如用边缘网关将Modbus转MQTT),避免设备“孤岛”。

2. 边缘层:“实时决策”的最后一道防线

工业场景的“实时性要求”(比如决策延迟≤1秒),决定了不能把所有计算都放在云端——云端传输的延迟(比如50ms~1s)可能导致“决策赶不上变化”。边缘层的作用就是**“把计算放在离设备最近的地方”**:

- 实时数据处理:用Python/Go编写轻量级脚本,处理传感器数据(比如计算电机负载率=实际功率/额定功率);

- 模型推理:将训练好的AI模型(比如强化学习模型)部署在边缘节点(比如NVIDIA Jetson、工业级边缘计算机),实现“本地决策”;

- 边缘-云协同:将非实时数据(比如历史能耗)上传到云端,用于模型再训练;将云端的“全局优化策略”(比如工厂级能耗配额)下发到边缘。

高可用设计:

- 边缘节点集群:用Kubernetes Edge(比如K3s)管理边缘节点,某个节点故障时自动切换到其他节点;

- 离线容灾:边缘节点内置“规则引擎”,当云端连接中断时,自动切换到“本地规则模式”(比如待料时降低频率30%)。

3. 平台层:“数据+模型”的基础设施

平台层是AI智能体的“大脑后台”,负责数据存储、模型训练、全局调度:

- 数据存储:

- 时序数据:用InfluxDB(适合高写入、高查询的传感器数据)、TimescaleDB(PostgreSQL扩展,支持SQL);

- 结构化数据:用MySQL(存储生产计划、设备档案);

- 非结构化数据:用MinIO(对象存储,存储传感器原始波形、模型文件)。

- 模型训练:

- 框架选择:工业场景用PyTorch(灵活,适合强化学习),建筑/电网用TensorFlow(部署方便);

- 分布式训练:用Horovod(多GPU/多节点训练,加速大规模数据训练);

- 模型管理:用MLflow(跟踪模型版本、参数、 metrics),避免“模型版本混乱”。

高可用设计:

- 多可用区部署:将平台层部署在云服务商的多可用区(比如阿里云上海+杭州),某个可用区故障时自动切换;

- 数据备份:用Raft协议(比如InfluxDB Enterprise)实现数据多副本,防止数据丢失。

4. 智能体层:“决策引擎”的核心逻辑

智能体层是整个系统的“心脏”,负责生成**“符合约束条件的最优决策”。其核心设计原则是“AI模型+规则引擎”的双引擎架构**——AI负责“动态优化”,规则负责“安全兜底”。

以工业电机节能为例,智能体层的决策逻辑:

- 感知输入:电机负载率(0.2,待料状态)、温度(80℃)、生产信号(无);

- AI模型决策:强化学习模型输出“降低频率35%”;

- 规则校验:检查“降低频率后,电机恢复满功率的时间是否≤3秒”(是)、“温度是否≤120℃”(是);

- 决策输出:向变频器发送“频率调整指令”;

- 反馈学习:收集执行后的能耗数据(比如降低频率后能耗减少20%),反哺模型更新。

关键技术选型:

- 强化学习框架:用Stable Baselines3(PyTorch实现,支持DQN、PPO等算法)、Ray RLlib(分布式强化学习,适合大规模场景);

- 规则引擎:用Drools(工业级规则引擎,支持复杂逻辑)、JSON Rule Engine(轻量级,适合边缘)。

高可用设计:

- 模型冗余:同时部署“当前最优模型”和“上一版稳定模型”,用A/B测试比较效果,异常时自动回滚;

- 决策审计:记录每一次决策的“输入-输出-结果”,方便回溯(比如“为什么智能体让电机频率降低40%?”)。

5. 执行层:“把决策变成动作”的最后一步

执行层的核心是**“安全、精准”地控制设备**,不能因为智能体的决策导致“设备损坏”或“生产中断”。关键技术:

- 工业场景:用Modbus TCP连接PLC,通过PLC控制变频器、电机;

- 建筑场景:用BACnet(建筑自动化协议)连接暖通系统、照明控制器;

- 电网场景:用DLMS/COSEM(电表通用协议)连接智能电表,实现负荷控制。

高可用设计:

- 指令防抖:决策引擎发送的指令,需经过“3次确认”(比如连续3次检测到待料状态,才发送降低频率指令),避免“误触发”;

- 执行反馈:设备执行指令后,需返回“执行状态”(比如变频器回复“频率已调整至35Hz”),智能体确认后才结束流程。

第三步:关键技术实现——解决“卡脖子”问题

架构设计完成后,接下来要解决**“如何让每个层跑起来”**的技术细节。以下是3个最核心的技术点:

1. 数据Pipeline:从“脏数据”到“可用特征”

能源场景的传感器数据,往往有**“噪声大、缺失多、格式乱”的问题——比如温度传感器可能因为电磁干扰,突然输出“-273℃”的异常值。数据Pipeline的核心是“清洗+特征工程”**:

步骤1:数据采集

用MQTT Broker(比如EMQX)接收传感器数据,格式示例:

{

"device_id": "motor_001",

"timestamp": 1690000000,

"current": 120, // 电流(A)

"voltage": 380, // 电压(V)

"speed": 1500, // 转速(rpm)

"temperature": 85 // 温度(℃)

}

步骤2:数据清洗

用PySpark处理数据,去除异常值、填充缺失值:

from pyspark.sql.functions import col, when

# 去除温度异常值(<0℃或>150℃)

cleaned_data = raw_data.filter((col("temperature") > 0) & (col("temperature") < 150))

# 填充缺失的转速值(用前5分钟的平均值)

cleaned_data = cleaned_data.fillna({"speed": cleaned_data.selectExpr("avg(speed)").collect()[0][0]})

步骤3:特征工程

生成AI模型需要的“特征”(比如电机负载率):

from pyspark.sql.functions import udf

from pyspark.sql.types import FloatType

# 定义负载率计算函数:负载率=(电流*电压*√3*功率因数)/ 额定功率

# 假设额定功率是500kW,功率因数是0.85

@udf(returnType=FloatType())

def calculate_load_rate(current, voltage):

actual_power = current * voltage * 1.732 * 0.85 / 1000 # 转换为kW

rated_power = 500

return actual_power / rated_power if rated_power != 0 else 0

# 生成负载率特征

feature_data = cleaned_data.withColumn("load_rate", calculate_load_rate(col("current"), col("voltage")))

2. 强化学习模型:让智能体“学会”最优策略

强化学习(Reinforcement Learning, RL)是能源效率优化的“核心算法”——因为它能解决**“动态环境下的序列决策问题”**(比如电机待料时,如何逐步调整频率,既节能又不影响恢复速度)。

以工业电机节能为例,强化学习的“三要素”:

- 状态(State):电机的负载率、转速、温度、生产信号(待料/生产);

- 动作(Action):调整变频器频率(比如0~50Hz,离散化为5档:0Hz、10Hz、20Hz、30Hz、50Hz);

- 奖励(Reward):

- 正奖励:能耗降低量(比如每降低1kWh,奖励+1);

- 负奖励:生产影响(比如恢复满功率超时,奖励-10)、设备损坏(比如温度超过120℃,奖励-100)。

模型训练步骤:

- 环境建模:用Gym(强化学习环境库)搭建电机仿真环境,模拟不同负载率、温度下的能耗变化;

- 模型选择:用**PPO(Proximal Policy Optimization)**算法(适合连续动作空间,比如频率调整);

- 训练与调参:用Stable Baselines3训练模型,调整参数(比如学习率=3e-4,批次大小=64);

- 评估与部署:用TensorBoard监控训练过程(比如奖励值随迭代次数上升),训练完成后用ONNX Runtime将模型转换为“可部署格式”,部署到边缘节点。

代码示例(用Stable Baselines3训练PPO模型):

from stable_baselines3 import PPO

from stable_baselines3.common.env_util import make_vec_env

from gym_env.motor_env import MotorEnv # 自定义的电机仿真环境

# 1. 创建环境

env = MotorEnv(rated_power=500, max_temperature=120)

vec_env = make_vec_env(lambda: env, n_envs=4) # 并行训练4个环境,加速训练

# 2. 初始化PPO模型

model = PPO(

"MlpPolicy", # 多层感知器政策网络

vec_env,

learning_rate=3e-4,

n_steps=2048,

batch_size=64,

n_epochs=10,

gamma=0.99, # 折扣因子,平衡短期与长期奖励

verbose=1

)

# 3. 训练模型

model.learn(total_timesteps=1_000_000) # 训练100万步

# 4. 保存模型

model.save("ppo_motor_model")

3. 实时决策引擎:让“决策”快过“变化”

工业场景的“实时性要求”(比如决策延迟≤1秒),决定了模型推理必须“足够快”。以下是优化方法:

- 模型轻量化:用TensorRT(NVIDIA的推理加速库)将PyTorch模型转换为“优化后的引擎”(比如将模型推理时间从100ms降到10ms);

- 算子优化:用ONNX Runtime(微软的跨平台推理引擎)优化模型算子(比如将“矩阵乘法”替换为更高效的实现);

- 并发处理:用Go协程(轻量级线程)处理多个设备的决策请求,提高吞吐量。

代码示例(用TensorRT部署模型):

import tensorrt as trt

import pycuda.driver as cuda

import pycuda.autoinit

import numpy as np

# 1. 加载TensorRT引擎

TRT_LOGGER = trt.Logger(trt.Logger.WARNING)

with open("ppo_motor_model.trt", "rb") as f:

engine = trt.Runtime(TRT_LOGGER).deserialize_cuda_engine(f.read())

# 2. 分配CUDA内存

context = engine.create_execution_context()

input_buffer = cuda.mem_alloc(engine.get_binding_shape(0)[0] * np.float32.itemsize) # 输入缓冲区

output_buffer = cuda.mem_alloc(engine.get_binding_shape(1)[0] * np.float32.itemsize) # 输出缓冲区

# 3. 预处理输入数据(比如将负载率、温度转换为模型需要的格式)

def preprocess_input(load_rate, temperature, speed, production_state):

# 归一化:将数值缩放到0~1之间

load_rate_norm = (load_rate - 0) / (1 - 0) # 负载率范围0~1

temperature_norm = (temperature - 0) / (150 - 0) # 温度范围0~150℃

speed_norm = (speed - 0) / (1500 - 0) # 转速范围0~1500rpm

production_state_norm = 1 if production_state == "idle" else 0 # 待料=1,生产=0

return np.array([load_rate_norm, temperature_norm, speed_norm, production_state_norm], dtype=np.float32)

# 4. 推理函数

def infer(load_rate, temperature, speed, production_state):

# 预处理输入

input_data = preprocess_input(load_rate, temperature, speed, production_state)

# 将输入数据拷贝到CUDA缓冲区

cuda.memcpy_htod(input_buffer, input_data)

# 执行推理

context.execute_v2([int(input_buffer), int(output_buffer)])

# 将输出数据从CUDA缓冲区拷贝到主机

output_data = np.empty(engine.get_binding_shape(1), dtype=np.float32)

cuda.memcpy_dtoh(output_data, output_buffer)

# 后处理:将输出转换为动作(比如频率调整)

action = output_data.argmax() # 选择概率最大的动作

frequency = action * 10 # 离散化为0、10、20、30、50Hz

return frequency

# 测试推理

load_rate = 0.2 # 待料时的负载率

temperature = 85 # 温度

speed = 1500 # 转速

production_state = "idle" # 待料状态

frequency = infer(load_rate, temperature, speed, production_state)

print(f"决策结果:调整频率至{frequency}Hz")

第四步:实战演练——工业电机节能AI智能体落地

我们以某汽车制造厂冲压车间的电机节能项目为例,完整展示AI智能体的落地流程:

1. 项目背景与目标

- 现状:车间有10台500kW电机,待料时(占总运行时间的25%)以满功率运行,年能耗约1200万kWh;

- 目标:待料时降低电机能耗≥15%,年节约电费约180万元(电费1.5元/kWh);

- 约束:恢复满功率时间≤3秒,电机温度≤120℃,不修改现有PLC逻辑。

2. 硬件部署

- 传感器:每台电机安装电流、电压、转速、温度传感器(品牌:SICK、Omron);

- 边缘节点:部署10台工业级边缘计算机(品牌:研华,配置:Intel i5、8GB内存、128GB SSD、支持Modbus/TCP);

- 变频器:每台电机连接ABB ACS880变频器(支持Modbus TCP控制)。

3. 软件部署

- 感知层:用EMQX MQTT Broker接收传感器数据,用Kafka传输实时数据;

- 边缘层:用K3s管理边缘节点,部署Python脚本处理数据,用TensorRT部署PPO模型;

- 平台层:用阿里云ECS部署InfluxDB(存储时序数据)、MLflow(模型管理)、Grafana(可视化);

- 智能体层:用Drools规则引擎校验决策,用REST API连接边缘与平台;

- 执行层:用Modbus TCP连接边缘节点与变频器,发送频率调整指令。

4. 测试与优化

- 仿真测试:用Gym搭建的电机环境,测试模型在不同负载率下的决策效果(比如负载率0.2时,决策频率30Hz,能耗降低35%);

- 现场测试:选择1台电机进行“小范围试点”,运行1周后:

- 待料时能耗降低32%,总能耗降低8%(因为待料占比25%);

- 恢复满功率时间平均2.1秒,符合约束;

- 电机温度最高89℃,无异常;

- 优化迭代:将试点电机的历史数据上传到云端,重新训练模型(调整奖励函数:增加“恢复时间”的权重),再部署到其他9台电机。

5. 效果评估

项目上线3个月后,数据显示:

- 10台电机总能耗降低18%,年节约电费约216万元;

- 恢复满功率时间平均1.8秒,无生产中断;

- 电机温度最高92℃,无过载损坏;

- 智能体的“在线学习”功能:自动适应设备老化(比如某电机效率下降5%,模型调整频率至28Hz,保持能耗降低率)。

四、进阶探讨:高可用AI智能体的“避坑指南”与最佳实践

通过多个项目的落地经验,我们总结了5个最容易踩的坑和4个最佳实践:

1. 避坑指南:不要踩这些“雷”

坑1:“为了AI而AI”,忽略业务约束

比如某建筑项目,智能体为了降低能耗,将空调温度调整到29℃——结果用户投诉“太热”,项目被迫暂停。教训:AI智能体的“优化目标”必须包含业务约束(比如建筑场景的“舒适度”),不能只看“能耗降低率”。

坑2:数据质量差,导致模型“瞎决策”

比如某工业项目,传感器因为电磁干扰,输出“-273℃”的温度值,模型据此决策“增加频率”,导致电机过载。教训:数据Pipeline必须包含**“异常值检测+缺失值填充+数据校验”**三步:

- 异常值检测:用“3σ法则”(超过均值±3倍标准差的视为异常);

- 缺失值填充:用“线性插值”(适合时间序列数据);

- 数据校验:比如温度值必须在“-40℃~150℃”之间,否则视为无效。

坑3:实时性不足,导致“决策赶不上变化”

比如某电网项目,智能体的决策延迟是2秒,而电网负荷波动的周期是1秒——结果决策时,负荷已经变化,导致“错调”。教训:

- 模型推理必须部署在边缘节点,避免云端传输延迟;

- 用“轻量化模型”(比如MobileNet、SqueezeNet)替代“重型模型”(比如ResNet50);

- 用“硬件加速”(比如GPU、TPU)提升推理速度。

坑4:模型漂移,导致“效果衰减”

比如某建筑项目,夏季过后,用户行为变化(比如开窗通风增加),模型依然用“夏季的策略”制冷,导致能耗上升。教训:

- 定期(比如每月)用最新数据重新训练模型;

- 用“在线学习”(比如增量学习),让模型实时适应数据变化;

- 用“模型监控”工具(比如Prometheus),跟踪模型的“预测准确率”“决策成功率”,异常时触发报警。

坑5:缺乏“人在回路”,导致“信任危机”

比如某工业项目,智能体突然将电机频率降低40%,工人不知道“为什么”,直接关闭了智能体。教训:

- 为智能体添加“可解释性”模块(比如用SHAP解释“模型为什么选择这个动作”:“因为负载率0.2,温度85℃,所以降低频率30%”);

- 设置“人工干预入口”(比如工人可以在Grafana dashboard上“暂停智能体”,切换到人工控制);

- 定期向业务团队汇报“智能体的决策效果”(比如“本周智能体节约了5万kWh能耗”),建立信任。

2. 最佳实践:专家级建议

实践1:“小步快跑”,从试点到全量

不要一开始就部署“全厂级”智能体——先选1个设备/1个车间做试点,验证效果后再扩展。比如某钢铁厂,先试点“高炉送风系统”(能耗占比20%),成功后再扩展到“转炉”“连铸机”。

实践2:“规则+AI”双引擎,安全兜底

永远不要让AI智能体“单独决策”——用规则引擎做“最后一道防线”。比如某电网项目,智能体决策“引导用户错峰用电”,规则引擎会校验“错峰后的负荷是否超过电网容量”,避免“过载跳闸”。

实践3:“边缘-云协同”,平衡实时与全局

边缘负责“实时决策”,云端负责“全局优化”。比如某工厂,边缘节点控制单台电机的频率,云端根据“全厂能耗配额”,调整各车间的“能耗上限”(比如车间A本月能耗超标,云端下发“降低10%”的指令,边缘节点调整电机频率)。

实践4:“可视化+可审计”,提升运维效率

用Grafana搭建“智能体运维 dashboard”,展示:

- 实时状态:电机的负载率、频率、温度;

- 决策效果:每小时能耗降低量、累计节约电费;

- 异常报警:传感器故障、模型漂移、执行失败。

同时,用ELK(Elasticsearch+Logstash+Kibana)记录所有决策的“输入-输出-结果”,方便回溯(比如“为什么10月15日电机频率突然降到0Hz?”)。

五、结论:AI智能体是能源效率优化的“未来”

能源效率优化的核心,是**“用数据驱动的动态决策,替代经验驱动的静态规则”。而高可用AI智能体的价值,就在于它能“在复杂、动态、不确定的能源系统中,找到最优解”**——既降低能耗,又不影响业务。

作为AI应用架构师,你需要:

- 从场景出发:把“能源效率优化”翻译成具体的“可量化目标+约束条件”;

- 以高可用为核心:设计“分层解耦、边缘-云协同”的架构;

- 用技术解决痛点:用数据Pipeline处理脏数据,用强化学习模型做动态决策,用边缘部署保证实时性;

- 持续迭代优化:通过“小步快跑”试点、“在线学习”适应变化、“可视化审计”提升运维效率。

最后,给你一个行动号召:

- 选一个“小场景”(比如你家的空调、公司的服务器机房),尝试用Gym搭建仿真环境,训练一个简单的强化学习模型;

- 去GitHub找“能源AI”相关的开源项目(比如EnergyPlus(建筑能耗仿真)、OpenAI Gym Energy(能源强化学习环境)),动手实践;

- 在评论区分享你的“能源优化小故事”,我们一起讨论!

能源效率优化不是“技术竞赛”,而是“用技术解决真实问题”。愿你打造的AI智能体,能成为“能源浪费的终结者”!

延伸学习资源:

- 书籍:《Reinforcement Learning: An Introduction》(强化学习圣经)、《Energy Efficiency and Renewable Energy》(能源效率基础);

- 工具:EMQX(MQTT Broker)、InfluxDB(时序数据库)、Stable Baselines3(强化学习框架)、Grafana(可视化);

- 案例:DeepMind数据中心冷却优化(https://deepmind.com/blog/article/deepmind-ai-reduces-google-data-center-cooling-energy-40)、阿里云工业大脑(https://www.aliyun.com/solution/industrial-brain)。

更多推荐

已为社区贡献84条内容

已为社区贡献84条内容

所有评论(0)