简介

该用户还未填写简介

擅长的技术栈

未填写擅长的技术栈

可提供的服务

暂无可提供的服务

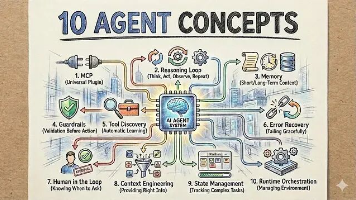

AI Agent技术栈:10个构建生产级Agent的核心概念

本文揭示Agentic AI稳定运行的核心不在大模型或提示词,而在于系统设计。文章精炼总结10个关键基础概念:MCP插件协议、推理循环、记忆机制、安全护栏、工具发现、错误恢复、人机协同、上下文工程、状态管理与运行时编排,直击Agent工程化落地痛点。

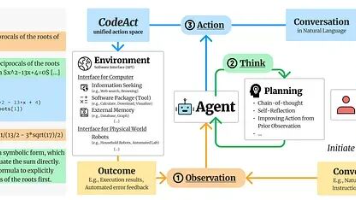

超越上下文窗口:CodeAct与RLM,两种代码驱动的LLM扩展方案

本文介绍CodeAct与RLM两大前沿范式:CodeAct让模型用可执行代码调用工具,缓解Context Rot,提升多工具任务成功率;RLM则通过递归分解超长上下文,将推理转化为编程式搜索。二者分别重构“动作空间”与“推理结构”,共同推动LLM从黑箱生成器迈向可编程智能体。

到底了