Apache Doris介绍

一、关于 Apache Doris 和 DorisDB、StarRocks 的关系Doris 最早是解决百度凤巢统计报表的专用系统,随着百度业务的飞速发展对系统进行了多次迭代,逐渐承担起百度内部业务的统计报表和多维分析需求。2013 年,我们把 Doris 进行了 MPP 框架的升级,并将新系统命名为 Palo ,2017 年我们以百度 Palo 的名字在 GitHub 上进行了开源,2018 年

一、关于 Apache Doris 和 DorisDB、StarRocks 的关系

Doris 最早是解决百度凤巢统计报表的专用系统,随着百度业务的飞速发展对系统进行了多次迭代,逐渐承担起百度内部业务的统计报表和多维分析需求。2013 年,我们把 Doris 进行了 MPP 框架的升级,并将新系统命名为 Palo ,2017 年我们以百度 Palo 的名字在 GitHub 上进行了开源,2018 年贡献给 Apache 基金会时,由于与国外数据库厂商重名,因此选择用回最初的名字,这就是 Apache Doris 的由来。

那么 StarRocks 以及 DorisDB 是什么?

2020 年 2 月,百度 Doris 团队的个别同学离职创业,基于 Apache Doris 之前的版本做了自己的商业化闭源产品 DorisDB ,这就是 StarRocks 的前身。

按照 Apache License,基于开源产品进行商业化是被允许的。

但是 DorisDB 团队在对外宣传时,会宣称自己“是 Apache Doris 的主创团队”、“ Apache Doris 的核心开发人员大部分在任职”等诸类话术。

实际上, GitHub 上公开的数据显示,Apache Doris 贡献代码前三的 Contributor 全部在百度 Doris 团队就职,不知所谓的“大部分”和“主创”从何说起。

实际上,从 2020 年初起, DorisDB 团队几乎没有向 Apache Doris 提交过一行代码。少部分开发者原本是 Apache Doris 的 Contributor ,在加入 DorisDB 团队后,同样不再向 Apache Doris 贡献一行代码。

比如 DorisDB 团队在人员扩张时,会故意定向挖 Apache Doris 企业用户的员工。开源社区的发展离不开用户的支持,挖用户墙角更无异于自掘坟墓。对于员工个人主动的选择我们不去评判,但这让企业用户对自己员工的培养做了嫁衣。而短视的人是不会看到这些的,更认为与他们毫无关系, Apache Doris 的死活与他们无关,只要自己能招到人就行。

比如 DorisDB 的商标问题,从品牌角度来说,开源项目与商业化产品的品牌必须存在区分度,比如 Linux 和 RedHat 、 Hadoop 与 Cloudera 、Apache Kylin 和 Kyligence 。

因为他们最初将产品命名为 DorisDB 就受到了 Apache 基金会的质疑,进而阻碍了 Apache Doris 的毕业进程,也给 Apache Doris 社区带来了困扰。最终在 Apache 基金会的施压和我们的抗议下,不得已作出了改名的行为。

总结下来他们三个的关系是

Apache Doris 不等于 DorisDB(更名后:StarRocks)

二、原理剖析

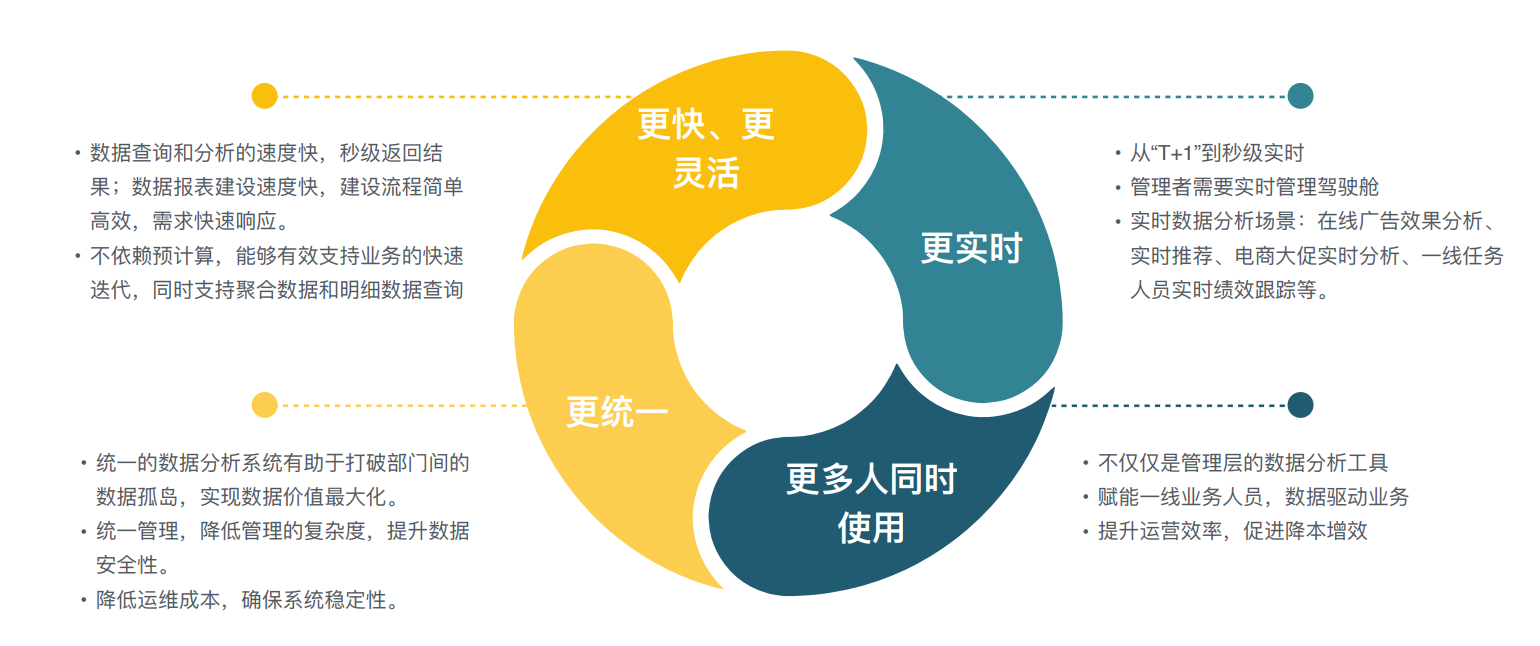

数据驱动的新趋势

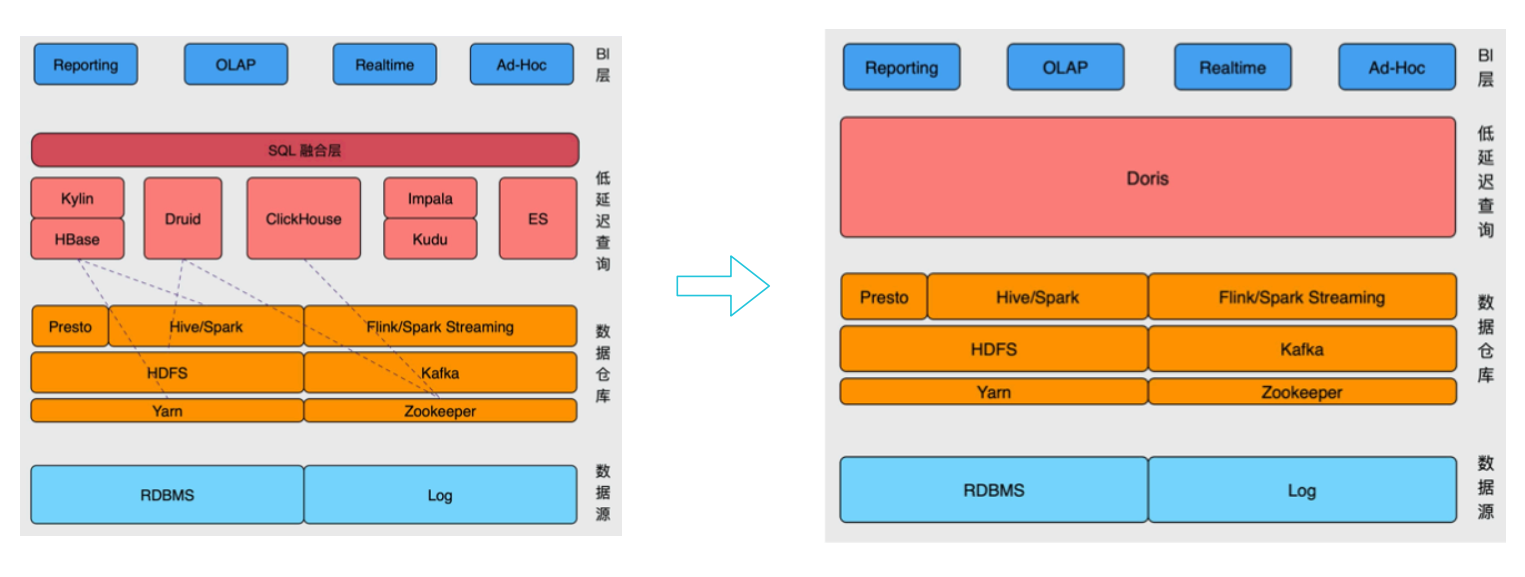

目前数据需求对速度和性能要求越来越高: 查询(亚秒级别返回),快速开发,

传统的方式进行预计算kylin、clickhouse, 星型模型--宽表模型--预聚合--(聚合度越高就会丧失一些灵活性,业务变更、维度变化就要重新刷新数据)

星型和雪花模型的多表关联, 高效的即席查询,预计算;

传统方式:

kylin+hbase做预处理

实时分析druid-聚合模型(对宽表支持度不高)

宽表选用clickhouse(对更新不友好)

Impala+kudu实现更新+多表关联

ES 全文检索、倒排索引;

现在只需一个Doris,解决不同系统之间的差异;

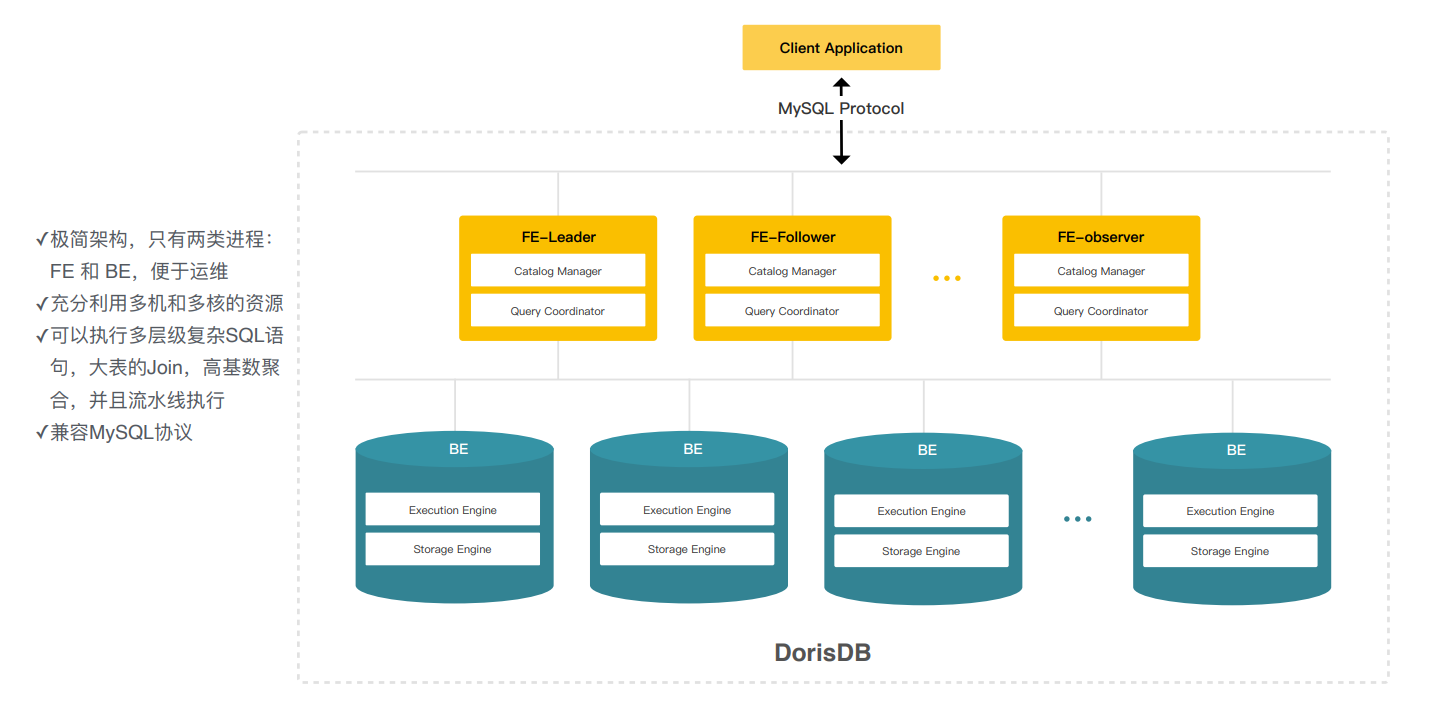

整体架构 - MPP架构

弹性MPP架构-极简架构

FE前端节点-主要负责元数据的管理、查询调度,解析sql的执行计划给BE,

BE-数据的存储和执行的引擎,这里存储和计算还是在一起的;

FE:leader 、follower(参与选举),水平扩容

对外提供了mysql兼容的协议;

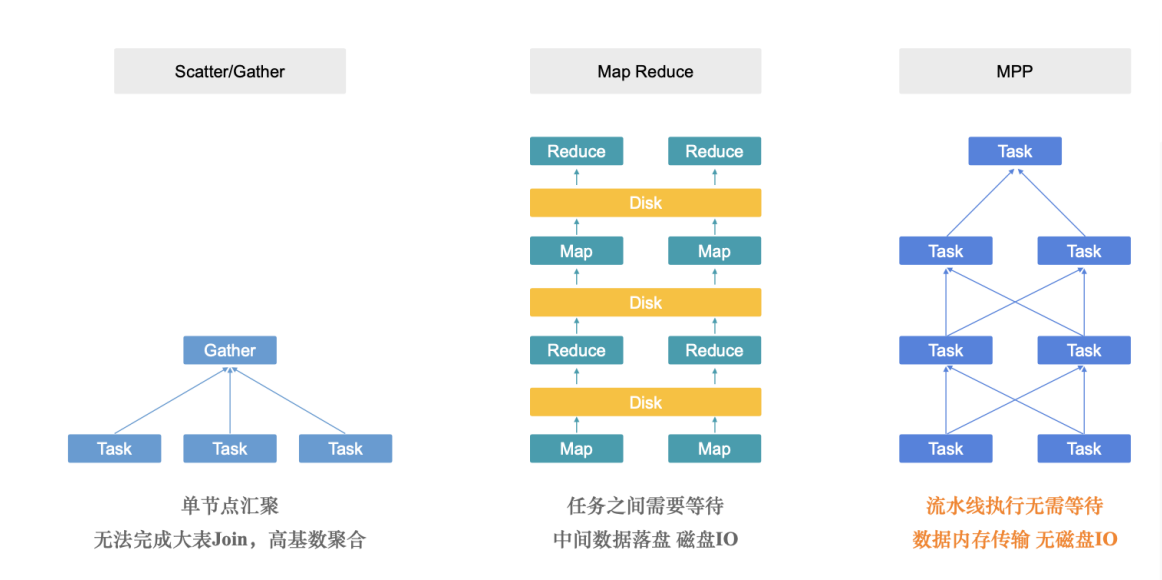

跟传统架构的区别:

通过分布式拆分成不同的task,再在中心节点汇聚;

druid、clickhouse都是类型;

MR是任务的拆分、落盘;

doris是MPP架构,任务之间分成task、全都在内存中执行和传输,所有任务都是流水线,没有磁盘IO,适用于低延迟亚秒级查询;

三、编译、安装与部署

直接编译(CentOS/Ubuntu)

你可以在自己的 linux 环境中直接尝试编译 Doris。

-

系统依赖 不同的版本依赖也不相同

-

在 ad67dd3 (opens new window)之前版本依赖如下:

GCC 7.3+, Oracle JDK 1.8+, Python 2.7+, Apache Maven 3.5+, CMake 3.11+ Bison 3.0+如果使用Ubuntu 16.04 及以上系统 可以执行以下命令来安装依赖

sudo apt-get install build-essential openjdk-8-jdk maven cmake byacc flex automake libtool-bin bison binutils-dev libiberty-dev zip unzip libncurses5-dev curl git ninja-build python autopoint pkg-config如果是CentOS 可以执行以下命令

sudo yum groupinstall 'Development Tools' && sudo yum install maven cmake byacc flex automake libtool bison binutils-devel zip unzip ncurses-devel curl git wget python2 glibc-static libstdc++-static java-1.8.0-openjdk -

在 ad67dd3 (opens new window)之后版本依赖如下:

GCC 10+, Oracle JDK 1.8+, Python 2.7+, Apache Maven 3.5+, CMake 3.19.2+ Bison 3.0+如果使用Ubuntu 16.04 及以上系统 可以执行以下命令来安装依赖

sudo apt install build-essential openjdk-8-jdk maven cmake byacc flex automake libtool-bin bison binutils-dev libiberty-dev zip unzip libncurses5-dev curl git ninja-build python sudo add-apt-repository ppa:ubuntu-toolchain-r/ppa sudo apt update sudo apt install gcc-10 g++-10 sudo apt-get install autoconf automake libtool autopoint如果是CentOS 可以执行以下命令

sudo yum groupinstall 'Development Tools' && sudo yum install maven cmake byacc flex automake libtool bison binutils-devel zip unzip ncurses-devel curl git wget python2 glibc-static libstdc++-static java-1.8.0-openjdk sudo yum install centos-release-scl sudo yum install devtoolset-10 scl enable devtoolset-10 bash如果当前仓库没有提供devtoolset-10 可以添加如下repo 使用oracle 提供 package

[ol7_software_collections] name=Software Collection packages for Oracle Linux 7 ($basearch) baseurl=http://yum.oracle.com/repo/OracleLinux/OL7/SoftwareCollections/$basearch/ gpgkey=file:///etc/pki/rpm-gpg/RPM-GPG-KEY-oracle gpgcheck=1 enabled=1

安装完成后,自行设置环境变量

PATH,JAVA_HOME等。 注意: Doris 0.14.0 的版本仍然使用gcc7 的依赖编译,之后的代码将使用gcc10 的依赖 -

-

编译 Doris

$ sh build.sh编译完成后,产出文件在

output/目录中。

安装与部署

Doris 作为一款开源的 MPP 架构 OLAP 数据库,能够运行在绝大多数主流的商用服务器上。为了能够充分运用 MPP 架构的并发优势,以及 Doris 的高可用特性,我们建议 Doris 的部署遵循以下需求:

Linux 操作系统版本需求

| Linux 系统 | 版本 |

|---|---|

| CentOS | 7.1 及以上 |

| Ubuntu | 16.04 及以上 |

软件需求

| 软件 | 版本 |

|---|---|

| Java | 1.8 及以上 |

| GCC | 4.8.2 及以上 |

开发测试环境

| 模块 | CPU | 内存 | 磁盘 | 网络 | 实例数量 |

|---|---|---|---|---|---|

| Frontend | 8核+ | 8GB+ | SSD 或 SATA,10GB+ * | 千兆网卡 | 1 |

| Backend | 8核+ | 16GB+ | SSD 或 SATA,50GB+ * | 千兆网卡 | 1-3 * |

生产环境

| 模块 | CPU | 内存 | 磁盘 | 网络 | 实例数量(最低要求) |

|---|---|---|---|---|---|

| Frontend | 16核+ | 64GB+ | SSD 或 RAID 卡,100GB+ * | 万兆网卡 | 1-5 * |

| Backend | 16核+ | 64GB+ | SSD 或 SATA,100G+ * | 万兆网卡 | 10-100 * |

注1:

- FE 的磁盘空间主要用于存储元数据,包括日志和 image。通常从几百 MB 到几个 GB 不等。

- BE 的磁盘空间主要用于存放用户数据,总磁盘空间按用户总数据量 * 3(3副本)计算,然后再预留额外 40% 的空间用作后台 compaction 以及一些中间数据的存放。

- 一台机器上可以部署多个 BE 实例,但是只能部署一个 FE。如果需要 3 副本数据,那么至少需要 3 台机器各部署一个 BE 实例(而不是1台机器部署3个BE实例)。多个FE所在服务器的时钟必须保持一致(允许最多5秒的时钟偏差)

- 测试环境也可以仅适用一个 BE 进行测试。实际生产环境,BE 实例数量直接决定了整体查询延迟。

- 所有部署节点关闭 Swap。

集群部署

手动部署

FE 部署

-

拷贝 FE 部署文件到指定节点

将源码编译生成的 output 下的 fe 文件夹拷贝到 FE 的节点指定部署路径下并进入该目录。

-

配置 FE

-

配置文件为 conf/fe.conf。其中注意:

meta_dir是元数据存放位置。默认值为${DORIS_HOME}/doris-meta。需手动创建该目录。注意:生产环境强烈建议单独指定目录不要放在Doris安装目录下,最好是单独的磁盘(如果有SSD最好),测试开发环境可以使用默认配置

-

fe.conf 中 JAVA_OPTS 默认 java 最大堆内存为 4GB,建议生产环境调整至 8G 以上。

-

-

启动FE

sh bin/start_fe.sh --daemonFE进程启动进入后台执行。日志默认存放在 log/ 目录下。如启动失败,可以通过查看 log/fe.log 或者 log/fe.out 查看错误信息。

-

如需部署多 FE,请参见 "FE 扩容和缩容" 章节

BE 部署

-

拷贝 BE 部署文件到所有要部署 BE 的节点

将源码编译生成的 output 下的 be 文件夹拷贝到 BE 的节点的指定部署路径下。

-

修改所有 BE 的配置

修改 be/conf/be.conf。主要是配置

storage_root_path:数据存放目录。默认在be/storage下,需要手动创建该目录。多个路径之间使用英文状态的分号;分隔(最后一个目录后不要加;)。可以通过路径区别存储目录的介质,HDD或SSD。可以添加容量限制在每个路径的末尾,通过英文状态逗号,隔开。示例1如下:

注意:如果是SSD磁盘要在目录后面加上

.SSD,HDD磁盘在目录后面加.HDDstorage_root_path=/home/disk1/doris.HDD,50;/home/disk2/doris.SSD,10;/home/disk2/doris说明

- /home/disk1/doris.HDD, 50,表示存储限制为50GB, HDD;

- /home/disk2/doris.SSD 10, 存储限制为10GB,SSD;

- /home/disk2/doris,存储限制为磁盘最大容量,默认为HDD

示例2如下:

注意:不论HHD磁盘目录还是SSD磁盘目录,都无需添加后缀,storage_root_path参数里指定medium即可

storage_root_path=/home/disk1/doris,medium:hdd,capacity:50;/home/disk2/doris,medium:ssd,capacity:50说明

- /home/disk1/doris,medium:hdd,capacity:10,表示存储限制为10GB, HHD;

- /home/disk2/doris,medium:ssd,capacity:50,表示存储限制为50GB, SSD;

-

BE webserver_port端口配置

如果 be 部署在 hadoop 集群中,注意调整 be.conf 中的

webserver_port = 8040,以免造成端口冲突 -

在 FE 中添加所有 BE 节点

BE 节点需要先在 FE 中添加,才可加入集群。可以使用 mysql-client(下载MySQL 5.7 (opens new window)) 连接到 FE:

./mysql-client -h host -P port -uroot其中 host 为 FE 所在节点 ip;port 为 fe/conf/fe.conf 中的 query_port;默认使用 root 账户,无密码登录。

登录后,执行以下命令来添加每一个 BE:

ALTER SYSTEM ADD BACKEND "host:port";其中 host 为 BE 所在节点 ip;port 为 be/conf/be.conf 中的 heartbeat_service_port。 -

启动 BE

sh bin/start_be.sh --daemonBE 进程将启动并进入后台执行。日志默认存放在 be/log/ 目录下。如启动失败,可以通过查看 be/log/be.log 或者 be/log/be.out 查看错误信息。

-

查看BE状态

使用 mysql-client 连接到 FE,并执行

SHOW PROC '/backends';查看 BE 运行情况。如一切正常,isAlive列应为true。

扩容缩容

Doris 可以很方便的扩容和缩容 FE、BE、Broker 实例。

#FE 扩容和缩容

可以通过将 FE 扩容至 3 个以上节点来实现 FE 的高可用。

用户可以通过 mysql 客户端登陆 Master FE。通过:

SHOW PROC '/frontends';

来查看当前 FE 的节点情况。

也可以通过前端页面连接:http://fe_hostname:fe_http_port/frontend 或者 http://fe_hostname:fe_http_port/system?path=//frontends 来查看 FE 节点的情况。

以上方式,都需要 Doris 的 root 用户权限。

FE 节点的扩容和缩容过程,不影响当前系统运行。

#增加 FE 节点

FE 分为 Leader,Follower 和 Observer 三种角色。 默认一个集群,只能有一个 Leader,可以有多个 Follower 和 Observer。其中 Leader 和 Follower 组成一个 Paxos 选择组,如果 Leader 宕机,则剩下的 Follower 会自动选出新的 Leader,保证写入高可用。Observer 同步 Leader 的数据,但是不参加选举。如果只部署一个 FE,则 FE 默认就是 Leader。

第一个启动的 FE 自动成为 Leader。在此基础上,可以添加若干 Follower 和 Observer。

添加 Follower 或 Observer。使用 mysql-client 连接到已启动的 FE,并执行:

ALTER SYSTEM ADD FOLLOWER "host:port";

或

ALTER SYSTEM ADD OBSERVER "host:port";

其中 host 为 Follower 或 Observer 所在节点 ip,port 为其配置文件 fe.conf 中的 edit_log_port。

配置及启动 Follower 或 Observer。Follower 和 Observer 的配置同 Leader 的配置。第一次启动时,需执行以下命令:

./bin/start_fe.sh --helper host:port --daemon

其中 host 为 Leader 所在节点 ip, port 为 Leader 的配置文件 fe.conf 中的 edit_log_port。--helper 参数仅在 follower 和 observer 第一次启动时才需要。

查看 Follower 或 Observer 运行状态。使用 mysql-client 连接到任一已启动的 FE,并执行:SHOW PROC '/frontends'; 可以查看当前已加入集群的 FE 及其对应角色。

FE 扩容注意事项:

- Follower FE(包括 Leader)的数量必须为奇数,建议最多部署 3 个组成高可用(HA)模式即可。

- 当 FE 处于高可用部署时(1个 Leader,2个 Follower),我们建议通过增加 Observer FE 来扩展 FE 的读服务能力。当然也可以继续增加 Follower FE,但几乎是不必要的。

- 通常一个 FE 节点可以应对 10-20 台 BE 节点。建议总的 FE 节点数量在 10 个以下。而通常 3 个即可满足绝大部分需求。

- helper 不能指向 FE 自身,必须指向一个或多个已存在并且正常运行中的 Master/Follower FE。

#删除 FE 节点

使用以下命令删除对应的 FE 节点:

ALTER SYSTEM DROP FOLLOWER[OBSERVER] "fe_host:edit_log_port";

FE 缩容注意事项:

- 删除 Follower FE 时,确保最终剩余的 Follower(包括 Leader)节点为奇数。

#BE 扩容和缩容

用户可以通过 mysql-client 登陆 Leader FE。通过:

SHOW PROC '/backends';

来查看当前 BE 的节点情况。

也可以通过前端页面连接:http://fe_hostname:fe_http_port/backend 或者 http://fe_hostname:fe_http_port/system?path=//backends 来查看 BE 节点的情况。

以上方式,都需要 Doris 的 root 用户权限。

BE 节点的扩容和缩容过程,不影响当前系统运行以及正在执行的任务,并且不会影响当前系统的性能。数据均衡会自动进行。根据集群现有数据量的大小,集群会在几个小时到1天不等的时间内,恢复到负载均衡的状态。集群负载情况,可以参见 Tablet 负载均衡文档。

#增加 BE 节点

BE 节点的增加方式同 BE 部署 一节中的方式,通过 ALTER SYSTEM ADD BACKEND 命令增加 BE 节点。

BE 扩容注意事项:

- BE 扩容后,Doris 会自动根据负载情况,进行数据均衡,期间不影响使用。

#删除 BE 节点

删除 BE 节点有两种方式:DROP 和 DECOMMISSION

DROP 语句如下:

ALTER SYSTEM DROP BACKEND "be_host:be_heartbeat_service_port";

注意:DROP BACKEND 会直接删除该 BE,并且其上的数据将不能再恢复!!!所以我们强烈不推荐使用 DROP BACKEND 这种方式删除 BE 节点。当你使用这个语句时,会有对应的防误操作提示。

DECOMMISSION 语句如下:

ALTER SYSTEM DECOMMISSION BACKEND "be_host:be_heartbeat_service_port";

DECOMMISSION 命令说明:

- 该命令用于安全删除 BE 节点。命令下发后,Doris 会尝试将该 BE 上的数据向其他 BE 节点迁移,当所有数据都迁移完成后,Doris 会自动删除该节点。

- 该命令是一个异步操作。执行后,可以通过

SHOW PROC '/backends';看到该 BE 节点的 isDecommission 状态为 true。表示该节点正在进行下线。- 该命令不一定执行成功。比如剩余 BE 存储空间不足以容纳下线 BE 上的数据,或者剩余机器数量不满足最小副本数时,该命令都无法完成,并且 BE 会一直处于 isDecommission 为 true 的状态。

- DECOMMISSION 的进度,可以通过

SHOW PROC '/backends';中的 TabletNum 查看,如果正在进行,TabletNum 将不断减少。- 该操作可以通过:

CANCEL DECOMMISSION BACKEND "be_host:be_heartbeat_service_port";

命令取消。取消后,该 BE 上的数据将维持当前剩余的数据量。后续 Doris 重新进行负载均衡

四、使用指南

基础使用指南

Doris 采用 MySQL 协议进行通信,用户可通过 MySQL client 或者 MySQL JDBC连接到 Doris 集群。选择 MySQL client 版本时建议采用5.1 之后的版本,因为 5.1 之前不能支持长度超过 16 个字符的用户名。本文以 MySQL client 为例,通过一个完整的流程向用户展示 Doris 的基本使用方法。

#1 创建用户

#1.1 Root 用户登录与密码修改

Doris 内置 root 和 admin 用户,密码默认都为空。启动完 Doris 程序之后,可以通过 root 或 admin 用户连接到 Doris 集群。 使用下面命令即可登录 Doris:

mysql -h FE_HOST -P9030 -uroot

fe_host是任一 FE 节点的 ip 地址。9030是 fe.conf 中的 query_port 配置。

登陆后,可以通过以下命令修改 root 密码

SET PASSWORD FOR 'root' = PASSWORD('your_password');

#1.3 创建新用户

通过下面的命令创建一个普通用户。

CREATE USER 'test' IDENTIFIED BY 'test_passwd';

后续登录时就可以通过下列连接命令登录。

mysql -h FE_HOST -P9030 -utest -ptest_passwd

新创建的普通用户默认没有任何权限。权限授予可以参考后面的权限授予。

#2 数据表的创建与数据导入

#2.1 创建数据库

初始可以通过 root 或 admin 用户创建数据库:

CREATE DATABASE example_db;

所有命令都可以使用 'HELP command;' 查看到详细的语法帮助。如:

HELP CREATE DATABASE;

如果不清楚命令的全名,可以使用 "help 命令某一字段" 进行模糊查询。如键入 'HELP CREATE',可以匹配到

CREATE DATABASE,CREATE TABLE,CREATE USER等命令。

数据库创建完成之后,可以通过 SHOW DATABASES; 查看数据库信息。

MySQL> SHOW DATABASES;

+--------------------+

| Database |

+--------------------+

| example_db |

| information_schema |

+--------------------+

2 rows in set (0.00 sec)

information_schema是为了兼容MySQL协议而存在,实际中信息可能不是很准确,所以关于具体数据库的信息建议通过直接查询相应数据库而获得。

#2.2 账户授权

example_db 创建完成之后,可以通过 root/admin 账户将 example_db 读写权限授权给普通账户,如 test。授权之后采用 test 账户登录就可以操作 example_db 数据库了。

GRANT ALL ON example_db TO test;

#2.3 建表

使用 CREATE TABLE 命令建立一个表(Table)。更多详细参数可以查看:

HELP CREATE TABLE;

首先切换数据库:

USE example_db;

Doris支持支持单分区和复合分区两种建表方式。

在复合分区中:

-

第一级称为 Partition,即分区。用户可以指定某一维度列作为分区列(当前只支持整型和时间类型的列),并指定每个分区的取值范围。

-

第二级称为 Distribution,即分桶。用户可以指定一个或多个维度列以及桶数对数据进行 HASH 分布。

以下场景推荐使用复合分区

- 有时间维度或类似带有有序值的维度,可以以这类维度列作为分区列。分区粒度可以根据导入频次、分区数据量等进行评估。

- 历史数据删除需求:如有删除历史数据的需求(比如仅保留最近N 天的数据)。使用复合分区,可以通过删除历史分区来达到目的。也可以通过在指定分区内发送 DELETE 语句进行数据删除。

- 解决数据倾斜问题:每个分区可以单独指定分桶数量。如按天分区,当每天的数据量差异很大时,可以通过指定分区的分桶数,合理划分不同分区的数据,分桶列建议选择区分度大的列。

用户也可以不使用复合分区,即使用单分区。则数据只做 HASH 分布。

下面以聚合模型为例,分别演示两种分区的建表语句。

#单分区

建立一个名字为 table1 的逻辑表。分桶列为 siteid,桶数为 10。

这个表的 schema 如下:

- siteid:类型是INT(4字节), 默认值为10

- citycode:类型是SMALLINT(2字节)

- username:类型是VARCHAR, 最大长度为32, 默认值为空字符串

- pv:类型是BIGINT(8字节), 默认值是0; 这是一个指标列, Doris内部会对指标列做聚合操作, 这个列的聚合方法是求和(SUM)

建表语句如下:

CREATE TABLE table1

(

siteid INT DEFAULT '10',

citycode SMALLINT,

username VARCHAR(32) DEFAULT '',

pv BIGINT SUM DEFAULT '0'

)

AGGREGATE KEY(siteid, citycode, username)

DISTRIBUTED BY HASH(siteid) BUCKETS 10

PROPERTIES("replication_num" = "1");

#复合分区

建立一个名字为 table2 的逻辑表。

这个表的 schema 如下:

- event_day:类型是DATE,无默认值

- siteid:类型是INT(4字节), 默认值为10

- citycode:类型是SMALLINT(2字节)

- username:类型是VARCHAR, 最大长度为32, 默认值为空字符串

- pv:类型是BIGINT(8字节), 默认值是0; 这是一个指标列, Doris 内部会对指标列做聚合操作, 这个列的聚合方法是求和(SUM)

我们使用 event_day 列作为分区列,建立3个分区: p201706, p201707, p201708

- p201706:范围为 [最小值, 2017-07-01)

- p201707:范围为 [2017-07-01, 2017-08-01)

- p201708:范围为 [2017-08-01, 2017-09-01)

注意区间为左闭右开。

每个分区使用 siteid 进行哈希分桶,桶数为10

建表语句如下:

CREATE TABLE table2

(

event_day DATE,

siteid INT DEFAULT '10',

citycode SMALLINT,

username VARCHAR(32) DEFAULT '',

pv BIGINT SUM DEFAULT '0'

)

AGGREGATE KEY(event_day, siteid, citycode, username)

PARTITION BY RANGE(event_day)

(

PARTITION p201706 VALUES LESS THAN ('2017-07-01'),

PARTITION p201707 VALUES LESS THAN ('2017-08-01'),

PARTITION p201708 VALUES LESS THAN ('2017-09-01')

)

DISTRIBUTED BY HASH(siteid) BUCKETS 10

PROPERTIES("replication_num" = "1");

表建完之后,可以查看 example_db 中表的信息:

MySQL> SHOW TABLES;

+----------------------+

| Tables_in_example_db |

+----------------------+

| table1 |

| table2 |

+----------------------+

2 rows in set (0.01 sec)

MySQL> DESC table1;

+----------+-------------+------+-------+---------+-------+

| Field | Type | Null | Key | Default | Extra |

+----------+-------------+------+-------+---------+-------+

| siteid | int(11) | Yes | true | 10 | |

| citycode | smallint(6) | Yes | true | N/A | |

| username | varchar(32) | Yes | true | | |

| pv | bigint(20) | Yes | false | 0 | SUM |

+----------+-------------+------+-------+---------+-------+

4 rows in set (0.00 sec)

MySQL> DESC table2;

+-----------+-------------+------+-------+---------+-------+

| Field | Type | Null | Key | Default | Extra |

+-----------+-------------+------+-------+---------+-------+

| event_day | date | Yes | true | N/A | |

| siteid | int(11) | Yes | true | 10 | |

| citycode | smallint(6) | Yes | true | N/A | |

| username | varchar(32) | Yes | true | | |

| pv | bigint(20) | Yes | false | 0 | SUM |

+-----------+-------------+------+-------+---------+-------+

5 rows in set (0.00 sec)

注意事项:

- 上述表通过设置 replication_num 建的都是单副本的表,Doris建议用户采用默认的 3 副本设置,以保证高可用。

- 可以对复合分区表动态的增删分区。详见

HELP ALTER TABLE中 Partition 相关部分。- 数据导入可以导入指定的 Partition。详见

HELP LOAD。- 可以动态修改表的 Schema。

- 可以对 Table 增加上卷表(Rollup)以提高查询性能,这部分可以参见高级使用指南关于 Rollup 的描述。

- 表的列的Null属性默认为true,会对查询性能有一定的影响。

#2.4 导入数据

Doris 支持多种数据导入方式。具体可以参阅数据导入文档。这里我们使用流式导入和 Broker 导入做示例。

#流式导入

流式导入通过 HTTP 协议向 Doris 传输数据,可以不依赖其他系统或组件直接导入本地数据。详细语法帮助可以参阅 HELP STREAM LOAD;。

示例1:以 "table1_20170707" 为 Label,使用本地文件 table1_data 导入 table1 表。

curl --location-trusted -u test:test_passwd -H "label:table1_20170707" -H "column_separator:," -T table1_data http://FE_HOST:8030/api/example_db/table1/_stream_load

- FE_HOST 是任一 FE 所在节点 IP,8030 为 fe.conf 中的 http_port。

- 可以使用任一 BE 的 IP,以及 be.conf 中的 webserver_port 进行导入。如:

BE_HOST:8040

本地文件 table1_data 以 , 作为数据之间的分隔,具体内容如下:

1,1,jim,2

2,1,grace,2

3,2,tom,2

4,3,bush,3

5,3,helen,3

示例2: 以 "table2_20170707" 为 Label,使用本地文件 table2_data 导入 table2 表。

curl --location-trusted -u test:test -H "label:table2_20170707" -H "column_separator:|" -T table2_data http://127.0.0.1:8030/api/example_db/table2/_stream_load

本地文件 table2_data 以 | 作为数据之间的分隔,具体内容如下:

2017-07-03|1|1|jim|2

2017-07-05|2|1|grace|2

2017-07-12|3|2|tom|2

2017-07-15|4|3|bush|3

2017-07-12|5|3|helen|3

注意事项:

- 采用流式导入建议文件大小限制在 10GB 以内,过大的文件会导致失败重试代价变大。

- 每一批导入数据都需要取一个 Label,Label 最好是一个和一批数据有关的字符串,方便阅读和管理。Doris 基于 Label 保证在一个Database 内,同一批数据只可导入成功一次。失败任务的 Label 可以重用。

- 流式导入是同步命令。命令返回成功则表示数据已经导入,返回失败表示这批数据没有导入。

#Broker 导入

Broker 导入通过部署的 Broker 进程,读取外部存储上的数据进行导入。更多帮助请参阅 HELP BROKER LOAD;

示例:以 "table1_20170708" 为 Label,将 HDFS 上的文件导入 table1 表

LOAD LABEL table1_20170708

(

DATA INFILE("hdfs://your.namenode.host:port/dir/table1_data")

INTO TABLE table1

)

WITH BROKER hdfs

(

"username"="hdfs_user",

"password"="hdfs_password"

)

PROPERTIES

(

"timeout"="3600",

"max_filter_ratio"="0.1"

);

Broker 导入是异步命令。以上命令执行成功只表示提交任务成功。导入是否成功需要通过 SHOW LOAD; 查看。如:

SHOW LOAD WHERE LABEL = "table1_20170708";

返回结果中,State 字段为 FINISHED 则表示导入成功。

关于 SHOW LOAD 的更多说明,可以参阅 HELP SHOW LOAD;

异步的导入任务在结束前可以取消:

CANCEL LOAD WHERE LABEL = "table1_20170708";

#3 数据的查询

#3.1 简单查询

示例:

MySQL> SELECT * FROM table1 LIMIT 3;

+--------+----------+----------+------+

| siteid | citycode | username | pv |

+--------+----------+----------+------+

| 2 | 1 | 'grace' | 2 |

| 5 | 3 | 'helen' | 3 |

| 3 | 2 | 'tom' | 2 |

+--------+----------+----------+------+

3 rows in set (0.01 sec)

MySQL> SELECT * FROM table1 ORDER BY citycode;

+--------+----------+----------+------+

| siteid | citycode | username | pv |

+--------+----------+----------+------+

| 2 | 1 | 'grace' | 2 |

| 1 | 1 | 'jim' | 2 |

| 3 | 2 | 'tom' | 2 |

| 4 | 3 | 'bush' | 3 |

| 5 | 3 | 'helen' | 3 |

+--------+----------+----------+------+

5 rows in set (0.01 sec)

#3.3 Join 查询

示例:

MySQL> SELECT SUM(table1.pv) FROM table1 JOIN table2 WHERE table1.siteid = table2.siteid;

+--------------------+

| sum(`table1`.`pv`) |

+--------------------+

| 12 |

+--------------------+

1 row in set (0.20 sec)

#3.4 子查询

示例:

MySQL> SELECT SUM(pv) FROM table2 WHERE siteid IN (SELECT siteid FROM table1 WHERE siteid > 2);

+-----------+

| sum(`pv`) |

+-----------+

| 8 |

+-----------+

1 row in set (0.13 sec)高级使用指南

这里我们介绍 Doris 的一些高级特性。

#1 表结构变更

使用 ALTER TABLE 命令可以修改表的 Schema,包括如下修改:

- 增加列

- 删除列

- 修改列类型

- 改变列顺序

以下举例说明。

原表 table1 的 Schema 如下:

+----------+-------------+------+-------+---------+-------+

| Field | Type | Null | Key | Default | Extra |

+----------+-------------+------+-------+---------+-------+

| siteid | int(11) | No | true | 10 | |

| citycode | smallint(6) | No | true | N/A | |

| username | varchar(32) | No | true | | |

| pv | bigint(20) | No | false | 0 | SUM |

+----------+-------------+------+-------+---------+-------+

我们新增一列 uv,类型为 BIGINT,聚合类型为 SUM,默认值为 0:

ALTER TABLE table1 ADD COLUMN uv BIGINT SUM DEFAULT '0' after pv;

提交成功后,可以通过以下命令查看作业进度:

SHOW ALTER TABLE COLUMN;

当作业状态为 FINISHED,则表示作业完成。新的 Schema 已生效。

ALTER TABLE 完成之后, 可以通过 DESC TABLE 查看最新的 Schema。

mysql> DESC table1;

+----------+-------------+------+-------+---------+-------+

| Field | Type | Null | Key | Default | Extra |

+----------+-------------+------+-------+---------+-------+

| siteid | int(11) | No | true | 10 | |

| citycode | smallint(6) | No | true | N/A | |

| username | varchar(32) | No | true | | |

| pv | bigint(20) | No | false | 0 | SUM |

| uv | bigint(20) | No | false | 0 | SUM |

+----------+-------------+------+-------+---------+-------+

5 rows in set (0.00 sec)

可以使用以下命令取消当前正在执行的作业:

CANCEL ALTER TABLE COLUMN FROM table1

更多帮助,可以参阅 HELP ALTER TABLE。

#2 Rollup

Rollup 可以理解为 Table 的一个物化索引结构。物化 是因为其数据在物理上独立存储,而 索引 的意思是,Rollup可以调整列顺序以增加前缀索引的命中率,也可以减少key列以增加数据的聚合度。

以下举例说明。

原表table1的Schema如下:

+----------+-------------+------+-------+---------+-------+

| Field | Type | Null | Key | Default | Extra |

+----------+-------------+------+-------+---------+-------+

| siteid | int(11) | No | true | 10 | |

| citycode | smallint(6) | No | true | N/A | |

| username | varchar(32) | No | true | | |

| pv | bigint(20) | No | false | 0 | SUM |

| uv | bigint(20) | No | false | 0 | SUM |

+----------+-------------+------+-------+---------+-------+

对于 table1 明细数据是 siteid, citycode, username 三者构成一组 key,从而对 pv 字段进行聚合;如果业务方经常有看城市 pv 总量的需求,可以建立一个只有 citycode, pv 的rollup。

ALTER TABLE table1 ADD ROLLUP rollup_city(citycode, pv);

提交成功后,可以通过以下命令查看作业进度:

SHOW ALTER TABLE ROLLUP;

当作业状态为 FINISHED,则表示作业完成。

Rollup 建立完成之后可以使用 DESC table1 ALL 查看表的 Rollup 信息。

mysql> desc table1 all;

+-------------+----------+-------------+------+-------+--------+-------+

| IndexName | Field | Type | Null | Key | Default | Extra |

+-------------+----------+-------------+------+-------+---------+-------+

| table1 | siteid | int(11) | No | true | 10 | |

| | citycode | smallint(6) | No | true | N/A | |

| | username | varchar(32) | No | true | | |

| | pv | bigint(20) | No | false | 0 | SUM |

| | uv | bigint(20) | No | false | 0 | SUM |

| | | | | | | |

| rollup_city | citycode | smallint(6) | No | true | N/A | |

| | pv | bigint(20) | No | false | 0 | SUM |

+-------------+----------+-------------+------+-------+---------+-------+

8 rows in set (0.01 sec)

可以使用以下命令取消当前正在执行的作业:

CANCEL ALTER TABLE ROLLUP FROM table1;

Rollup 建立之后,查询不需要指定 Rollup 进行查询。还是指定原有表进行查询即可。程序会自动判断是否应该使用 Rollup。是否命中 Rollup可以通过 EXPLAIN your_sql; 命令进行查看。

更多帮助,可以参阅 HELP ALTER TABLE。

#2 数据表的查询

#2.1 内存限制

为了防止用户的一个查询可能因为消耗内存过大。查询进行了内存控制,一个查询任务,在单个 BE 节点上默认使用不超过 2GB 内存。

用户在使用时,如果发现报 Memory limit exceeded 错误,一般是超过内存限制了。

遇到内存超限时,用户应该尽量通过优化自己的 sql 语句来解决。

如果确切发现2GB内存不能满足,可以手动设置内存参数。

显示查询内存限制:

mysql> SHOW VARIABLES LIKE "%mem_limit%";

+---------------+------------+

| Variable_name | Value |

+---------------+------------+

| exec_mem_limit| 2147483648 |

+---------------+------------+

1 row in set (0.00 sec)

exec_mem_limit 的单位是 byte,可以通过 SET 命令改变 exec_mem_limit 的值。如改为 8GB。

SET exec_mem_limit = 8589934592;

mysql> SHOW VARIABLES LIKE "%mem_limit%";

+---------------+------------+

| Variable_name | Value |

+---------------+------------+

| exec_mem_limit| 8589934592 |

+---------------+------------+

1 row in set (0.00 sec)

- 以上该修改为 session 级别,仅在当前连接 session 内有效。断开重连则会变回默认值。

- 如果需要修改全局变量,可以这样设置:

SET GLOBAL exec_mem_limit = 8589934592;。设置完成后,断开 session 重新登录,参数将永久生效。

#2.2 查询超时

当前默认查询时间设置为最长为 300 秒,如果一个查询在 300 秒内没有完成,则查询会被 Doris 系统 cancel 掉。用户可以通过这个参数来定制自己应用的超时时间,实现类似 wait(timeout) 的阻塞方式。

查看当前超时设置:

mysql> SHOW VARIABLES LIKE "%query_timeout%";

+---------------+-------+

| Variable_name | Value |

+---------------+-------+

| QUERY_TIMEOUT | 300 |

+---------------+-------+

1 row in set (0.00 sec)

修改超时时间到1分钟:

SET query_timeout = 60;

- 当前超时的检查间隔为 5 秒,所以小于 5 秒的超时不会太准确。

- 以上修改同样为 session 级别。可以通过

SET GLOBAL修改全局有效。

#2.3 Broadcast/Shuffle Join

系统默认实现 Join 的方式,是将小表进行条件过滤后,将其广播到大表所在的各个节点上,形成一个内存 Hash 表,然后流式读出大表的数据进行Hash Join。但是如果当小表过滤后的数据量无法放入内存的话,此时 Join 将无法完成,通常的报错应该是首先造成内存超限。

如果遇到上述情况,建议显式指定 Shuffle Join,也被称作 Partitioned Join。即将小表和大表都按照 Join 的 key 进行 Hash,然后进行分布式的 Join。这个对内存的消耗就会分摊到集群的所有计算节点上。

Doris会自动尝试进行 Broadcast Join,如果预估小表过大则会自动切换至 Shuffle Join。注意,如果此时显式指定了 Broadcast Join 也会自动切换至 Shuffle Join。

使用 Broadcast Join(默认):

mysql> select sum(table1.pv) from table1 join table2 where table1.siteid = 2;

+--------------------+

| sum(`table1`.`pv`) |

+--------------------+

| 10 |

+--------------------+

1 row in set (0.20 sec)

使用 Broadcast Join(显式指定):

mysql> select sum(table1.pv) from table1 join [broadcast] table2 where table1.siteid = 2;

+--------------------+

| sum(`table1`.`pv`) |

+--------------------+

| 10 |

+--------------------+

1 row in set (0.20 sec)

使用 Shuffle Join:

mysql> select sum(table1.pv) from table1 join [shuffle] table2 where table1.siteid = 2;

+--------------------+

| sum(`table1`.`pv`) |

+--------------------+

| 10 |

+--------------------+

1 row in set (0.15 sec)

#2.4 查询重试和高可用

当部署多个 FE 节点时,用户可以在多个 FE 之上部署负载均衡层来实现 Doris 的高可用。

以下提供一些高可用的方案:

第一种

自己在应用层代码进行重试和负载均衡。比如发现一个连接挂掉,就自动在其他连接上进行重试。应用层代码重试需要应用自己配置多个doris前端节点地址。

第二种

如果使用 mysql jdbc connector 来连接Doris,可以使用 jdbc 的自动重试机制:

jdbc:mysql://[host:port],[host:port].../[database][?propertyName1][=propertyValue1][&propertyName2][=propertyValue2]...

第三种

应用可以连接到和应用部署到同一机器上的 MySQL Proxy,通过配置 MySQL Proxy 的 Failover 和 Load Balance 功能来达到目的。

http://dev.mysql.com/doc/refman/5.6/en/mysql-proxy-using.html

数据模型、ROLLUP 及前缀索引

本文档主要从逻辑层面,描述 Doris 的数据模型、 ROLLUP 以及前缀索引的概念,以帮助用户更好的使用 Doris 应对不同的业务场景。

#基本概念

在 Doris 中,数据以表(Table)的形式进行逻辑上的描述。

一张表包括行(Row)和列(Column)。Row 即用户的一行数据。Column 用于描述一行数据中不同的字段。

Column 可以分为两大类:Key 和 Value。从业务角度看,Key 和 Value 可以分别对应维度列和指标列。

Doris 的数据模型主要分为3类:

- Aggregate

- Uniq

- Duplicate

下面我们分别介绍。

#Aggregate 模型

我们以实际的例子来说明什么是聚合模型,以及如何正确的使用聚合模型。

#示例1:导入数据聚合

假设业务有如下数据表模式:

| ColumnName | Type | AggregationType | Comment |

|---|---|---|---|

| user_id | LARGEINT | 用户id | |

| date | DATE | 数据灌入日期 | |

| city | VARCHAR(20) | 用户所在城市 | |

| age | SMALLINT | 用户年龄 | |

| sex | TINYINT | 用户性别 | |

| last_visit_date | DATETIME | REPLACE | 用户最后一次访问时间 |

| cost | BIGINT | SUM | 用户总消费 |

| max_dwell_time | INT | MAX | 用户最大停留时间 |

| min_dwell_time | INT | MIN | 用户最小停留时间 |

如果转换成建表语句则如下(省略建表语句中的 Partition 和 Distribution 信息)

CREATE TABLE IF NOT EXISTS example_db.expamle_tbl

(

`user_id` LARGEINT NOT NULL COMMENT "用户id",

`date` DATE NOT NULL COMMENT "数据灌入日期时间",

`city` VARCHAR(20) COMMENT "用户所在城市",

`age` SMALLINT COMMENT "用户年龄",

`sex` TINYINT COMMENT "用户性别",

`last_visit_date` DATETIME REPLACE DEFAULT "1970-01-01 00:00:00" COMMENT "用户最后一次访问时间",

`cost` BIGINT SUM DEFAULT "0" COMMENT "用户总消费",

`max_dwell_time` INT MAX DEFAULT "0" COMMENT "用户最大停留时间",

`min_dwell_time` INT MIN DEFAULT "99999" COMMENT "用户最小停留时间"

)

AGGREGATE KEY(`user_id`, `date`, `city`, `age`, `sex`)

... /* 省略 Partition 和 Distribution 信息 */

;

可以看到,这是一个典型的用户信息和访问行为的事实表。

在一般星型模型中,用户信息和访问行为一般分别存放在维度表和事实表中。这里我们为了更加方便的解释 Doris 的数据模型,将两部分信息统一存放在一张表中。

表中的列按照是否设置了 AggregationType,分为 Key (维度列) 和 Value(指标列)。没有设置 AggregationType 的,如 user_id、date、age ... 等称为 Key,而设置了 AggregationType 的称为 Value。

当我们导入数据时,对于 Key 列相同的行会聚合成一行,而 Value 列会按照设置的 AggregationType 进行聚合。 AggregationType 目前有以下四种聚合方式:

- SUM:求和,多行的 Value 进行累加。

- REPLACE:替代,下一批数据中的 Value 会替换之前导入过的行中的 Value。

- MAX:保留最大值。

- MIN:保留最小值。

假设我们有以下导入数据(原始数据):

| user_id | date | city | age | sex | last_visit_date | cost | max_dwell_time | min_dwell_time |

|---|---|---|---|---|---|---|---|---|

| 10000 | 2017-10-01 | 北京 | 20 | 0 | 2017-10-01 06:00:00 | 20 | 10 | 10 |

| 10000 | 2017-10-01 | 北京 | 20 | 0 | 2017-10-01 07:00:00 | 15 | 2 | 2 |

| 10001 | 2017-10-01 | 北京 | 30 | 1 | 2017-10-01 17:05:45 | 2 | 22 | 22 |

| 10002 | 2017-10-02 | 上海 | 20 | 1 | 2017-10-02 12:59:12 | 200 | 5 | 5 |

| 10003 | 2017-10-02 | 广州 | 32 | 0 | 2017-10-02 11:20:00 | 30 | 11 | 11 |

| 10004 | 2017-10-01 | 深圳 | 35 | 0 | 2017-10-01 10:00:15 | 100 | 3 | 3 |

| 10004 | 2017-10-03 | 深圳 | 35 | 0 | 2017-10-03 10:20:22 | 11 | 6 | 6 |

我们假设这是一张记录用户访问某商品页面行为的表。我们以第一行数据为例,解释如下:

| 数据 | 说明 |

|---|---|

| 10000 | 用户id,每个用户唯一识别id |

| 2017-10-01 | 数据入库时间,精确到日期 |

| 北京 | 用户所在城市 |

| 20 | 用户年龄 |

| 0 | 性别男(1 代表女性) |

| 2017-10-01 06:00:00 | 用户本次访问该页面的时间,精确到秒 |

| 20 | 用户本次访问产生的消费 |

| 10 | 用户本次访问,驻留该页面的时间 |

| 10 | 用户本次访问,驻留该页面的时间(冗余) |

那么当这批数据正确导入到 Doris 中后,Doris 中最终存储如下:

| user_id | date | city | age | sex | last_visit_date | cost | max_dwell_time | min_dwell_time |

|---|---|---|---|---|---|---|---|---|

| 10000 | 2017-10-01 | 北京 | 20 | 0 | 2017-10-01 07:00:00 | 35 | 10 | 2 |

| 10001 | 2017-10-01 | 北京 | 30 | 1 | 2017-10-01 17:05:45 | 2 | 22 | 22 |

| 10002 | 2017-10-02 | 上海 | 20 | 1 | 2017-10-02 12:59:12 | 200 | 5 | 5 |

| 10003 | 2017-10-02 | 广州 | 32 | 0 | 2017-10-02 11:20:00 | 30 | 11 | 11 |

| 10004 | 2017-10-01 | 深圳 | 35 | 0 | 2017-10-01 10:00:15 | 100 | 3 | 3 |

| 10004 | 2017-10-03 | 深圳 | 35 | 0 | 2017-10-03 10:20:22 | 11 | 6 | 6 |

可以看到,用户 10000 只剩下了一行聚合后的数据。而其余用户的数据和原始数据保持一致。这里先解释下用户 10000 聚合后的数据:

前5列没有变化,从第6列 last_visit_date 开始:

-

2017-10-01 07:00:00:因为last_visit_date列的聚合方式为 REPLACE,所以2017-10-01 07:00:00替换了2017-10-01 06:00:00保存了下来。注:在同一个导入批次中的数据,对于 REPLACE 这种聚合方式,替换顺序不做保证。如在这个例子中,最终保存下来的,也有可能是

2017-10-01 06:00:00。而对于不同导入批次中的数据,可以保证,后一批次的数据会替换前一批次。 -

35:因为cost列的聚合类型为 SUM,所以由 20 + 15 累加获得 35。 -

10:因为max_dwell_time列的聚合类型为 MAX,所以 10 和 2 取最大值,获得 10。 -

2:因为min_dwell_time列的聚合类型为 MIN,所以 10 和 2 取最小值,获得 2。

经过聚合,Doris 中最终只会存储聚合后的数据。换句话说,即明细数据会丢失,用户不能够再查询到聚合前的明细数据了。

#示例2:保留明细数据

接示例1,我们将表结构修改如下:

| ColumnName | Type | AggregationType | Comment |

|---|---|---|---|

| user_id | LARGEINT | 用户id | |

| date | DATE | 数据灌入日期 | |

| timestamp | DATETIME | 数据灌入时间,精确到秒 | |

| city | VARCHAR(20) | 用户所在城市 | |

| age | SMALLINT | 用户年龄 | |

| sex | TINYINT | 用户性别 | |

| last_visit_date | DATETIME | REPLACE | 用户最后一次访问时间 |

| cost | BIGINT | SUM | 用户总消费 |

| max_dwell_time | INT | MAX | 用户最大停留时间 |

| min_dwell_time | INT | MIN | 用户最小停留时间 |

即增加了一列 timestamp,记录精确到秒的数据灌入时间。

导入数据如下:

| user_id | date | timestamp | city | age | sex | last_visit_date | cost | max_dwell_time | min_dwell_time |

|---|---|---|---|---|---|---|---|---|---|

| 10000 | 2017-10-01 | 2017-10-01 08:00:05 | 北京 | 20 | 0 | 2017-10-01 06:00:00 | 20 | 10 | 10 |

| 10000 | 2017-10-01 | 2017-10-01 09:00:05 | 北京 | 20 | 0 | 2017-10-01 07:00:00 | 15 | 2 | 2 |

| 10001 | 2017-10-01 | 2017-10-01 18:12:10 | 北京 | 30 | 1 | 2017-10-01 17:05:45 | 2 | 22 | 22 |

| 10002 | 2017-10-02 | 2017-10-02 13:10:00 | 上海 | 20 | 1 | 2017-10-02 12:59:12 | 200 | 5 | 5 |

| 10003 | 2017-10-02 | 2017-10-02 13:15:00 | 广州 | 32 | 0 | 2017-10-02 11:20:00 | 30 | 11 | 11 |

| 10004 | 2017-10-01 | 2017-10-01 12:12:48 | 深圳 | 35 | 0 | 2017-10-01 10:00:15 | 100 | 3 | 3 |

| 10004 | 2017-10-03 | 2017-10-03 12:38:20 | 深圳 | 35 | 0 | 2017-10-03 10:20:22 | 11 | 6 | 6 |

那么当这批数据正确导入到 Doris 中后,Doris 中最终存储如下:

| user_id | date | timestamp | city | age | sex | last_visit_date | cost | max_dwell_time | min_dwell_time |

|---|---|---|---|---|---|---|---|---|---|

| 10000 | 2017-10-01 | 2017-10-01 08:00:05 | 北京 | 20 | 0 | 2017-10-01 06:00:00 | 20 | 10 | 10 |

| 10000 | 2017-10-01 | 2017-10-01 09:00:05 | 北京 | 20 | 0 | 2017-10-01 07:00:00 | 15 | 2 | 2 |

| 10001 | 2017-10-01 | 2017-10-01 18:12:10 | 北京 | 30 | 1 | 2017-10-01 17:05:45 | 2 | 22 | 22 |

| 10002 | 2017-10-02 | 2017-10-02 13:10:00 | 上海 | 20 | 1 | 2017-10-02 12:59:12 | 200 | 5 | 5 |

| 10003 | 2017-10-02 | 2017-10-02 13:15:00 | 广州 | 32 | 0 | 2017-10-02 11:20:00 | 30 | 11 | 11 |

| 10004 | 2017-10-01 | 2017-10-01 12:12:48 | 深圳 | 35 | 0 | 2017-10-01 10:00:15 | 100 | 3 | 3 |

| 10004 | 2017-10-03 | 2017-10-03 12:38:20 | 深圳 | 35 | 0 | 2017-10-03 10:20:22 | 11 | 6 | 6 |

我们可以看到,存储的数据,和导入数据完全一样,没有发生任何聚合。这是因为,这批数据中,因为加入了 timestamp 列,所有行的 Key 都不完全相同。也就是说,只要保证导入的数据中,每一行的 Key 都不完全相同,那么即使在聚合模型下,Doris 也可以保存完整的明细数据。

#示例3:导入数据与已有数据聚合

接示例1。假设现在表中已有数据如下:

| user_id | date | city | age | sex | last_visit_date | cost | max_dwell_time | min_dwell_time |

|---|---|---|---|---|---|---|---|---|

| 10000 | 2017-10-01 | 北京 | 20 | 0 | 2017-10-01 07:00:00 | 35 | 10 | 2 |

| 10001 | 2017-10-01 | 北京 | 30 | 1 | 2017-10-01 17:05:45 | 2 | 22 | 22 |

| 10002 | 2017-10-02 | 上海 | 20 | 1 | 2017-10-02 12:59:12 | 200 | 5 | 5 |

| 10003 | 2017-10-02 | 广州 | 32 | 0 | 2017-10-02 11:20:00 | 30 | 11 | 11 |

| 10004 | 2017-10-01 | 深圳 | 35 | 0 | 2017-10-01 10:00:15 | 100 | 3 | 3 |

| 10004 | 2017-10-03 | 深圳 | 35 | 0 | 2017-10-03 10:20:22 | 11 | 6 | 6 |

我们再导入一批新的数据:

| user_id | date | city | age | sex | last_visit_date | cost | max_dwell_time | min_dwell_time |

|---|---|---|---|---|---|---|---|---|

| 10004 | 2017-10-03 | 深圳 | 35 | 0 | 2017-10-03 11:22:00 | 44 | 19 | 19 |

| 10005 | 2017-10-03 | 长沙 | 29 | 1 | 2017-10-03 18:11:02 | 3 | 1 | 1 |

那么当这批数据正确导入到 Doris 中后,Doris 中最终存储如下:

| user_id | date | city | age | sex | last_visit_date | cost | max_dwell_time | min_dwell_time |

|---|---|---|---|---|---|---|---|---|

| 10000 | 2017-10-01 | 北京 | 20 | 0 | 2017-10-01 07:00:00 | 35 | 10 | 2 |

| 10001 | 2017-10-01 | 北京 | 30 | 1 | 2017-10-01 17:05:45 | 2 | 22 | 22 |

| 10002 | 2017-10-02 | 上海 | 20 | 1 | 2017-10-02 12:59:12 | 200 | 5 | 5 |

| 10003 | 2017-10-02 | 广州 | 32 | 0 | 2017-10-02 11:20:00 | 30 | 11 | 11 |

| 10004 | 2017-10-01 | 深圳 | 35 | 0 | 2017-10-01 10:00:15 | 100 | 3 | 3 |

| 10004 | 2017-10-03 | 深圳 | 35 | 0 | 2017-10-03 11:22:00 | 55 | 19 | 6 |

| 10005 | 2017-10-03 | 长沙 | 29 | 1 | 2017-10-03 18:11:02 | 3 | 1 | 1 |

可以看到,用户 10004 的已有数据和新导入的数据发生了聚合。同时新增了 10005 用户的数据。

数据的聚合,在 Doris 中有如下三个阶段发生:

- 每一批次数据导入的 ETL 阶段。该阶段会在每一批次导入的数据内部进行聚合。

- 底层 BE 进行数据 Compaction 的阶段。该阶段,BE 会对已导入的不同批次的数据进行进一步的聚合。

- 数据查询阶段。在数据查询时,对于查询涉及到的数据,会进行对应的聚合。

数据在不同时间,可能聚合的程度不一致。比如一批数据刚导入时,可能还未与之前已存在的数据进行聚合。但是对于用户而言,用户只能查询到聚合后的数据。即不同的聚合程度对于用户查询而言是透明的。用户需始终认为数据以最终的完成的聚合程度存在,而不应假设某些聚合还未发生。(可参阅聚合模型的局限性一节获得更多详情。)

#Uniq 模型

在某些多维分析场景下,用户更关注的是如何保证 Key 的唯一性,即如何获得 Primary Key 唯一性约束。因此,我们引入了 Uniq 的数据模型。该模型本质上是聚合模型的一个特例,也是一种简化的表结构表示方式。我们举例说明。

| ColumnName | Type | IsKey | Comment |

|---|---|---|---|

| user_id | BIGINT | Yes | 用户id |

| username | VARCHAR(50) | Yes | 用户昵称 |

| city | VARCHAR(20) | No | 用户所在城市 |

| age | SMALLINT | No | 用户年龄 |

| sex | TINYINT | No | 用户性别 |

| phone | LARGEINT | No | 用户电话 |

| address | VARCHAR(500) | No | 用户住址 |

| register_time | DATETIME | No | 用户注册时间 |

这是一个典型的用户基础信息表。这类数据没有聚合需求,只需保证主键唯一性。(这里的主键为 user_id + username)。那么我们的建表语句如下:

CREATE TABLE IF NOT EXISTS example_db.expamle_tbl

(

`user_id` LARGEINT NOT NULL COMMENT "用户id",

`username` VARCHAR(50) NOT NULL COMMENT "用户昵称",

`city` VARCHAR(20) COMMENT "用户所在城市",

`age` SMALLINT COMMENT "用户年龄",

`sex` TINYINT COMMENT "用户性别",

`phone` LARGEINT COMMENT "用户电话",

`address` VARCHAR(500) COMMENT "用户地址",

`register_time` DATETIME COMMENT "用户注册时间"

)

UNIQUE KEY(`user_id`, `username`)

... /* 省略 Partition 和 Distribution 信息 */

;

而这个表结构,完全同等于以下使用聚合模型描述的表结构:

| ColumnName | Type | AggregationType | Comment |

|---|---|---|---|

| user_id | BIGINT | 用户id | |

| username | VARCHAR(50) | 用户昵称 | |

| city | VARCHAR(20) | REPLACE | 用户所在城市 |

| age | SMALLINT | REPLACE | 用户年龄 |

| sex | TINYINT | REPLACE | 用户性别 |

| phone | LARGEINT | REPLACE | 用户电话 |

| address | VARCHAR(500) | REPLACE | 用户住址 |

| register_time | DATETIME | REPLACE | 用户注册时间 |

及建表语句:

CREATE TABLE IF NOT EXISTS example_db.expamle_tbl

(

`user_id` LARGEINT NOT NULL COMMENT "用户id",

`username` VARCHAR(50) NOT NULL COMMENT "用户昵称",

`city` VARCHAR(20) REPLACE COMMENT "用户所在城市",

`age` SMALLINT REPLACE COMMENT "用户年龄",

`sex` TINYINT REPLACE COMMENT "用户性别",

`phone` LARGEINT REPLACE COMMENT "用户电话",

`address` VARCHAR(500) REPLACE COMMENT "用户地址",

`register_time` DATETIME REPLACE COMMENT "用户注册时间"

)

AGGREGATE KEY(`user_id`, `username`)

... /* 省略 Partition 和 Distribution 信息 */

;

即 Uniq 模型完全可以用聚合模型中的 REPLACE 方式替代。其内部的实现方式和数据存储方式也完全一样。这里不再继续举例说明。

#Duplicate 模型

在某些多维分析场景下,数据既没有主键,也没有聚合需求。因此,我们引入 Duplicate 数据模型来满足这类需求。举例说明。

| ColumnName | Type | SortKey | Comment |

|---|---|---|---|

| timestamp | DATETIME | Yes | 日志时间 |

| type | INT | Yes | 日志类型 |

| error_code | INT | Yes | 错误码 |

| error_msg | VARCHAR(1024) | No | 错误详细信息 |

| op_id | BIGINT | No | 负责人id |

| op_time | DATETIME | No | 处理时间 |

建表语句如下:

CREATE TABLE IF NOT EXISTS example_db.expamle_tbl

(

`timestamp` DATETIME NOT NULL COMMENT "日志时间",

`type` INT NOT NULL COMMENT "日志类型",

`error_code` INT COMMENT "错误码",

`error_msg` VARCHAR(1024) COMMENT "错误详细信息",

`op_id` BIGINT COMMENT "负责人id",

`op_time` DATETIME COMMENT "处理时间"

)

DUPLICATE KEY(`timestamp`, `type`)

... /* 省略 Partition 和 Distribution 信息 */

;

这种数据模型区别于 Aggregate 和 Uniq 模型。数据完全按照导入文件中的数据进行存储,不会有任何聚合。即使两行数据完全相同,也都会保留。 而在建表语句中指定的 DUPLICATE KEY,只是用来指明底层数据按照那些列进行排序。(更贴切的名称应该为 “Sorted Column”,这里取名 “DUPLICATE KEY” 只是用以明确表示所用的数据模型。关于 “Sorted Column”的更多解释,可以参阅前缀索引小节)。在 DUPLICATE KEY 的选择上,我们建议适当的选择前 2-4 列就可以。

这种数据模型适用于既没有聚合需求,又没有主键唯一性约束的原始数据的存储。更多使用场景,可参阅聚合模型的局限性小节。

#ROLLUP

ROLLUP 在多维分析中是“上卷”的意思,即将数据按某种指定的粒度进行进一步聚合。

#基本概念

在 Doris 中,我们将用户通过建表语句创建出来的表称为 Base 表(Base Table)。Base 表中保存着按用户建表语句指定的方式存储的基础数据。

在 Base 表之上,我们可以创建任意多个 ROLLUP 表。这些 ROLLUP 的数据是基于 Base 表产生的,并且在物理上是独立存储的。

ROLLUP 表的基本作用,在于在 Base 表的基础上,获得更粗粒度的聚合数据。

下面我们用示例详细说明在不同数据模型中的 ROLLUP 表及其作用。

#Aggregate 和 Uniq 模型中的 ROLLUP

因为 Uniq 只是 Aggregate 模型的一个特例,所以这里我们不加以区别。

- 示例1:获得每个用户的总消费

接Aggregate 模型小节的示例2,Base 表结构如下:

| ColumnName | Type | AggregationType | Comment |

|---|---|---|---|

| user_id | LARGEINT | 用户id | |

| date | DATE | 数据灌入日期 | |

| timestamp | DATETIME | 数据灌入时间,精确到秒 | |

| city | VARCHAR(20) | 用户所在城市 | |

| age | SMALLINT | 用户年龄 | |

| sex | TINYINT | 用户性别 | |

| last_visit_date | DATETIME | REPLACE | 用户最后一次访问时间 |

| cost | BIGINT | SUM | 用户总消费 |

| max_dwell_time | INT | MAX | 用户最大停留时间 |

| min_dwell_time | INT | MIN | 用户最小停留时间 |

存储的数据如下:

| user_id | date | timestamp | city | age | sex | last_visit_date | cost | max_dwell_time | min_dwell_time |

|---|---|---|---|---|---|---|---|---|---|

| 10000 | 2017-10-01 | 2017-10-01 08:00:05 | 北京 | 20 | 0 | 2017-10-01 06:00:00 | 20 | 10 | 10 |

| 10000 | 2017-10-01 | 2017-10-01 09:00:05 | 北京 | 20 | 0 | 2017-10-01 07:00:00 | 15 | 2 | 2 |

| 10001 | 2017-10-01 | 2017-10-01 18:12:10 | 北京 | 30 | 1 | 2017-10-01 17:05:45 | 2 | 22 | 22 |

| 10002 | 2017-10-02 | 2017-10-02 13:10:00 | 上海 | 20 | 1 | 2017-10-02 12:59:12 | 200 | 5 | 5 |

| 10003 | 2017-10-02 | 2017-10-02 13:15:00 | 广州 | 32 | 0 | 2017-10-02 11:20:00 | 30 | 11 | 11 |

| 10004 | 2017-10-01 | 2017-10-01 12:12:48 | 深圳 | 35 | 0 | 2017-10-01 10:00:15 | 100 | 3 | 3 |

| 10004 | 2017-10-03 | 2017-10-03 12:38:20 | 深圳 | 35 | 0 | 2017-10-03 10:20:22 | 11 | 6 | 6 |

在此基础上,我们创建一个 ROLLUP:

| ColumnName |

|---|

| user_id |

| cost |

该 ROLLUP 只包含两列:user_id 和 cost。则创建完成后,该 ROLLUP 中存储的数据如下:

| user_id | cost |

|---|---|

| 10000 | 35 |

| 10001 | 2 |

| 10002 | 200 |

| 10003 | 30 |

| 10004 | 111 |

可以看到,ROLLUP 中仅保留了每个 user_id,在 cost 列上的 SUM 的结果。那么当我们进行如下查询时:

SELECT user_id, sum(cost) FROM table GROUP BY user_id;

Doris 会自动命中这个 ROLLUP 表,从而只需扫描极少的数据量,即可完成这次聚合查询。

- 示例2:获得不同城市,不同年龄段用户的总消费、最长和最短页面驻留时间

紧接示例1。我们在 Base 表基础之上,再创建一个 ROLLUP:

| ColumnName | Type | AggregationType | Comment |

|---|---|---|---|

| city | VARCHAR(20) | 用户所在城市 | |

| age | SMALLINT | 用户年龄 | |

| cost | BIGINT | SUM | 用户总消费 |

| max_dwell_time | INT | MAX | 用户最大停留时间 |

| min_dwell_time | INT | MIN | 用户最小停留时间 |

则创建完成后,该 ROLLUP 中存储的数据如下:

| city | age | cost | max_dwell_time | min_dwell_time |

|---|---|---|---|---|

| 北京 | 20 | 0 | 30 | 10 |

| 北京 | 30 | 1 | 2 | 22 |

| 上海 | 20 | 1 | 200 | 5 |

| 广州 | 32 | 0 | 30 | 11 |

| 深圳 | 35 | 0 | 111 | 6 |

当我们进行如下这些查询时:

SELECT city, age, sum(cost), max(max_dwell_time), min(min_dwell_time) FROM table GROUP BY city, age;SELECT city, sum(cost), max(max_dwell_time), min(min_dwell_time) FROM table GROUP BY city;SELECT city, age, sum(cost), min(min_dwell_time) FROM table GROUP BY city, age;

Doris 会自动命中这个 ROLLUP 表。

#Duplicate 模型中的 ROLLUP

因为 Duplicate 模型没有聚合的语意。所以该模型中的 ROLLUP,已经失去了“上卷”这一层含义。而仅仅是作为调整列顺序,以命中前缀索引的作用。我们将在接下来的小节中,详细介绍前缀索引,以及如何使用ROLLUP改变前缀索引,以获得更好的查询效率。

#前缀索引与 ROLLUP

#前缀索引

不同于传统的数据库设计,Doris 不支持在任意列上创建索引。Doris 这类 MPP 架构的 OLAP 数据库,通常都是通过提高并发,来处理大量数据的。

本质上,Doris 的数据存储在类似 SSTable(Sorted String Table)的数据结构中。该结构是一种有序的数据结构,可以按照指定的列进行排序存储。在这种数据结构上,以排序列作为条件进行查找,会非常的高效。

在 Aggregate、Uniq 和 Duplicate 三种数据模型中。底层的数据存储,是按照各自建表语句中,AGGREGATE KEY、UNIQ KEY 和 DUPLICATE KEY 中指定的列进行排序存储的。

而前缀索引,即在排序的基础上,实现的一种根据给定前缀列,快速查询数据的索引方式。

我们将一行数据的前 36 个字节 作为这行数据的前缀索引。当遇到 VARCHAR 类型时,前缀索引会直接截断。我们举例说明:

- 以下表结构的前缀索引为 user_id(8Byte) + age(4Bytes) + message(prefix 20 Bytes)。

| ColumnName | Type |

|---|---|

| user_id | BIGINT |

| age | INT |

| message | VARCHAR(100) |

| max_dwell_time | DATETIME |

| min_dwell_time | DATETIME |

- 以下表结构的前缀索引为 user_name(20 Bytes)。即使没有达到 36 个字节,因为遇到 VARCHAR,所以直接截断,不再往后继续。

| ColumnName | Type |

|---|---|

| user_name | VARCHAR(20) |

| age | INT |

| message | VARCHAR(100) |

| max_dwell_time | DATETIME |

| min_dwell_time | DATETIME |

当我们的查询条件,是前缀索引的前缀时,可以极大的加快查询速度。比如在第一个例子中,我们执行如下查询:

SELECT * FROM table WHERE user_id=1829239 and age=20;

该查询的效率会远高于如下查询:

SELECT * FROM table WHERE age=20;

所以在建表时,正确的选择列顺序,能够极大地提高查询效率。

#ROLLUP 调整前缀索引

因为建表时已经指定了列顺序,所以一个表只有一种前缀索引。这对于使用其他不能命中前缀索引的列作为条件进行的查询来说,效率上可能无法满足需求。因此,我们可以通过创建 ROLLUP 来人为的调整列顺序。举例说明。

Base 表结构如下:

| ColumnName | Type |

|---|---|

| user_id | BIGINT |

| age | INT |

| message | VARCHAR(100) |

| max_dwell_time | DATETIME |

| min_dwell_time | DATETIME |

我们可以在此基础上创建一个 ROLLUP 表:

| ColumnName | Type |

|---|---|

| age | INT |

| user_id | BIGINT |

| message | VARCHAR(100) |

| max_dwell_time | DATETIME |

| min_dwell_time | DATETIME |

可以看到,ROLLUP 和 Base 表的列完全一样,只是将 user_id 和 age 的顺序调换了。那么当我们进行如下查询时:

SELECT * FROM table where age=20 and message LIKE "%error%";

会优先选择 ROLLUP 表,因为 ROLLUP 的前缀索引匹配度更高。

#ROLLUP 的几点说明

- ROLLUP 最根本的作用是提高某些查询的查询效率(无论是通过聚合来减少数据量,还是修改列顺序以匹配前缀索引)。因此 ROLLUP 的含义已经超出了 “上卷” 的范围。这也是为什么我们在源代码中,将其命名为 Materialized Index(物化索引)的原因。

- ROLLUP 是附属于 Base 表的,可以看做是 Base 表的一种辅助数据结构。用户可以在 Base 表的基础上,创建或删除 ROLLUP,但是不能在查询中显式的指定查询某 ROLLUP。是否命中 ROLLUP 完全由 Doris 系统自动决定。

- ROLLUP 的数据是独立物理存储的。因此,创建的 ROLLUP 越多,占用的磁盘空间也就越大。同时对导入速度也会有影响(导入的ETL阶段会自动产生所有 ROLLUP 的数据),但是不会降低查询效率(只会更好)。

- ROLLUP 的数据更新与 Base 表示完全同步的。用户无需关心这个问题。

- ROLLUP 中列的聚合方式,与 Base 表完全相同。在创建 ROLLUP 无需指定,也不能修改。

- 查询能否命中 ROLLUP 的一个必要条件(非充分条件)是,查询所涉及的所有列(包括 select list 和 where 中的查询条件列等)都存在于该 ROLLUP 的列中。否则,查询只能命中 Base 表。

- 某些类型的查询(如 count(*))在任何条件下,都无法命中 ROLLUP。具体参见接下来的 聚合模型的局限性 一节。

- 可以通过

EXPLAIN your_sql;命令获得查询执行计划,在执行计划中,查看是否命中 ROLLUP。 - 可以通过

DESC tbl_name ALL;语句显示 Base 表和所有已创建完成的 ROLLUP。

在这篇文档中可以查看 查询如何命中 Rollup

#聚合模型的局限性

这里我们针对 Aggregate 模型(包括 Uniq 模型),来介绍下聚合模型的局限性。

在聚合模型中,模型对外展现的,是最终聚合后的数据。也就是说,任何还未聚合的数据(比如说两个不同导入批次的数据),必须通过某种方式,以保证对外展示的一致性。我们举例说明。

假设表结构如下:

| ColumnName | Type | AggregationType | Comment |

|---|---|---|---|

| user_id | LARGEINT | 用户id | |

| date | DATE | 数据灌入日期 | |

| cost | BIGINT | SUM | 用户总消费 |

假设存储引擎中有如下两个已经导入完成的批次的数据:

batch 1

| user_id | date | cost |

|---|---|---|

| 10001 | 2017-11-20 | 50 |

| 10002 | 2017-11-21 | 39 |

batch 2

| user_id | date | cost |

|---|---|---|

| 10001 | 2017-11-20 | 1 |

| 10001 | 2017-11-21 | 5 |

| 10003 | 2017-11-22 | 22 |

可以看到,用户 10001 分属在两个导入批次中的数据还没有聚合。但是为了保证用户只能查询到如下最终聚合后的数据:

| user_id | date | cost |

|---|---|---|

| 10001 | 2017-11-20 | 51 |

| 10001 | 2017-11-21 | 5 |

| 10002 | 2017-11-21 | 39 |

| 10003 | 2017-11-22 | 22 |

我们在查询引擎中加入了聚合算子,来保证数据对外的一致性。

另外,在聚合列(Value)上,执行与聚合类型不一致的聚合类查询时,要注意语意。比如我们在如上示例中执行如下查询:

SELECT MIN(cost) FROM table;

得到的结果是 5,而不是 1。

同时,这种一致性保证,在某些查询中,会极大的降低查询效率。

我们以最基本的 count(*) 查询为例:

SELECT COUNT(*) FROM table;

在其他数据库中,这类查询都会很快的返回结果。因为在实现上,我们可以通过如“导入时对行进行计数,保存count的统计信息”,或者在查询时“仅扫描某一列数据,获得count值”的方式,只需很小的开销,即可获得查询结果。但是在 Doris 的聚合模型中,这种查询的开销非常大。

我们以刚才的数据为例:

batch 1

| user_id | date | cost |

|---|---|---|

| 10001 | 2017-11-20 | 50 |

| 10002 | 2017-11-21 | 39 |

batch 2

| user_id | date | cost |

|---|---|---|

| 10001 | 2017-11-20 | 1 |

| 10001 | 2017-11-21 | 5 |

| 10003 | 2017-11-22 | 22 |

因为最终的聚合结果为:

| user_id | date | cost |

|---|---|---|

| 10001 | 2017-11-20 | 51 |

| 10001 | 2017-11-21 | 5 |

| 10002 | 2017-11-21 | 39 |

| 10003 | 2017-11-22 | 22 |

所以,select count(*) from table; 的正确结果应该为 4。但如果我们只扫描 user_id 这一列,如果加上查询时聚合,最终得到的结果是 3(10001, 10002, 10003)。而如果不加查询时聚合,则得到的结果是 5(两批次一共5行数据)。可见这两个结果都是不对的。

为了得到正确的结果,我们必须同时读取 user_id 和 date 这两列的数据,再加上查询时聚合,才能返回 4 这个正确的结果。也就是说,在 count(*) 查询中,Doris 必须扫描所有的 AGGREGATE KEY 列(这里就是 user_id 和 date),并且聚合后,才能得到语意正确的结果。当聚合列非常多时,count(*) 查询需要扫描大量的数据。

因此,当业务上有频繁的 count(*) 查询时,我们建议用户通过增加一个值恒为 1 的,聚合类型为 SUM 的列来模拟 count(*)。如刚才的例子中的表结构,我们修改如下:

| ColumnName | Type | AggregateType | Comment |

|---|---|---|---|

| user_id | BIGINT | 用户id | |

| date | DATE | 数据灌入日期 | |

| cost | BIGINT | SUM | 用户总消费 |

| count | BIGINT | SUM | 用于计算count |

增加一个 count 列,并且导入数据中,该列值恒为 1。则 select count(*) from table; 的结果等价于 select sum(count) from table;。而后者的查询效率将远高于前者。不过这种方式也有使用限制,就是用户需要自行保证,不会重复导入 AGGREGATE KEY 列都相同的行。否则,select sum(count) from table; 只能表述原始导入的行数,而不是 select count(*) from table; 的语义。

另一种方式,就是 将如上的 count 列的聚合类型改为 REPLACE,且依然值恒为 1。那么 select sum(count) from table; 和 select count(*) from table; 的结果将是一致的。并且这种方式,没有导入重复行的限制。

#Duplicate 模型

Duplicate 模型没有聚合模型的这个局限性。因为该模型不涉及聚合语意,在做 count(*) 查询时,任意选择一列查询,即可得到语意正确的结果。

#数据模型的选择建议

因为数据模型在建表时就已经确定,且无法修改。所以,选择一个合适的数据模型非常重要。

- Aggregate 模型可以通过预聚合,极大地降低聚合查询时所需扫描的数据量和查询的计算量,非常适合有固定模式的报表类查询场景。但是该模型对 count(*) 查询很不友好。同时因为固定了 Value 列上的聚合方式,在进行其他类型的聚合查询时,需要考虑语意正确性。

- Uniq 模型针对需要唯一主键约束的场景,可以保证主键唯一性约束。但是无法利用 ROLLUP 等预聚合带来的查询优势(因为本质是 REPLACE,没有 SUM 这种聚合方式)。

- Duplicate 适合任意维度的 Ad-hoc 查询。虽然同样无法利用预聚合的特性,但是不受聚合模型的约束,可以发挥列存模型的优势(只读取相关列,而不需要读取所有 Key 列)。

Rollup 与查询

在 Doris 里 Rollup 作为一份聚合物化视图,其在查询中可以起到两个作用:

- 索引

- 聚合数据(仅用于聚合模型,即aggregate key)

但是为了命中 Rollup 需要满足一定的条件,并且可以通过执行计划中 ScanNode 节点的 PreAggregation 的值来判断是否可以命中 Rollup,以及 Rollup 字段来判断命中的是哪一张 Rollup 表。

#名词解释

Base:基表。

Rollup:一般指基于 Base 表创建的 Rollup 表,但在一些场景包括 Base 以及 Rollup 表。

#索引

前面的查询实践中已经介绍过 Doris 的前缀索引,即 Doris 会把 Base/Rollup 表中的前 36 个字节(有 varchar 类型则可能导致前缀索引不满 36 个字节,varchar 会截断前缀索引,并且最多使用 varchar 的 20 个字节)在底层存储引擎单独生成一份排序的稀疏索引数据(数据也是排序的,用索引定位,然后在数据中做二分查找),然后在查询的时候会根据查询中的条件来匹配每个 Base/Rollup 的前缀索引,并且选择出匹配前缀索引最长的一个 Base/Rollup。

-----> 从左到右匹配

+----+----+----+----+----+----+

| c1 | c2 | c3 | c4 | c5 |... |

如上图,取查询中 where 以及 on 上下推到 ScanNode 的条件,从前缀索引的第一列开始匹配,检查条件中是否有这些列,有则累计匹配的长度,直到匹配不上或者36字节结束(varchar类型的列只能匹配20个字节,并且会匹配不足36个字节截断前缀索引),然后选择出匹配长度最长的一个 Base/Rollup,下面举例说明,创建了一张Base表以及四张rollup:

+---------------+-------+--------------+------+-------+---------+-------+

| IndexName | Field | Type | Null | Key | Default | Extra |

+---------------+-------+--------------+------+-------+---------+-------+

| test | k1 | TINYINT | Yes | true | N/A | |

| | k2 | SMALLINT | Yes | true | N/A | |

| | k3 | INT | Yes | true | N/A | |

| | k4 | BIGINT | Yes | true | N/A | |

| | k5 | DECIMAL(9,3) | Yes | true | N/A | |

| | k6 | CHAR(5) | Yes | true | N/A | |

| | k7 | DATE | Yes | true | N/A | |

| | k8 | DATETIME | Yes | true | N/A | |

| | k9 | VARCHAR(20) | Yes | true | N/A | |

| | k10 | DOUBLE | Yes | false | N/A | MAX |

| | k11 | FLOAT | Yes | false | N/A | SUM |

| | | | | | | |

| rollup_index1 | k9 | VARCHAR(20) | Yes | true | N/A | |

| | k1 | TINYINT | Yes | true | N/A | |

| | k2 | SMALLINT | Yes | true | N/A | |

| | k3 | INT | Yes | true | N/A | |

| | k4 | BIGINT | Yes | true | N/A | |

| | k5 | DECIMAL(9,3) | Yes | true | N/A | |

| | k6 | CHAR(5) | Yes | true | N/A | |

| | k7 | DATE | Yes | true | N/A | |

| | k8 | DATETIME | Yes | true | N/A | |

| | k10 | DOUBLE | Yes | false | N/A | MAX |

| | k11 | FLOAT | Yes | false | N/A | SUM |

| | | | | | | |

| rollup_index2 | k9 | VARCHAR(20) | Yes | true | N/A | |

| | k2 | SMALLINT | Yes | true | N/A | |

| | k1 | TINYINT | Yes | true | N/A | |

| | k3 | INT | Yes | true | N/A | |

| | k4 | BIGINT | Yes | true | N/A | |

| | k5 | DECIMAL(9,3) | Yes | true | N/A | |

| | k6 | CHAR(5) | Yes | true | N/A | |

| | k7 | DATE | Yes | true | N/A | |

| | k8 | DATETIME | Yes | true | N/A | |

| | k10 | DOUBLE | Yes | false | N/A | MAX |

| | k11 | FLOAT | Yes | false | N/A | SUM |

| | | | | | | |

| rollup_index3 | k4 | BIGINT | Yes | true | N/A | |

| | k5 | DECIMAL(9,3) | Yes | true | N/A | |

| | k6 | CHAR(5) | Yes | true | N/A | |

| | k1 | TINYINT | Yes | true | N/A | |

| | k2 | SMALLINT | Yes | true | N/A | |

| | k3 | INT | Yes | true | N/A | |

| | k7 | DATE | Yes | true | N/A | |

| | k8 | DATETIME | Yes | true | N/A | |

| | k9 | VARCHAR(20) | Yes | true | N/A | |

| | k10 | DOUBLE | Yes | false | N/A | MAX |

| | k11 | FLOAT | Yes | false | N/A | SUM |

| | | | | | | |

| rollup_index4 | k4 | BIGINT | Yes | true | N/A | |

| | k6 | CHAR(5) | Yes | true | N/A | |

| | k5 | DECIMAL(9,3) | Yes | true | N/A | |

| | k1 | TINYINT | Yes | true | N/A | |

| | k2 | SMALLINT | Yes | true | N/A | |

| | k3 | INT | Yes | true | N/A | |

| | k7 | DATE | Yes | true | N/A | |

| | k8 | DATETIME | Yes | true | N/A | |

| | k9 | VARCHAR(20) | Yes | true | N/A | |

| | k10 | DOUBLE | Yes | false | N/A | MAX |

| | k11 | FLOAT | Yes | false | N/A | SUM |

+---------------+-------+--------------+------+-------+---------+-------+

这五张表的前缀索引分别为

Base(k1 ,k2, k3, k4, k5, k6, k7)

rollup_index1(k9)

rollup_index2(k9)

rollup_index3(k4, k5, k6, k1, k2, k3, k7)

rollup_index4(k4, k6, k5, k1, k2, k3, k7)

能用的上前缀索引的列上的条件需要是 = < > <= >= in between 这些并且这些条件是并列的且关系使用 and 连接,对于or、!= 等这些不能命中,然后看以下查询:

SELECT * FROM test WHERE k1 = 1 AND k2 > 3;

有 k1 以及 k2 上的条件,检查只有 Base 的第一列含有条件里的 k1,所以匹配最长的前缀索引即 test,explain一下:

| 0:OlapScanNode

| TABLE: test

| PREAGGREGATION: OFF. Reason: No AggregateInfo

| PREDICATES: `k1` = 1, `k2` > 3

| partitions=1/1

| rollup: test

| buckets=1/10

| cardinality=-1

| avgRowSize=0.0

| numNodes=0

| tuple ids: 0

再看以下查询:

SELECT * FROM test WHERE k4 = 1 AND k5 > 3;

有 k4 以及 k5 的条件,检查 rollup_index3、rollup_index4 的第一列含有 k4,但是 rollup_index3 的第二列含有k5,所以匹配的前缀索引最长。

| 0:OlapScanNode

| TABLE: test

| PREAGGREGATION: OFF. Reason: No AggregateInfo

| PREDICATES: `k4` = 1, `k5` > 3

| partitions=1/1

| rollup: rollup_index3

| buckets=10/10

| cardinality=-1

| avgRowSize=0.0

| numNodes=0

| tuple ids: 0

现在我们尝试匹配含有 varchar 列上的条件,如下:

SELECT * FROM test WHERE k9 IN ("xxx", "yyyy") AND k1 = 10;

有 k9 以及 k1 两个条件,rollup_index1 以及 rollup_index2 的第一列都含有 k9,按理说这里选择这两个 rollup 都可以命中前缀索引并且效果是一样的随机选择一个即可(因为这里 varchar 刚好20个字节,前缀索引不足36个字节被截断),但是当前策略这里还会继续匹配 k1,因为 rollup_index1 的第二列为 k1,所以选择了 rollup_index1,其实后面的 k1 条件并不会起到加速的作用。(如果对于前缀索引外的条件需要其可以起到加速查询的目的,可以通过建立 Bloom Filter 过滤器加速。一般对于字符串类型建立即可,因为 Doris 针对列存在 Block 级别对于整形、日期已经有 Min/Max 索引) 以下是 explain 的结果。

| 0:OlapScanNode

| TABLE: test

| PREAGGREGATION: OFF. Reason: No AggregateInfo

| PREDICATES: `k9` IN ('xxx', 'yyyy'), `k1` = 10

| partitions=1/1

| rollup: rollup_index1

| buckets=1/10

| cardinality=-1

| avgRowSize=0.0

| numNodes=0

| tuple ids: 0

最后看一个多张Rollup都可以命中的查询:

SELECT * FROM test WHERE k4 < 1000 AND k5 = 80 AND k6 >= 10000;

有 k4,k5,k6 三个条件,rollup_index3 以及 rollup_index4 的前3列分别含有这三列,所以两者匹配的前缀索引长度一致,选取两者都可以,当前默认的策略为选取了比较早创建的一张 rollup,这里为 rollup_index3。

| 0:OlapScanNode

| TABLE: test

| PREAGGREGATION: OFF. Reason: No AggregateInfo

| PREDICATES: `k4` < 1000, `k5` = 80, `k6` >= 10000.0

| partitions=1/1

| rollup: rollup_index3

| buckets=10/10

| cardinality=-1

| avgRowSize=0.0

| numNodes=0

| tuple ids: 0

如果稍微修改上面的查询为:

SELECT * FROM test WHERE k4 < 1000 AND k5 = 80 OR k6 >= 10000;

则这里的查询不能命中前缀索引。(甚至 Doris 存储引擎内的任何 Min/Max,BloomFilter 索引都不能起作用)

#聚合数据

当然一般的聚合物化视图其聚合数据的功能是必不可少的,这类物化视图对于聚合类查询或报表类查询都有非常大的帮助,要命中聚合物化视图需要下面一些前提:

- 查询或者子查询中涉及的所有列都存在一张独立的 Rollup 中。

- 如果查询或者子查询中有 Join,则 Join 的类型需要是 Inner join。

以下是可以命中Rollup的一些聚合查询的种类,

| 列类型 查询类型 | Sum | Distinct/Count Distinct | Min | Max | APPROX_COUNT_DISTINCT |

|---|---|---|---|---|---|

| Key | false | true | true | true | true |

| Value(Sum) | true | false | false | false | false |

| Value(Replace) | false | false | false | false | false |

| Value(Min) | false | false | true | false | false |

| Value(Max) | false | false | false | true | false |

如果符合上述条件,则针对聚合模型在判断命中 Rollup 的时候会有两个阶段:

- 首先通过条件匹配出命中前缀索引索引最长的 Rollup 表,见上述索引策略。

- 然后比较 Rollup 的行数,选择最小的一张 Rollup。

如下 Base 表以及 Rollup:

+-------------+-------+--------------+------+-------+---------+-------+

| IndexName | Field | Type | Null | Key | Default | Extra |

+-------------+-------+--------------+------+-------+---------+-------+

| test_rollup | k1 | TINYINT | Yes | true | N/A | |

| | k2 | SMALLINT | Yes | true | N/A | |

| | k3 | INT | Yes | true | N/A | |

| | k4 | BIGINT | Yes | true | N/A | |

| | k5 | DECIMAL(9,3) | Yes | true | N/A | |

| | k6 | CHAR(5) | Yes | true | N/A | |

| | k7 | DATE | Yes | true | N/A | |

| | k8 | DATETIME | Yes | true | N/A | |

| | k9 | VARCHAR(20) | Yes | true | N/A | |

| | k10 | DOUBLE | Yes | false | N/A | MAX |

| | k11 | FLOAT | Yes | false | N/A | SUM |

| | | | | | | |

| rollup2 | k1 | TINYINT | Yes | true | N/A | |

| | k2 | SMALLINT | Yes | true | N/A | |

| | k3 | INT | Yes | true | N/A | |

| | k10 | DOUBLE | Yes | false | N/A | MAX |

| | k11 | FLOAT | Yes | false | N/A | SUM |

| | | | | | | |

| rollup1 | k1 | TINYINT | Yes | true | N/A | |

| | k2 | SMALLINT | Yes | true | N/A | |

| | k3 | INT | Yes | true | N/A | |

| | k4 | BIGINT | Yes | true | N/A | |

| | k5 | DECIMAL(9,3) | Yes | true | N/A | |

| | k10 | DOUBLE | Yes | false | N/A | MAX |

| | k11 | FLOAT | Yes | false | N/A | SUM |

+-------------+-------+--------------+------+-------+---------+-------+

看以下查询:

SELECT SUM(k11) FROM test_rollup WHERE k1 = 10 AND k2 > 200 AND k3 in (1,2,3);

首先判断查询是否可以命中聚合的 Rollup表,经过查上面的图是可以的,然后条件中含有 k1,k2,k3 三个条件,这三个条件 test_rollup、rollup1、rollup2 的前三列都含有,所以前缀索引长度一致,然后比较行数显然 rollup2 的聚合程度最高行数最少所以选取 rollup2。

| 0:OlapScanNode |

| TABLE: test_rollup |

| PREAGGREGATION: ON |

| PREDICATES: `k1` = 10, `k2` > 200, `k3` IN (1, 2, 3) |

| partitions=1/1 |

| rollup: rollup2 |

| buckets=1/10 |

| cardinality=-1 |

| avgRowSize=0.0 |

| numNodes=0 |

| tuple ids: 0 |五、备份与恢复

Doris 支持将当前数据以文件的形式,通过 broker 备份到远端存储系统中。之后可以通过 恢复 命令,从远端存储系统中将数据恢复到任意 Doris 集群。通过这个功能,Doris 可以支持将数据定期的进行快照备份。也可以通过这个功能,在不同集群间进行数据迁移。

该功能需要 Doris 版本 0.8.2+

使用该功能,需要部署对应远端存储的 broker。如 BOS、HDFS 等。可以通过 SHOW BROKER; 查看当前部署的 broker。

#简要原理说明

#备份(Backup)

备份操作是将指定表或分区的数据,直接以 Doris 存储的文件的形式,上传到远端仓库中进行存储。当用户提交 Backup 请求后,系统内部会做如下操作:

-

快照及快照上传

快照阶段会对指定的表或分区数据文件进行快照。之后,备份都是对快照进行操作。在快照之后,对表进行的更改、导入等操作都不再影响备份的结果。快照只是对当前数据文件产生一个硬链,耗时很少。快照完成后,会开始对这些快照文件进行逐一上传。快照上传由各个 Backend 并发完成。

-

元数据准备及上传

数据文件快照上传完成后,Frontend 会首先将对应元数据写成本地文件,然后通过 broker 将本地元数据文件上传到远端仓库。完成最终备份作业。

#恢复(Restore)

恢复操作需要指定一个远端仓库中已存在的备份,然后将这个备份的内容恢复到本地集群中。当用户提交 Restore 请求后,系统内部会做如下操作:

-

在本地创建对应的元数据

这一步首先会在本地集群中,创建恢复对应的表分区等结构。创建完成后,该表可见,但是不可访问。

-

本地snapshot

这一步是将上一步创建的表做一个快照。这其实是一个空快照(因为刚创建的表是没有数据的),其目的主要是在 Backend 上产生对应的快照目录,用于之后接收从远端仓库下载的快照文件。

-

下载快照

远端仓库中的快照文件,会被下载到对应的上一步生成的快照目录中。这一步由各个 Backend 并发完成。

-

生效快照

快照下载完成后,我们要将各个快照映射为当前本地表的元数据。然后重新加载这些快照,使之生效,完成最终的恢复作业。

#最佳实践

#备份

当前我们支持最小分区(Partition)粒度的全量备份(增量备份有可能在未来版本支持)。如果需要对数据进行定期备份,首先需要在建表时,合理的规划表的分区及分桶,比如按时间进行分区。然后在之后的运行过程中,按照分区粒度进行定期的数据备份。

#数据迁移

用户可以先将数据备份到远端仓库,再通过远端仓库将数据恢复到另一个集群,完成数据迁移。因为数据备份是通过快照的形式完成的,所以,在备份作业的快照阶段之后的新的导入数据,是不会备份的。因此,在快照完成后,到恢复作业完成这期间,在原集群上导入的数据,都需要在新集群上同样导入一遍。

建议在迁移完成后,对新旧两个集群并行导入一段时间。完成数据和业务正确性校验后,再将业务迁移到新的集群。

#重点说明

- 备份恢复相关的操作目前只允许拥有 ADMIN 权限的用户执行。

- 一个 Database 内,只允许有一个正在执行的备份或恢复作业。

- 备份和恢复都支持最小分区(Partition)级别的操作,当表的数据量很大时,建议按分区分别执行,以降低失败重试的代价。

- 因为备份恢复操作,操作的都是实际的数据文件。所以当一个表的分片过多,或者一个分片有过多的小版本时,可能即使总数据量很小,依然需要备份或恢复很长时间。用户可以通过

SHOW PARTITIONS FROM table_name;和SHOW TABLET FROM table_name;来查看各个分区的分片数量,以及各个分片的文件版本数量,来预估作业执行时间。文件数量对作业执行的时间影响非常大,所以建议在建表时,合理规划分区分桶,以避免过多的分片。 - 当通过

SHOW BACKUP或者SHOW RESTORE命令查看作业状态时。有可能会在TaskErrMsg一列中看到错误信息。但只要State列不为CANCELLED,则说明作业依然在继续。这些 Task 有可能会重试成功。当然,有些 Task 错误,也会直接导致作业失败。 - 如果恢复作业是一次覆盖操作(指定恢复数据到已经存在的表或分区中),那么从恢复作业的

COMMIT阶段开始,当前集群上被覆盖的数据有可能不能再被还原。此时如果恢复作业失败或被取消,有可能造成之前的数据已损坏且无法访问。这种情况下,只能通过再次执行恢复操作,并等待作业完成。因此,我们建议,如无必要,尽量不要使用覆盖的方式恢复数据,除非确认当前数据已不再使用。

#相关命令

和备份恢复功能相关的命令如下。以下命令,都可以通过 mysql-client 连接 Doris 后,使用 help cmd; 的方式查看详细帮助。

-

CREATE REPOSITORY

创建一个远端仓库路径,用于备份或恢复。该命令需要借助 Broker 进程访问远端存储,不同的 Broker 需要提供不同的参数,具体请参阅 Broker文档,也可以直接通过S3 协议备份到支持AWS S3协议的远程存储上去,具体参考 [创建远程仓库文档](../sql-reference/sql-statements/Data Definition/CREATE REPOSITORY.md)

-

BACKUP

执行一次备份操作。

-

SHOW BACKUP

查看最近一次 backup 作业的执行情况,包括:

- JobId:本次备份作业的 id。

- SnapshotName:用户指定的本次备份作业的名称(Label)。

- DbName:备份作业对应的 Database。

- State:备份作业当前所在阶段:

- PENDING:作业初始状态。

- SNAPSHOTING:正在进行快照操作。

- UPLOAD_SNAPSHOT:快照结束,准备上传。

- UPLOADING:正在上传快照。

- SAVE_META:正在本地生成元数据文件。

- UPLOAD_INFO:上传元数据文件和本次备份作业的信息。

- FINISHED:备份完成。

- CANCELLED:备份失败或被取消。

- BackupObjs:本次备份涉及的表和分区的清单。

- CreateTime:作业创建时间。

- SnapshotFinishedTime:快照完成时间。

- UploadFinishedTime:快照上传完成时间。

- FinishedTime:本次作业完成时间。

- UnfinishedTasks:在

SNAPSHOTTING,UPLOADING等阶段,会有多个子任务在同时进行,这里展示的当前阶段,未完成的子任务的 task id。 - TaskErrMsg:如果有子任务执行出错,这里会显示对应子任务的错误信息。

- Status:用于记录在整个作业过程中,可能出现的一些状态信息。

- Timeout:作业的超时时间,单位是秒。

-

SHOW SNAPSHOT

查看远端仓库中已存在的备份。

- Snapshot:备份时指定的该备份的名称(Label)。

- Timestamp:备份的时间戳。

- Status:该备份是否正常。

如果在

SHOW SNAPSHOT后指定了 where 子句,则可以显示更详细的备份信息。- Database:备份时对应的 Database。

- Details:展示了该备份完整的数据目录结构。

-

RESTORE

执行一次恢复操作。

-

SHOW RESTORE

查看最近一次 restore 作业的执行情况,包括:

- JobId:本次恢复作业的 id。

- Label:用户指定的仓库中备份的名称(Label)。

- Timestamp:用户指定的仓库中备份的时间戳。

- DbName:恢复作业对应的 Database。

- State:恢复作业当前所在阶段:

- PENDING:作业初始状态。

- SNAPSHOTING:正在进行本地新建表的快照操作。

- DOWNLOAD:正在发送下载快照任务。

- DOWNLOADING:快照正在下载。

- COMMIT:准备生效已下载的快照。

- COMMITTING:正在生效已下载的快照。

- FINISHED:恢复完成。

- CANCELLED:恢复失败或被取消。

- AllowLoad:恢复期间是否允许导入。

- ReplicationNum:恢复指定的副本数。

- RestoreObjs:本次恢复涉及的表和分区的清单。

- CreateTime:作业创建时间。

- MetaPreparedTime:本地元数据生成完成时间。

- SnapshotFinishedTime:本地快照完成时间。

- DownloadFinishedTime:远端快照下载完成时间。

- FinishedTime:本次作业完成时间。

- UnfinishedTasks:在

SNAPSHOTTING,DOWNLOADING,COMMITTING等阶段,会有多个子任务在同时进行,这里展示的当前阶段,未完成的子任务的 task id。 - TaskErrMsg:如果有子任务执行出错,这里会显示对应子任务的错误信息。

- Status:用于记录在整个作业过程中,可能出现的一些状态信息。

- Timeout:作业的超时时间,单位是秒。

-

CANCEL BACKUP

取消当前正在执行的备份作业。

-

CANCEL RESTORE

取消当前正在执行的恢复作业。

-

DROP REPOSITORY

删除已创建的远端仓库。删除仓库,仅仅是删除该仓库在 Doris 中的映射,不会删除实际的仓库数据。

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)