【论文速递】ECCV2022 - PETR: Position Embedding Transformation for Multi-View 3D Object Detection

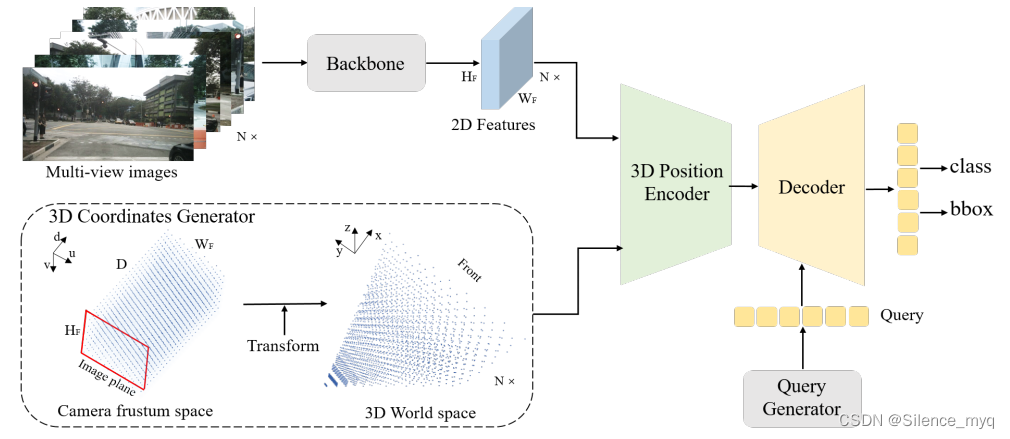

在本文中,我们开发了用于多视图 3D 对象检测的位置嵌入变换 (PETR)。PETR 将 3D 坐标的位置信息编码为图像特征,产生 3D 位置感知特征。对象查询可以感知 3D 位置感知特征并执行端到端对象检测。PETR 在标准 nuScenes 数据集上实现了最先进的性能(50.4% NDS 和 44.1% mAP),并在基准测试中排名第一。它可以作为未来研究的简单而强大的基线。Fig. DETR

【论文原文】:PETR: 用于多视图 3D 对象检测的位置嵌入变换

论文:https://arxiv.org/abs/2203.05625

代码:https://github.com/megvii-research/PETR

博主关键词: 小样本学习,语义分割,图注意力网络,互监督,目标检测,三维视觉

推荐相关论文:

【论文速递】CoRL2021 - DETR3D:通过 3D 到 2D 查询从多视图图像中检测 3D 对象

https://bbs.csdn.net/topics/612489503

摘要

在本文中,我们开发了用于多视图 3D 对象检测的位置嵌入变换 (PETR)。 PETR 将 3D 坐标的位置信息编码为图像特征,产生 3D 位置感知特征。 对象查询可以感知 3D 位置感知特征并执行端到端对象检测。 PETR 在标准 nuScenes 数据集上实现了最先进的性能(50.4% NDS 和 44.1% mAP),并在基准测试中排名第一。 它可以作为未来研究的简单而强大的基线。

简介

多视图图像的 3D 对象检测由于其在自动驾驶系统中的低成本而具有吸引力。 以往的工作主要是从单目目标检测的角度来解决这个问题。 最近,DETR 因其在端到端目标检测方面的贡献而受到广泛关注。 在 DETR 中,每个对象查询代表一个对象并与 transformer 解码器中的 2D 特征交互以产生预测。 DETR3D 是 DETR 框架的简单扩展,为端到端 3D 对象检测提供了直观的解决方案。 由对象查询预测的 3D 参考点通过相机参数投影回图像空间,并用于从所有相机视图中采样 2D 特征。 解码器将采样特征和查询作为输入并更新对象查询的表示。

然而,DETR3D 中的这种 2D 到 3D 转换可能会引入几个问题。 首先,参考点的预测坐标可能不那么准确,使得采样的特征超出了对象区域。 其次,仅收集投影点处的图像特征,无法从全局视图进行表示学习。 此外,复杂的特征采样过程将阻碍检测器的实际应用。 因此,在没有在线 2D 到 3D 转换和特征采样的情况下构建端到端 3D 对象检测框架仍然是一个遗留问题。

在本文中,我们的目标是开发一个基于 DETR 的简单而优雅的 3D 对象检测框架。 我们想知道是否有可能将 2D 特征从多视图转换为 3D 感知特征。 这样,对象查询就可以在3D环境下直接更新。 我们的工作受到隐式神经表示的这些进步的启发。 在 MetaSR 和 LIFF 中,高分辨率 (HR) RGB 值是通过将 HR 坐标信息编码到 LR 特征中,从低分辨率 (LR) 输入生成的。 在本文中,我们尝试通过编码 3D 位置嵌入将多视图图像的 2D 特征转换为 3D 表示。 为了实现这一目标,首先将由不同视图共享的相机视锥体空间离散化为网格坐标。 然后通过不同的相机参数对坐标进行变换,得到3D世界空间的坐标。 然后从骨干和 3D 坐标中提取的 2D 图像特征被输入到一个简单的 3D 位置编码器以产生 3D 位置感知特征。 3D 位置感知功能将与转换器解码器中的对象查询交互,更新的对象查询进一步用于预测对象类和 3D 边界框。

与 DETR3D 相比,所提出的 PETR 架构带来了许多优势。 它保持了原始 DETR 的端到端精神,同时避免了复杂的 2D 到 3D 投影和特征采样。 在推理期间,可以以离线方式生成 3D 位置坐标,并用作额外的输入位置嵌入。 实际应用起来相对容易一些。

总而言之,我们的贡献是:

文章的主要贡献如下:

• 提出了一个简单而优雅的框架,称为 PETR,用于多视图 3D 对象检测。 通过对 3D 坐标进行编码,将多视图特征转换为 3D 域。 可以通过与 3D 位置感知功能交互来更新对象查询并生成 3D 预测。

• 引入了一种新的 3D 位置感知表示,用于多视图 3D 对象检测。 引入了一个简单的隐函数来将 3D 位置信息编码为 2D 多视图特征。

• 实验表明,PETR 在标准 nuScenes 数据集上实现了最先进的性能(50.4% NDS 和 44.1% mAP),并在 3D 目标检测排行榜上排名第一。

【社区访问】

【论文速递 | 精选】

【论文速递 | 精选】

阅读原文访问社区

阅读原文访问社区

https://bbs.csdn.net/forums/paper

更多推荐

已为社区贡献142条内容

已为社区贡献142条内容

所有评论(0)